多模态大模型在输入输出上涵盖了图像、音频、视频等模态,让大模型超越了大语言模型的范畴,为大模型赋予了更强大的功能。如最近引起广泛关注的GPT4V、Gemini等,就让人们看到了多模态大模型的更多价值和可能性。在此背景下,业界对多模态大模型的研究不断深入,多模态大模型相关技术也随之不断发展突破。

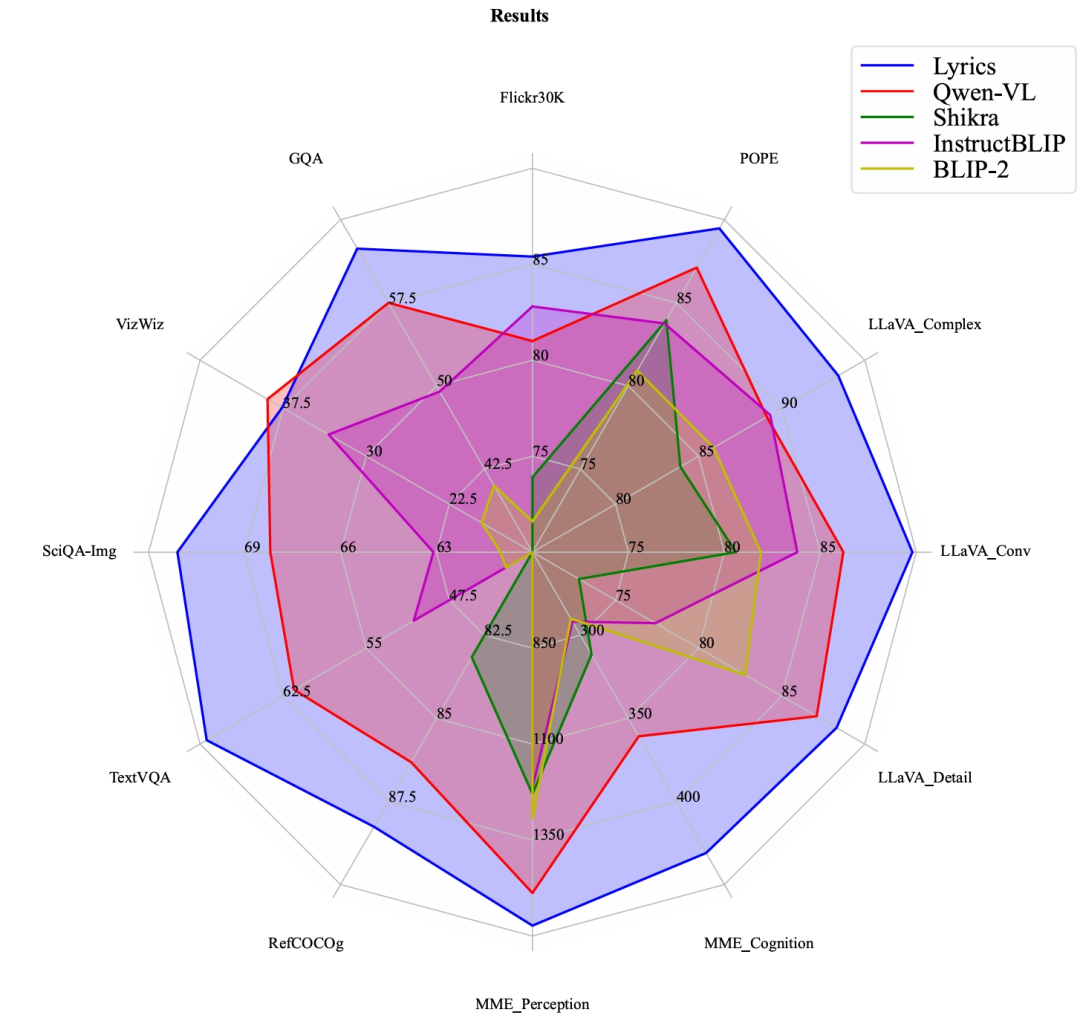

封神榜大模型团队基于在多模态领域积累的先进技术,首次在多模态大模型上加入图像标记、目标检测、语义分割模块,推出了多模态大模型Ziya-Visual-Lyrics。评测结果显示,Ziya-Visual-Lyrics在跟开源多模态大模型的对比中取得多个零样本任务SOTA,模型效果亮眼。

欢迎大家点击下方链接下载,也可通过魔搭创空间、Hugging Face Space 体验我们的模型,与我们分享你的使用感受!

论文链接

https://arxiv.org/abs/2312.05278

模型下载链接

ModelScope:

https://modelscope.cn/models/Fengshenbang/Ziya-Visual-Lyrics-14B/summary

Hugging Face:

https://hf.co/IDEA-CCNL/Ziya-Visual-Lyrics-14B

模型体验链接

ModelScope:

https://modelscope.cn/studios/Fengshenbang/Ziya-Visual-Lyrics

Hugging Face:

https://hf.co/spaces/IDEA-CCNL/Ziya-Visual-Lyrics

多模态大模型的局限

主流的多模态大模型(MLLM),如LLaVA、BLIP2和Shikra只采用CLIP模型中的ViT作为图像编码器,缺乏细粒度的视觉对象识别阻碍了模型对图像细节的理解,导致模型出现视觉幻觉和事实错误,比如针对图片中对象的颜色、计数、详细描述、动作识别、定位等问答的准确性有待提高。

封神榜大模型团队在研究中高度关注了细粒度问题并首次引入视觉细化器,推出了多模态大模型Ziya-Visual-Lyrics,为当前多模态大模型存在的以上局限提出了具有创新性和借鉴性的解决方案。

Ziya-Visual-Lyrics的亮点所在

提出细粒度两阶段视觉语言训练框架

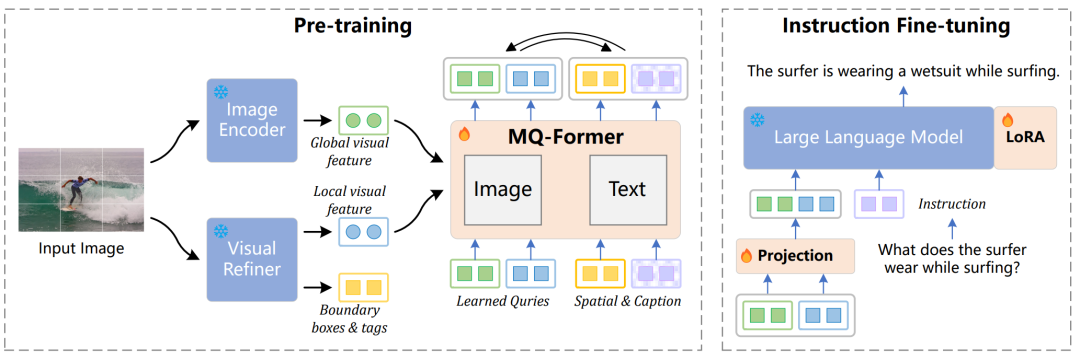

我们提出了一个细粒度的两阶段视觉语言训练框架——Lyrics,通过视觉语言对齐范式来促使模型能够处理语义感知的视觉对象。

引入视觉细化器与MQ-Former

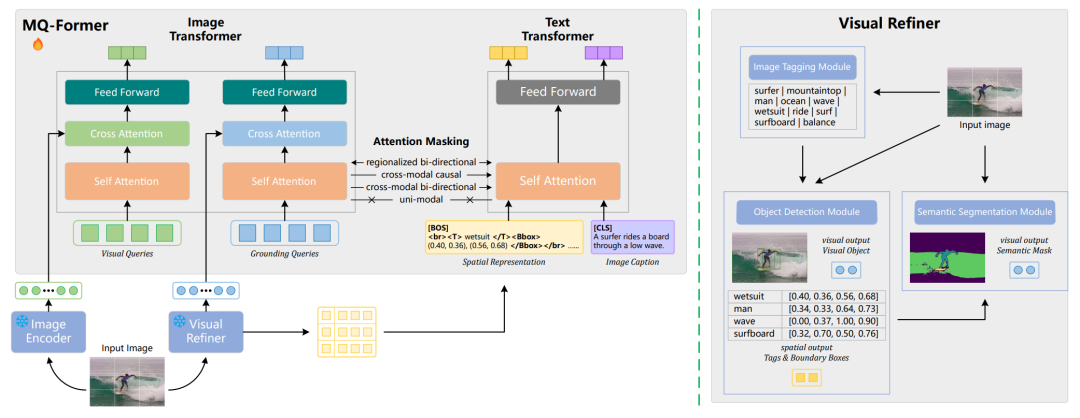

Ziya-Visual-Lyrics 引入了视觉细化器来提取局部视觉特征和具化的空间表征,该视觉细化器由图像标记、目标检测和语义分割模块组成。同时,我们提出了多尺度Querying Transformer (MQ-Former) 结构来对齐视觉和语言特征。

在不同视觉语言任务上(包括Image Captioning, Visual Question Answering, Referring Expression Comprehension 以及多模态评测排行榜)进行的广泛评测结果表明:Lyrics模型效果优秀,在多个评测上都有着极具竞争力的表现。

模型架构

图像编码器

在图像编码器方面,我们沿用了CLIP中采用的ViT-L/14来抽取图像的全局特征。

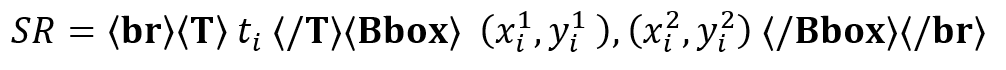

视觉细化器

采用三个视觉模块抽取图像的局部特征,包括:

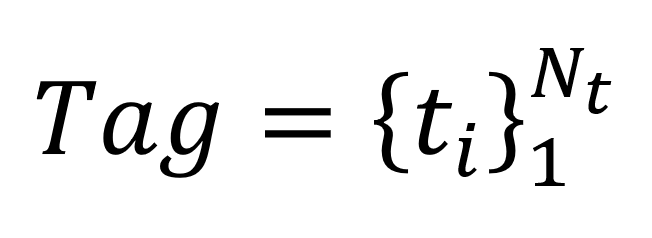

(1) 图像标记模块:

RAM模型,从图片中提取所有潜在的视觉对象的标签,记为

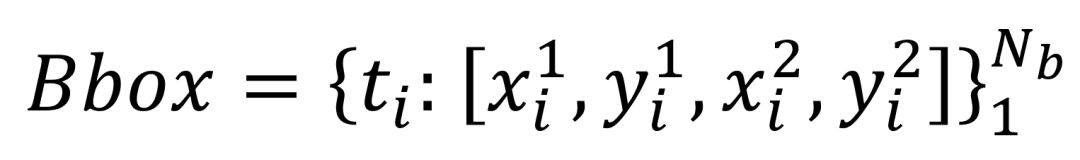

(2) 目标检测模块:

Grounded DINO模型,根据图片和标签提取置信度高于阈值的检测框坐标,记为

(3) 语义分割模块:

SAM模型,根据图片和检测框获取视觉目标的语义掩码特征

MQ-Former

(1) 图像Transformer:

我们创建了一组固定数量的可学习Visual Queries和Grounding Queries,它们分别通过两个独立的交叉注意层与图像编码器和视觉细化器交互以输出压缩的视觉特征。

(2) 文本Transformer:

将图像的空间表征设计为以下格式,并和图片的描述拼接后作为文本输入。

(3) MQ-Former内部共享self-attention层参数

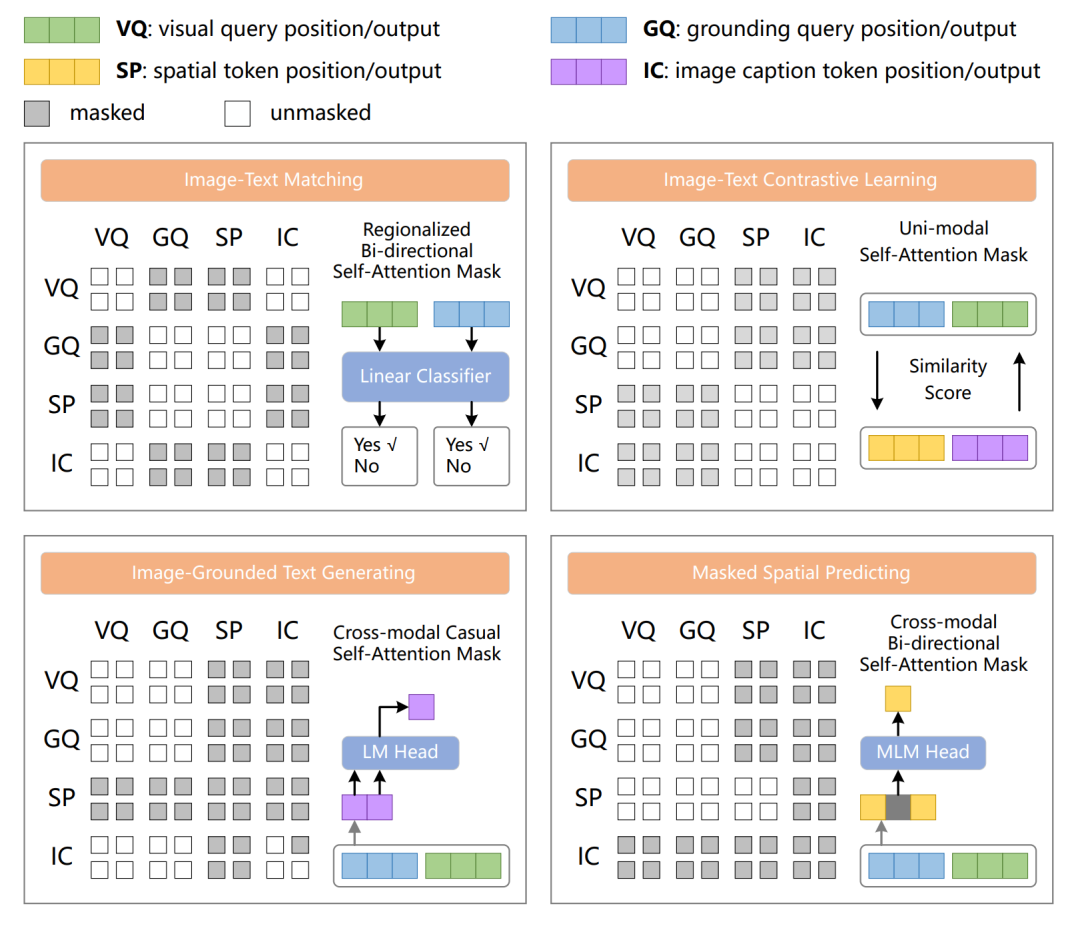

一阶段训练:视觉语言表征对齐

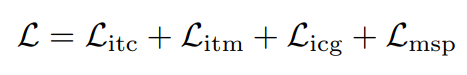

由于引入了视觉细化器,一阶段通过四个训练目标进行对齐。

输出表示:在视觉Transformer端中,将输出的Visual Queries表征和Grounding Queries表征经过Pooling层后得到的Hv 和Hg 拼接成HI。在文本Transformer端中,将[BOS] 和[CLS] 对应的输出表征Hsp 和Hic 拼接成HT。

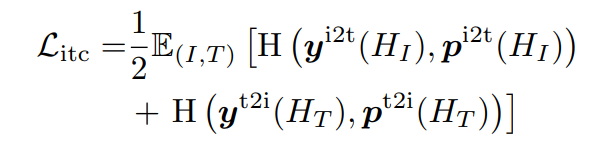

Image-Text Contrastive Learning (ITC):

视觉和文本特征互相Mask以防止信息泄露,通过鼓励积极的图像-文本对的相似表征,来区分具有与消极的图像-文本对以对齐多尺度的视觉和文本表示。

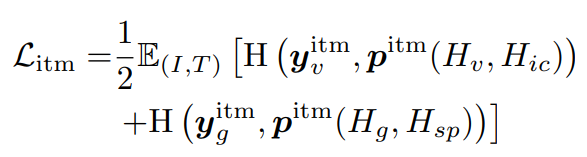

Image-Text Matching (ITM):

分别捕获视觉和文本之间的粗粒度和细粒度语义对齐,使用区域化双向自注意力机制,局部视觉特征和空间表征/全局视觉特征和图像描述互相可视。Hv 和Hg 经过具有softmax的分类层做二分类任务。

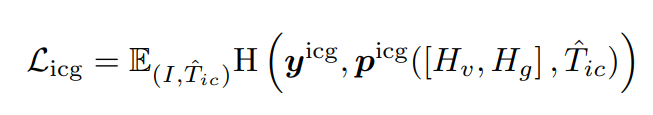

Image-Grounded Caption Generating (ICG):

仅基于视觉信号生成图片描述,旨在让模型学习将抽象的视觉特征转换为具体的图像描述。采用跨模态的因果注意力机制,并替换[CLS] 为[DEC] 来象征语言建模任务。

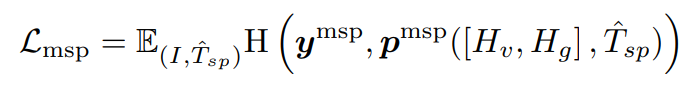

Masked Spatial Predicting (MSP):

通过细粒度多模态对齐学习语义感知的视觉对象,使用Mask掩盖并预测空间表征的每一项完整视觉对象。采用跨模态的双向注意力机制,并替换[BOS] 为[MLM] 。

二阶段训练:指令微调

在指令微调阶段,我们将MQ-Former输出的Queries表征通过一个可训练的线性映射层后作为LLM的输入,并启用LoRA训练LLM,以适应多种多模态场景下的输入和输出。

数据

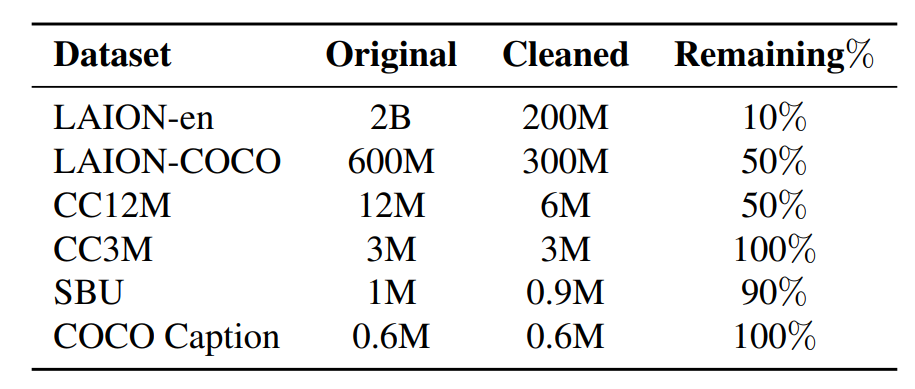

预训练数据

我们从开源数据集中收集了26亿图文对,并进行了数据处理,最终得到了5亿高质量的图文对用于进行一阶段的预训练。

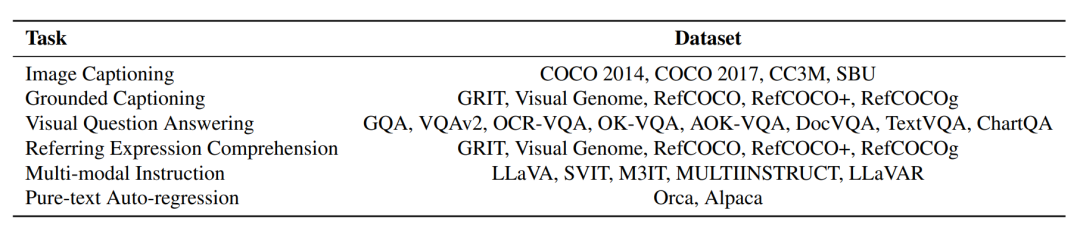

指令微调数据

Lyrics二阶段的微调数据为开源数据集中所收集的7类任务数据,24个数据集。

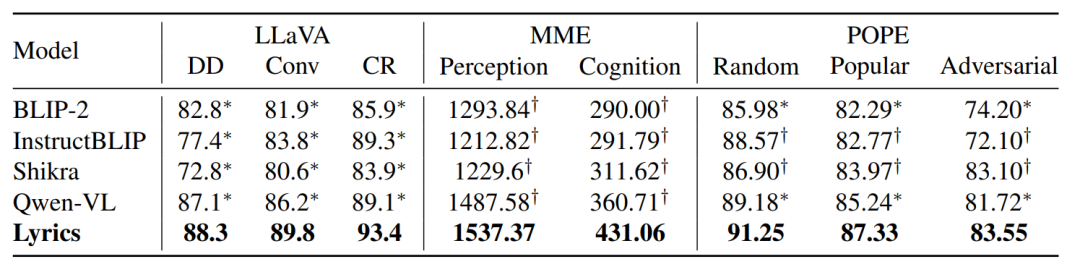

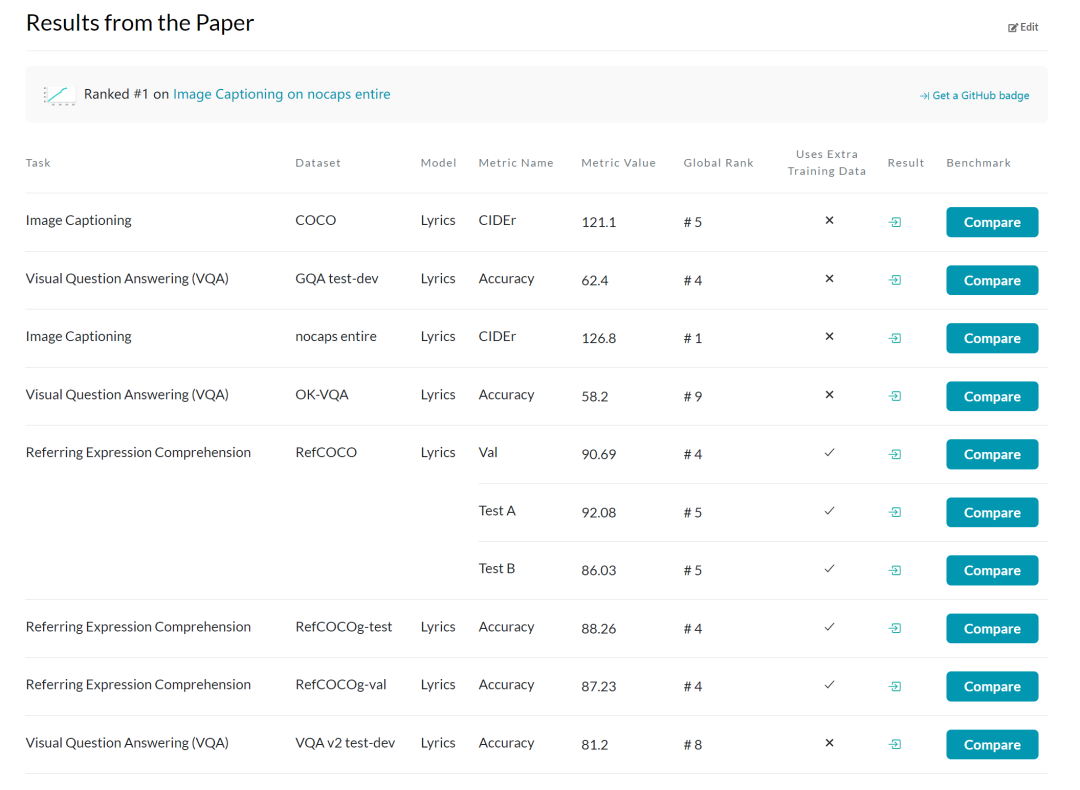

实验结果

Ziya-Visual-Lyrics在Image Captioning、Visual Question Answering、Text-Oriented VQA、Referring Expression Comprehension (REC)等大部分任务上都取得了SOTA的效果,同时我们在LLaVA, MME和POPE排行榜测评也取得了SOTA的效果。

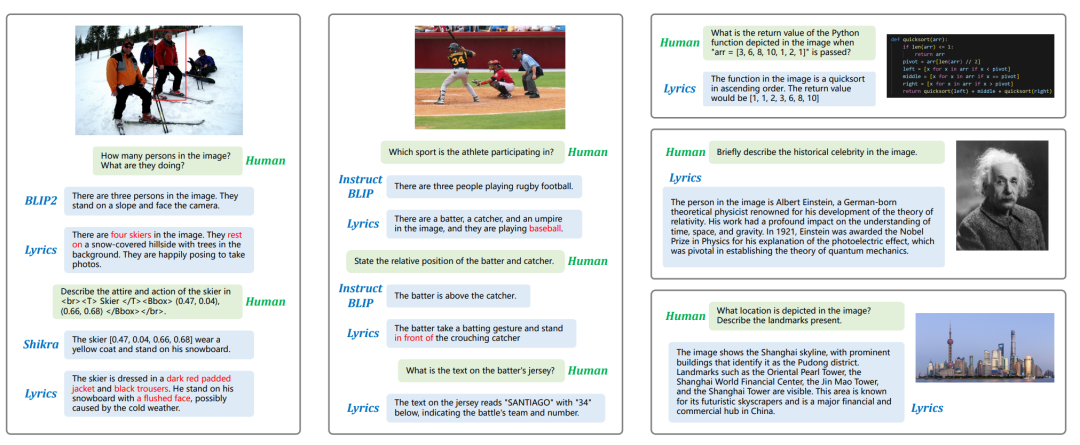

Case展示

(1) 视觉细化器提供的局部视觉特征和空间信息有效地促进了细粒度的视觉语言对齐,从而提高了模型捕获和响应面向指令的视觉对象的能力,并具备对文字的识别和分析能力。

(2) 在预训练阶段促进文本化空间信息与视觉对象之间的语义对齐,能够提供良好的视觉基础,这有助于提升模型快速适应各个场景下的视觉-语言任务。

(3) 在相同体量的情况下,BLIP2, InstructBLIP和Shikra由于缺乏细粒度的视觉信号,无法准确捕获指令中涉及的视觉对象的详细信息。Lyrics在视觉细化器的支持下,在经过两阶段训练后能够有效地感知图片中视觉对象的数量、颜色、方位等细节信息。如在样例1中,Lyrics能够识别在图片中有四个滑雪者处于休息状态,并在指向性对话的功能中,能够指出指定空间坐标下的滑雪者脸色红润且穿着暗红色棉衣和黑色长裤。

(4) 此外,Lyrics很好地将视觉信号融入到LLM的常识理解和逻辑推理能力,这使得模型能够应对图像中的符号象征和代码推理,同时对知名的地点、人物、符号有着很强的识别能力。

通过引入视觉细化器,并进行两阶段的训练,Ziya-Visual-Lyrics对视觉对象的感知识别能力得到了提高。在未来,封神榜大模型团队将继续多模态领域的研究,我们也将持续为社区提供先进的多模态训练技术,分享先进经验,共同推进多模态领域的发展。

了解更多信息

欢迎关注封神榜开源主页

封神榜 ModelScope 主页:

https://modelscope.cn/organization/Fengshenbang

封神榜 Hugging Face 主页:

https://hf.co/IDEA-CCNL

封神榜 Github 主页:

https://github.com/IDEA-CCNL/Fengshenbang-LM

本文由 Hugging Face 中文社区内容共建项目提供,稿件由社区成员投稿,经授权发布于 Hugging Face 公众号。文章内容不代表官方立场,文中介绍的产品和服务等均不构成投资建议。了解更多请关注公众号:

如果你有与开源 AI、Hugging Face 相关的技术和实践分享内容,以及最新的开源 AI 项目发布,希望通过我们分享给更多 AI 从业者和开发者们,请通过下面的链接投稿与我们取得联系:

https://hf.link/tougao

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง