编译 | 熊展坤

审核 | 王紫嫣

今天介绍的是AAAI 2024接收论文:Structure-CLIP: Towards Scene Graph Knowledge to Enhance Multi-modal Structured Representations,作者提出了一个端到端框架Structure-CLIP,它集成了场景图知识(Scene Graph Knowledge, SGK)来增强多模态结构化表示。

1 摘要

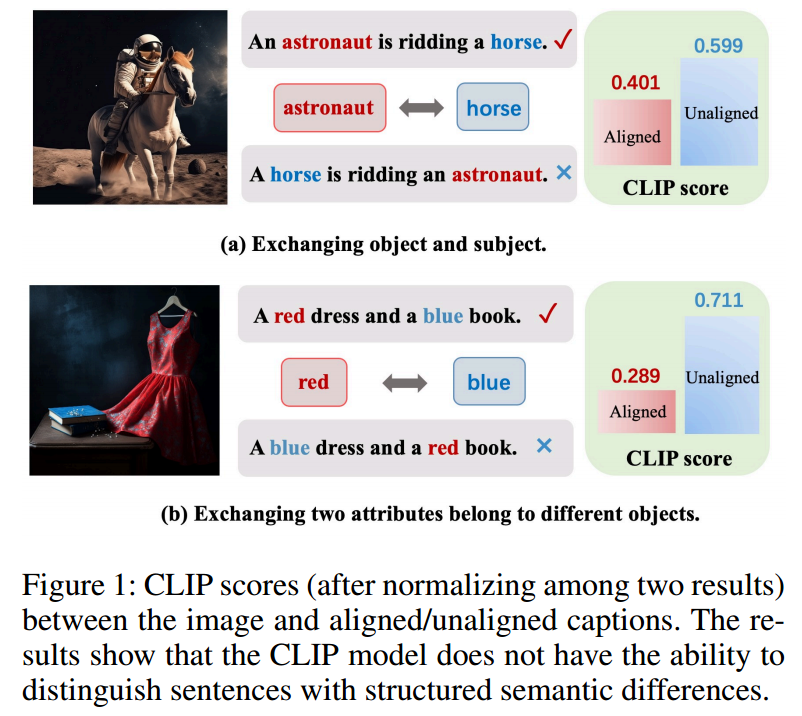

大规模视觉语言预训练在多模态理解和生成任务中取得了显著的效果。然而,现有的方法在需要结构化表示(即对象、属性和关系的表示)的图像-文本匹配任务上通常表现不佳。如图1 (a)所示,模型无法区分“宇航员骑马”和“马骑宇航员”。这是因为它们在学习多模态场景中的表示时未能充分利用结构化知识。在本文中,作者提出了一个端到端框架Structure-CLIP,它集成了场景图知识(Scene Graph Knowledge, SGK)来增强多模态结构化表示。首先,作者使用场景图来指导语义负样例的构建,并提出了一种知识增强编码器(KEE),利用SGK作为输入进一步增强结构化表示。为了验证所提出框架的有效性,作者使用上述方法预训练模型,并在下游任务上进行实验。实验结果表明,Structure-CLIP在VG-Attribution和VG-Relation数据集上达到了最先进的SOTA性能,分别比多模态SOTA模型高出12.5%和4.1%。同时,MSCOCO结果表明,Structure-CLIP在保持一般表征能力的同时,显著增强了结构化表征。

2 引文

视觉语言模型(VLMs)在各种多模态理解和生成任务中表现出显著的性能。尽管多模态模型在各种任务中的表现令人印象深刻,但这些模型、如何能够有效地捕获结构化知识(例如理解对象属性和对象之间关系的能力)仍然没有解决。例如,如图1 (a)所示,图像与正确匹配的标题(“一名宇航员正在骑马”)之间的CLIP得分(即语义相似度),与图像与不匹配的标题(“一匹马骑着一名宇航员”)之间的得分相比,显示出较低的值。随后,图1 (b)表明,在两个对象之间交换属性也会给模型准确区分其语义带来挑战。这些发现表明,CLIP模型产生的通用表示无法区分包含相同单词但在结构化知识方面存在分歧的文本片段。换句话说,CLIP模型不理解句子中的细粒度语义。

在本文中,作者提出了Structure-CLIP,一种利用场景图知识(SGK)来增强多模态结构化表示的新方法。首先,与随机交换方法相比,作者利用SGK来构建更符合潜在意图的单词交换。其次,作者提出了一种知识增强编码器(KEE),利用SGK提取基本结构信息。通过在输入层引入结构化知识,所提出的KEE可以进一步增强结构化表示的能力。实验结果显示了Structure-CLIP的SOTA性能及其组成部分的有效性。此外,作者对MSCOCO进行了跨模态检索评估,结果表明Structure-CLIP仍然保留了足够的一般表示能力。

总的来说,论文的贡献有三个方面:

•Structure-CLIP是第一种通过构造语义负样本来增强详细结构化表示的方法。

•在Structure-CLIP中引入了知识增强编码器,以利用结构化知识作为输入来增强结构化表示。

•全面的实验证明Structure-CLIP能够在结构化表示下游任务上实现SOTA性能,并在结构化表示上产生显著改进。

3 方法

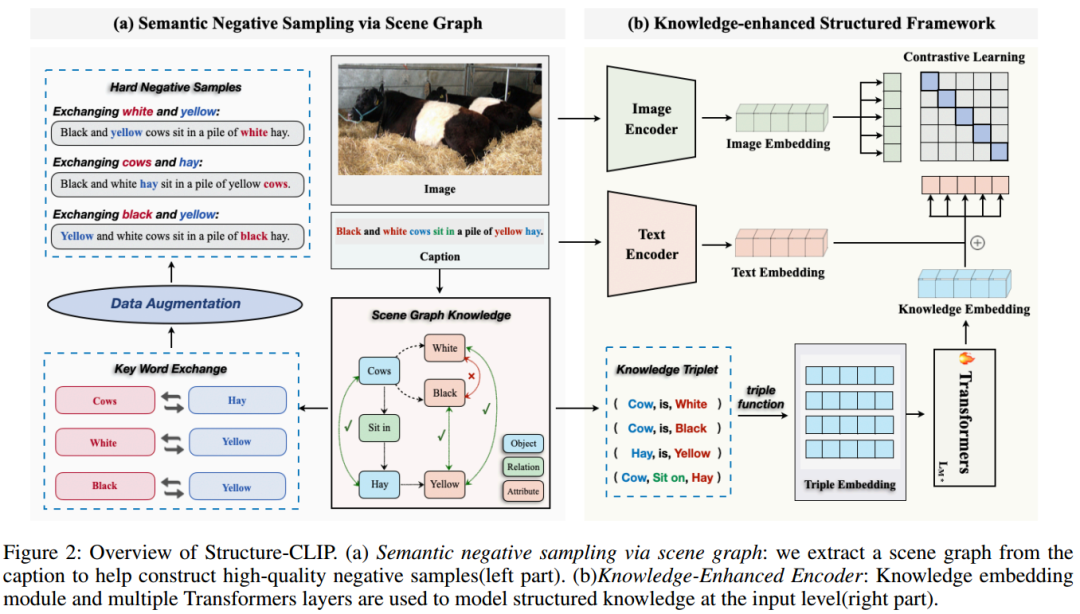

Structure-CLIP的基本架构如上图所示。

Structure-CLIP的基本架构如上图所示。

3.1 通过场景图进行语义负采样

Faghri等人提出了一种负抽样方法,该方法涉及构建负样本,通过将其与正样本进行比较来增强表征。本文的目标是构建具有相似一般表示但不同细节语义的样本,从而鼓励模型专注于学习结构化表示。

场景图构建:详细的语义,包括对象、对象的属性和对象之间的关系,对于理解视觉场景以及跨模态学习至关重要。跨模态学习旨在增强视觉和语言的联合表征。在本文的框架中,场景图解析器将文本解析为场景图。给定文本句子w,作者将其解析为场景图,表示为G(w) =< O(w), E(w), K(w) >,其中O(w)是w中所述对象的集合,R(w)是关系节点的集合,E(w) ⊆ O(w) × R(w) ×

O(w) 是表示对象之间实际关系的超边集合。K(w) ⊆ O(w) × A(w)为属性对集合,其中A(w)为与对象相关联的属性节点集合。如图2所示,作者基于原始标题生成场景图。以图2中的标题“黑白奶牛坐在一堆黄色的干草中”为例,在生成的场景图中,“奶牛”、“干草”等物体是基本元素。相关的属性,如“白色”和“黄色”表征了对象的颜色或其他属性。诸如“坐”之类的关系表示对象之间的空间连接。

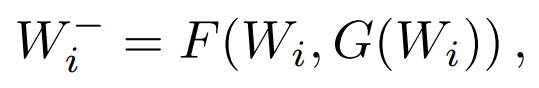

语义负样本的选择:对比学习的目的是通过将语义上接近的邻居拉到一起而将非邻居推开来学习有效的表征。本文的目标是构建成分相似但细节语义不同的语义负样本。因此,负样本的质量在结构化表征学习中起着至关重要的作用。多模态数据集通常由N个图像-文本对组成,其中图像和文本分别用下标表示为I和W。给定图像-文本对(, )和由生成的相关场景图G(),通过W生成高质量的语义负样本:

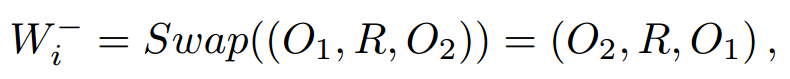

其中F为建议的采样函数,为高质量语义负样本。具体来说,对于场景图中的三元组(对象、关系、主体),是通过以下公式生成的:

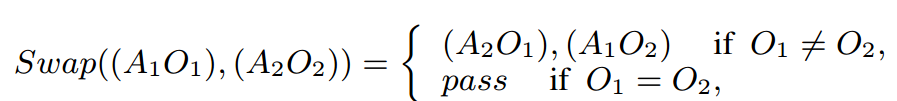

其中Swap是句子中宾语和主语交换的功能,、R、分别表示宾语、关系和主语。对于场景图中的属性对(, )和(, ), W−i由下述公式得到:

总的来说,作者利用场景图引导来构建高质量的语义负样本,而不是随机交换单词位置。这些语义负样本在改变细节语义的同时保持句子结构不变。因此,模型可以更有效地学习详细语义的结构化表示。

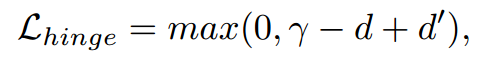

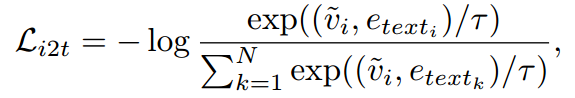

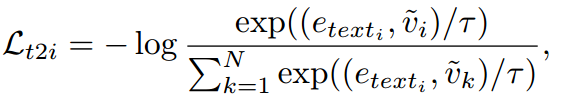

对比学习目标:本文的对比学习目标是通过将图像和原始标题拉在一起并将图像和负样本分开来学习足够的表示。具体来说,作者引入了一个带有损失函数的多模态对比学习模块:

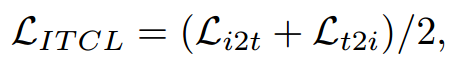

其中γ为边缘超参数,d表示图像与原标题之间的距离,表示图像与原标题之间的距离。引入了对比学习目标是为了提高结构化表征的性能。同时,为了保持模型的一般表示能力,作者将原始的小批图像-文本对比学习损失与提出的损失结合起来进行联合训练。原始的图像-文本对比学习损失包含图像-文本对比损失和文本-图像对比损失:

其中:

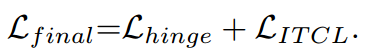

最终,模型的损失为上述loss的和:

3.2 知识增强的编码器

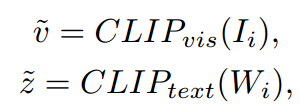

在本节中,作者提出了一种知识增强编码器,它利用场景图作为文本输入来增强结构化表示。首先,作者使用以下函数对图像和文本进行编码:

其中和表示视觉编码器和文本编码器。然而,CLIP模型以一种词包的方式处理文本输入,这种方式忽略了文本的详细语义。相比之下,结合场景图可以从句子中捕获关键的结构信息,从而使模型能够更深入地了解文本的细粒度语义。

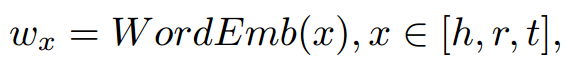

因此,知识增强编码器显式地将详细知识建模为模型输入,即对象、对象的属性以及成对对象之间的关系。具体来说,作者为两种结构化知识制定了统一的输入规范。将关系连词“is”添加到对中以统一表示。例如,以这种方式将对(white, cow)视为三元组(cow, is, white)。这样可以得到一个三元组,其中分别表示头部实体、关系实体和尾部实体。对于中的每个三元组,作者使用来自BERT的Tokenizer和Word Vocabulary Embeddings 来获得每个实体嵌入:

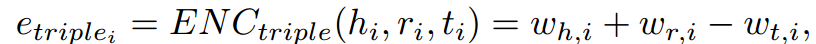

为了得到每个实体嵌入的三重嵌入,作者使用以下编码函数:

其中是三重编码函数。使用这种三重编码器可以更好地解决头部和尾部实体顺序颠倒的问题。

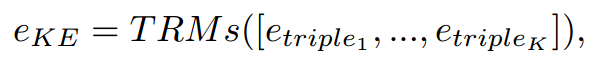

这样,K个三元组可以被处理成K个语义嵌入。然后作者输入到多个Transformer层,以获得最终的表示:

知识增强编码器使模型能够从所有输入三元组中提取足够的结构化知识来提高结构化表示的性能。

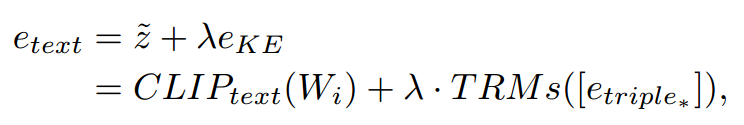

因此,可以利用知识增强编码器获得文本知识嵌入。然而,仅仅依赖结构化知识可能会导致失去对一般语义的表示。因此,作者将文本嵌入和结构化知识嵌入结合起来:

其中λ为超参数,和表示原始文本嵌入和结构知识嵌入。本文模型中的文本表示既包含整个句子所携带的词信息,也包含句子中由细节语义组成的结构化知识。

4 实验

4.1 数据集

预训练数据集:高质量的图像-文本对齐数据是训练模型的一个关键方面。作者采用了广泛使用的跨模态文本图像检索数据集MSCOCO。使用Karpathy 进行训练和评估。在本文的实验中,通过过滤大约100k对涉及多个对象、属性和关系的图像-文本来进行预训练。随后,在包含5k张图像的测试上对模型进行评估。作者使用图像到文本检索(IR)和文本到图像检索(TR)的Recall@1来衡量一般表示的能力。

下游任务数据集:使用两个新的数据集来评估结构化表示,其中每个测试用例由带有匹配的标题和交换的不匹配的标题的图像组成。该模型的任务是根据相应的图像区分对齐和未对齐的标题。(1)Visual Genome Relation(VG-Relation)。给定图像和包含关系三元组的标题,评估模型选择与图像对齐的关系的标题的能力。具体来说,希望模型能够区分“X关系Y”和“Y关系X”与特定图像(例如,“宇航员骑着马”与“马骑着宇航员”与图1(a)中的图像)。(2)Visual Genome Relation.给定“A1 O1和A2 O2”和“A2 O1和A1 O2”的形式,评估模型准确地将对象属性属性化的能力。如图1(b)所示,期望模型根据图像区分标题“红裙子和蓝书”和标题“蓝裙子和红书”。

4.2 实验结果

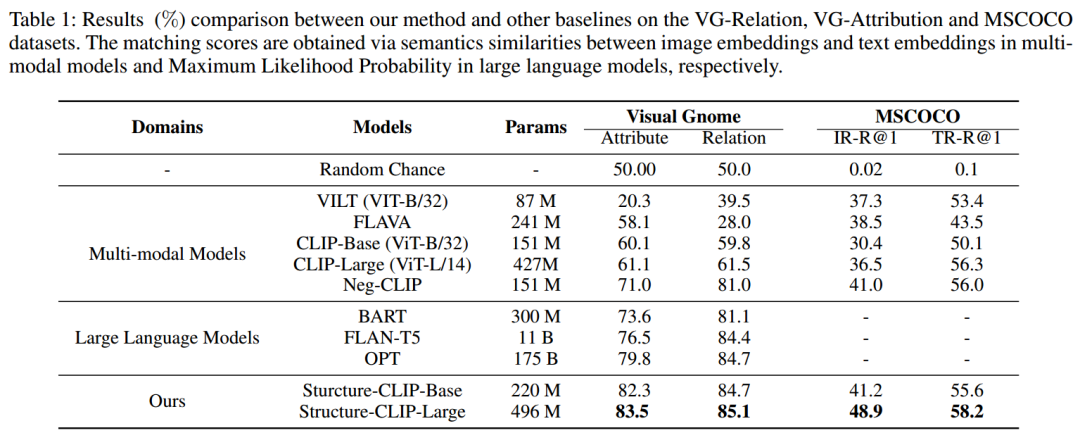

结构化表示任务:作者将他们的方法与8种代表性的SOTA方法进行比较,结果如下表所示

首先,在结构化表征方面,NegCLIP明显优于CLIP模型,这表明上述负例采样方法可以显著增强结构化表征。此外,通过利用场景图知识的指导来提高构造负例的质量,Structure-CLIP进一步增强了结构化表示。结果,structuclip在VG-Attribution和vgr上分别比现有的多模态SOTA模型(NegCLIP)高出12.5%和4.1%。作者还将Structure-CLIP与现有的大型语言模型(llm)进行了比较,后者使用图像和文本的最大似然概率作为匹配分数。研究结果表明,随着llm模型参数的显著增加,结构化表征也相应改善。然而,即使其参数小于OPT模型的1%,Structure-CLIP仍然比OPT模型分别高出3.7%和0.4%。研究结果表明,增加模型参数来改善结构化表征是资源密集型的,并且会产生次优性能,因为模型在训练阶段主要学习一般表征而不是结构化表征。相比之下,提出的Structure-CLIP方法可以显著增强结构化表示,只需要最小的模型参数增加和少量的训练。

首先,在结构化表征方面,NegCLIP明显优于CLIP模型,这表明上述负例采样方法可以显著增强结构化表征。此外,通过利用场景图知识的指导来提高构造负例的质量,Structure-CLIP进一步增强了结构化表示。结果,structuclip在VG-Attribution和vgr上分别比现有的多模态SOTA模型(NegCLIP)高出12.5%和4.1%。作者还将Structure-CLIP与现有的大型语言模型(llm)进行了比较,后者使用图像和文本的最大似然概率作为匹配分数。研究结果表明,随着llm模型参数的显著增加,结构化表征也相应改善。然而,即使其参数小于OPT模型的1%,Structure-CLIP仍然比OPT模型分别高出3.7%和0.4%。研究结果表明,增加模型参数来改善结构化表征是资源密集型的,并且会产生次优性能,因为模型在训练阶段主要学习一般表征而不是结构化表征。相比之下,提出的Structure-CLIP方法可以显著增强结构化表示,只需要最小的模型参数增加和少量的训练。

一般表示任务:作者评估了Structure-CLIP在一般表示任务上的性能。Structure-CLIP在MSCOCO数据集上的性能与NegCLIP相当。换句话说,虽然大大提高了结构化表示的性能,但Structure-CLIP保留了一般表示的能力。此外,研究结果表明,使用Structure-CLIP可以同时获得足够的一般表示和结构化表示,而以前的模型产生的结构化表示不足。

4.3 消融实验

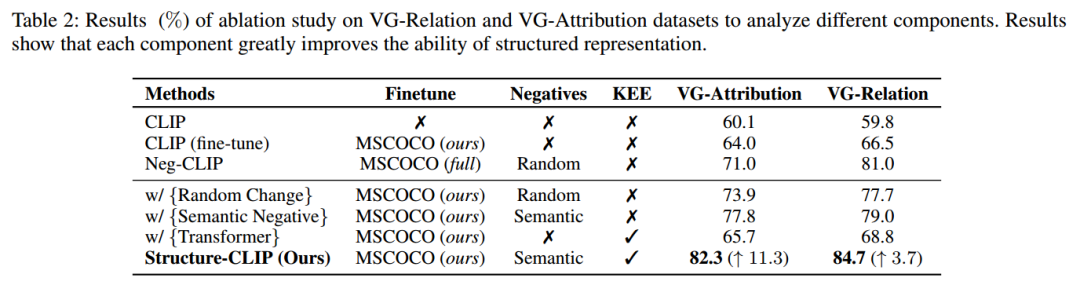

作者进行了一项消融研究,以评估基于clip的多个增强版本的VG-Relation和VG-Attribution数据集模型。结果如下表所示:

首先,实验结果表明,当使用语义负采样策略而不是随机负采样策略时,性能有了显著的提高(第4行与第5行)。在VG-attribution和VG-Relation数据集上,性能分别提高了3.9%和1.3%,这表明作者提出的方法产生了更高质量的负样本,从而产生了更好的结构化表征。

通过提出的知识增强编码器(knowledge – enhanced Encoder)将结构化知识作为输入,只产生了轻微的改进(第2行与第6行)。这些发现表明,为了实现充分的结构化表示引入负例抽样是必要的。因此,知识增强编码器在与语义负采样(第5行vs第7行)相结合后实现了显著的增强。

4.4 案例分析

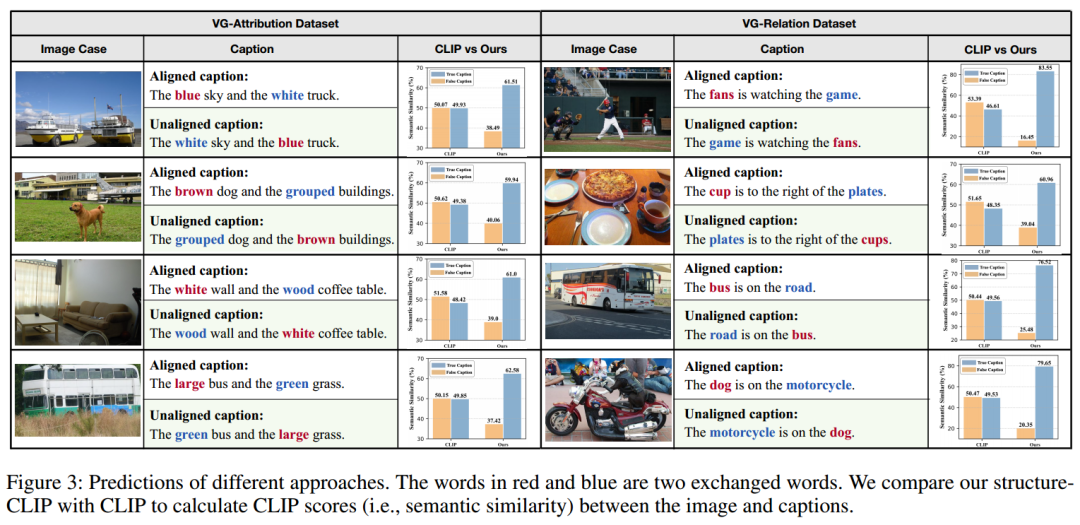

VG-Relation和VG-attribution案例的预测结果如下图所示。

这清楚地表明,Structure-CLIP可以成功区分对齐和未对齐的标题。然而,CLIP模型在准确确定这些标题与给定图像之间的语义相似性方面遇到了挑战。特别是,CLIP模型在交换两个属性或对象时表现出近乎一致的语义相似性,这表明缺乏捕获结构化语义的能力。与CLIP模型相比,Structure-CLIP对细粒度语义的修改表现出敏感性,表明它具有表示结构化知识的能力。例如,当两个属性(即蓝色和白色)交换时,使用标题“蓝天和白色卡车”来评估Structure-CLIP区分对齐和未对齐标题的能力。结果表明,Structure-CLIP能够以25.16%的差值区分对齐和未对齐的标题,进一步验证了该方法在增强多模态结构化表示方面的有效性。

5 总结

在本文中,作者提出了Structure-CLIP,旨在整合场景图知识来增强多模态结构化表示。首先,作者使用场景图来指导语义否定样例的构建。此外,引入了一个知识增强编码器,它利用场景图知识作为输入,从而进一步增强了结构化表示。提出的Structure-CLIP在预训练任务和下游任务上优于所有最近的方法,这表明Structure-CLIP可以有效地和鲁棒地理解多模态场景中的详细语义。

6 论文代码地址

论文:https://arxiv.org/pdf/2305.06152.pdf

代码:https://github.com/zjukg/Structure-CLIP.

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง