2023年12月15日,OpenAI的“超级对齐”团队发表了首篇论文,题为《弱到强的泛化:通过弱监督引出强性能》(Weak-to-Strong Generalization: Eliciting Strong Capabilities with Weak Supervision)。该论文为超级模型的实证对齐指明了新研究方向,并展示了良好的初步结果。

论文实则关乎人工智能发展的终极难题:当人工智能模型的智慧超越人类时,应怎样对强大人工智能进行有效监管,使之与人类价值观保持一致、不对人类造成伤害?

对此,OpenAI旨在探明的核心问题是:能否利用深度学习的泛化特性,以弱监督来控制强模型?即,我们能否用一个能力更弱的模型来监管另一个能力更为强大的模型?

该论文试图证明:通过弱模型监管强模型,或会是一条行之有效的路径。

01

AI VS 人类:

人工智能,人类把握得住吗?

据路透社、纽约时报等媒体报道,早在2023年3月29日,埃隆·马斯克(Elon Musk)和苹果联合创始人史蒂夫·沃兹尼亚克(Steve Wozniak)等1000多名科技界领袖呼吁暂停开发人工智能。他们担心这场“没有人能预测或控制的危险竞赛”会对社会和人类构成“深远的风险”,且可能产生“灾难性”影响。

路透社:“马斯克呼吁停止AI发展,称其对社会有害”

在由非营利组织生命未来研究所(The Future of Life Institute)发布的一封名为《暂停大型人工智能实验》公开信中,马斯克和其他科技界领袖呼吁,所有人工智能实验室应停止产品开发6个月以上,并对人工智能进行更多风险评估。

“我们呼吁所有人工智能实验室立即暂停比GPT-4更强大的人工智能系统的试验,至少6个月。”信中建议道,暂停行动应该是公开的、可核实的。如果相关实验室拒绝,呼吁者们希望政府能够介入,并强制暂停实验。

奇点指向一种假设的未来——技术超越了人类的智力,改变了人类演变的道路。而一旦人工智能达到这一点,其创新速度将远超人类。

千人署名要求暂停人工智能发展的背后,无疑是对人工智能超越人类智慧的担忧,是对“奇点将近”的惶恐。

OpenAI也认为,远超人类智慧的“超级智能”(superintelligence)将在未来十年之内涌现,而其“超级对齐”(Superalignment)团队正是为破题而来。

2023年7月,OpenAI首次提出“超级对齐”(Superalignment)的概念,并宣布将投入20%的计算资源,花费4年的时间全力打造一个超级对齐系统,意在正确引导、监控超级人工智能系统,让人工智能系统与人类价值观保持一致,确保超越人类智慧的人工智能系统亦不威胁人类安全,乃至造福人类。

02

OpenAI:“由弱到强泛化”

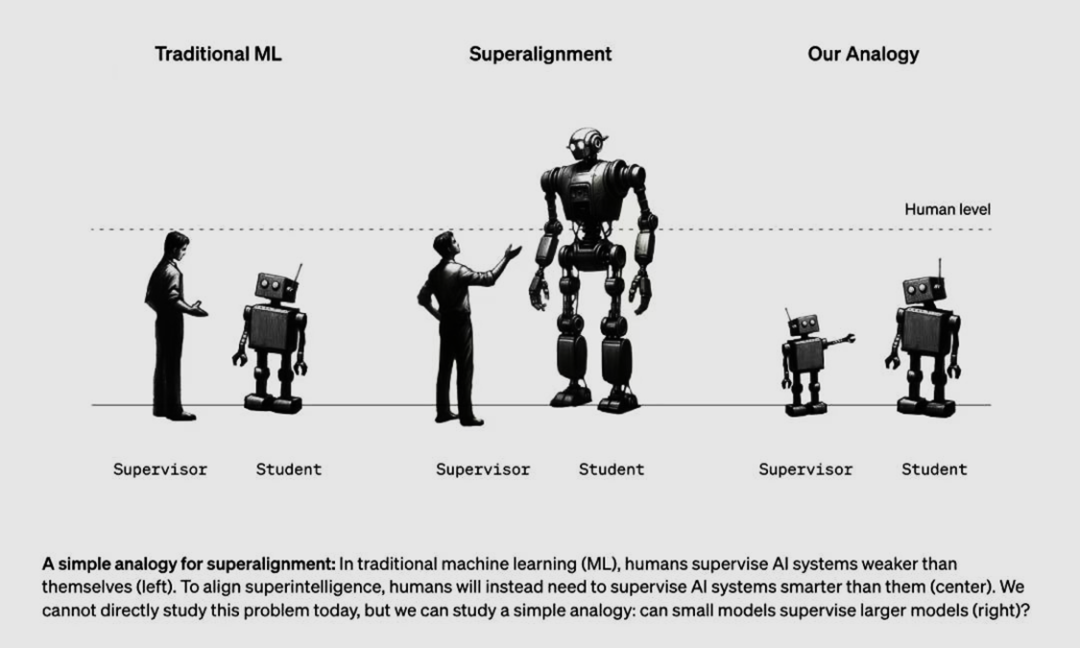

从左到右依次是“传统机器学习”(人训练弱AI)、超级对齐(人训练强AI)和OpenAI的假设(弱AI训练强AI)

图为对于超级对齐的简单类比:在传统机器学习(ML)中,人类监督比人类弱的人工智能系统(左)。为了对齐超级智能,人类将需要监督比人类更强大的人工智能系统(中)。虽然今天无法直接研究这个问题,但可以研究一个简单的类比:弱模型是否能监督强模型(右)?

OpenAI为什么要提出“从弱到强的泛化”?

现有的大模型开发主要依赖人类反馈强化学习(Reinforcement Learning from Human Feedback,简称RLHF):对于人类评估者认为好的行为给予强化,反之则予以惩罚。当人类评估者能够判断模型是否忠实地遵循指令或生成安全的输出时,这一过程非常有效,也是目前ChatGPT等大语言模型的训练核心。

然而,当AI智慧超过人类时,其将能够展现出人类无法完全理解的复杂和创造性行为。彼时,人类将无法有效评估超人类模型(Superhuman Model)的输出内容。例如,当超人类模型生成了百万行极其复杂的代码,人类将无法提供可靠监督,如:代码是否符合设计意图,模型是否诚实地回答代码的关于问题,代码是否危险、不可执行等。因此,如果我们继续通过人类监督对超人类模型进行训练,人类大概率将无法有效监督其复杂行为。换言之,基于人类反馈的强化学习技术面对超人类模型或将束手无策。为此,OpenAI提出“弱到强泛化”,以期用较弱的模型来对齐较强的模型,旨在尽可能地将与对齐相关的工作交由自动系统完成。这样一来,便可比人类更强的人工智能系统出现后,继续保证人工智能模型与人类的意志、偏好和价值观保持一致。

什么是“从弱到强的泛化”?

一言以蔽之,当在弱模型生成的标签上对强预训练模型进行简单微调时,它们的性能始终优于它们的弱监督者,这一现象被OpenAI定义为“弱到强的泛化”。使用弱模型监督强模型是“弱到强学习”的一个实例。人类只能对超人类模型进行弱监督,弱模型监督强模型是研究人类监督超人类模型的问题的类比。我们可以通过在由小模型生成的标签上对大型(强大的)预训练模型进行微调,观察它们的泛化情况来进行经验测试。与人类监督超人类模型一样,使用弱模型监督强模型也是“弱到强学习问题”(the weak-to-strong learning problem)的一个实例。

弱模型监督能否开发出更强模型的全部能力?

OpenAI认为,“弱到强学习”是可能的:一方面,强模型能够学会模仿弱监督模型(包括其错误)。另一方面,强预训练模型已具备对齐相关任务的良好反馈。例如,如果一个模型能够生成复杂的代码,那么它本身知道该代码是否忠实遵循用户的指令。因此,为了对齐的目的,我们不需要弱监督模型教强模型新的能力;相反,我们只需弱监督模型引出强模型已经知道的内容。这让我们对强模型能够在弱监督模型之外进行泛化充满了希望,甚至解决弱监督模型只能提供不完整或有缺陷的训练标签的难题。OpenAI将这一现象称为“弱到强泛化”,并在自然语言处理(NLP)、国际象棋和奖励建模任务中使用GPT-4的一系列预训练语言模型来测试这一点。

该方法能否有效监管强AI模型?

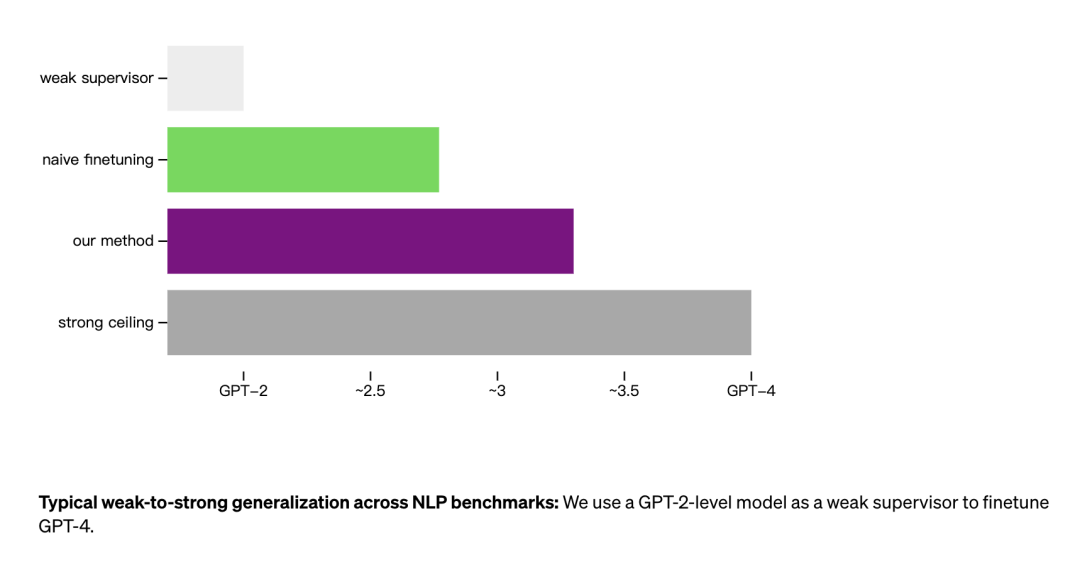

OpenAI认为的超级对齐“三基准”:

OpenAI认为的超级对齐“三基准”:

- 弱模型的性能表现基准(weak),

- 通过弱模型初始微调后的强模型的性能(weak-to-strong),

- 强模型的性能上限基准(strong ceiling)。

超级对齐的目标就是通过弱模型微调,让强模型达到其性能上限基准。在研究中,OpenAI团队以未经微调的GPT-2级模型作为弱模型,以未经微调的GPT-4为强模型。先对GPT-2的预训练模型进行人类强化反馈学习,用各种具体文本、场景、情感分析等等,微调GPT-2让它与人类价值观对齐。微调后的GPT-2即“弱监督者”,让其对更多文本、场景、情感分析输出大量结果作为带标签的数据,用以微调已完成预训练的GPT-4模型。而生成的模型表现通常在GPT-3和GPT-3.5之间,证明能够仅通过弱监督者就恢复GPT-4(强模型)的许多能力。

论文结论

1.如果使用弱模型生成的标签对强模型进行微调,强模型的表现会超出弱监督者。2.仅依靠弱监督模型数据的微调是不够的。尽管实验结果积极,但使用弱模型微调的强模型与使用人类监督微调的强模型之间仍然存在显著差距,“弱到强泛化”在ChatGPT奖励建模方面尤其不理想。综合来看,这个实验结果提供了实证证据,表明当前的人类反馈强化学习(RLHF)可能难以适用于超人类模型。3.“弱到强泛化”在一定程度上可行。综上,OpenAI的研究表明“弱监督”对齐方法的可行性。虽然目前还无法像RLHF一样有效,但至少指明了一条全新对齐方向,用AI监督AI、用AI微调AI,是未来提升大模型安全性、改善大模型性能的重要渠道之一。

03

人工智能治理,不止是技术问题

随着AI能力的迅速发展,模型对齐工作已经接近奇点,受限于人类标注者有限的能力以及规模化(Scale Up)的难度,寻求更为有效、不完全依赖人类标注者的算法迫在眉睫。OpenAI的工作带给研究团队和工业界同仁许多启发,更多研究者今后将把他们的目光转向以弱AI监督强AI自提升的算法道路。

技术的探索毋庸置疑是必要的,但与此同时,人工智能是否应该继续开发,并不单单是技术问题,还涉及治理、伦理等诸多方面。好的监管规则,能在一定程度上限制危险技术的开发、扩散或滥用。也为中国未来的AI监管提供了注解,本文认为可从以下5方面进行探索:

1.加强数据监管:以弱AI监督强AI需要大量数据支持,因此应该加强对数据的监管,包括数据质量、数据隐私等方面。

2.强化算法公正性:在以弱AI监督强AI的过程中,需要确保算法的公正性,避免算法偏见和歧视。这需要采用多样化的数据集进行训练,同时对算法进行严格的测试和验证。

3.推广算法解释性技术:对于强AI的模型,应该采用算法解释性技术,以便相关机构能够理解并掌握其工作原理和运行过程。

4.建立安全机制:为确保强AI的模型安全,需要建立安全机制,包括安全验证、安全设计和安全防护等方面,避免恶意攻击或误用导致造成的不利影响。

5.加强人工智能伦理方面的研究:以弱AI监督强AI需要关注人工智能伦理方面的问题,如隐私保护、公平性、透明度等,需要加强研究和探索相关的理论和方法。

国际社会正积极构建人工智能治理框架,如欧盟的《人工智能法案》、拜登政府人工智能监管行政令、中美英等多方联署的《布莱切利宣言》文件,均为确保人工智能与人类价值观和道德原则保持一致制定了原则框架,旨在促进人工智能融入人类社会,确保它服务于人类、造福于人类。中国亦在积极探索人工智能治理。于2023年陆续颁布《全球人工智能治理倡议》《生成式人工智能服务管理暂行办法》《网络安全标准实践指南 —— 生成式人工智能服务内容标识方法》等政策文件,中国正牢牢把握本次科技革命新机遇,不断深化在全球人工智能治理规则领域的参与和话语权构建。人工智能的治理需要多方共同的努力,只有将科技创新与人文关怀相结合,才能构建出一个开放、包容、安全、可持续的全球人工智能治理体系,为全球人工智能治理作出更多贡献,并推动人工智能造福人类的伟大事业不断前行。

参考来源:https://openai.com/research/weak-to-strong-generalization

论文链接:https://cdn.openai.com/papers/weak-to-strong-generalization.pdf

主理人丨刘典

文案丨陶含孜 王昕晨

排版丨赵杨博

校审丨王祚

终审丨梁正 鲁俊群

END

2023人工智能大事件回顾丨中国AI政策篇

2023人工智能大事件回顾丨中国AI大模型篇

2023人工智能大事件回顾丨中国科技巨头篇

2023人工智能大事件回顾丨国际治理篇

关于我们

清华大学人工智能国际治理研究院(Institute for AI International Governance, Tsinghua University,THU I-AIIG)是2020年4月由清华大学成立的校级科研机构。依托清华大学在人工智能与国际治理方面的已有积累和跨学科优势,研究院面向人工智能国际治理重大理论问题及政策需求开展研究,致力于提升清华在该领域的全球学术影响力和政策引领作用,为中国积极参与人工智能国际治理提供智力支撑。

新浪微博:@清华大学人工智能国际治理研究院

微信视频号:THU-AIIG

Bilibili:清华大学AIIG

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง