导语

境自远尘皆入咏,物含妙理总堪寻。

人类大脑是一个由数以百亿计的神经元相互连接所构成的复杂系统,被认为是「已知宇宙中最复杂的物体」。本着促进来自神经科学、系统科学、信息科学、物理学、数学以及计算机科学等不同领域,对脑科学、类脑智能与计算、人工智能感兴趣的学术工作者的交流与合作,集智俱乐部联合国内外多所知名高校的专家学者发起神经、认知、智能系列读书会第三季——「计算神经科学」读书会,涵盖复杂神经动力学、神经元建模与计算、跨尺度神经动力学、计算神经科学与AI的融合四大模块,并希望探讨计算神经科学对类脑智能和人工智能的启发。读书会从2024年2月22日开始,每周四19:00-21:00进行,持续时间预计10-15周,欢迎感兴趣的朋友报名参与,深入梳理相关文献、激发跨学科的学术火花!

读书会背景

如同理论物理之于物理学,计算神经科学在大脑研究中扮演着重要的角色。综合运用神经科学、数学、物理学、信息科学等多个学科的知识,计算神经科学家们试图将大脑看作一个自组织系统,通过脑的非线性行为和复杂性研究来理解生物神经网络的功能和运行机理。来自不同学科背景的研究人员已经从不同层级尺度和角度将脑作为信息处理系统构建模型进行研究,包含神经元对信息的编解码机制、神经元之间的相互作用机理、皮层功能柱间连接模式、脑区间不同认知功能分离与整合模式等。这些研究都试图揭示人脑这一最为复杂的神经系统的工作模式,进而理解语言、情绪、运动、记忆和社会交往等高级认知活动的底层神经机制,并一定程度上促进类脑人工智能技术的发展。

读书会简介

本着促进来自神经科学、系统科学、信息科学、物理学、数学以及计算机科学等不同领域,对脑科学、类脑智能与人工智能感兴趣的学术工作者的交流与合作,激发同学们的研究兴趣,集智俱乐部联合国内外多所知名高校的专家学者(详见发起人介绍)继续发起了神经、认知、智能系列读书会第三季——「计算神经科学」读书会,聚焦大脑在神经元及其环路的微观尺度的信息处理机制及其鲁棒性与非线性,在介观与宏观尺度认知功能的组织结构特征的适应性与稳定性,以及对类脑智能及人工智能的启发,对相关文献进行深入梳理、激发跨学科的学术火花。

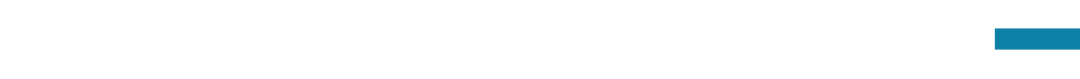

读书会框架

分享预告:复杂神经动力学的全景与基础

1. 周昌松:机器学习与神经科学(Machine Learning: from and in Neuroscience)

生物神经网络对机器学习中人工神经网络(ANNs)的启发已经得到了广泛的认识。然而,大脑中的生物神经网络在网络结构和活动模式上要复杂得多,可以将其视为通过演化和学习来训练以支持人类的自然智能的网络。另一方面,人工神经网络和机器学习作为强大的数据分析工具被越来越多地应用于神经科学的诸多研究中。更有趣的是,人工神经网络提供了一种新的方法来研究复杂行为背后的计算原理。

本讲座将对上述内容进行简要概述:首先介绍大脑网络的结构连接和动力学的复杂性,及其与认知能力和自然智能的复杂关系;然后总结在神经科学中用于复杂数据分析和复杂行为计算原理探索的机器学习技术。希望这样的总结能给大家提供一个俯瞰领域的视角,激发大家对开发大脑启发的,特别是利用了大脑的网络连接结构和动力复杂性的机器学习和人工智能系统的兴趣。

2. 弭元元:神经计算建模基础与入门

大脑的高级认知功能,如感知、运动、学习与记忆等,都是由海量神经元所构成的复杂神经网络来实现的。网络中的神经元接收外部输入信息,通过突触连接相互作用,在记忆、注意、情感等因素调控下,使得网络状态发生改变,进而实现了对信息的编码、存储、整合等操作。破解神经系统的信息处理机制,不仅是阐明大脑高级认知功能的基础,也是发展人工智能的重要思想源泉。

本讲座将简要介绍单神经元、神经突触、神经网络三个不同层面的神经计算建模相关知识。

3. 唐乾元:Sloppiness模型简介与理论基础

复杂系统不仅在变量空间有着极高的自由度,其在参数空间同样也有非常高的自由度。在大量参数不确定的情况下,我们是否仍然可以对系统的动力学情况进行预测?如果错误地估计了某个参数,我们所预测的动力学会跟原来的动力学产生怎样的差异?有趣的是,许多复杂系统的工作状态似乎不会由于少数参数的改变而发生剧烈的变化,例如一个深度学习网络,其中可能包含上千万个参数,但一个能够有较好泛化能力的网络,往往不会因为参数的扰动影响其表现。Sloppy 模型所描述的就是这样一类多参数模型,这类模型的行为只取决于几个参数的严格组合,而其它许多参数方向对模型预测来说并不重要。这样的模型在生命科学、物理学和人工智能等领域中无处不在。

这一讲,讲者将介绍有关sloppy模型和sloppiness分析的有关理论基础。

发起人

周昌松,物理学博士,香港浸会大学物理系教授、系主任,浸会大学非线性研究中心主任,计算及理论研究所副所长, 生命科学影像中心主任。

研究方向:对生物神经网络复杂结构、动力学及其低成本高效益如何启发类脑智能具有浓厚的兴趣。致力于复杂系统动力学基础研究及其应用,特别是网络的复杂联结结构与体系的动态行为的关系和相互作用。近几年与国际国内系统和认知神经科学家合作,把这些理论进展应用到大脑的复杂联结结构和活动以及认知功能及障碍的分析和建模等方面研究中。

弭元元,清华大学心理学系长聘副教授。2012年于北京师范大学获得理论物理专业博士学位,先后在以色列Weizmann Institute of Science和美国Columbia University作博士后研究。

研究方向:计算神经科学。专注于采用数理建模和计算仿真的方法研究脑在网络层面处理动态信息的一般性原理,包括工作记忆的容量与调控、时空信息的网络编码等;并基于此发展了类脑运动模式的快速识别算法、运动目标的预测追踪算法等。

傅渥成(唐乾元),香港浸会大学助理教授,集智科学家,集智-凯风研读营学者。南京大学物理学博士,曾是是日本理化学研究所博士后。

研究方向:数据驱动的复杂系统研究;生物医学领域的人工智能;蛋白质进化和动力学;生物系统的复杂性和临界性。

臧蕴亮,天津大学医学工程与转化医学研究院英才教授,博士毕业于浙江大学生物医学工程专业,先后在日本冲绳科学技术研究院大学的Erik De Schutter教授以及美国布兰迪斯大学的Eve Marder教授(美国科学院院士)课题组从事科学研究。

研究方向:类脑仿真和类脑智能研究。(1)脑启发智能:提炼脑认知功能的已知高效算法(大多未知),启发人工智能研究,目前聚焦基于小脑和果蝇等环路的类脑算法;(2)计算神经科学:采用bottom-up方式,构建数据约束的神经元和环路模型理解运动学习、记忆、决策和异常检测等功能的工作机制和计算原理;(3)树突计算:探索树突非线性特性对信息处理学习的作用。

冯志聪(Alan Fung),香港城市大学神经科学系助理教授。2006 年开始研究连续吸引子神经网络(CANN)模型。

研究方向:专注在计算神经科学领域,基于数学工具和数值方法的基础脑科学的计算模型、神经现象的机器学习实现、数据驱动的神经数据分析,希望能够促进神经科学和人工智能的相互启发。

杜凯,北京大学人工智能研究院助理研究员。杜凯博士于2002年在北京航空航天大学飞行器动力工程系获得学士学位,并于2016年在瑞典卡罗琳斯卡医学院神经科学系取得博士学位,随后在该院进行了博士后研究至2020年。在2013至2016年间,他是欧盟脑计划“大脑仿真平台”瑞典团队的主要成员。2020年,加入了北京大学人工智能研究院,并参与创建了北京智源人工智能研究院的生命模拟部门。

研究方向:大脑精细仿真,树突计算,以及基于大脑精细模型的新型人工智能系统和理论。主要贡献包括构建了首个针对基底核脑区的精细神经元模型,并开发了一种基于GPU的高性能计算框架—DeepDendrite。该框架不仅显著提高了大脑模拟的计算速度,还成功地将树突计算原理与人工智能模型进行了紧密的整合。

李松挺,上海交通大学自然科学研究院、数学科学学院教授。2010年和2014年于上海交通大学分别取得数学本科和博士学位,2015-2018年于纽约大学柯朗研究所任博士后。

研究方向:神经元树突计算、神经元回路和大尺度神经网络动力学分析、脑启发的机器学习算法。

胡禹,香港科技大学数学系和生命科学学部助理教授。2014年在华盛顿大学取得应用数学博士学位,并曾在哈佛大学和以色利希伯来大学从事博士后研究。

研究方向:神经元网络中连接图结构和其动力学性质之间的关系;建模和分析神经元活动数据中的回路机制。提出了刻画连接模体(motif)影响神经元群体相关性的数学工具,和解释神经元活动维度性质的动力学模型。

张铁林,中科院自动化所复杂系统认知与决策实验室副研究员,智能机制机理研究部PI。

研究方向:研究组十分关注新型类脑脉冲神经网络,研究方向包括类脑脉冲神经网络、脑动力学模拟仿真、脑机接口类脑芯片。提出自组织可塑性传播模型、神经调制的类脑连续学习方法、基于多巴胺奖赏传播的SNN高效学习方法和基于多尺度可塑性的SNN架构体系,也将算法应用于图像识别、自然语言处理、连续动作控制等任务,并形成面向侵入式脑机接口的专用类脑芯片。

刘健,伯明翰大学神经计算实验室副教授。

研究方向: 计算神经科学,脑启发计算,类脑智能,神经形态计算。具体包括(1)计算脑科学:理解大脑的基本运算机制,例如感知、学习和记忆、决策和运动控制,以及数据分析和建模的方法和算法;(2)计算机器人:研究类脑计算和神经形态计算技术,并为智能机器人设计感知、决策与控制的新型算法和计算模型;(3)计算医学:利用机器学习设计用于治疗脑疾病的药物模型(神经系统的分子药物与物理模型)和疗法(机器辅助的神经假体和脑机接口)。

刘泉影,南方科技大学生物医学工程系助理教授,博士生导师,神经计算与控制实验室PI。本科和硕士毕业于兰州大学信息学院,博士毕业于瑞士苏黎世联邦理工大学生物医学工程方向,在美国加州理工学院进行计算与数学科学方向的博士后训练。

研究方向:机器学习算法、多模态神经信号处理、神经计算建模、医学人工智能等。

邀请报告

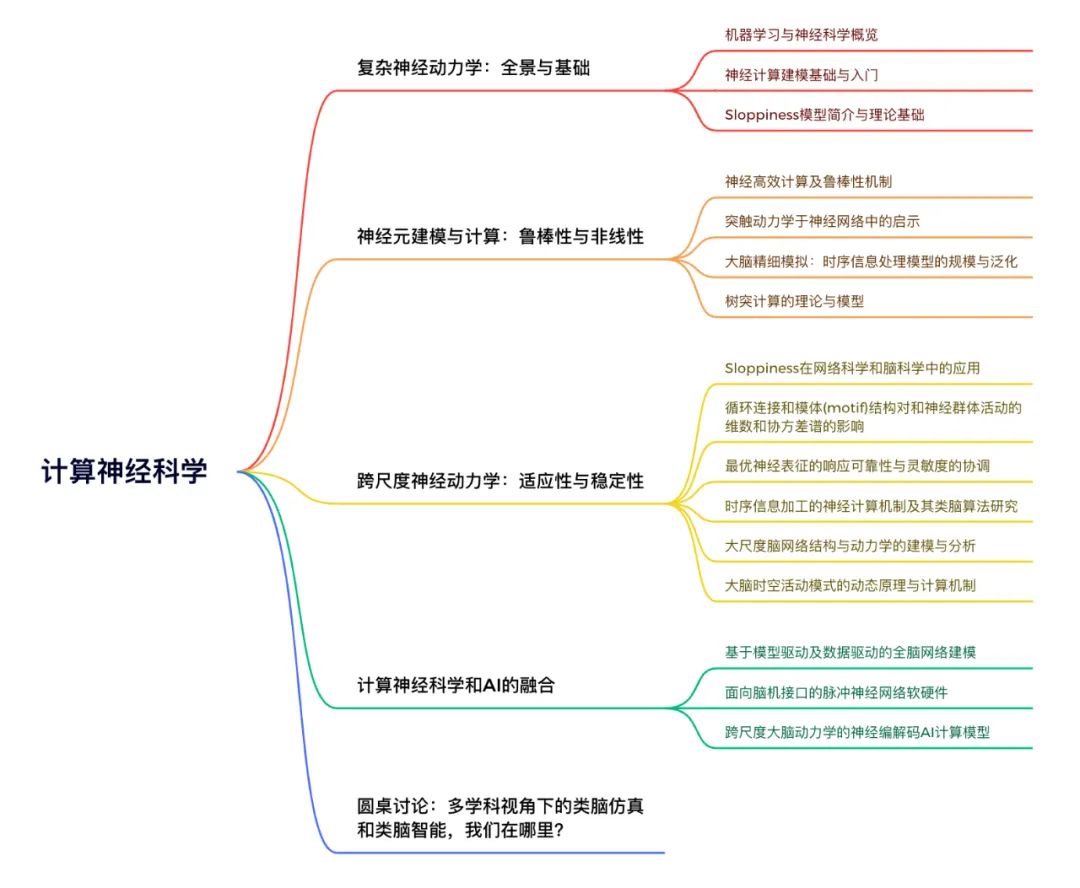

龚璞林(Pulin Gong),悉尼大学物理学院副教授,理论计算研究组主任。在加入悉尼大学之前,他是日本RIKEN脑科学研究所的一名研究员。希望能更好地理解大脑时空动态的自组织机制以及这些动态如何实现神经计算的基本原理。

研究方向:脑时空动力学,认知的神经和计算机制,类脑人工智能。

本季读书会运营负责人周莉,集智科学研究中心副秘书长。兴趣领域:认知的边界,认知的普遍性与差异性,个体与群体的认知与决策,社区营造。

报名参与读书会

本读书会适合参与的对象

-

基于复杂系统相关学科研究,对从多尺度与动力学角度理解大脑的信息处理机制及其对类脑智能、人工智能启发相关研究有浓厚兴趣的科研工作者;

-

具有一定神经科学、系统科学、信息科学、物理学、数学以及计算机科学的学科背景,在领域内有一定的研究基础,想进一步进行交叉学科研究与交流的学者、研究生、本科生。

-

对复杂科学充满激情,对世界,特别是生命与大脑的本质充满好奇的探索者,且具备一定的英文文献阅读能力的探索者。

- 想锻炼自己科研能力或者有出国留学计划的高年级本科生及研究生。

本读书会谢绝参与的对象

为确保专业性和讨论的聚焦,本读书会谢绝脱离读书会主题和复杂科学问题本身的空泛的哲学和思辨式讨论;不提倡过度引申在社会、人文、管理、政治、经济等应用层面的讨论。我们将对参与人员进行筛选,如果出现讨论内容不符合要求、经提醒无效者,会被移除群聊并对未参与部分退费,解释权归集智俱乐部所有。

运行模式

本季读书会预计讨论分享10-15次,以主题分享的形式按照暂定框架贯次展开;每周进行线上会议,与会者可以广泛参与讨论,会后可以获得视频回放持续学习。

举办时间

从2024年2月22日开始,每周四19:00-21:00,持续时间预计10-15 周。我们也会对每次分享的内容进行录制,剪辑后发布在集智斑图网站上,供读书会成员回看,因此报名的成员可以根据自己的时间自由安排学习时间。

参与方式

此次读书会为线上闭门读书会,采用的会议软件是腾讯会议(请提前下载安装)。在扫码完成报名并添加负责人微信后,负责人会将您拉入交流社区(微信群),入群后告知具体的会议号码。

报名方式

第一步:扫码填写报名信息。 扫码报名第二步:填写信息后,付费299元。第三步:添加负责人微信,拉入对应主题的读书会社区(微信群)。本读书会可开发票,请联系相关负责人沟通详情。

扫码报名第二步:填写信息后,付费299元。第三步:添加负责人微信,拉入对应主题的读书会社区(微信群)。本读书会可开发票,请联系相关负责人沟通详情。

共学共研模式与退费机制

读书会采用共学共研的机制,围绕前沿主题进行内容梳理和沉淀。读书会成员可通过内容共创任务获得积分,解锁更多网站内容,积分达到标准后可退费。发起人和主讲人作为读书会成员,均遵循内容共创共享的退费机制,暂无其他金钱激励。读书会成员可以在读书会期间申请成为主讲人,分享或领读相关研究。

加入社区后可以获得的资源:

-

在线会议室沉浸式讨论:与主讲人即时讨论交流

-

交互式播放器高效回看:快速定位主讲人提到的术语、论文、大纲、讨论等重要时间点(详情请见:解放科研时间,轻松掌握学术分享:集智斑图推出可交互式播放器)

-

高质量的主题微信社群:硕博比例超过80%的成员微信社区,闭门夜谈和交流

-

超多学习资源随手可得:从不同尺度记录主题下的路径、词条、前沿解读、算法、学者等

-

参与社区内容共创任务:读书会笔记、百科词条、公众号文章、论文解读分享等不同难度共创任务,在学习中贡献,在付出中收获。

- 共享追踪主题前沿进展:在群内和公众号分享最新进展,领域论文速递

参与共创任务,共建学术社区:

-

读书会笔记:在交互式播放器上记录术语和参考文献

-

集智百科词条:围绕读书会主题中重要且前沿的知识概念梳理成词条。例如:

论文解读分享:认领待读列表中的论文,以主题报告的形式在社区分享

论文摘要翻译:翻译社区推荐论文中的摘要和图注

-

论文翻译

– 诺奖之后的复杂科学:18位学者勾勒未来20年复杂系统研究图景

-

科普文章翻译

-

讲座整理

– AI何以涌现:复杂适应系统视角的ChatGPT和大语言模型

PS:具体参与方式可以加入读书会后查看对应的共创任务列表,领取任务,与运营负责人沟通详情,上述规则的最终解释权归集智俱乐部所有。

阅读资料

阅读材料较长,为了更好的阅读体验,建议您前往集智斑图沉浸式阅读,并可收藏感兴趣的论文。

读书会阅读清单

读书会阅读清单

1. 复杂神经动力学:全景与基础

周昌松:机器学习与神经科学(Machine Learning: from and in Neuroscience)

综述文章,重点梳理了有监督机器学习在系统神经科学中的概念应用,认为有监督机器学习可以在以下四个方面发挥重要作用:(1)工程问题;(2)预测变量识别;(3)简单模型基础测试;(4)作为一种大脑模型。

Glaser, J. I., Benjamin, A. S., Farhoodi, R., & Kording, K. P. (2019). The roles of supervised machine learning in systems neuroscience. Progress in Neurobiology, 175, 126–137.

文章创新性的提出基于神经影像的“大脑年龄”作为个人大脑健康的生物标志物。

HJ Cole, K Franke, Predicting Aging Using Neuroimaging: Innovative Brain Ageing Biomarkers, Trends in Neuroscience 2017.

文章将视觉的深度神经网络模型与语义的吸引子网络模型相结合来研究视觉语义处理。

Devereux, B. J., Clarke, A., & Tyler, L. K. (2018). Integrated deep visual and semantic attractor neural networks predict fMRI pattern-information along the ventral object processing pathway. Scientific reports, 8(1), 10636.

文章通过训练单个网络模型来执行 20 项依赖于工作记忆、决策、分类和抑制控制的认知任务,提供了一个研究许多认知任务的神经表征的计算平台。

Guangyu Robert Yang, Madhura R. Joglekar, H. Francis Song, William T. Newsome and Xiao-Jing Wang, Task representations in neural networks trained to perform many cognitive tasks.Nature neuroscience, 2019.

文章提出了一个基于梯度下降的兴奋-抑制 RNN 训练框架,融合了大脑的生物学特征,能够简单、灵活的进行RNN的探索性训练。

Song HF, Yang GR, Wang XJ (2016) Training Excitatory-Inhibitory Recurrent Neural Networks for Cognitive Tasks: A Simple and Flexible Framework. PLOS Computational Biology 12(2): e1004792

人工神经网络(ANN)是机器学习的重要工具,在神经科学领域能够于构建复杂行为、异构神经活动和电路连接的模型,并以传统模型无法设计的方式探索神经系统的优化。这是一篇给神经科学家的人工神经网络使用教程:首先讨论人工神经网络的基本概念和方法。然后,重点关注如何使这个数学框架更接近神经生物学,详细介绍了如何定制人工神经网络的分析、结构和学习,以更好地解决大脑研究中的各种挑战。

Guangyu Robert Yang, Xiao-Jing Wang.Artificial neural networks for neuroscientists: A primer. Neuron. 2020.

感知、维持和使用工作记忆中的时间间隔对于动物在不断变化的世界中在正确的时间预测或采取正确的行动至关重要。文章结合空间信息处理和决策过程训练循环神经网络来研究其中的神经机制。发现神经网络通过旧有轨迹的状态演化来感知时间,并通过缩放演化速度来产生时间间隔。Zedong Bi and Changsong Zhou, Understanding the computation of time using neural network models, Proc Natl Acad Sci USA, 117, 10530 (2020).

弭元元:神经计算建模基础与入门

《神经计算建模实战:基于BrainPy》,王超名,陈啸宇、张天秋、吴思,电子工业出版社,2023.06.《计算认知神经科学》,吴思,科学出版社,2023.03.BrainPy:https://brainpy.readthedocs.io/en/latest/

唐乾元:Sloppiness模型简介与理论基础

关于Sloopy Model的学习资料Sloopy Model: https://www.lassp.cornell.edu/sethna/Sloppy/https://mp.weixin.qq.com/s/uhT768tQ_MVPuJRiDpO7Jg

2. 神经元建模与计算:鲁棒性与非线性

臧蕴亮:神经高效计算及鲁棒性机制

从依据兴奋状态的学习和计算机制开始Zang, Y., S. Hong and E. De Schutter (2020). “Firing rate-dependent phase responses of Purkinje cells support transient oscillations.” Elife 9.

Zang, Y., S. Dieudonne and E. De Schutter (2018). “Voltage- and Branch-Specific Climbing Fiber Responses in Purkinje Cells.” Cell Rep 24(6): 1536-1549.

到神经系统抗噪性能Zang, Y. and E. Marder (2023). “Neuronal morphology enhances robustness to perturbations of channel densities.” Proc Natl Acad Sci U S A 120(8): e2219049120.

Zang, Y., E. Marder and S. Marom (2023). “Sodium channel slow inactivation normalizes firing in axons with uneven conductance distributions.” Curr Biol 33(9): 1818-1824 e1813.

最后展望未来工作Zang, Y.; De Schutter, E. Recent data on the cerebellum require new models and theories. Curr. Opin. Neurobiol. 2023, 82, 102765.

冯志聪:突触动力学对于神经网络中模式分离的启示

由 Tsodyks 及 Markram 提出的数学模型

Tsodyks, Misha V., and Henry Markram. “The neural code between neocortical pyramidal neurons depends on neurotransmitter release probability.” Proceedings of the national academy of sciences 94.2 (1997): 719-723.

结合 TM 模型与连续吸引子神经网络的理论研究

Fung, CC Alan, et al. “Dynamical synapses enhance neural information processing: gracefulness, accuracy, and mobility.” Neural computation 24.5 (2012): 1147-1185.

突触竞争如何达至模式分离的研究Fung, Chi Chung Alan, and Tomoki Fukai. “Competition on presynaptic resources enhances the discrimination of interfering memories.” PNAS nexus 2.6 (2023): pgad161.由 Misha Tsodyks 及吴思撰写的简介:Short-term synaptic plasticityhttp://www.scholarpedia.org/article/Short-term_synaptic_plasticity

杜凯 :大脑精细模拟:时序信息处理模型的规模与泛化

神经元树突表现出一系列线性和非线性机制,使它们能够实现基本计算。这两篇论文讨论树突特性对于神经元和网络执行的计算的重要性,并提供理论和实验示例来支持。Stuart GJ, Spruston N. Dendritic integration: 60 years of progress. Nat Neurosci. 2015 Dec;18(12):1713-21. doi: 10.1038/nn.4157. Epub 2015 Nov 25. PMID: 26605882.

London M, Häusser M. Dendritic computation. Annu Rev Neurosci. 2005;28:503-32. doi: 10.1146/annurev.neuro.28.061604.135703. PMID: 16033324.

综述性介绍了树突计算建模领域发展,重点介绍了建模和实验神经科学界之间成功相互作用的研究。

Poirazi, Panayiota, and Athanasia Papoutsi. “Illuminating dendritic function with computational models.” Nature Reviews Neuroscience 21.6 (2020): 303-321.

提出了Dendritic Hierarchical Scheduling(DHS)方法,提高舱室模型模拟器求解大型线性方程组的能力。Zhang, Yichen, et al. “A GPU-based computational framework that bridges Neuron simulation and Artificial Intelligence.” Nature Communications 14.1 (2023): 5798.

李松挺:树突计算的数学理论与模型

神经元树突计算经典综述论文。

London, M. and Häusser, M. “Dendritic computation.” Annu. Rev. Neurosci. 28: 503-532. (2005)

树突计算的理论与建模研究较新综述论文。

Poirazi, P., Papoutsi, A. Illuminating dendritic function with computational models. Nat Rev Neurosci 21, 303–321 (2020).

神经元树突整合的有效数学模型介绍。Li, S., Liu, N., Zhang, X., McLaughlin, D. W., Zhou, D., & Cai, D. Dendritic computations captured by an effective point neuron model. Proceedings of the National Academy of Sciences USA, 116(30), 15244-15252. (2019)

3. 跨尺度神经动力学:计算及应用

唐乾元:Sloppiness在网络科学和脑科学中的应用

系统生物学中的低敏感度参数

Gutenkunst, Ryan N., Joshua J. Waterfall, Fergal P. Casey, Kevin S. Brown, Christopher R. Myers, and James P. Sethna. “Universally Sloppy Parameter Sensitivities in Systems Biology Models.” PLoS Computational Biology 3, no. 10 (2007): e189.

参数空间压缩作为新兴理论和预测模型的基础

Machta, B. B., R. Chachra, M. K. Transtrum, and J. P. Sethna. “Parameter Space Compression Underlies Emergent Theories and Predictive Models.” Science 342, no. 6158 (November 1, 2013): 604–7.

为什么蛋白质兼具可塑性与稳定性?从进化视角揭示生命复杂系统的内在平衡

Qian-Yuan Tang, Testsuhiro S. Hatakeyama, Kunihiko Kaneko, Functional Sensitivity and Mutational Robustness of Proteins, Physical Review Research 2(3), 033452 (2020).

蛋白质的动力学和进化之间的对应关系:两个不同时间尺度下的相同故事Qian-Yuan Tang, Kunihiko Kaneko. Dynamics-Evolution Correspondence of Protein Structures. Physical Review Letters, 127, 098103 (2021).

胡禹:循环连接和模体(motif)结构对和神经群体活动的维数和协方差谱的影响(Dimension and covariance spectrum of neural activity shaped by recurrent interactions and motifs)

关于correlation and connectivity 之间关系的综述文章,其中介绍了5 年内的经典工作:

Ocker et al, From the statistics of connectivity to the statistics of spike times in neuronal networks, Current Opinion in Neurobiology, 2017

这两篇文章将connectivity statistics和covariance spectrum 联系起来,后者(spectrum)和dimension of neural activity有密切关系:Recanatesi et al, Dimensionality in recurrent spiking networks: Global trends in activity and local origins in connectivity. PLOS CB 2019

Hu & Sompolinsky, The spectrum of covariance matrices of randomly connected recurrent neuronal networks with linear dynamics, PLOS CB 2022

这是一篇前沿工作,将 connectivity statistics 和dimension 的联系推广到nonlinear and chaotic networks:

Clark et al, Dimension of Activity in Random Neural Networks, PRL 2023

这篇预印本详细讨论了如何将上述理论应用到实验数据中:

Dahmen et al, Strong and localized recurrentce controls dimensionality of neural activity across brain areas, Biorxiv 2023

这是一篇基础性工作,提出了在发放神经元循环网络模型中,描述连接结构以及单细胞内在动力学对神经元相关性的影响的数学方法:Trousdale et al, Impact of network structure and cellular response on spike time correlations, PLOS CB 2012

周昌松:最优神经表征的响应可靠性与灵敏度的协调

研究提出自下而上兴奋-抑制动力学模型研究大脑的神经回路,以更综合的方式解释了自发状态和诱发状态的跨尺度神经动力学。Liang, Junhao, and Changsong Zhou. “Criticality enhances the multilevel reliability of stimulus responses in cortical neural networks.” PLoS computational biology 18.1 (2022): e1009848.

弭元元:时序信息加工的神经计算机制及其类脑算法研究

提出一个基于 RNN 学习表示时间序数结构的树状吸引子结构,能够很好的将空间信息及其对应的序列分离,在时间信息处理中具有计算优势,。Learning and processing the ordinal information of temporal sequences in recurrent neural circuits

https://openreview.net/forum?id=eeeqORvJbf

提出一种通用的时空模式识别计算模型,能够很好的实现空间信息的提取,在模式识别中具有广阔的应用场景。Lin, Xiaohan, et al. “A brain-inspired computational model for spatio-temporal information processing.” Neural Networks 143 (2021): 74-87.

李松挺:大尺度脑网络结构与动力学的建模与分析

大脑中时间尺度层级结构的理论模型和分析研究。

Chaudhuri, R., Knoblauch, K., Gariel, M. A., Kennedy, H., & Wang, X. J. A large-scale circuit mechanism for hierarchical dynamical processing in the primate cortex. Neuron, 88(2), 419-431. (2015)

对猕猴皮层的网络模型进行数学分析揭示时间尺度层级结构背后的数学机制和生物学意义。

Li, S., & Wang, X. J. Hierarchical timescales in the neocortex: Mathematical mechanism and biological insights. Proceedings of the National Academy of Sciences, 119(6), e2110274119. (2022)

多脑区皮层计算的理论和建模分析综述。

Wang, X. J. Theory of the multiregional neocortex: large-scale neural dynamics and distributed cognition. Annual review of neuroscience, 45, 533-560. (2022)

最大熵原理刻画跨物种大脑网络的结构特点。Song, Y., Zhou, D., & Li, S. Maximum entropy principle underlies wiring length distribution in brain networks. Cerebral cortex, 31(10), 4628-4641.(2021).

龚璞林:大脑时空活动模式的动态原理与计算机制(Spatiotemporal activity patterns in the brain: dynamical principles and functional roles)

分数阶神经采样(Fractional Neural Sampling,FNS)充分利用神经群体在时间和空间上呈现出的丰富而复杂的动力学,以高效执行基于采样的概率计算。因此,FNS提供了一种新理论来解决长期以来存在的多模态概率分布的采样和表征挑战。我们的FNS神经概率计算理论统一解释了神经网络动力学,以及有关知觉现象(如视觉知觉推理)的各种实验结果,从而构建了一个理论框架,用于深入理解脑功能的神经生理和计算机制。

Yang Qi and Pulin Gong. Fractional neural sampling as a theory of spatiotemporal probabilistic computations in neural circuits. Nature Communications, 13: 4572 (2022).

基于超扩散运动与θ振荡的视觉注意力时空机制不仅能够解释许多实验结果并提供了灵活切换探索 (exploration)和利用 (exploitation)的关键功能优势,而且对设计新的类脑人工智能具有重要的启发作用。

Guozhang Chen and Pulin Gong. A spatiotemporal mechanism of visual attention: Superdiffusive motion and theta oscillations of neural population activity patterns. Science Advances, eabl4995 (2022).

这项研究揭示了人类大脑复杂时空活动的一种新型基于螺旋波(vortex)的组织机制。此外,我们发现脑螺旋波与认知处理存在功能上的关联。螺旋波的相互作用提供了一种全新的视角, 用以解释在认知任务期间各个脑区如何灵活协调活动。

Yiben Xu, Xian Long, Jianfeng Feng and Pulin Gong. Interacting spiral wave patterns underlie complex brain dynamics and are related to cognitive processing. Nature Human Behaviour volume 7, 1196–1215 (2023).

这项研究提出了脑时空动力学的分析和计算方法,可以可靠地检测大规模神经记录中不同传播波模式,进行全面的模式分析和可视化,并对它们的时空模式进行深入研究。

Rory Townsend, Pulin Gong. Detection and analysis of spatiotemporal patterns in brain activity. PLoS Computational Biology, 14: e1006643 (2018).

这项研究揭示了在具有异质性和重尾连接性的神经网络中存在着扩展的临界相变区域。在这个区域内,神经网络的活动呈现出多分形 (multifractal) 的本质特性,这解释了各种神经动力学现象,如时间尺度的多样性,并为reservoir computing提供了计算优势。

Asem Wardak and Pulin Gong. Extended Anderson Criticality in Heavy-Tailed Neural Networks. Physical Review Letters, 129: 048103 (2022)

这个工作提出了一种神经计算机制,用于理解自发活动如何积极参与神经信息处理:Computing by Modulating Spontaneous Activity (CMSA), CMSA计算机制为单个神经元、神经网络层面和认知功能的多项实验结果提供了统一的解释。

Guozhang Chen & Pulin Gong. Computing by modulating spontaneous cortical activity patterns as a mechanism of active visual processing. Nature Communications. 10: 4915 (2019).

这项研究深入探讨了在深度学习中通过随机梯度下降(SGD)与损失函数地形 (landscape) 相互作用而实现有效学习的机制。我们发现,在SGD导航损失函数地形时,它呈现出丰富而复杂的动力学;初始阶段,SGD表现出超扩散,随着时间的推移逐渐减弱,并在接近解决方案时转变为亚扩散。这一结果以一种新的视角揭示了SGD在深度学习中的有效性,并对设计高效的深度神经网络 (deep neural networks) 具有重要意义。Guozhang Chen, Cheng Kevin Qu and Pulin Gong. Anomalous diffusion dynamics of learning in deep neural networks. Neural Networks, 149: 18-28 (2022).

4. 计算神经科学和AI的融合

张铁林:面向脑机接口的类脑脉冲神经网络软硬件

人工脉冲神经网络模型适合天然的生物脉冲信号处理,且其低能耗、灵活性、鲁棒性的本质特征,非常适合侵入式脑机接口的解码和调控任务。作为最终要嵌入到生物脑中的硬件实体,可以对多种如癫痫、阿尔兹海莫、自闭症等认知症的治疗有较大的临床促进。我将深耕这个领域,并与临港实验室、上海脑智卓越中心、自动化所等多个团队紧密合作,最终实现记录、处理、控制、临床等全流程测试。下面罗列一些与SNN相关的软件算法类工作。后续欢迎同学们联系我来组实习,共创SNN与脑机接口的未来。生物神经调制启发类脑连续学习算法并缓解灾难性遗忘

Zhang TL, Cheng X, Jia S, Li CT, Poo MM, Xu B. A brain-inspired algorithm that mitigates catastrophic forgetting of artificial and spiking neural networks with low computational cost. Science Advances. 2023;9(34)

生物介观尺度自组织反向传播助力脉冲和人工网络高效学习

Zhang TL*, Cheng X, Jia SC, Poo MM, Zeng Y, Xu B*. Self-backpropagation of synaptic modifications elevates the efficiency of spiking and artificial neural networks. Science Advances. 2021.

脑启发的奖赏传播帮助脉冲神经网络收敛学习

Zhang TL*, Jia SC, Cheng X, Xu B*. Tuning Convolutional Spiking Neural Network With Biologically Plausible Reward Propagation. IEEE Transactions on Neural Networks and Learning Systems (IEEE-TNNLS). 2021.

动力学知识嵌入强化学习帮助解决“部分可观马尔科夫决策问题”(POMDP)

Zhao XL, Zhang DZ, Han LY, Zhang TL*, Xu B. ODE-based Recurrent Model-free Reinforcement Learning for POMDPs. Thirty-seventh Conference on Neural Information Processing Systems (NeurIPS), 2023.

脉冲Transformer和神经动力学编码帮助高精度的语音识别

Wang QY, Zhang TL*, Han ML, Wang Y, Xu B. Complex dynamic neurons improved spiking transformer network for efficient automatic speech recognition. Thirty-Seventh AAAI Conference on Artificial Intelligence (AAAI), 2023.

多尺度动力学脉冲编码帮助脉冲强化学习模型取得超过人工模型的分数表现

Zhang DZ, Zhang TL*, Jia SC, Xu B*. Multiscale Dynamic Coding improved Spiking Actor Network for Reinforcement Learning. Thirty-Sixth AAAI Conference on Artificial Intelligence (AAAI), 2022.

基于脉冲神经网络的多尺度生物合理脑模拟

Wei QL, Han LY, Zhang TL*. Learning and Controlling Multi-scale Dynamics in Spiking Neural Networks using Recursive Least Square Modifications. IEEE Transactions on Cybernetics (IEEE-TCYB), 2023.

基于尖峰时序的神经计算处理时间信息的效率起源

Jiang, ZW, Xu JM, Zhang TL, Poo MM*, Xu B*. “Origin of the efficiency of spike timing-based neural computation for processing temporal information.” Neural Networks, 160 (2023): 84-96.

受生物学启发的尖峰神经网络的研究进展和新范式张铁林*, 李澄宇, 王刚, 张马路, 余磊, 徐波. 适合类脑脉冲神经网络的应用任务范式分析与展望.” 电子与信息学报 45.8 (2023): 2675-2688.

刘健:跨尺度大脑动力学的神经编解码AI计算模型

基于脑启发的视觉计算正在发挥重要功能,本文重点介绍了机器学习技术如何帮助开发对抗各种类型神经信号的模型,从精细尺度的神经尖峰和单细胞钙成像到粗尺度的脑电图(脑电图)和功能性磁共振成像记录大脑信号。

Zhang, Y., Yu, Z., Liu, J. K., Huang T., Neural Decoding of Visual Information Across Different Neural Recording Modalities and Approaches. Machine Intelligence Research. 19: 350-365 (2022) DOI: 10.1007/s11633-022-1335-2

贾杉杉, 余肇飞, 刘健, 黄铁军. 面向生物视觉的神经编码模型研究:进展与挑战[J]. 电子与信息学报, 2023, 45(8): 2689-2698. doi: 10.11999/JEIT221368提出STNMF模型,能够动态表征神经元回路的动态物理结构。

Jia S., Xing D., Yu Z., Liu, J. K., Dissecting cascade computational components in spiking neural networks, PLoS Comput Biol 17(11): e1009640 (2021) DOI: 10.1371/journal.pcbi.1009640

扩展了 STNMF 方法的范围。通过使用视网膜 GC 作为模型系统,STNMF 可以检测上游双极细胞(BC)的各种计算特性,包括空间感受野、时间滤波器和传递非线性。

Jia S, Yu Z, Onken A, Tian Y, Huang T, Liu J. K. Neural System Identification with Spike-triggered Non-negative Matrix Factorization. IEEE Transactions on Cybernetics 52(6): 4772-4783 (2022) DOI: 10.1109/TCYB.2020.3042513

采用了受图像分割技术启发的深度神经网络解码器从神经元反应中提取特征。

Zhang, Y., Bu, T., Zhang, Y., Tang, S., Yu, Z., Liu, J. K. Huang, T., Decoding Pixel-Level Image Features from Two-Photon Calcium Signals of Macaque Visual Cortex. Neural Computation 34 (6): 1369–1397 (2022) DOI: 10.1162/neco_a_01498

基于神经节细胞以非线性方式组合空间上的视觉信号的机理,提出一个考虑细胞感受野内的平均光强度及其随时间变化的模型,为模拟神经节细胞对自然图像的反应提供了一个易于获得的基准。

Liu, J. K., Karamanlis, D., Gollisch, T., Simple model for encoding natural images by retinal ganglion cells with nonlinear spatial integration. PLoS Comput Biol 18(3): e1009925 (2022) DOI: 10.1101/2021.08.29.458067

提出一种基于深度神经网络的新型解码框架尖峰图像解码器(SID)为人工视觉系统的神经形态计算提供了新的视角。

Zhang Y, Jia S, Zheng Y, Yu Z, Tian Y., Ma S., Huang T, Liu J.K. Reconstruction of Natural Visual Scenes from Neural Spikes with Deep Neural Networks. Neural Networks. 125:19-30 (2020) DOI: 10.1016/j.neunet.2020.01.033

介绍了尖峰触发的非负矩阵分解方法,用于检测神经元感受野内子单元的布局。该方法仅需要神经元在精细结构的感觉刺激下的尖峰反应,因此适用于同时记录的大量神经元。Liu, J. K., Schreyer, H.M., Onken, A., Rozenblit, F., Khani, M.H., Krishnamoorthy, V., Panzeri, S., and Gollisch, T. Inference of neuronal functional circuitry with spike-triggered non-negative matrix factorization, Nature Communications, 8(1):149 (2017). DOI:10.1038/s41467-017-00156-9

刘泉影:基于模型驱动及数据驱动的全脑网络建模

文章讨论基于 RNN 的动态系统重建的形式先决条件、不同的模型架构和训练方法、评估和验证模型性能的方法、如何在神经科学背景下解释训练模型以及当前的挑战。

Durstewitz, Daniel, Georgia Koppe, and Max Ingo Thurm. “Reconstructing computational system dynamics from neural data with recurrent neural networks.” Nature Reviews Neuroscience 24.11 (2023): 693-710.

文章在兴奋性和抑制性 RNN 单元中发现了网格状响应,这些响应在空间线索、视觉输入维度和激活函数方面都很稳健,群体反应揭示了低维、环面流形和吸引子。

Zhang, Xiaohan, et al. “Excitatory-inhibitory recurrent dynamics produce robust visual grids and stable attractors.” Cell reports 41.11 (2022).

文章使用深度合成图像构建的神经网络被证明可以重现动物神经反应的整体行为。

Bashivan, Pouya, Kohitij Kar, and James J. DiCarlo. “Neural population control via deep image synthesis.” Science 364.6439 (2019): eaav9436.

文章提出了一种用于癫痫实时闭环电神经调节的 Koopman-MPC 框架,为基于模型的闭环神经调节打开了一个新窗口,并揭示了非线性神经动力学和反馈控制策略。

Liang, Zhichao, et al. “Online Learning Koopman operator for closed-loop electrical neurostimulation in epilepsy.” IEEE Journal of Biomedical and Health Informatics 27.1 (2022): 492-503.

文章提出一种受生物学启发的架构空金字塔图卷积网络(STpGCN),捕获功能性大脑活动的时空图。

Ye, Ziyuan, et al. “Explainable fMRI‐based brain decoding via spatial temporal‐pyramid graph convolutional network.” Human Brain Mapping 44.7 (2023): 2921-2935.

建模的目的是为了找到合适的压缩方式,以最有效的方式表征信息。Ilya Sutskever: An observation on generalization

https://www.youtube.com/watch?v=AKMuA_TVz3A

关于集智俱乐部读书会和主办方

集智俱乐部读书会是面向广大科研工作者的系列论文研读活动,其目的是共同深入学习探讨某个科学议题,了解前沿进展,激发科研灵感,促进科研合作,降低科研门槛。

读书会活动始于 2008 年,至今已经有 50 余个主题,内容涵盖复杂系统、人工智能、脑与意识、生命科学、因果科学、高阶网络等。凝聚了众多优秀科研工作者,促进了科研合作发表论文,孵化了许多科研产品。如:2013 年的“深度学习”读书会孕育了彩云天气 APP,2015 年的“集体注意力流”读书会产生了众包书籍《走近2050》,2020年的开始因果科学读书会孕育了全国最大的因果科学社区等。

主办方:集智俱乐部

协办方:集智学园

集智俱乐部成立于 2003 年,是一个从事学术研究、享受科学乐趣的探索者的团体,也是国内最早的研究人工智能、复杂系统的科学社区。它倡导以平等开放的态度、科学实证的精神,进行跨学科的研究与交流,力图搭建一个中国的 “没有围墙的研究所”。

集智学园成立于2016年,是集智俱乐部孕育的创业团队。集智学园致力于传播复杂性科学、人工智能等前沿知识和新兴技术,促进、推动复杂科学领域的知识探索与生态构建。

神经、认知、智能社区

理解大脑的工作机制,能够促进人工智能的发展,人工智能也为大脑的研究提供新的以数据和模型为基础的范式。「神经、认知、智能」共创社区主要从跨学科与复杂科学的视角,探讨大脑编解码的机制与计算模型,以及视觉、语言、学习、运动、决策、记忆、情绪、社会交互等高级认知功能的组织。目前社区已经组织策划了「神经动力学模型」和「NeuroAI」读书会,此次「计算神经科学」读书会是系列读书会的第三季。

计算神经科学读书会

神经动力学模型读书会

NeuroAI读书会

点击“阅读原文”,报名读书会

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง