点击下方卡片,关注「AI视界引擎」公众号

自监督表示学习框架最近在遥感和传感器社区中引起了兴趣,因为它们有可能减轻制作大型卫星图像数据集的高昂标签成本。在多模态数据融合领域,虽然经常使用的对比学习方法可以帮助弥合不同传感器类型之间的域间隙,但它们依赖于需要专业知识和仔细设计的数据增强技术,尤其是对于多光谱遥感和数据。一种可能的但很少研究的绕过这些限制的方法是使用基于Mask图像建模的预训练策略。

在本文中介绍了一种基于Mask自编码器的自监督学习框架Fus-MAE,它使用交叉注意力在合成孔径雷达和多光谱光学数据之间进行早期和特征 Level 的数据融合,这两种模态具有显著的域差异。

实证结果表明,Fus-MAE可以有效地与针对SAR-光学数据融合的自定义对比学习策略相竞争,并在更大的语料库上训练的其它Mask自编码器框架之上表现出色。

1 Introduction

近年来,多模态学习越来越受到关注,因为有许多模态,如RGB-Depth或文本图像。值得注意的是,最近的研究已经为深度多模态学习相对于单模态的性能优势提供了理论依据。在遥感领域的数据融合领域,有两种模态被广泛研究:合成孔径雷达(SAR)和光学影像。确实,这些模态本质上是互补的:SAR数据具有全天候和穿透云的能力,但存在斑点噪声,使得其解释具有挑战性。另一方面,光学数据虽然受到天气和季节性约束,但具有自然感(例如RGB)和较少的噪声图像,有利于解释。因此,它们的结合对于土地覆盖分类等任务是相关的,并为云去除和SAR去斑等应用打开了大门。

自监督学习(SSL)在各个机器学习领域引起了广泛关注,如自然语言处理(NLP)和计算机视觉。其中一种关键特征是它能够在不需要 Token 数据的情况下学习强大的表示,这在遥感领域尤其有趣,因为数据标注可能代价高昂,通常需要特定领域的专业知识。

近年来,大规模的公共SAR-光学数据集(如SeCo,BigEarthNet-MM,SEN12MS和,最近,SSL4EO-12)的出现,推动了SAR-光学融合的SSL方法的研究。然而,现有的大多数研究倾向于对比学习,虽然有效,但存在一些局限性。这些包括依赖于数据增强,需要仔细设计以适应遥感图像(RSI)的特定性,以及需要负样本,这需要较大的批量大小。

近年来,在Mask图像建模(MIM)方面取得了某些视觉表示学习任务的新状态。尽管MIM避免了对比学习的上述缺陷,但据作者所知,使用MIM进行遥感图像(RSI)数据融合的文献仍然相对较少。在本文中,作者探索了这种替代的预训练方法,用于自监督学习数据融合,贡献可以总结如下:

-

提出了FusMAE,这是一种基于自监督和MAE的框架,能够实现早期级和特征级的数据融合。

-

通过实证方式证明了基于交叉注意力的早期融合策略是最适合预训练SAR-光学数据进行土地覆盖分类任务的策略。

-

展示了FusMAE模型可以在某些最先进的对比学习方法上与针对RSI数据融合的最近方法相竞争。

2 Related Works

在遥感领域中的自监督学习– 根据文献,自监督学习方法可以分为三类:

- 生成方法,其中预任务是在像素级重构被破坏的信号(例如降采样或Mask);

- 预测方法,其中目标是通过预任务(例如预测图像中两个块的相对位置或灰度到RGB着色)学习语义上下文特征;

- 对比学习方法,该方法传统上旨在创建一个嵌入空间,其中相同实例的视图被拉近(正视图),而不相关的视图被拉远(负视图)。

对于SAR-光学数据融合,大部分研究努力都倾向于后者:Chen和Bruzzone研究了SAR和光学图像的早期、中期和晚期融合,通过联合训练两个ResUnets和一个多视对比损失。Montanaro等人使用了SimCLR框架将不同模态的嵌入拉近。Wang等人适应了基于知识蒸馏的DINO框架,该框架不需要负样本,从而省去了需要大型批处理的需求。尽管这些对比方法都相当成功,但它们需要精心设计数据增强 Pipeline 来创建正视图,其质量很难评估。为了绕过这个挑战,作者选择专注于不需要数据增强的生成方法:Mask图像建模。

在遥感领域中的Mask图像建模- He等人[9]最近提出了一种去噪自动编码器(DAE)架构的变体,其中输入图像块以高 Mask 比例随机 Mask ,只留下少量输入块输入到Transformer编码器中。然后,浅层解码器使用获得的潜在和 Mask Token 来重建图像。被称为 Mask 自动编码器(MAE)的框架在ImageNet-1K上设置了新的最先进状态,同时由于处理输入 Token 数量较少和轻量级解码器,训练时间大大缩短。Cong等人将该架构适应光学数据,通过添加多域编码(例如位置+时间或位置+光谱)。Sun等人在2M光学图像数据集上训练了一个基于MAE的模型,并声称在各种RS数据集上实现了最先进性能。Allen等人跟进了一项与SAR图像类似的工作。

然而,尽管在自然领域对Mask图像建模的数据融合方面进行了许多 recent advancements,但SAR-光学方面的文献较少,有些尝试通过在通道轴上堆叠SAR和光学数据来训练MAE,以及一些关于专业 Mask 策略的研究。在本文中提出了一些架构变化来研究早期、中期和晚期融合策略,为未来研究铺平道路。

3 Methodology

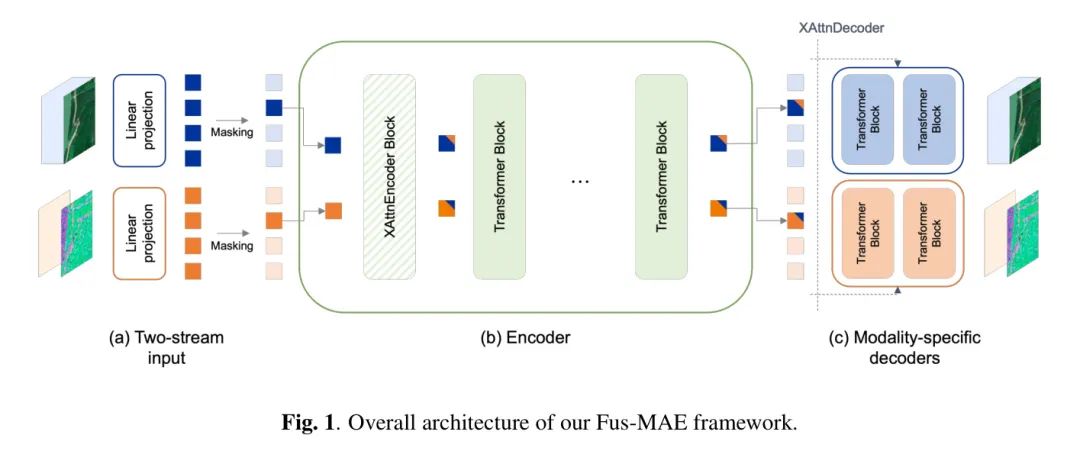

作者的工作受到了MultiMAE的启发,MultiMAE是一种基于Mask自动编码器的架构,在自然图像上具有已被证明的记录,其混合流式架构可以接受不同的模态作为输入。在本节中通过在第3.1节中提出需要多任务编码器在第3.2节中提出需要多任务解码器来描述Fus-MAE架构。考虑了两种 Mask 策略,其中详细内容在3.3节中提供。整体架构如图1所示。

Multi-modal encoder

就像MAE一样,编码器是一个ViT,并接受线性嵌入的块表示作为输入 Token 。令和分别是SAR和光学卫星图像的相应张量表示。一个直观的融合策略是将SAR和光学RSI数据沿通道维数堆叠,并从获得的张量中创建块。由于这种早期的 ConCat 技术将整个融合过程聚焦在单个块投影层上,作者假设它对于在SAR和光学数据之间存在显著域间隙的情况下有效地描述跨模态交互并不足够表达。

为了解决这个具有挑战性的早期融合任务,FusMAE用一个”交叉注意力块投影”模块替换了第一个编码器块,将更细粒度的多模态信息编码到输入 Token 中。代码和模型权重将在GitHub上公开提供。

交叉注意力块投影 – 首先,使用模态特定的块投影层创建单模态 Token 。具体而言,对于每个模态,应用大小为的2D卷积层,核大小为,步长为,然后添加位置嵌入,得到一组个 Token :

然后,为了执行早期融合操作,引入了一个块,称为XAttnEncoder(用于交叉注意力编码器),其定义如下:

其中表示 ConCat 操作,MLP是一个两层前馈网络,使用GELU非线性,CA是一个定义为:的交叉注意力层。

作者得到的最终输入 Token 是通过将单模态 Token 输入到这个XAttnEncoder块,并附加一个全局 Token ,该 Token 具有学习的嵌入:

将第一个编码器块替换为这个XAttnEncoder块的主要思想是,由于两个模态之间存在较大的域间隙,将两个单模态 Token 输入到编码器块的自注意力层中,会导致类似于块对角矩阵的注意力图,缺乏跨模态理解。另一方面,XAttnEncoder块促使网络尽早地建模跨模态交互,生成具有单模态偏差和相关跨模态信息的 Token。

模态偏差潜在值 – 令表示ViT编码器的深度。在XAttnEncoder块的情况下,编码器将由一个XAttnEncoder块后接N-1个Transformer编码器块组成。作者将单模态 Token 输入到编码器中,以获得一组模态偏差的潜在值,它可以分解为:

Multi-task decoder

为了在特征 Level 进行数据融合,Fus-MAE提出为每个模态设置一个编码器。遵循MAE的方法,使用轻量级解码器,因此增加解码器不会显著增加模型的整体计算复杂性。将模态偏差的潜在值输入到各自的解码器,以获得原始RSI数据的重建。

然后,只计算重构 Token 的均方误差损失,并反向传播整个架构的梯度。

为了进一步坚持特征 Level 的跨模态信息融合,遵循MultiMAE的方法,引入了一个XAttnDecoder块,该块在将模态偏差的潜在值输入到之前,将它们与模态相关的潜在值进行交叉注意力:

Masking strategies

作者提出研究两种 Mask 策略:独立 Mask 和一致 Mask 。遵循MAE的方法,应用了75%的 Mask 比例,并在各个模态上均匀地采样作者的块。

独立 Mask – 在RS领域中的MiM文献中,跨模态的独立 Mask 被广泛采用,因为它可以捕获模态之间的内相关性和跨相关性。遵循这种策略,作者在各个模态上以均匀的方式随机采样作者的 Mask 块。

一致 Mask – 作者还研究了一种一致 Mask 策略,其中跨模态的 Mask 块相同。作者的假设是,由于SAR和光学数据的域间隙,捕获跨模态相关性比捕获模态内相关性更容易。通过确保作者向各个模态提供表示相同块的 Token ,作者可以减少注意力层捕获跨模态信息时的困难。

4 Experiments and Results

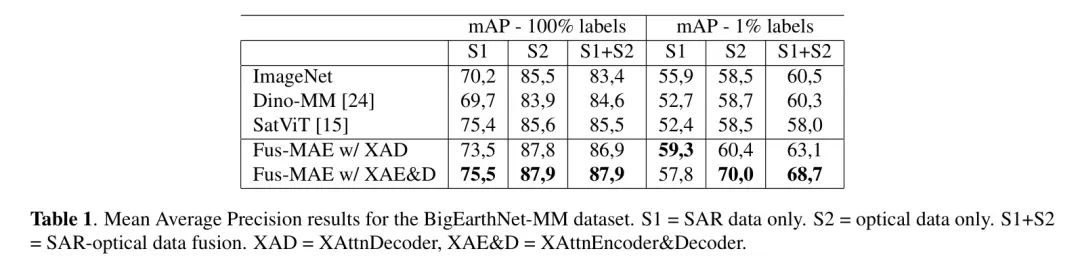

为了研究两种不同的融合策略,作者预训练了两个Fus-MAE实例:仅执行特征级融合的Fus-MAE w/ XAD,以及同时执行早期和特征级融合的Fus-MAE w/ XAE&D。在BigEarthNet训练分割的354,196张图像上训练Fus-MAE,使用AdamW优化器,批处理大小为200,共100个Epoch。在前10个Epoch中,学习率逐步升温到,然后使用余弦计划进行衰减。

作者在2台NVIDIA RTX 3090Ti上训练Fus-MAE,大约需要60小时。将ImageNet初始化作为 Baseline ,并使用两个专门为SAR-光学数据融合设计的基于Transformer的预训练模型来完成作者的基准测试:分别代表最近对比学习研究的DINO-MM和SATVIT,以及分别代表Mask图像建模的近期研究。

多标签分类 – 为了评估预训练策略的有效性,在预训练的编码器顶部附加一个线性分类头。在10个Epoch中微调模型,使用PyTorch的MultiLabelSoftMargin Loss和AdamW优化器,并报告测试分割上的平均平均精度(mAP)得分。

表1总结了这些微调实验的结果,其中分类器在单模态数据(S1或S2)或多模态数据(S1+S2)上进行训练。值得注意的是,与其它架构相比,Fus-MAE展示了优越的性能,对于S2和S1+S2,mAP提高了大约2个百分点,而Fus-MAE w/XAE&D略有优势。

然而,值得注意的是,在所有架构中,使用仅SAR数据(S1)的mAP显著低于使用S2或S1+S2时的情况,这表明所有模型在S1+S2场景中主要依赖光学数据进行预测。

此外,为了评估在标签和资源稀缺条件下学习的表示的质量,在训练标签的1%上进行线性评估。在这种情况下,线性块投影和编码器权重被冻结,只允许学习线性分类器的权重。在AdamW优化器的支持下训练这个分类器20个Epoch,批量大小为128。结果也在表1中报告,与其它SSL架构相比,性能提高更大,突显了Fus-MAE学习的表示的质量。

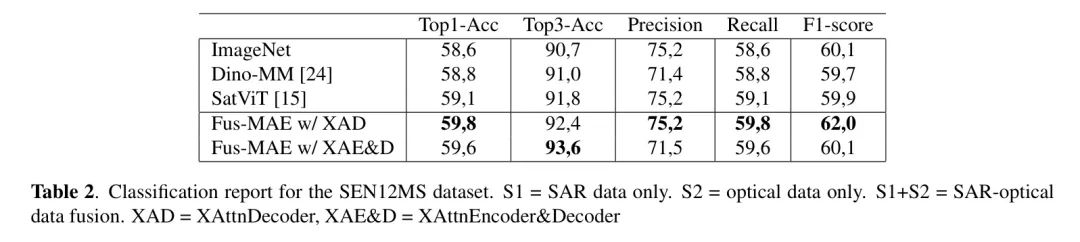

迁移学习 – 为了研究泛化能力,作者在另一个下游任务上进行线性评估:在SEN12MS数据集上进行单模态土地覆盖分类。由于这个数据集的不平衡性质,使用加权平均方法计算精确度、召回率和F1-score。在AdamW优化器的支持下训练这个分类器10个Epoch,批量大小为256,使用Timm的LabelSmoothingCrossEntropy损失。与之前实验类似的实验设置下的基准测试结果报告在表2中。Fus-MAE在所有跟踪指标上均优于其他技术,尽管优势较小。

5 Conclusion

在本文中提出了Fus-MAE,这是一个新颖的用于SAR-光学数据融合的自监督学习框架。基于MAE架构,它使用在不同阶段两个数据流之间的交叉注意力来执行早期和特征级数据融合。

Fus-MAE在各种下游任务上超过了最近对比学习和基于MIM的工作,证明了使用交叉注意力描述具有较大域间隙的模态之间跨模态交互的有效性。可以进一步研究将作者的交叉注意力层扩展到超过2个模态,并使Fus-MAE在各个模态上的预测依赖更加均衡。

参考

[1]. FUS-MAE: A CROSS-ATTENTION-BASED DATA FUSION APPROACH FOR MASKED AUTOENCODERS IN REMOTE SENSING

点击上方卡片,关注「AI视界引擎」公众号

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง