导语

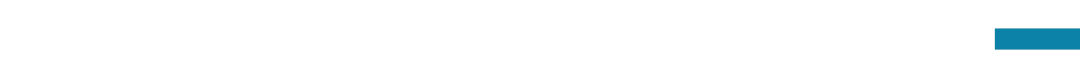

大模型安全与对齐读书会的第一期,我们邀请到了非盈利研究机构FAR AI的联合创始人Adam Gleave分享《AGI安全:风险与研究方向》。Adam毕业于UC Berkeley的AI博士项目,导师是人类兼容人工智能中心(Center for Human-Compatible AI)的主任Stuart Russell。

集智俱乐部和安远AI联合举办“大模型安全与对齐”读书会,由多位海内外一线研究者联合发起,针对大模型安全与对齐所涉及的核心技术、理论架构、解决路径以及安全治理等交叉课题,展开共读共研活动。读书会自2024年1月27日正式开始,每周六上午举行,为期8-10周。欢迎从事相关研究与应用工作的朋友报名加入!

分享内容简介

2023年3月,OpenAI发布GPT-4,点燃了通用大模型和通用人工智能 (AGI) 的研发热情。两个月之后,数百位国际AI界重量级科学家和领袖共同签署《AI风险声明》(Statement of AI Risk),呼吁“防范人工智能带来的生存风险应该与流行病和核战争等其他大规模风险一样,成为全球优先议题”。

大模型安全与对齐读书会的第一期,我们邀请到了非盈利研究机构FAR AI的联合创始人Adam Gleave分享《AGI安全:风险与研究方向》。Adam毕业于UC Berkeley的AI博士项目,导师是人类兼容人工智能中心(Center for Human-Compatible AI)的主任Stuart Russell。他将带来关于《AGI安全:风险与研究方向》的演讲,介绍AGI安全的历史沿革,并强调AGI可能带来的两种大规模风险:滥用风险(恶意或鲁莽使用AI造成伤害)与失控AI(AI自主追求未对齐的目标),最后他将介绍AGI安全和对齐的四个具体研究方向:监督(Oversight)、鲁棒性(Robustness)、可解释性(Interpretability)和AI治理(Governance)。

分享内容大纲

-

背景:回顾AGI风险和安全的历史沿革

-

风险研判:AGI的滥用风险(Misuse)和失控风险(Rogue AI)

-

大模型的谄媚行为(Sharma et al., 2023)

-

工具趋同的理论结果(Turner et al., 2023)

-

滥用风险:恶意或鲁莽使用AI造成伤害。

-

失控风险:AI自主追求未对齐的目标。

AGI安全研究领域:

(1) 监督(Oversight):明确系统应如何行动以满足设计者设定的目标。

-

意图对齐(Intent Alignment)(Christiano, 2018)

-

价值理解(Value Comprehension)

-

辅助博弈(Assitance Games)(Hadfield-Menell et al., 2016)

(2) 鲁棒性(Robustness):确保系统在一系列设置中能够可靠地满足设计规范。

-

对抗策略击败顶级围棋AI(Wang et al., 2023)

(3) 可解释性(Interpretability):使用人类可理解的方法探究系统的能力和局限性。

-

使用LLM去解释神经网络 (Bills et al,2023)

- 自动化发现神经网络通路 (circuit, Conmy et al, 2023)

(4) 治理(Governance):协调系统训练和部署的安全标准。

- 未来展望:AI竞争发展会忽略安全的发展,社会各界应重视AI安全。

分享形式和议程

-

主题分享:Adam Gleave《AGI Safety: Risks and Research Directions》

-

圆桌讨论 :

-

当前大模型安全和对齐方法有何局限?

-

大模型对齐技术如何迁移到超级对齐?

-

缺乏算力的情况下如何贡献这个领域?

- 出席嘉宾:Adam Gleave,苏炜杰(宾夕法尼亚大学助理教授)、刘鹏飞(上海交通大学副教授)、杨耀东(北京大学)等

主要涉及到的前置知识

-

对齐 (Alignment)

-

通用人工智能 (Artificial General Intelligence,AGI)

-

线路 (circuit,Towards Automated Circuit Discovery for Mechanistic Interpretability)

-

对抗鲁棒性(adversarial robustness)

- AI对齐

主讲人介绍

Adam Gleave 是非盈利研究机构 FAR AI 的联合创始人和 CEO,FAR AI团队主要关注的研究方向有:对抗鲁棒性、价值对齐和大模型评测等。Adam Gleave 在 UC Berkeley的人类兼容人工智能中心(Center for Human-Compatible AI)完成 AI 博士学位,他的导师是著名的 AI 研究者斯图尔特·罗素(Stuart Russell)。Adam曾在 Google DeepMind 与 Jan Leike 和 Geoffrey Irving 合作进行AI对齐方面的研究,并曾在剑桥大学与 Zoubin Ghahramani 和 Christian Steinruecken 合作。研究兴趣:大模型价值对齐、模型评测、对抗鲁棒性和AGI安全领域建设

Adam Gleave 是非盈利研究机构 FAR AI 的联合创始人和 CEO,FAR AI团队主要关注的研究方向有:对抗鲁棒性、价值对齐和大模型评测等。Adam Gleave 在 UC Berkeley的人类兼容人工智能中心(Center for Human-Compatible AI)完成 AI 博士学位,他的导师是著名的 AI 研究者斯图尔特·罗素(Stuart Russell)。Adam曾在 Google DeepMind 与 Jan Leike 和 Geoffrey Irving 合作进行AI对齐方面的研究,并曾在剑桥大学与 Zoubin Ghahramani 和 Christian Steinruecken 合作。研究兴趣:大模型价值对齐、模型评测、对抗鲁棒性和AGI安全领域建设

圆桌嘉宾介绍

杨耀东,现为北京大学人工智能研究院助理教授(博导)、博雅青年学者。国家高层次留学人才计划、国家高层次青年人才项目、中国科协青年托举计划获得者。他本科毕业于中国科学技术大学,并在伦敦帝国理工大学获得硕士、伦敦大学学院获得博士学位(博士论文获学校唯一提名ACM SIGAI 优博奖)。回国前于伦敦国王大学信息学院任助理教授。发表AI顶会论文100余篇,谷歌引用3500余次,累计主持经费超2500万元。研究兴趣:通用智能体构建、博弈交互与对齐问题。

杨耀东,现为北京大学人工智能研究院助理教授(博导)、博雅青年学者。国家高层次留学人才计划、国家高层次青年人才项目、中国科协青年托举计划获得者。他本科毕业于中国科学技术大学,并在伦敦帝国理工大学获得硕士、伦敦大学学院获得博士学位(博士论文获学校唯一提名ACM SIGAI 优博奖)。回国前于伦敦国王大学信息学院任助理教授。发表AI顶会论文100余篇,谷歌引用3500余次,累计主持经费超2500万元。研究兴趣:通用智能体构建、博弈交互与对齐问题。 苏炜杰,现为宾夕法尼亚大学沃顿商学院统计与数据科学系和工学院计算机系助理教授,及Facebook访问科学家。同时还兼任宾大机器学习研究中心联合主任,以及任职于应用数学和计算数学项目执行委员会。此外还供职于宾大沃顿智能商务中心,Warren网络数据科学中心,和北京智源人工智能研究院青源会。苏炜杰为首届2022年数据科学青年奖得主,曾在2019年和2020年分别获得NSF CAREER Award和斯隆研究奖。研究兴趣:超级对齐、可扩展监督、AI安全和对齐等研究方向。

苏炜杰,现为宾夕法尼亚大学沃顿商学院统计与数据科学系和工学院计算机系助理教授,及Facebook访问科学家。同时还兼任宾大机器学习研究中心联合主任,以及任职于应用数学和计算数学项目执行委员会。此外还供职于宾大沃顿智能商务中心,Warren网络数据科学中心,和北京智源人工智能研究院青源会。苏炜杰为首届2022年数据科学青年奖得主,曾在2019年和2020年分别获得NSF CAREER Award和斯隆研究奖。研究兴趣:超级对齐、可扩展监督、AI安全和对齐等研究方向。 刘鹏飞,上海交通大学长聘教轨副教授,博士生导师。生成式人工智能研究组负责人,国家高层次人才计划青年项目,上海市领军人才 (海外青年);在自然语言处理和人工智能领域发表学术论文 70 余篇。谷歌学术引用 9900余次。ACL会议史上首次实现连续两年获得System & Demo Paper Award;提示工程(Prompt Engineering)概念最早提出者之一。代表作包括:高数学推理大模型“阿贝尔”、Auto-J,LIMA等。研究方向:专注于大模型的训练和价值对齐。

刘鹏飞,上海交通大学长聘教轨副教授,博士生导师。生成式人工智能研究组负责人,国家高层次人才计划青年项目,上海市领军人才 (海外青年);在自然语言处理和人工智能领域发表学术论文 70 余篇。谷歌学术引用 9900余次。ACL会议史上首次实现连续两年获得System & Demo Paper Award;提示工程(Prompt Engineering)概念最早提出者之一。代表作包括:高数学推理大模型“阿贝尔”、Auto-J,LIMA等。研究方向:专注于大模型的训练和价值对齐。

主要涉及到的参考文献

-

SHARKEY L, GHUIDHIR C N, BRAUN D, et al. A Causal Framework for AI Regulation and Auditing[C/OL]. https://api.semanticscholar.org/CorpusID:265309979.

-

Sharma M, Tong M, Korbak T, et al. Towards understanding sycophancy in language models[J]. arXiv preprint arXiv:2310.13548, 2023.

-

Turner A M, Smith L, Shah R, et al. Optimal policies tend to seek power[J]. arXiv preprint arXiv:1912.01683, 2019.

-

Hadfield-Menell D, Russell S J, Abbeel P, et al. Cooperative inverse reinforcement learning[J]. Advances in neural information processing systems, 2016, 29.

-

Wang T T, Gleave A, Tseng T, et al. Adversarial policies beat superhuman go AIs[C]//International Conference on Machine Learning. PMLR, 2023: 35655-35739.

- Bills S, Cammarata N, Mossing D, et al. Language models can explain neurons in language models[J]. URL https://openaipublic. blob. core. windows. net/neuron-explainer/paper/index. html.(Date accessed: 14.05. 2023), 2023.

- Conmy A, Mavor-Parker A N, Lynch A, et al. Towards automated circuit discovery for mechanistic interpretability[J]. arXiv preprint arXiv:2304.14997, 2023.

- IDAIS: https://humancompatible.ai/news/2023/10/31/prominent-ai-scientists-from-china-and-the-west-propose-joint-strategy-to-mitigate-risks-from-ai/

直播信息

时间:2024年1月27日(本周六)早上10:00-12:00

参与方式:

扫码参与大模型安全与对齐读书会,加入群聊,获取系列读书会回看权限,成为社区的种子用户,与社区的一线科研工作者与企业实践者沟通交流,共同推动图神经网络社区的发展。

大模型安全与对齐读书会

大模型的狂飙突进唤醒了人们对AI技术的热情和憧憬,也引发了对AI技术本身存在的社会伦理风险及其对人类生存构成的潜在威胁的普遍担忧。在此背景下,AI安全与对齐得到广泛关注,这是一个致力于让AI造福人类,避免AI模型失控或被滥用而导致灾难性后果的研究方向。集智俱乐部和安远AI联合举办「大模型安全与对齐」读书会,由多位海内外一线研究者联合发起,旨在深入探讨大模型安全与对齐所涉及的核心技术、理论架构、解决路径以及安全治理等交叉课题。

详情请见:2024开年读书会:AI安全与对齐——应对前沿AI失控与滥用的技术路线

此次活动鸣谢安远AI、达摩院。

安远AI是一家位于北京、专注于AI安全与治理的社会企业。我们的使命是引领人机关系走向安全、可信、可靠的未来。我们面向大模型和通用人工智能安全和对齐问题,进行风险研判、建立技术社区、开展治理研究、提供战略咨询以及推动国际交流。

达摩院是一家致力于探索科技未知,以人类愿景为驱动力的,立足于基础科学、创新性技术和应用技术的研究院。希望打通应用基础研究和产业应用,探索技术产品化、产品市场化的转换路径。

点击“阅读原文”,报名读书会

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง