此前引起大量关注的 AI 生成 3D 工具 Meshy 迎来了大更新,Meshy 的联合创始人兼 CEO 胡渊鸣发文解读了产品更新,并分享了他对 3D AIGC 发展方向的思考。

本文作者胡渊鸣,Meshy 联合创始人兼 CEO,计算机图形学知名学者,毕业于清华大学姚班,MIT 博士,也是「太极」(TaiChi)编程语言作者。

原文标题:《AI 生成 3D 模型发展到哪了?Meshy-2 带来哪些新功能?》

Meshy-1 的推出快三个月了。今天我们很开心地向大家介绍 Meshy 的新版本,Meshy-2。这是我们在 3D AIGC 文字生成 3D(Text to 3D)方面的最新进展。

邀请大家看一看 Meshy-2 宣传片

*本文中的 3D 资产,除非特别标明,均为 Meshy-2 生成。

01

Meshy-2 Text to 3D

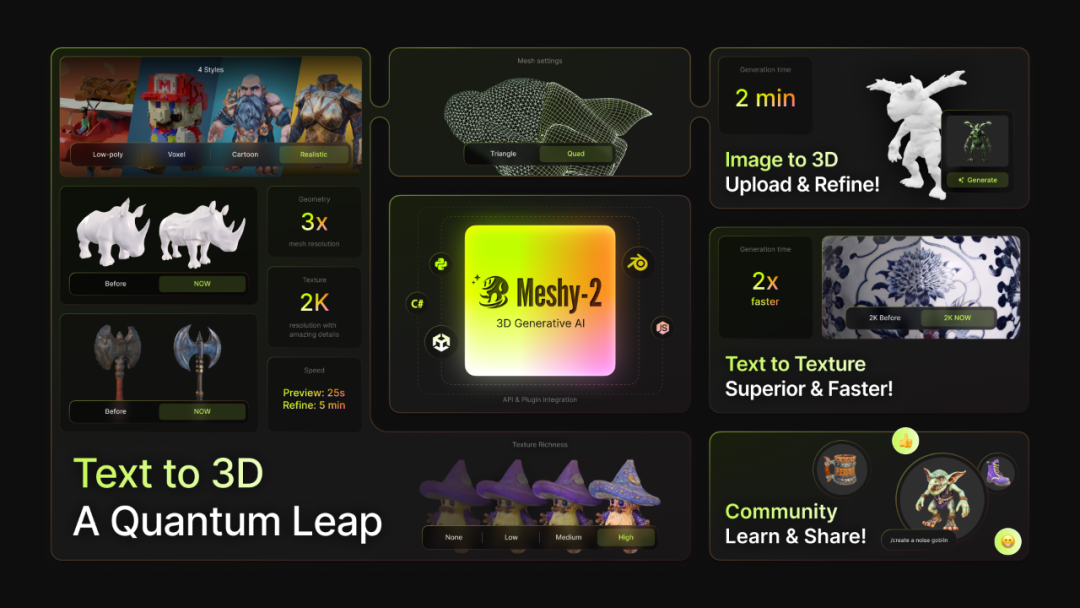

更好的几何、贴图、风格控制

Meshy-2 最主要的更新在于 Text to 3D,也就是从提示词直接生成 3D 模型。Meshy-2 的 Text to 3D 功能带来了在造型设计感、模型细节、贴图质量和风格方面控制的显著改进。相比 Meshy-1,Meshy-2 的模型比例更加自然、模型结构更精准,细节更丰富、清晰。提示词:prehistoric winter boots with wool, realistic, 4K, high quality 提示词:royal armor set, gold, iron, highly detailed, medieval, knight armor, leatherMeshy-2 在文本到 3D 中提供了四种风格的选择:写实、卡通、低多边形和体素。我们希望这些选项能满足用户广泛的艺术风格偏好,并激发新的创意方向。

提示词:royal armor set, gold, iron, highly detailed, medieval, knight armor, leatherMeshy-2 在文本到 3D 中提供了四种风格的选择:写实、卡通、低多边形和体素。我们希望这些选项能满足用户广泛的艺术风格偏好,并激发新的创意方向。 从左至右的风格分别是:低多边形、写实、体素、卡通效率至关重要,我们设法在不影响质量的情况下提高了速度。Meshy-2 现在仅需 20 多秒就可获得预览,从输入提示词到细化结果,在 5 分钟内可端到端完成。(*运行时间为服务器低负载时测量,高峰期可能会有排队、减速。)我们在 Meshy-2 中引入了一个方便的网格转换系统,可以让用户一键实现减面、转四边面等常见操作。这可以一定程度上解决网格面数、AI 生成的模型拓扑不好(布线乱)的问题。关于我们的用户比较期待的自动展 UV 方面的优化,这次没有更新。坦率地说,考虑到目前 AI 还不能按部件清晰地生成各种模块,更好的 UV 暂时在 AI 生成 3D 的管线中的价值还不太大。但是我们已经开始思考这个问题。Meshy-2 重点更新的内容就是上面这些了,主要是 Text to 3D。另外,不少用户已经融入到工作流程中的 Meshy Text to Texture 功能,我们也有小更新:速度更快、并且贴图细节丰富程度在同样的分辨率下更加清楚了。Image to 3D 不是我们最近开发的重点,但是也有个小更新,优化了一些几何造型能力。

从左至右的风格分别是:低多边形、写实、体素、卡通效率至关重要,我们设法在不影响质量的情况下提高了速度。Meshy-2 现在仅需 20 多秒就可获得预览,从输入提示词到细化结果,在 5 分钟内可端到端完成。(*运行时间为服务器低负载时测量,高峰期可能会有排队、减速。)我们在 Meshy-2 中引入了一个方便的网格转换系统,可以让用户一键实现减面、转四边面等常见操作。这可以一定程度上解决网格面数、AI 生成的模型拓扑不好(布线乱)的问题。关于我们的用户比较期待的自动展 UV 方面的优化,这次没有更新。坦率地说,考虑到目前 AI 还不能按部件清晰地生成各种模块,更好的 UV 暂时在 AI 生成 3D 的管线中的价值还不太大。但是我们已经开始思考这个问题。Meshy-2 重点更新的内容就是上面这些了,主要是 Text to 3D。另外,不少用户已经融入到工作流程中的 Meshy Text to Texture 功能,我们也有小更新:速度更快、并且贴图细节丰富程度在同样的分辨率下更加清楚了。Image to 3D 不是我们最近开发的重点,但是也有个小更新,优化了一些几何造型能力。 随着我们将重点从 Discord 转移到 Web App,Discord 社区将不再提供生成服务,转变为一个分享想法和经验的平台。这让我们能够更好地将有限的研发资源聚焦到 Web App 上,提供更完善的功能。欢迎加入我们的 Discord 和 WebApp 社区展示,探索和分享 AI 生成的 3D 艺术。

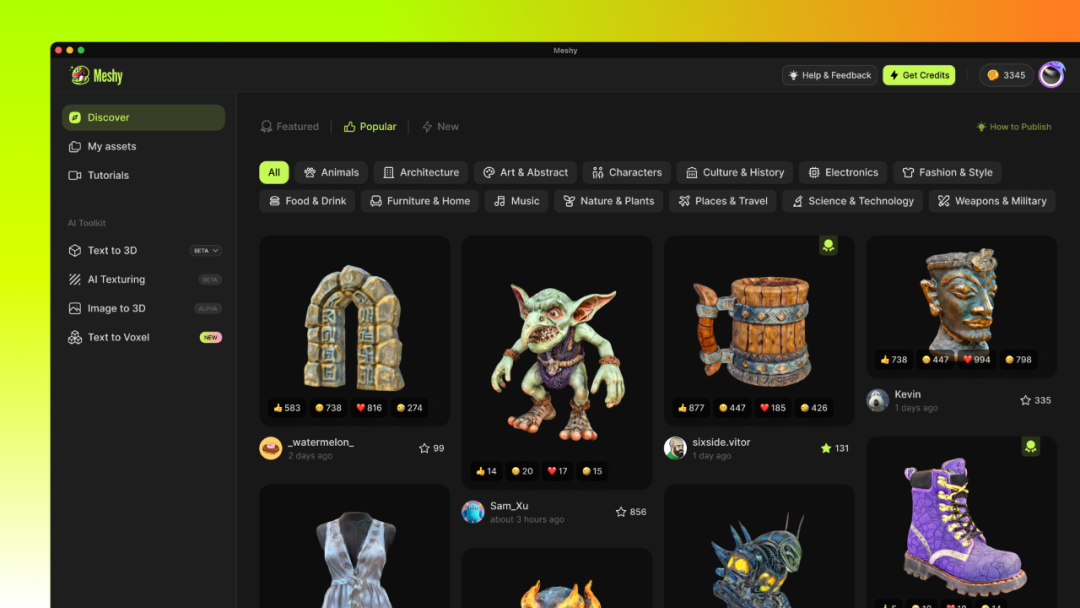

随着我们将重点从 Discord 转移到 Web App,Discord 社区将不再提供生成服务,转变为一个分享想法和经验的平台。这让我们能够更好地将有限的研发资源聚焦到 Web App 上,提供更完善的功能。欢迎加入我们的 Discord 和 WebApp 社区展示,探索和分享 AI 生成的 3D 艺术。 Meshy Web App 社区作品展示

Meshy Web App 社区作品展示 Meshy-2 功能更新汇总*Meshy-2 支持中文提示词和中文界面。如果你的系统语言是中文,Meshy-2 会自动显示中文页面。你也可以在左下角的 Settings -> Preference -> Language 中选择 “简体中文”。在提示词框中输入中文提示词会自动翻译。

Meshy-2 功能更新汇总*Meshy-2 支持中文提示词和中文界面。如果你的系统语言是中文,Meshy-2 会自动显示中文页面。你也可以在左下角的 Settings -> Preference -> Language 中选择 “简体中文”。在提示词框中输入中文提示词会自动翻译。

02

Meshy-2 有哪些不足?

在质量方面,Meshy-2 的 Text to 3D 是领先的:整体模型精度高、贴图细节和质量丰富、支持多种风格的模型生成、内容理解能力强。速度方面我们也很有优势:从发送提示词开始,我们的用户可以在 4~5 分钟内获得最终的模型,大大加速了创作过程。我想,Meshy-2 已经走在 3D AI 行业最前列了,但是整个 3D AI 行业还是有很多问题没有解决,比如:

-

可控性依然不足。可控性不足一方面来自于 AI 对于 prompt 的理解不到位,另一方面来自于用户不知道咋写提示词。

-

部分模型写实感不足。

-

贴图需要去光。如果要得到引擎内动态光影下可用的模型,需要对贴图进行进一步的处理。

-

贴图正确性。我们对于 Meshy-2 的贴图细节丰富程度很有信心,但 AI 的自由发挥也导致了一些地方会出错。

-

硬表面模型的棱角不够锐利。

-

拓扑、UV 与人类作品质量有较大差距。

- ……

Meshy 团队任重道远。但是无论如何。Meshy-2 的 Text to 3D 把 AI 生成 3D 这个事情又往前推进了一步,我们还是为这次更新取得的进展感到开心的。

03

Meshy-2 有什么用?

首先要明确,目前 AI 生成的 3D 资产质量,即使是最新的 Meshy-2,距离人类艺术家的最高标准,还有相当远的距离,所有尝试用 AI 解决 3D 资产生成的科研工作者和产品经理都应该对这个事情保持敬畏。我们希望能够客观、谨慎地看待这项技术。 示意图:真正高质量的 3D 模型应该是什么样的。(这是全文唯一一个不是 Meshy-2 生成的 3D 模型。)AI 生成 3D 很难,这是众所周知的,但是我们还是会不懈地朝这个方向努力。我想至少两点观察可以带给我们信心:

示意图:真正高质量的 3D 模型应该是什么样的。(这是全文唯一一个不是 Meshy-2 生成的 3D 模型。)AI 生成 3D 很难,这是众所周知的,但是我们还是会不懈地朝这个方向努力。我想至少两点观察可以带给我们信心:

- 一是总是能找到细分场景。3D 资产在各种使用场景下的质量要求,从最低到最高,本身是一个丰富的频谱。即使现在没法生成最高质量的模型,也总能找到要求不那么高的细分场景作为切入点,先把产品小范围落地,然后逐渐跨越质量和可控性的鸿沟。

- 二是技术发展很快。我自己作为在图形行业摸爬滚打了十余年的研究人员,不得不承认 AI 生成 3D 相关的进展在过去一年间进展的速度是突飞猛进的,在图形学领域很少能看到一个问题被如此集中地讨论。即使我觉得 Meshy-2 只解决了 “3D 版 Midjourney v6” 质量水准的 20% 的问题,我想剩下的 80% 会很快被解决。

我想上面的讨论基本比较客观地介绍了 Meshy-2 的已经做到的和没有做到事情。基于这些讨论,我想展开聊一聊 Meshy-2 目前的市场定位和使用场景。目前的几类专业使用场景如下。

第一类:直接使用工作流程为 “想好提示词,生成,下载,直接导入到 Unity/ UE/ Blender/ Maya/ Max 等等引擎或者 DCC 使用”。比如说影视行业,在一些要求不是很高的影片中,Meshy-2 生成的模型作为中远景、次要资产,有的时候不需要修改就可以直接使用了。在角色方面,群众、远景角色,只要相机不太近,Meshy-2 生成的角色也是可以发挥用处的。这类资产质量要求不高,但是数量需求很多。游戏行业里,虽然 AAA 级别的游戏肯定是达不到标准的,但是游戏关卡的白盒搭建,AI 生成的资产还是有价值的。用 Meshy 生成的资产代替白盒,可以让制作人更好地判断关卡是否吸引人。当然,如果你是独立 3D 游戏开发者,也可以很好地利用 Meshy 的 3D 模型生成填充你的游戏世界。 提示词:a full boy lion, highly detailed, high resolution, highest quality, best quality, 4K, 8K, HDR, studio quality beautiful, elegant, realistic, ultra realistic第二类:辅助生产虽然不直接使用,但是基于 AI 生成的模型,到 ZB、Maya、Blender、SP 等工具进行少量修改、加工,然后使用。相比于 2D 的概念设计(原画)参考,3D 的参考有更大的价值。目前 Meshy-2 Text to 3D 生成的模型,从人体的结构和造型看起来,相对还是很准确的。这也意味着建模师可以用我们生成的模型作为依据:要么导进 ZBrush 再雕,或者放到 Maya 里面对着 AI 出的模型拉 polygon,省时省力。Meshy-2 出色的贴图能力,能够大幅减低美术人员绘制贴图的成本。在手工的贴图绘制过程中,比如说基于 Substance Painter、Body painter 等工具的流程,需要美术人员自己理解 2D 参考图和 3D 贴图之间的区别(如光影等),这是一个费心费力的创作过程,绝非易事。比如说下面这个卡通风格的模型,稍微修一下可能就在一些场合生产可用了。至于 UV,除非要极致节约 UV 资源,不然现在 AI 自动搞出来的 UV 也是可用的。

提示词:a full boy lion, highly detailed, high resolution, highest quality, best quality, 4K, 8K, HDR, studio quality beautiful, elegant, realistic, ultra realistic第二类:辅助生产虽然不直接使用,但是基于 AI 生成的模型,到 ZB、Maya、Blender、SP 等工具进行少量修改、加工,然后使用。相比于 2D 的概念设计(原画)参考,3D 的参考有更大的价值。目前 Meshy-2 Text to 3D 生成的模型,从人体的结构和造型看起来,相对还是很准确的。这也意味着建模师可以用我们生成的模型作为依据:要么导进 ZBrush 再雕,或者放到 Maya 里面对着 AI 出的模型拉 polygon,省时省力。Meshy-2 出色的贴图能力,能够大幅减低美术人员绘制贴图的成本。在手工的贴图绘制过程中,比如说基于 Substance Painter、Body painter 等工具的流程,需要美术人员自己理解 2D 参考图和 3D 贴图之间的区别(如光影等),这是一个费心费力的创作过程,绝非易事。比如说下面这个卡通风格的模型,稍微修一下可能就在一些场合生产可用了。至于 UV,除非要极致节约 UV 资源,不然现在 AI 自动搞出来的 UV 也是可用的。 提示词:a high detailed t-posed dwarf character from world of warcraft, hand painted texture实际上,在过去一年,AI 生成的 3D 模型,是用户根本不愿意去修的,因为修的工作量太大,还不如重做。但是我个人感觉 Meshy-2 跨过了这个坎,至少有人愿意修一修了。

提示词:a high detailed t-posed dwarf character from world of warcraft, hand painted texture实际上,在过去一年,AI 生成的 3D 模型,是用户根本不愿意去修的,因为修的工作量太大,还不如重做。但是我个人感觉 Meshy-2 跨过了这个坎,至少有人愿意修一修了。

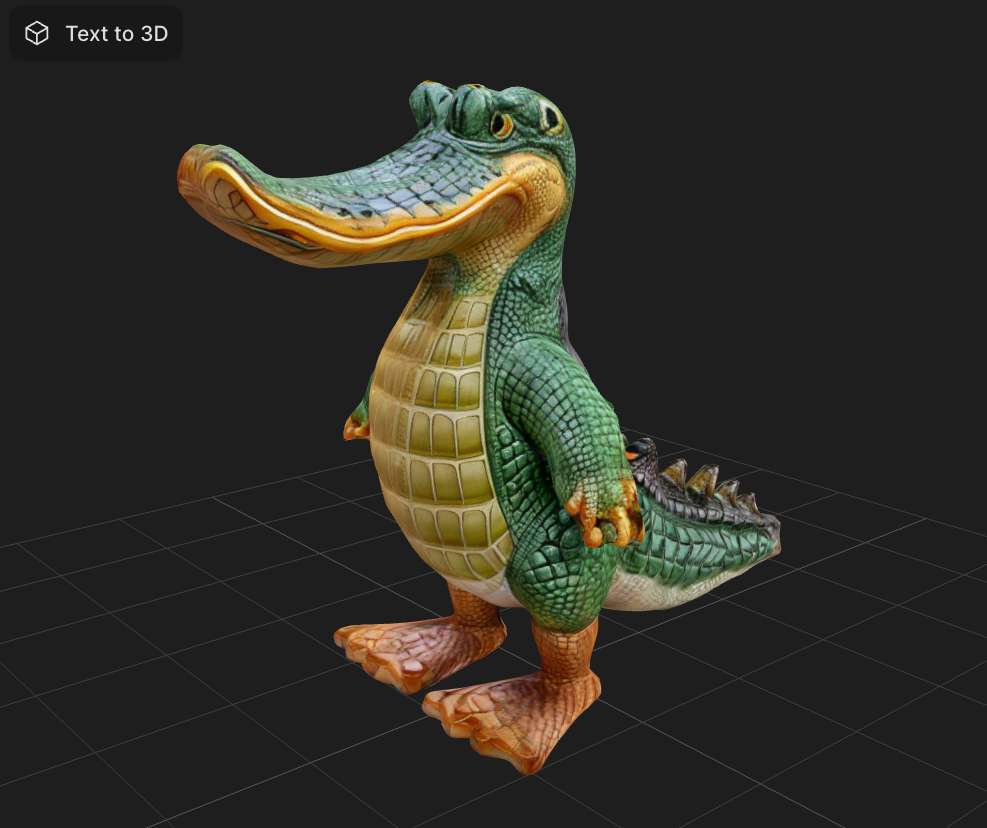

第三类:灵感释放这类用户甚至都不需要把我们的模型从网站上下载下来,只是观察自己的想法在 3D 空间中长什么样。概念设计的过程是很费时的。Midjourney 等工具解放了 2D 图片的灵感,而 Meshy 来解放 3D 的灵感。这里展示一些早期用户分享的奇奇怪怪的 3D 模型。 提示词:鳄鱼鸭 ©exotorfarm1

提示词:鳄鱼鸭 ©exotorfarm1

提示词:猩猩大象 ©exotorfarm1 提示词:Alpaca sculpture, Tangsancai, Sancai, white Alpaca sculpture, highly detailed, Chinese pottery, glaze羊驼唐三彩。也不知道唐代中国有没有羊驼,以及色彩是不是符合严格的 “三彩”,不过挺好玩的。

提示词:Alpaca sculpture, Tangsancai, Sancai, white Alpaca sculpture, highly detailed, Chinese pottery, glaze羊驼唐三彩。也不知道唐代中国有没有羊驼,以及色彩是不是符合严格的 “三彩”,不过挺好玩的。 提示词:猫头鹰雕像… (提示词过长,后续省略)当然,上面聊的更多是专业的生产力场景。由于 Meshy-2 的出现,相对不错质量的 3D 资产的生产成本将会大大降低。等 MR 普及以后,肯定会有一些新的 2C 的场景出现(比如说 3D AI 社交、游戏、甚至哄娃等等),本文限于篇幅就不做讨论了。

提示词:猫头鹰雕像… (提示词过长,后续省略)当然,上面聊的更多是专业的生产力场景。由于 Meshy-2 的出现,相对不错质量的 3D 资产的生产成本将会大大降低。等 MR 普及以后,肯定会有一些新的 2C 的场景出现(比如说 3D AI 社交、游戏、甚至哄娃等等),本文限于篇幅就不做讨论了。 提示词:奥特曼骑大象亲戚家小朋友告诉我的提示词。当她看到一个能够自由旋转的 3D 奥特曼模型时,可开心了。开一下脑洞:在消费端,也许 3D AI 哄娃会是一个应用场景:“巴啦啦小魔仙,变身!”

提示词:奥特曼骑大象亲戚家小朋友告诉我的提示词。当她看到一个能够自由旋转的 3D 奥特曼模型时,可开心了。开一下脑洞:在消费端,也许 3D AI 哄娃会是一个应用场景:“巴啦啦小魔仙,变身!”

04

“AI 会抢走建模师的工作吗?”

我想在文章最后聊一些大家关心的非技术内容。去年我有幸受邀在几家美国游戏公司介绍 Meshy。我记得有一次在 EA 分享,一位朋友直接地问我,用中文描述问题大概是 “你搞的这个 3D AI 未来可能会导致很多 3D 艺术家失业。你会感到自责吗?”我不想回避这个问题,所以借今天这个机会,和大家坦诚地聊一聊我的看法。首先,按照今天 AI 生成 3D 的水平,担心 “AI 明天就立刻导致一些 3D 艺术家失业”,未免有点贩卖焦虑、贻笑大方了。如前所说,今天的 3D AI 距离人类的最高水平,还有很远的距离。在 A 站随便找个模型,都比现在 AI 生成的模型在造型、贴图、拓扑、UV 等等方面好很多倍。但是,我想这个问题需要从更长的时间尺度,比如说 5 年来思考。按照我对 3D AI 的认知,技术会发展很快。当历史的车轮朝前滚动的时候,没有任何人能够阻止其发展。我们应该如何应对这种变化?这里我想分享一个我在 2022 年底看到 ChatGPT 的时候,担心自己会被 AI 替代的故事。我从事了近 10 年计算机科学方面的科研工作,先是在清华,后来到麻省理工学院,然后在硅谷创业。我每天和大量英文打交道,也在美国这样有英语语言环境的地方生活了挺多年,发表了一些 SIGGRAPH 之类的论文,自己觉得英文水平应该是不错的。但是当我发现 ChatGPT 的英文比自己好很多、并且每个人(即使没怎么学过英语的人)都能借助 ChatGPT 跨过语言的障碍的时候,我严重自我怀疑了一段时间:AI 这么牛了,我以前努力学习英语的时间是不是白费了?然后,我很快养成了每天使用 ChatGPT 的习惯。上面的故事其实想说明我比较认同的一个观点,即 “夺走人们工作的不是 AI,而是能够熟练掌握 AI 的人们”。打不过,就加入。虽然很多巧妙的英文表达方式我自己想不出来,但是我良好的英文基础能够帮我很好地判断 ChatGPT 的哪些输出是信、达、雅的。从此以后 ChatGPT 就成为了每天为我干活的工具之一,我也借助 ChatGPT 的能力在很多涉及英语的任务上事半功倍。(我经常用 ChatGPT 的方式是 “请提供 100 个方案”,这样我只需要选最好的就行了。)类似的还有 GitHub Copilot。虽然我现在自己创业做 CEO 了,但是依然保持着每天写代码的习惯。毕竟不写代码,人容易飘,手也会痒。不过我现在的代码,已经有一半是 GitHub Copilot 写的了。我想,AI 其实已经拿走了我作为计算机科学家、创业公司 CEO、软件工程师、产品经理等种种身份的很多工作,这是我没法改变的,只能去适应。另一方面,我作为十几年老码农,能够一眼看出 AI 写的 code 的 bug,估算出多少个时钟周期能运行完,AI 糊弄不了我,只是成为我的工具罢了。因此,我并没有觉得英语或者编程白学了,甚至我多年的英语和编程经验,让我比别人能够更好地使用相关的 AI 工具。说回 AI 生成 3D,我想也是类似的。AI 生 3D 的技术还没有达到 GPT-4 生成文字的水平。但是我觉得再过一两年 AI 生成 3D 就能实现 Midjourney 级别的质量。可能很多画师朋友吐槽 Midjourney 出的图没有图层,不方便后续编辑,但是这不妨碍当 Midjourney、SD 的质量做到一定水平以后,至少辅助原画生产是很有价值的。3D 也一样。即使一年以后 Meshy 生成的模型的拓扑、UV 还是不好,后续编辑也没有那么方便,但是这不妨碍模型师在很多场合用 Meshy 来提高生产力。我们有幸生活在一个充满了变化和机遇的时代,而适应变化的人就能够获得更多优势。Meshy 是面向全球用户的产品,我每天都在和世界各地的用户打交道。我的一个感觉是华人用户往往对 AI 接受程度是很高的。在未来的一两年, 3D 模型的生成会像如今的 AI 绘画一样容易。我想每个人都应该去为这样的变化做好准备。随着 Vision Pro、Quest 3 等 MR/VR 设备的普及,对于 3D 资产的需求也会快速上升。我想,最好的结果,就是 AI 带来的 3D 生产力的提升,恰好能够满足新设备带来的 3D 资产需求的快速增长。这样的话,虽然每位 3D 艺术家的生产力借助 AI 提高了,产业对于 3D 艺术家的需求却没有减少,因为总需求也变大了。甚至由于 AI 能够快速试错各种各样的灵感,反而能够解放艺术家更多创造力,最后所有拥抱 AI 的艺术家都能让 AI 为自己干活,做出更好的作品。说到底,用 AI 生成 3D,和 “用动捕代替手动 K 帧”、“用 UE 实时渲染加速影视创作”、“用 PCG 快速生成场景”、“用 PBR 流程做出更真实的材质”,没什么本质区别。只不过 AI 带来的工具升级会更加智能、新鲜、跨度更大罢了。

05

最后我想说

感谢 Meshy 团队每一位成员的努力拼搏。走在最前面做别人没做过的事情,趟出一条自己的路,是不容易的。我很开心能够作为 Meshy 团队的一员,和大家一起探索人类没有走到过的地方。也感谢一路走来,全球每一位 Meshy 用户对我们的支持和理解,你们的认同是我们持续把这件事情做下去的动力。提前祝大家龙年愉快。文章欢迎转载,转载请标明出处。*虽然 AI 生成 3D 大大降低了 3D 内容创作的门槛、使得大众也能进行 3D 创作,但是关于 3D 资产的使用 Consumer 场景尚不成熟,所以这篇文章暂时会聚焦在 CG 生产这样的明确场景,其他场景以后有机会再和大家讨论。

如果你关注 AI 生成 3D,欢迎扫码加入我们的 3D AI 交流群,来一起探讨大模型时代的共识和认知,跟上大模型时代的这股浪潮。

更多阅读Product Hunt 2023 年度产品榜:GPT-4 夺冠、获奖 AI 产品全介绍

Perplexity CEO 专访:拥有十万用户的套壳产品比拥有自有模型却没有用户更有意义

火遍硅谷的Arc浏览器,刚刚发布App和AI功能,体验碾压Chrome!

Kyligence 韩卿:创业 7 年复盘,中美企业服务市场差异浅析

Cubox创始人的产品思考:不要把「总结全文」当做AI阅读产品的唯一亮点

转载原创文章请添加微信:geekparker

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง