白交 衡宇 发自 凹非寺

量子位 | 公众号 QbitAI

造大模型的成本,又被打下来了!

这次是数据量狂砍95%的那种。

陈丹琦团队最新提出大模型降本大法——

数据选择算法LESS, 只筛选出与任务最相关5%数据来进行指令微调,效果比用整个数据集还要好。

指令微调正是让基础模型成为类ChatGPT助手模型的关键一步。

这样一来,让大模型术业有专攻,也就更便宜高效了。

更关键的是,所选的训练数据还具备可迁移性,只要针对特定任务,在其他大模型以及各种类型的模型上同样适用。

快来瞅瞅这篇新鲜出炉的论文到底说了什么?

LESS算法

目前指令微调释放了大模型的强大功能,可有效利用组合数据集开发ChatBot。

但面临的挑战在于,如何从这些数据集中识别出最相关的数据,从而来训练专门的技能。这种情况称为有针对性的指令微调。

为了解决这一难题,受过去相关研究——利用梯度信息估算单个训练数据点影响的启发,研究人员设计了一种优化器感知方法来选择这些数据。

LESS(Low-rank gradiEnt Similarity Search),简言之,优先使用对目标任务有直接帮助的数据进行训练,而不是依赖表面形式特征。

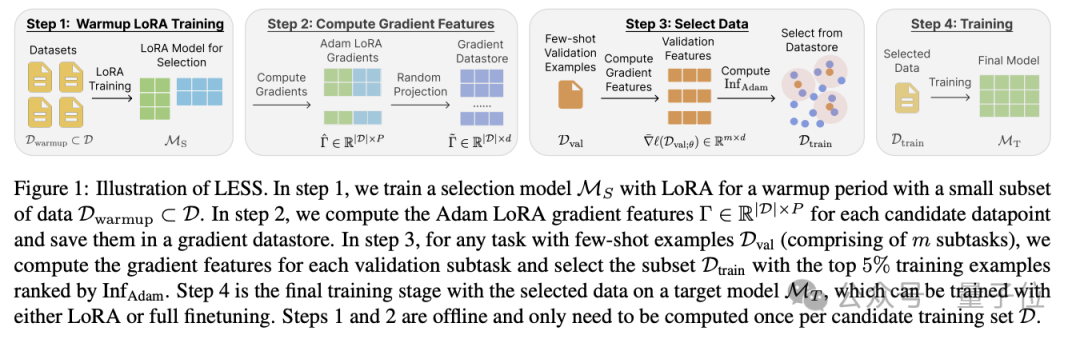

主要分为四个步骤。

首先从训练数据集摘取一小部分子集,用LoRA训练出一个选择模型。

随后,为单个训练数据点计算Adam LoRA梯度特征,并将其保存在梯度数据存储库中。

第三步,选择数据。对于具有少量示例的任务(含多个子任务),研究人员计算每个验证子任务的梯度特征。再从存储库中选出排名前5%训练子集。

最后,训练目标模型。该模型可以使用 LoRA 或完全微调进行训练。

其中第一步和第二步可以离线操作,每个候选训练集D只需计算一次。

归结起来,LESS具备这样几个特性:

-

与Adam优化器兼容。LESS将梯度信息与优化器状态相结合,来研究数据对模型性能的影响。

-

高效。LESS使用LoRA和随机投影来构建梯度数据存储,该数据存储具有低维、易操作的梯度特征,允许高效、有效地选择数据集。梯度数据存储可重复用于新的目标任务。

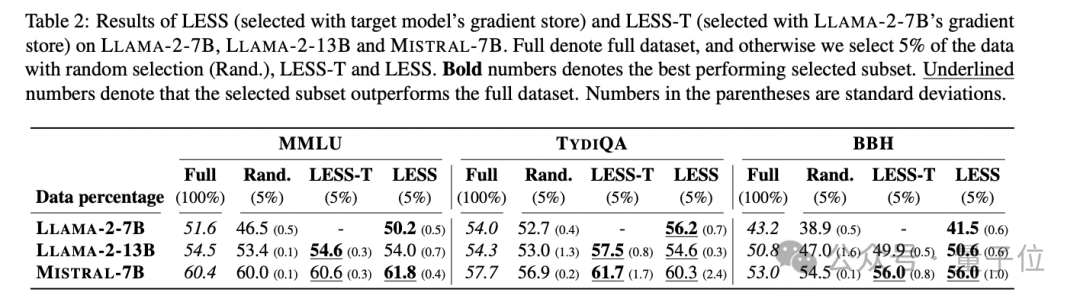

最终在评估结果中,MMLU、TydiQA以及BBH的任务中,5%数据量给大模型训练比整个数据集训练效果要好。

并且同随机选择相比,LESS性能始终高出 2 到 5 个百分点,这表明这一方法十分有效。

此外,他们还特别发现LESS具备可转移性。

LLAMA-2-7B上选择的数据结果,在LLAMA-2-13B和MISTRAL-7B的性能(列表LESS- T)同样更好。

甚至有的表现还比自己用LESS的(列表LESS)性能还好。

除此之外,还有可解释性。LESS选择的数据具有与目标任务相似的推理和技能类型,而现有方法(比如BM25、RDS)往往只根据表面形式线索(如语言或文本)选择数据。

陈丹琦团队出品

论文作者来自普林斯顿大学、华盛顿大学的研究人员。

普林斯顿计算机专业的博士生夏梦舟和Sadhika Malladi为共同一作。

其中夏梦舟本科毕业于复旦,硕士毕业于CMU,目前是陈丹琦的学生。

在陈丹琦的个人主页显示,“这些天主要被开发大模型吸引”,正在研究主题包括:

-

检索如何在下一代模型中发挥重要作用,提高真实性、适应性、可解释性和可信度。

-

大模型的低成本训练和部署,改进训练方法、数据管理、模型压缩和下游任务适应优化。

-

还对真正增进对当前大模型功能和局限性理解的工作感兴趣,无论在经验上还是理论上。

前段时间,他们曾提出爆火的“羊驼剪毛”大法——

LLM-Shearing大模型剪枝法,只用3%的计算量、5%的成本取得SOTA,统治了1B-3B规模的开源大模型。

大模型科研的上半场是把参数搞上去实战涌现,下半场嘛,less is more,更小的参数,更好的效果,帮助大模型在更多领域更快落地。

论文链接:

https://arxiv.org/abs/2402.04333

— 完 —

点这里👇关注我,记得标星哦~

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见 ~

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง