春节假期尚未结束,OpenAI 最新发布的视频生成模型 Sora 便突然引爆了科技圈。

作为一个数据驱动的物理引擎,只需要接收一句话,Sora 便可以生成“充满想象力”“史诗级”的大片。

视频|OpenAI 官方给出的 demo 之一。提示词:美丽多雪的东京热闹非凡。镜头跟随几位正在享受美丽雪景和在附近摊位购物的人们,穿过熙熙攘攘的城市街道。绚丽的樱花花瓣与雪花一起随风飞舞。

由于生成的视频画面过于真实,且水平吊打一众“前辈”视频生成模型,Sora 让人们不禁感叹:又有一批人要失业了?现实要不存在了吗?这无疑又是一颗投向人类的重磅“炸弹”。

当天,Google 也发布了自家的最新大模型 Gemini 1.5。据介绍,Gemini 1.5 的上下文窗口高达 100 万个 tokens,可以一次处理大量的信息——如 1 小时的视频、11 小时的音频、3 万多行的代码等。这样的算力,已经远远超过人类。

未来,人工智能(AI)还将会展现出怎样的超级能力,我们还不得而知。但有一点显而易见,AI 的安全治理,依然落后 AI 的发展。

面对已知的挑战和未知的风险,人类已经做了大量的工作,探讨 AI 伦理、数据伦理和算法伦理,而却很少讨论支撑 AI 飞速发展的物理硬件——图形处理器和算力上。

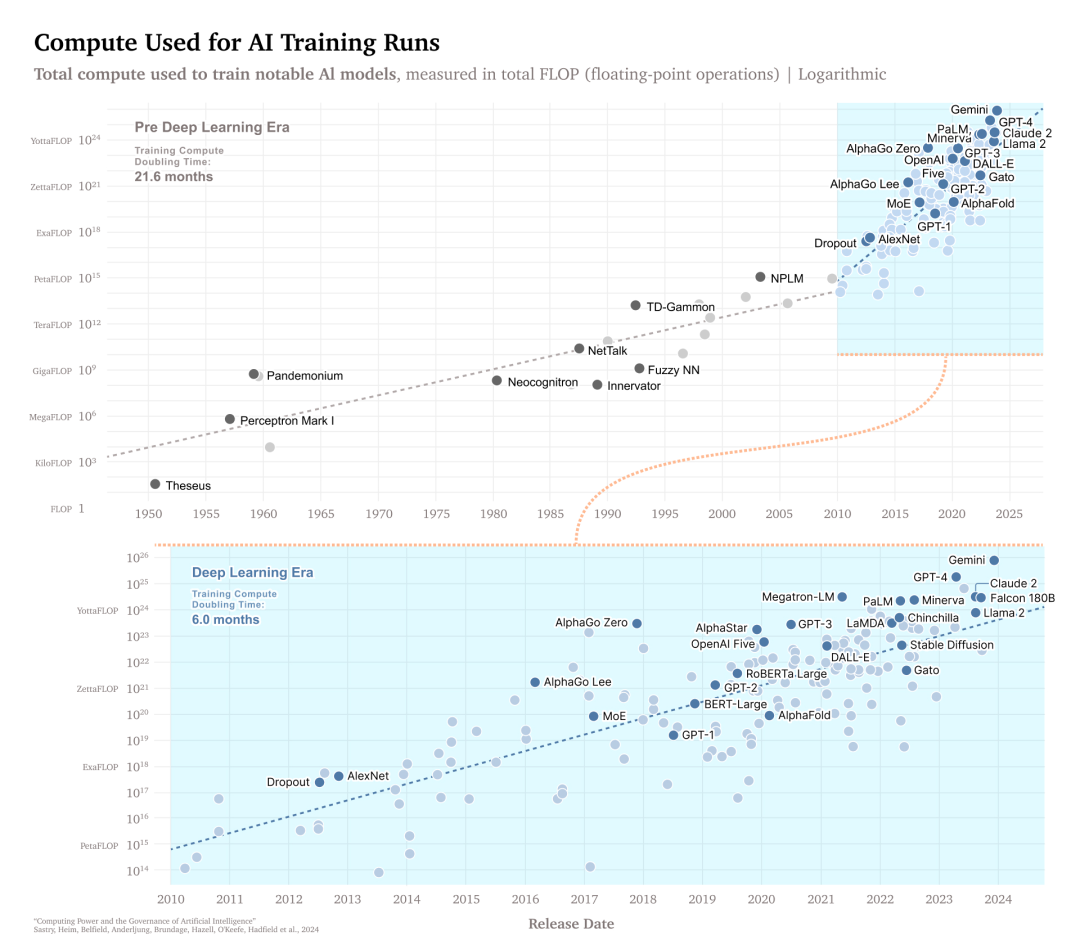

图|自 2010 年以来,用于训练 AI 模型的计算量大约每六个月翻一番,数据来自 Epoch。

日前,来自 OpenAI、人工智能治理中心(GovAI)、剑桥大学 Leverhulme 未来智能中心等机构的 19 位学界、业界人士,共同发表了一篇题为“Computing Power and the Governance of Artificial Intelligence”的研究论文,将 AI 发展的争议焦点聚焦到了“硬件”和“算力”上。

在这篇论文中,这些专家提出了多项政策选择,其中之一是建立一个全球登记处,跟踪用于 AI 超级计算机的芯片流动,从而帮助防止 AI 的滥用和灾难。

另外,论文中提到的其他技术建议包括“计算上限”(compute caps)——对每个 AI 芯片可连接的芯片数量的内置限制——以及在多方之间分配 AI 训练的“启动开关”(start switch),以便在有风险的 AI 输入数据之前对其进行数字否决。

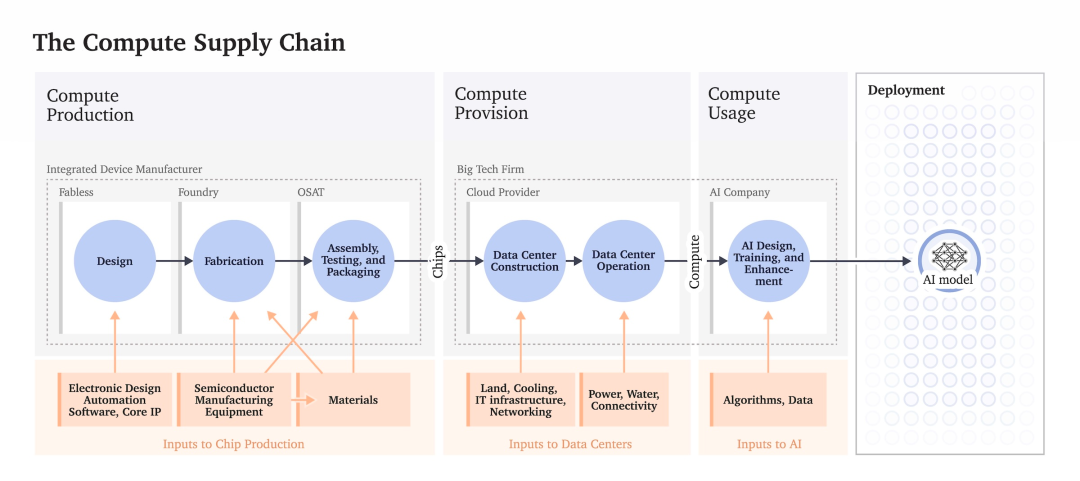

这些专家认为,驱动生成式 AI 模型所需的强大计算芯片是通过由少数几家公司主导的高度集中的供应链构建的,这使得硬件本身成为降低风险的 AI 政策的强有力干预点。

图|计算(compute)供应链示意图。

图|计算(compute)供应链示意图。

因此,治理人工智能硬件、芯片和数据中心将在治理 AI 模型开发和部署方面发挥重要作用,但“也可能带来新的社会风险”。

硬件是治理AI的关键

硬件在 AI 领域的重要性主要体现在以下几个方面:

AI 模型变得越来越复杂,需要大量的计算资源来训练和运行。硬件,例如高性能的 CPU、GPU、TPU 等,提供了这些计算资源。它们能够加速复杂算法的运行,以及大规模数据的处理,从而实现更快速、更有效的 AI 应用。

让一个 AI 模型变得越来越复杂,通常需要大量的计算资源,而硬件的性能直接影响着模型训练的速度和效率。高性能的硬件可以加快模型训练的进程,缩短开发周期,提高模型的更新速度和质量。

除了模型训练,AI 模型在部署和实际应用中也需要大量的计算资源进行推理。例如,在语音识别、图像识别、自然语言处理等应用中,需要实时处理大量的数据并生成准确的预测结果。硬件的性能和效率直接影响着这一过程的速度和准确性,这对实时性要求较高的应用尤为重要。

硬件在保障 AI 系统安全性和隐私保护方面也发挥着关键作用。通过硬件的安全功能和加密技术,可以确保 AI 系统的数据和模型在传输和存储过程中得到有效的保护,有效防止敏感信息泄露和恶意攻击。

因此,计算资源的使用量是衡量一个 AI 系统潜在影响的可靠指标之一。

通过监管和管理计算资源的使用,可以有效地影响和控制 AI 技术的发展方向和应用范围。

相比看不见摸不着的软件,计算资源相对容易进行检测、排除和量化,这使硬件治理成为一种有效手段。

与数据和算法不同,计算资源是有限的实物资源,可以被准确地计数和跟踪,因此更容易进行管理和监管。

基于此,该论文提供了一系列可行的治理方案:

1.建立监测和追踪系统,用于跟踪计算资源的使用情况和流向;

2.制定限制性政策,限制某些敏感领域或特定用途的计算资源的使用;

3.加强对计算资源供应链的管理和监督,以确保供应链的安全和稳定性。

这些技术方案的目标是通过有效的管理和监管计算资源的使用,来保障 AI 技术的安全和可持续发展,从而实现对 AI 技术的有效治理。

全球视野下的AI计算可见性

具体来说,AI 计算注册制度(global registry tracking the flow of chips destined for AI supercomputers)指的是一个全球性的登记注册系统,用于跟踪用于人工智能超级计算机的芯片流动。这个制度是报告提到的政策选择之一。

建立AI计算注册制度具有重要意义。

首先,可以提高对 AI 计算资源的透明度和可追溯性,使各国能够更好地监测和控制全球 AI 技术的发展和应用。

其次,注册制度有助于识别和防范潜在的安全风险和伦理挑战,确保 AI 技术的安全和可持续发展。

此外,全球注册制度还可以促进国际合作和信息共享,推动全球 AI 治理的协调和合作,实现共赢和共同发展。

当然,这项措施的推行也面临着很多挑战。

首先,来自不同国家和地区的政治和文化差异可能导致立法和执行上的障碍。

其次,技术和数据安全、隐私保护等问题可能引发国际争议和纠纷。解决这些挑战的关键在于建立多边合作机制和国际标准,促进各国间的协商和合作。

此外,加强国际组织和机构的角色和职能,建立信息交流和合作平台,加强对技术和数据安全的监管和管理,都是解决这些挑战的重要途径。

该论文还提到了其他技术方案,例如“计算上限”,即每个 AI 芯片可以连接的芯片数量的内置限制,以及分发“启动开关”给多方,以允许对有风险的 AI 进行数字否决之类的政策。

研究人员认为,AI 芯片和数据中心是更有效的审查和AI安全治理目标,因为这些资产必须是物理上拥有的,而“AI 三元组”的其他元素——数据和算法——理论上可以无限复制和传播。

AI治理政策的新方向

该论文指出,针对 AI 可能带来的风险,政策制定可以从以下几个方面进行:

1.限制计算机芯片网络:政府可以通过立法或监管机制限制对关键计算机芯片网络的访问,以防止其被恶意使用或攻击。这包括对芯片生产和供应链的管控,以确保其安全和可靠性。

2.加强加密技术监管:政府可以制定更严格的加密技术使用规定,确保其不被用于非法活动或恶意目的。这可能包括对加密技术的出口管制和使用限制。

保证安全和良性发展的同时,一定会有所牺牲。

比如,限制计算机芯片网络和加密技术可能会影响到正常的商业活动和科研进展,对技术创新造成一定程度的阻碍。过度的监管也可能导致市场动态受到限制,影响市场的竞争性和效率性。

论文指出,治理 AI 的关键在于对其计算设备的监管。政府需要制定相应的政策和监管措施,以应对由AI发展带来的风险。

然而,政策制定需要权衡各方利益,并且要克服监管过程中的各种挑战和困难。AI 发展是全球人类的命题,在这个过程中,政府应该积极倡导国际合作,共同应对 AI 治理挑战,携手实现共赢。

参考链接:https://www.eurekalert.org/news-releases/1034407https://www.cser.ac.uk/media/uploads/files/Computing-Power-and-the-Governance-of-AI.pdfhttps://github.com/lheim/CPGAI-Figureshttps://www.governance.ai/post/computing-power-and-the-governance-of-aihttp://lcfi.ac.uk/news-and-events/news/2024/feb/14/compute-ai-governance/

|点击关注我 👇 记得标星|

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง