导语

集智俱乐部和安远AI联合举办“大模型安全与对齐”读书会,由多位海内外一线研究者联合发起,针对大模型安全与对齐所涉及的核心技术、理论架构、解决路径以及安全治理等交叉课题,展开共读共研活动。读书会自2024年1月27日正式开始,每周六上午举行,为期8-10周。欢迎从事相关研究与应用工作的朋友报名加入!

分享内容简介

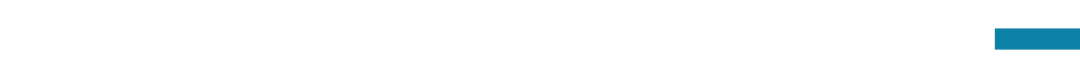

在Superalignment (超级对齐) 当中,scalable oversight (可扩展监督) 专注在通过人工智能系统协同人类完成人类单独难以完成的困难任务。可扩展监督在通用人工智能的语境下特别重要,因为能力的限制,人类很难有效评估通用人工智能的表现,因此必须通过可扩展监督的方式与人工智能系统协同进行评估。大模型安全与对齐读书会的第三期,我们邀请到上海交通大学计算机系博士生陈奕群。陈奕群将首先概述大模型对齐以及超级对齐相关研究。接下来会深入探讨可扩展监督的各个层面,包含实现方式和应用场景。

分享内容大纲

1.AI Alignment(AI对齐):

-

动机

-

可行方法概述:SFT, RLHF, DPO

2.SuperAlignment(超级对齐):

-

动机

-

研究类别:Weak-to-strong generalization, Interpretability, Scalable Oversight, Other directions

3.Scalable Oversight(可拓展监督):

-

动机

- 相关研究:实现方法(agent-debate, recursive reward modeling, prover-verifier game), 评估, 以及其他应用场景(agent, human annotation)

主要涉及到的前置知识

Alignment

SuperAlignment

Scalable Oversight

主讲人介绍

陈奕群,上海交通大学计算机系在读博士生。他师从刘鹏飞副教授进行人工智能对齐研究,硕士期间在卡内基美隆大学师从Graham Neubig教授。他过去曾在亚马逊进行研究实习,在人工智能对齐和大模型相关领域发表了多篇论文。研究方向:人工智能对齐

陈奕群,上海交通大学计算机系在读博士生。他师从刘鹏飞副教授进行人工智能对齐研究,硕士期间在卡内基美隆大学师从Graham Neubig教授。他过去曾在亚马逊进行研究实习,在人工智能对齐和大模型相关领域发表了多篇论文。研究方向:人工智能对齐

涉及到的参考文献

[1] Dario Amodei, Chris Olah, Jacob Steinhardt, et al. Concrete Problems in AI Safety. arXiv:1606.06565, 2016

[2] Bowman S R, Hyun J, Perez E, et al. Measuring progress on scalable oversight for large language models[J]. ar**v preprint ar**v:2211.03540, 2022.

[3] Irving G, Christiano P, Amodei D. AI safety via debate[J]. arXiv preprint arXiv:1805.00899, 2018.

[4] Leike J, Krueger D, Everitt T, et al. Scalable agent alignment via reward modeling: a research direction[J]. arXiv preprint arXiv:1811.07871, 2018.

[5] Learning to Give Checkable Answers with Prover-Verifier Games. arXiv.org, 2021, abs/2108.12099

[6] R. Peng, A. Parrish, N. Joshi, et al. QuALITY: Question Answering with Long Input Texts, Yes!. North American Chapter of the Association for Computational Linguistics, 2022: 5336-5358

[7] S. Chern, E. Chern, G. Neubig, et al. Can Large Language Models be Trusted for Evaluation? Scalable Meta-Evaluation of LLMs as Evaluators via Agent Debate. arXiv.org, 2024, arXiv:2401.16788

[8] Collin Burns, Pavel Izmailov, Jan Hendrik Kirchner, et al. Weak-to-Strong Generalization: Eliciting Strong Capabilities With Weak Supervision. arXiv:2312.09390, 2023

[9] Long Ouyang, Jeff Wu, Xu Jiang, et al. Training language models to follow instructions with human feedback. arXiv:2203.02155, 2022

[10] Chunting Zhou, Pengfei Liu, Puxin Xu, et al. LIMA: Less Is More for Alignment. arXiv:2305.11206, 2023

直播信息

时间:2024年2月24日(周六)早上9:00-11:00。

参与方式: 扫码参与大模型安全与对齐读书会,加入群聊,获取系列读书会回看权限,成为社区的种子用户,与社区的一线科研工作者与企业实践者沟通交流,共同推动大模型安全与对齐读书会社区的发展。

扫码参与大模型安全与对齐读书会,加入群聊,获取系列读书会回看权限,成为社区的种子用户,与社区的一线科研工作者与企业实践者沟通交流,共同推动大模型安全与对齐读书会社区的发展。

大模型安全与对齐读书会

大模型的狂飙突进唤醒了人们对AI技术的热情和憧憬,也引发了对AI技术本身存在的社会伦理风险及其对人类生存构成的潜在威胁的普遍担忧。在此背景下,AI安全与对齐得到广泛关注,这是一个致力于让AI造福人类,避免AI模型失控或被滥用而导致灾难性后果的研究方向。集智俱乐部和安远AI联合举办「大模型安全与对齐」读书会,由多位海内外一线研究者联合发起,旨在深入探讨大模型安全与对齐所涉及的核心技术、理论架构、解决路径以及安全治理等交叉课题。

详情请见:2024开年读书会:AI安全与对齐——应对前沿AI失控与滥用的技术路线

特别鸣谢安远AI对本次读书会的内容贡献。

安远AI是一家位于北京、专注于AI安全与治理的社会企业。我们的使命是引领人机关系走向安全、可信、可靠的未来。我们面向大模型和通用人工智能安全和对齐问题,进行风险研判、建立技术社区、开展治理研究、提供战略咨询以及推动国际交流。

点击“阅读原文”,报名读书会

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง