编译 | 熊展坤

审核 | 王紫嫣

今天介绍的是AAAI 2024接收的论文:MmAP : Multi-modal Alignment Prompt for Cross-domain Multi-task Learning,该论文为CLIP提出了多模态对齐提示(MmAP),并在其基础上开发了一个创新的多任务提示学习框架。

1 摘要

多任务学习(MTL)旨在同时训练多个相关任务,从而提高单个任务的性能。通常,多任务网络结构由共享主干和特定于任务的解码器组成。然而,解码器的复杂性随着任务数量的增加而增加。为了解决这一挑战,作者集成了无解码器的视觉语言模型CLIP,它具有强大的zero-shot泛化能力。最近,参数高效迁移学习方法已经与CLIP一起被广泛探索,以适应下游任务,其中快速微调显示出强大的潜力。然而,这些方法只是对单一的模态(文本或视觉)进行微调,从而破坏了CLIP的模态结构。在本文中,作者首先为CLIP提出了多模态对齐提示(MmAP),它在微调过程中对文本和视觉模态进行对齐。在MmAP的基础上,作者开发了一个创新的多任务提示学习框架。一方面,为了使高相似性任务之间的互补性最大化,作者采用梯度驱动的任务分组方法,将任务划分为多个不相连的组,并为每组分配一个组共享的MmAP。另一方面,为了保持每个任务的独特性,作者为每个任务分配了一个特定于任务的MmAP。在两个大型多任务学习数据集上进行的综合实验表明,与完全微调相比,该方法在仅利用约0.09%的可训练参数的情况下实现了显著的性能提升。

2 引文

多任务学习(MTL)已经成为深度学习的一种有效方法,它允许在统一的网络架构内联合训练多个相关任务,与单任务学习(STL)相比,可以提高模型性能。MTL的核心在于学习任务共享表示和特定任务表示。通过利用跨任务的共享表示和知识,MTL增强了泛化并减轻了过拟合。使用特定的表示允许MTL保留每个任务的独特特征。此外,为多个任务训练一个统一的模型通常比训练几个单任务模型更有效。因此,MTL在各个领域都引起了相当大的兴趣,包括计算机视觉,自然语言处理等。

在这项工作中,作者主要关注视觉多任务学习。先前的研究主要集中在多任务模型训练框架的设计上,包括基于编码器的方法和基于解码器的方法。然而,随着视觉预训练模型的日益强大,直接针对下游多任务对这些模型进行微调可以显著提高性能,并已成为多任务学习的主流方法。但这种微调模式仍然有必要为每个任务建立一个独特的解码器,具有线性增加的可训练参数。

为了解决上述问题,作者结合了预训练的视觉语言模型CLIP ,并认为它是为视觉多任务学习量身定制的。一方面,CLIP被训练成使用网络规模的数据(例如,4亿文本图像对)来对齐语言和视觉模式,赋予它zero-shot转移到视觉下游任务的强大能力。另一方面,CLIP的体系结构提供了一个明显的优势。它包括文本编码器和图像编码器,从而消除了为每个任务建立额外的解码器结构的需要。因此,作者选择调整CLIP来解决视觉多任务。

按照传统的预训练-微调范式,整个CLIP参数(~ 150M)将需要更新,这带来了计算和存储方面的挑战。最近,许多研究引入了参数高效迁移学习技术,以实现可训练参数与下游任务性能之间的最佳平衡。然而,这些现有的方法主要集中在预训练的视觉模型或语言模型上,它们对更复杂的视觉语言模型的适用性仍然不确定。此外,这些方法倾向于强调单任务适应,而多任务适应仍然是一个挑战。

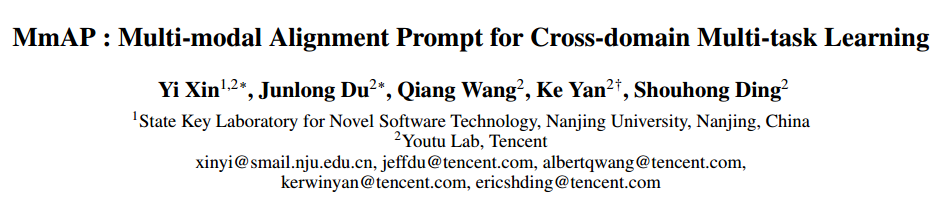

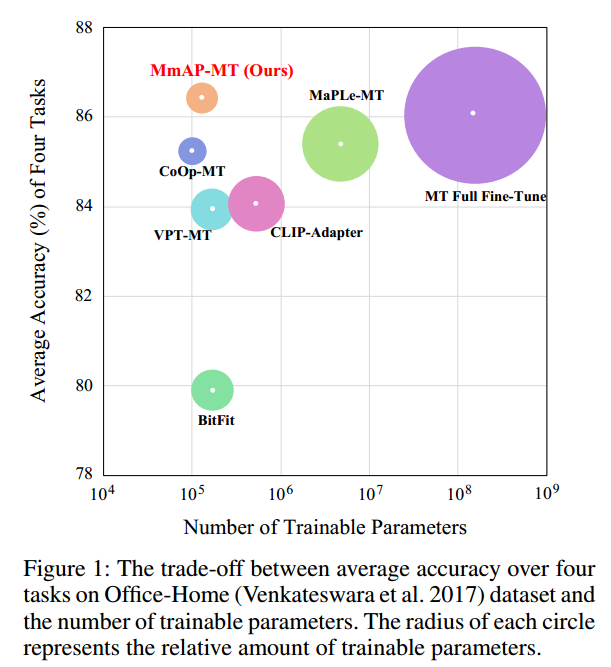

首先,作者首先对现有成功的参数高效迁移学习方法应用于CLIP进行视觉多任务学习时的性能进行了研究,如上图所示。通过广泛的研究,作者发现提示调优方法VPT-MT、CoOp-MT和MaPLe-MT比BitFit和Adapter更合适。这可能是由于BitFit和Adapter更新了模型参数,破坏了CLIP原有的结构完整性。相反,提示调优方法只修改输入嵌入(文本或图像),如下图所示。此外,作者观察到MaPLeMT优于VPT-MT和CoOp-MT,强调了同时微调两种模式的优势。

随后,基于观察到的现象,作者提出了一种新的多模态对齐提示(MmAP),以及为多任务图像识别场景量身定制的框架。MmAP通过源提示符生成文本提示符和视觉提示符,以实现两种模态的调优对齐效果。此外,作者还设计了一个基于MmAP的多任务提示调优框架。以前的MTL工作已经证实,将相似的任务放在一起训练会产生互补效果,而将不同的任务放在一起训练会产生负面效果。因此,作者首先对组任务采用梯度相似度,然后分配一个组共享的MmAP进行联合训练。此外,为了保持每个任务的独立特征,作者为每个任务单独建立了特定于任务的MmAP。在两个大型跨域多任务数据集(包括Office-Home和miniddomainnet)上评估了本文提出的方法。图1显示了Office-Home上的结果,说明提出的方法在可训练参数和性能之间实现了良好的权衡。

本文主要贡献如下: •为CLIP提出了多模态对齐提示(MmAP),以便在参数有效调谐时有利地对齐其视觉语言表示。

•在MmAP的基础上,设计了一个跨域图像识别任务的多任务提示学习框架,结合了组共享的MmAP和任务特定的MmAP。

•设计了一个基于CLIP的统一库,对用于多任务图像识别的各种参数高效调优方法进行基准测试。该论文是第一个承担这项工作的。

•在两个常用的视觉多任务数据集上的实验结果表明,与仅利用~ 0.09%的CLIP参数进行多任务全面调优相比,所提出的方法实现了具有竞争力的性能,如图1所示。

3 方法

MmAP的基本架构如上图所示。

3.1 多任务分组

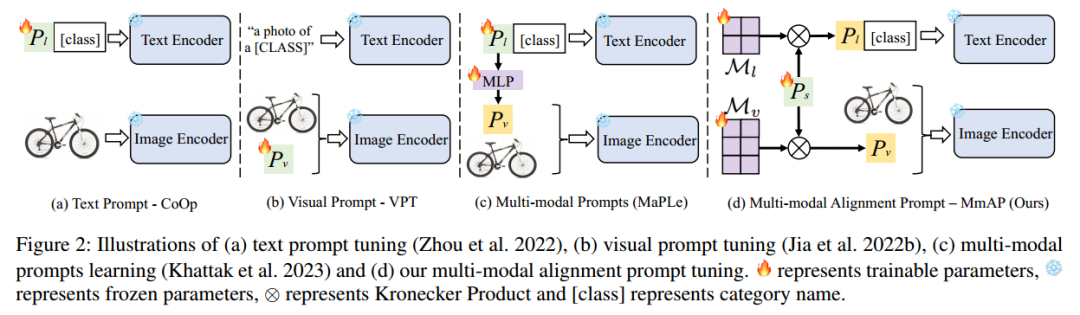

现有的MTL工作已经证明,梯度余弦相似度可以量化两个任务的相似度,即两个任务可以从联合训练中受益的程度。因此,作者通过计算共享参数上的梯度来评估两个任务的相似性,同时保持预训练的视觉语言模型不变。如模型图a所示

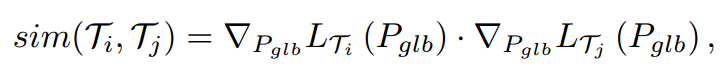

具体来说,给定所有任务的全局共享MmAP ,则第i个任务与第j个任务之间的相似度可以估计为如下点积:

其中表示任务上的损失。假设当时,表明两个任务表现出互增益效应。此外,为了进行稳健估计,作者在全局共享MmAP的训练过程中对多个相似度“快照”进行平均。在高层次上,作者同时训练所有任务,在整个训练过程中评估成对任务相似性,并确定最大限度地提高任务间总相似性的任务组。

3.2 多任务提示学习框架

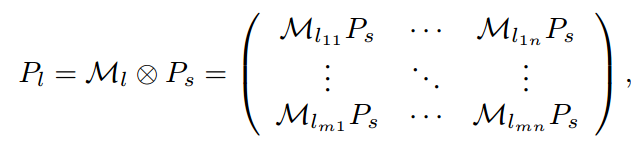

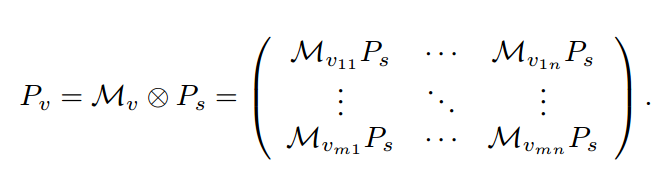

在MmAP基础上开发了统一的多任务提示学习框架,如模型图b所示。给定个下游任务,作者首先根据梯度相似度将它们划分为若干不相交的组。为简洁起见,作者将表示为一个由个任务组成的任务组。然后,作者构建了包含K个转换层的CLIP组共享MmAP,其中包括语言分支和视觉分支的源提示符、缩放矩阵和。组共享的MmAP由组G内的所有任务累积更新,从而在类似任务之间实现互补优势。此外,对于组中的每个任务,作者构建了特定于任务的MmAP来学习唯一的任务特征,包括语言和视觉分支的源提示、缩放矩阵和.其中,作者使用克罗内克积为文本和图像编码器生成提示:

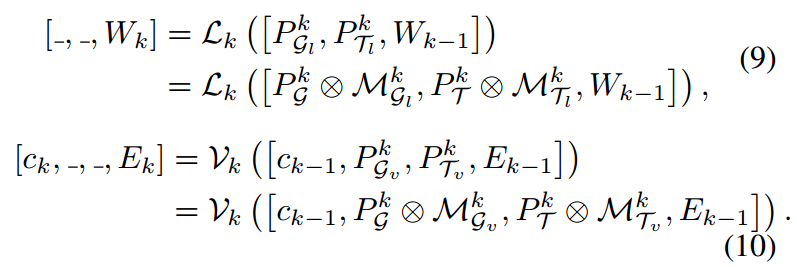

在组任务的训练过程中,作者首先在两个编码器中生成第k层的文本和图像提示符,然后通过组合类标记、生成的提示符和前一层的文本/图像标记符来重建输入标记。因此,文本和图像编码器中第k层的计算可以表示为:

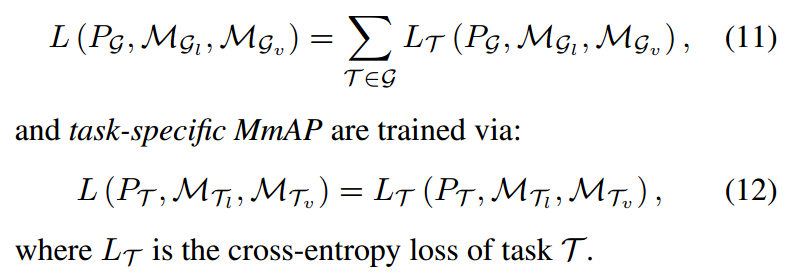

这里[·,·]指的是连接操作。最后,通过优化以下损失,对组共享MmAP进行累积更新:

4 实验

4.1 数据集

继之前的MTL工作,作者考虑Office-Home和miniddomainnet数据集来构建基准。

•Office-Home包含来自四个任务的图像:艺术,剪贴画,产品和现实世界。每个任务涵盖了在办公室和家庭设置下收集的65个对象类别的图像。总共大约有15500张图片。

•MiniDomainnet采用DomainNet的一个子集,这是一个极具挑战性的多任务学习数据集。MiniDomainnet有14万张图片,分布在126个类别中。它包含四个不同的任务:剪贴画,绘画,素描和真实。

基于前人的研究,作者从Office-Home中随机选择10%(每类6样本)和20%(每类12样本)进行训练,从MiniDomainNet中随机选择1%(每类3样本)和2%(每类6样本)进行训练。剩下的样本留作测试用。

4.2 实验结果

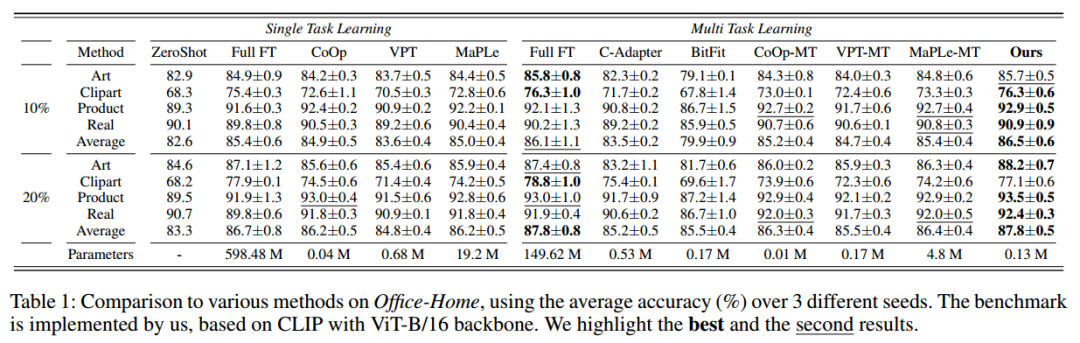

Office-Home数据集

结果如上表所示。首先,作者观察到所提出的方法与跨不同数据分割(10%或20%)的多任务完全微调相当,而只需要0.09% (0.13M vs. 149.62M)的可训练参数。这代表了在多任务图像识别的CLIP参数高效微调方面的重大突破。其次,所提出的方法始终优于其他参数高效调优方法。与提示方法(即MaPLe-MT, CoOp-MT和VPTMT)相比,所提出的方法显示出显着的改进,突出了在调整CLIP时集成视觉和文本模式以及将组共享知识和任务特定知识相结合的必要性。在可训练参数的数量方面,所提出的方法仅次于CoOp-MT,在准确率和可训练参数之间取得了最好的平衡。第三,作者还发现提示方法优于CLIPAdapter和BitFit,表明将下游数据与CLIP对齐是一种更有效的方法。

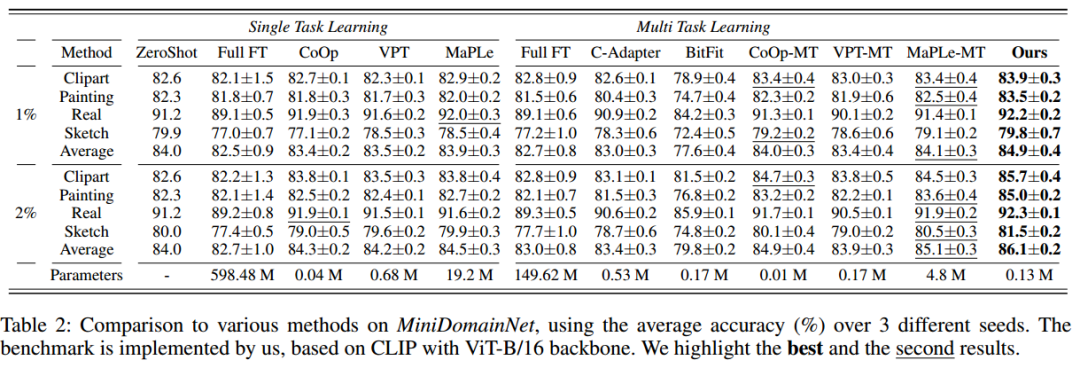

MiniDomainNet数据集

结果如上表所示。可以得出与Office-Home一致的结论。本文方法表现最好,在1%分割上达到84.9%,在2%分割上达到86.1%。然而,作者观察到Full Fine-Tuning的性能不是很令人满意,并且比大多数参数有效的调谐方法更差,这是由过拟合引起的。具体来说,MiniDomainnet的任务难度比Office-Home明显增加,同时训练数据数量有限。此外,BitFit方法表现出最差的性能。它使用少量数据更新CLIP的少量参数,严重损害了CLIP原有的zero-shot能力。CoOp-MT、VPT-MT和MaPLe-MT的效果在1%的分割上只能接近zero-shot,但当训练数据量达到2%时,CoOp-MT和MaPLeMT的效果分别超过zero-shot0.9%和1.1%。因此,为了探索不同训练数据规模下的性能,作者设置了相关实验,详见消融。

4.3 消融实验

在本节中,作者构建了各种消融实验来进一步分析提出的MmAP和多任务提示学习框架。同时,作者还针对不同的下游数据量设计了相关实验。

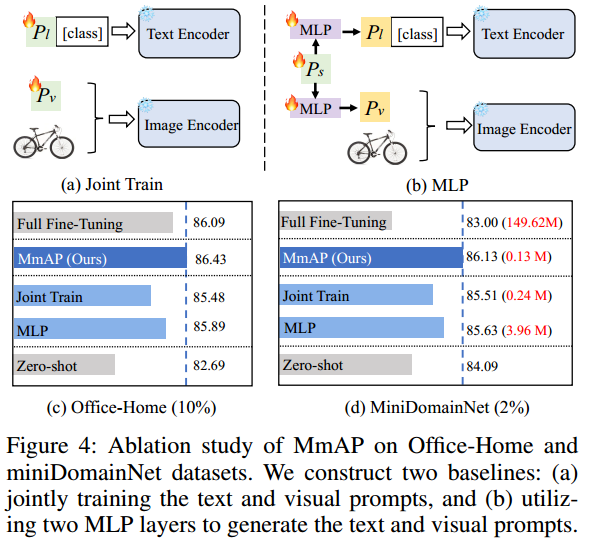

MmAP的有效性 为了验证所提出的MmAP的有效性,作者建立了相关的烧蚀实验。如上图a所示,多模式提示的一种直接方法是联合调优文本和视觉提示。另一个直接的解决方案涉及共享文本和视觉提示。但是CLIP的Text Encoder和Image Encoder的尺寸不相等,不能直接共享。因此,作者设计了MLP提示基线作为另一种比较方案,该方案采用两个MLP层来生成文本和视觉提示,如上图4b所示。结果如上图4c所示。在Office-Home的四个任务中,与联合训练基线相比,MLP基线显示出0.5%的改善,证明了在文本提示和视觉提示之间建立联系的有效性。此外,作者观察到,与MLP基线相比,MmAP实现了0.54%的改进,这表明MmAP方法在通过克罗内克积最大化文本和视觉提示之间的信息共享方面更有效。同时,相对于MLP基线,MmAP可训练参数大大减少(0.13M vs. 3.96M)。

为了验证所提出的MmAP的有效性,作者建立了相关的烧蚀实验。如上图a所示,多模式提示的一种直接方法是联合调优文本和视觉提示。另一个直接的解决方案涉及共享文本和视觉提示。但是CLIP的Text Encoder和Image Encoder的尺寸不相等,不能直接共享。因此,作者设计了MLP提示基线作为另一种比较方案,该方案采用两个MLP层来生成文本和视觉提示,如上图4b所示。结果如上图4c所示。在Office-Home的四个任务中,与联合训练基线相比,MLP基线显示出0.5%的改善,证明了在文本提示和视觉提示之间建立联系的有效性。此外,作者观察到,与MLP基线相比,MmAP实现了0.54%的改进,这表明MmAP方法在通过克罗内克积最大化文本和视觉提示之间的信息共享方面更有效。同时,相对于MLP基线,MmAP可训练参数大大减少(0.13M vs. 3.96M)。

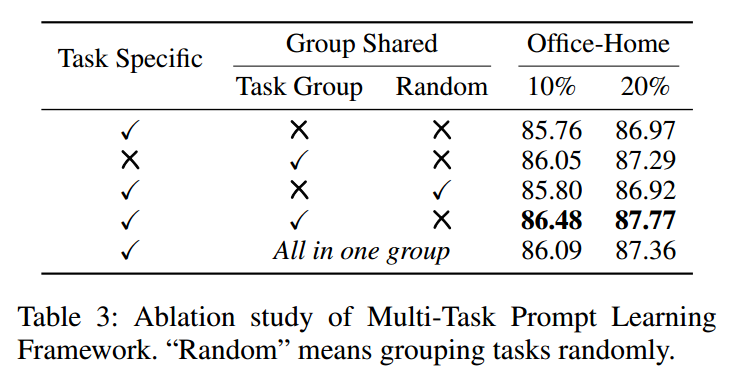

多任务提示学习框架的有效性

在多任务提示学习框架中,任务特定的MmAP和组共享的MmAP是主要组成部分。为了验证各个模块的重要性,作者对Office-Home进行了相关的烧蚀实验,结果如上表所示。为了验证任务分组策略的有效性,作者将随机分组作为比较的基准。实证结果表明,本文的框架中的每个模块都起着关键作用,累积有助于多任务提示学习框架取得优异的表现。与随机分组相比,作者的任务分组在10%和20%的设置下分别提高了0.68%和0.85%。与同一组中的所有任务相比,作者的任务组在10%和20%的设置下的执行效率分别高出0.39%和0.41%。从另一个角度来看,特定任务的MmAP优于CoOp和VPT(结果见表1),进一步证明了MmAP的有效性。

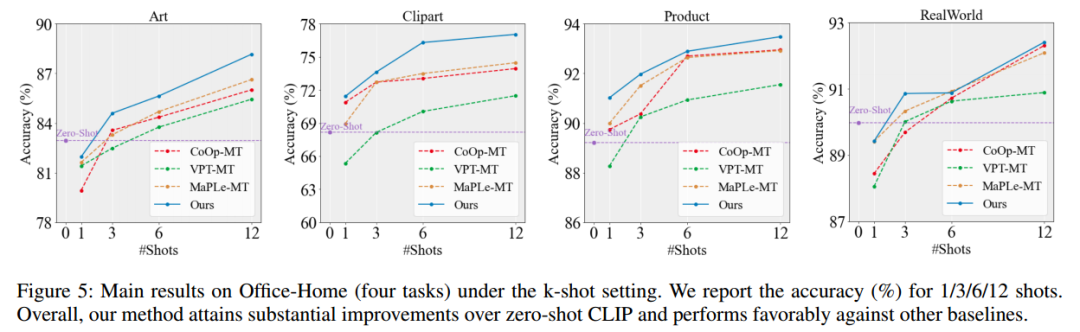

不同的下游数据大小

作者检验了训练数据大小对Office-Home(四项任务)的影响。作者在每个班选择1/3/6/12个shot,并将MmAP与CoOp-MT, VPT-MT和MaPLe-MT进行比较。各任务和方法在不同训练数据尺度下的结果如上图所示。结果表明,本文方法在跨数据尺度的四个任务上优于所有其他基线,证实了本文的方法具有很强的泛化性。然而,作者观察到,在art和realworld任务的1次shot设置中,所有方法的表现都不如Zero-Shot。这可能是由于1个shot太具体了,不能作为整个任务的一般代表。当提供3次或更多的shot进行训练时,本文方法带来的平均表现差距是实质性的。

5 总结

在这项工作中,作者提出了用于使CLIP适应下游任务的多模态对齐提示(MmAP),与大多数现有方法相比,它在可训练参数和性能之间实现了最佳权衡。同时,MmAP解决了先前单模态提示方法(如CoOp和VPT)干扰CLIP模态对齐的问题。在MmAP的基础上,作者设计了一个多任务提示学习框架,该框架不仅可以将相似的任务训练在一起,增强任务的互补性,而且可以保持每个任务的独立性。与在有限的下游数据下对两个大型多任务学习数据集进行完全微调相比,本文方法实现了显着的性能改进,同时仅利用~ 0.09%的可训练参数。

6 论文地址

论文:https://arxiv.org/pdf/2312.08636.pdf

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง