衡宇 丰色 发自 凹非寺

量子位 | 公众号 QbitAI

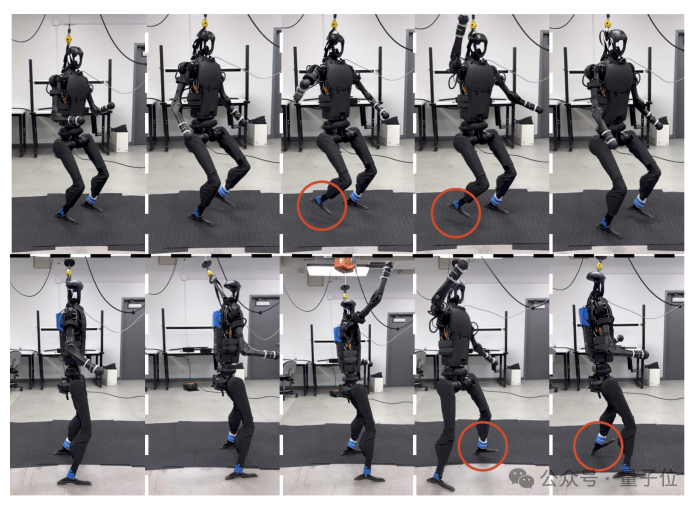

注意看,小帅一个转身,卫衣帽子里面居然 空 无 一 头:

好啦,这不是惊悚恐怖片,而是来自UCSD(加州大学圣地亚哥分校)全华人团队的最新研究成果。

他们提出一种特别的全身控制策略(ExBody),能对人形机器人进行全身控制。策略主要训练人形机器人上半身,下半身则专注于负责维持稳定。

这样训练出来的人形机器人,能实现稳健的运动和动态运动跟踪。

简而言之,会的活多,表现力还强。

比如和人类边贴贴边跳舞,增进增进人形机器人和人类之间的感情:

穿着荧光小马甲,就能立刻上岗街头指挥人车交通:

研究论文资料显示,这个研究团队共6人,其中过半是UCSD的在读博士生。

为什么要对人形机器人做这样的训练呢?论文共同一作Xuxin Cheng在推特上卖力宣传的同时,做出了解释。

机器人总是被要求化身各行各业的打工人!我们就想跟它一起探索另一条方向的路~

当人形机器人“富有表现力”

团队的这项研究名为《Expressive Whole-Body Control for Humanoid Robots》,研究目标是让人形机器人在现实世界中产生丰富、多样和富有表现力的动作。

在经过团队的调教后,人形机器人能做出什么样的行为呢?

路遇朋友迎面击掌,这是不在话下的。

我都能脑补出它大声喊了一句Hey Man……

亲切一点,路遇兄弟,来个抱抱:

有点搞笑的事,不管是击掌还是拥抱,机器人下半身跺脚的行为并不会停止,只是会稍微放缓。

眼尖的朋友们可能已经发现了,上面的击掌实验在不同环境、不同地面进行。

团队也明确表示,通过新研究训练出来的人形机器人,可以在各种不同的地形地面上健步如飞。

除了上文展示过的草地和石板路,沙滩对它来说同样是小菜一碟:

平整的办公室地面也可以轻松应对:

团队给出的更多展示中,还表现了更多遇到外界阻力时行动自如的demo。

狠狠拽它:

拿大球砸它:

还知道抬手示意,“喂,你可以帮我背上小书包了”。

各种操作,看得大伙儿一愣一愣的。

纽约大学计算机科学助理教授发推特应援,称这么高水平控制力和表现力的研究成果,居然是一个6人组成的学术团队的产出,“难以置信”!

更多的网友则选择用“Cool”来形容这项工作:

“无他,照着人类学”

所以,究竟怎么才能让机器人像以上般“张牙舞爪”、富有类人表现力?

设想的思路无他:照着人类学。

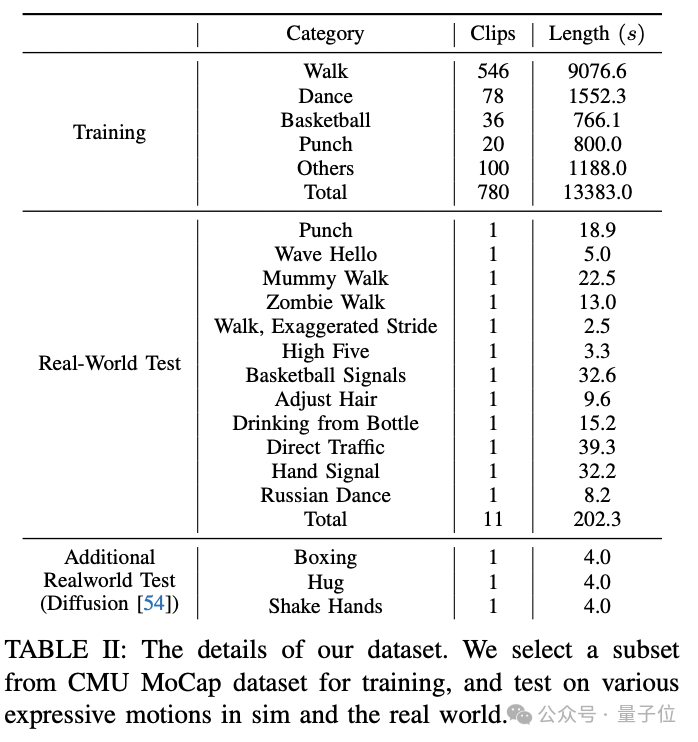

学习资料既包括各种人体动捕数据集,也包括生成模型、video2pose模型给出的模拟数据。

通过在强化学习框架中进行全身控制的大规模训练,机器人就可以在现实世界中进行动作的泛化了。

然而,这样的Sim2Real思想实际还是遇到了问题。

作者介绍,典型数据集中的人体模型有69个自由度,但他们所用的机器人只有19个。

除此之外,理论和实际的扭矩限制也不相同。

这就很尴尬了,等于学会的知识实际根本不能拿来就用。

那怎么办?

那就做一个小小的改动:

只让上半身进行模仿,负责各种表现力,下半身则只负责在任意速度内把两条腿控制稳定就行。

作者姑且就管这个方法就叫做“表现型全身控制”(Expressive Whole-Body Control (Exbody))。

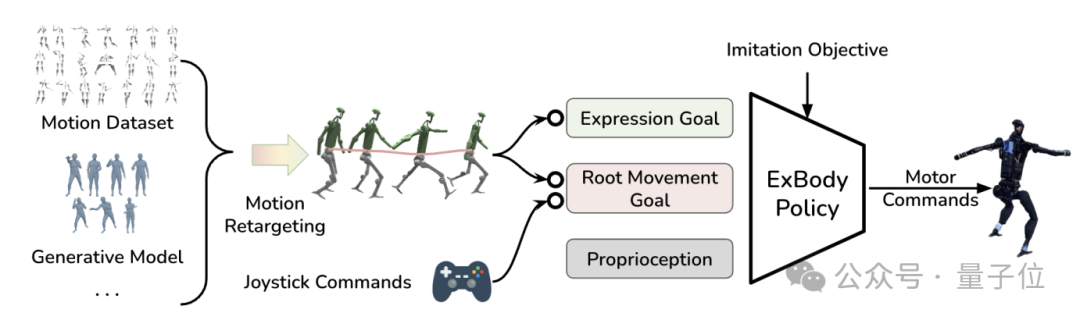

由此,该机器人的整体框架就长这样:

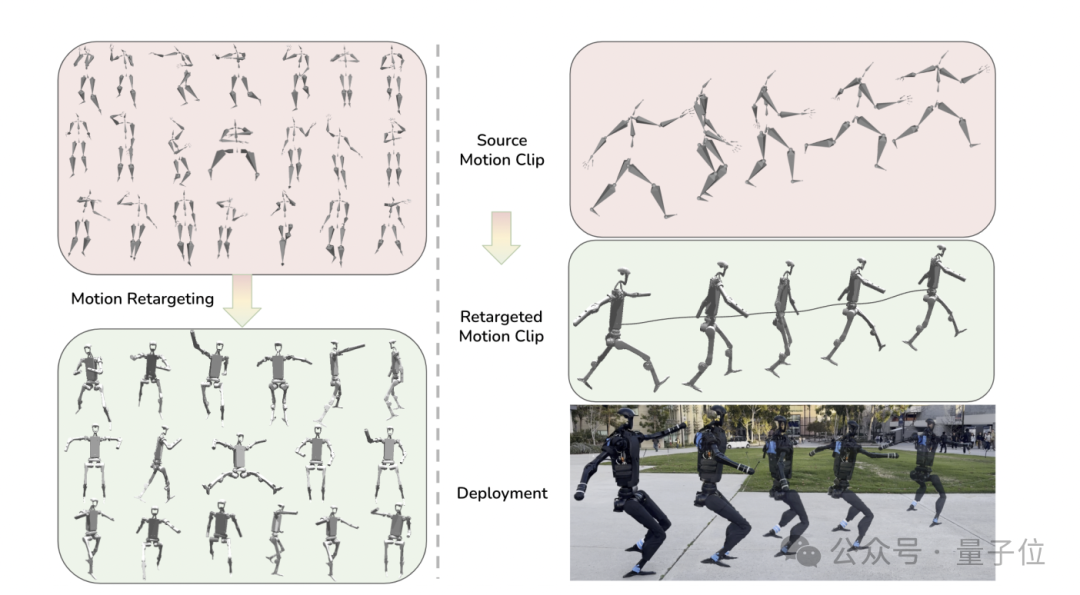

首先,在拿到各种数据集后,系统会有一个运动重定向,用于获取一系列与符合机器人运动学结构的运动片段。

然后在从这些片段中提取表达目标和根运动目标,进行“Exbody”策略的强化学习训练,最终将指令部署到真实机器人身上。

其中,表达目标就是机器人上半身要完成的,根运动目标则归于下半身(当然,这部分也可以用遥控命令直接给出)。

△ 所用数据集

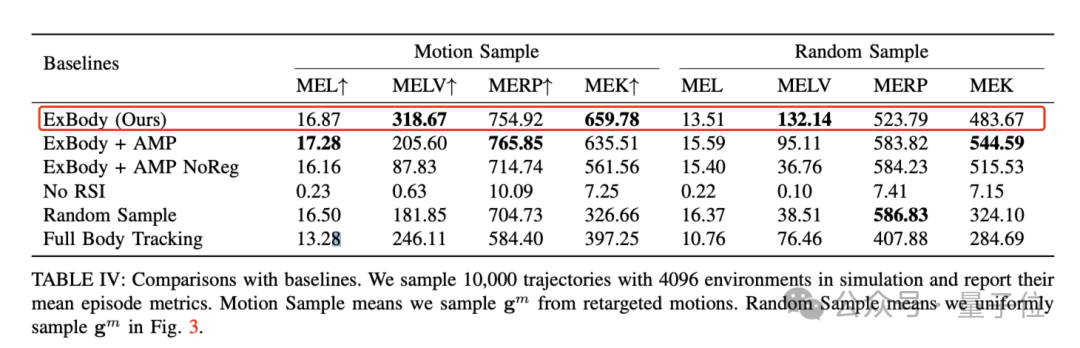

最终,和各种基线方法相比,该机器人取得了如下成绩:

有几项比较突出的指标,整体表现还不错。

(MELV:Mean Episode Linear Velocity Tracking Reward,线性速度跟踪奖励 MEK:Mean episode key body tracking reward,关键身体追踪奖励)

而从下图来看,Exbody的策略也能让机器人在表现时(例如击掌)膝盖弯曲更多,抬脚时脚离地面更高。言外之意,动作更卖力更富有表现力一些~当然,也更稳。

全华人团队出品

本研究一共6位作者,全部为华人,全部来自加州大学圣地亚哥分校(UCSD)。

共同一作有两位:

-

Xuxin Cheng,UCSD博一在读,硕士毕业于CMU机器人专业,本科则毕业于北理工自动化专业。

-

Yandong Ji,同UCSD博一在读,硕士毕业于UC伯克利机械工程,本科毕业于南开大学电子计算机工程专业。

通讯作者为他们的导师Xiaolong Wang,UCSD电气工程系助理教授。

他博士毕业于CMU,目前的研究方向集中于CV和机器人技术等等,谷歌学术显示论文引用次数23000+。

哦对了最后,团队成员还包括本次研究所用的机器人 :来自宇树科技的Unitree H1。

:来自宇树科技的Unitree H1。

One More Thing

要说最近的机器人进展,还真不少。

先是OpenAI和微软押注的Figure刚刚宣布,新一轮融资筹集了约6.75亿美元,融资前估值约20亿美元。

紧接着发布了个视频,介绍了旗下人形机器人Figure 01的最新进展,称“一切都是自主的”:

再有就是那个面部表情极其丰富,有时惊艳有时又惊悚的Ameca,最新宣布已具有视觉能力。

她能观察所处房间的整个情况,然后用各种各样的声音语气(包括但不限于马斯克、海绵宝宝)跟你绘声绘色地描述。

就怪有意思的hhhhhh

参考链接:

[1]https://expressive-humanoid.github.io/resources/Expressive_Whole-Body_Control_for_Humanoid_Robots.pdf

[2]https://expressive-humanoid.github.io/

[3]https://twitter.com/xiaolonw/status/1762528106001379369

— 完 —

报名中!

量子位正在评选2024年最值得关注的AIGC企业、 2024年最值得期待的AIGC产品两类奖项,欢迎报名评选!

评选报名截至2024年3月31日

中国AIGC产业峰会同步火热筹备中,了解更多请戳:在这里,看见生成式AI的应用未来!中国AIGC产业峰会来啦!

商务合作请联络微信:18600164356 徐峰

活动合作请联络微信:18801103170 王琳玉

点这里👇关注我,记得标星噢

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见 ~

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง