本周值得关注的大模型 / AIGC 前沿研究

- Sora综述:背景、技术、局限性和机遇

- 清华、央音、微软亚研院:Byte模型是数字世界的模拟器

- 清华、微软提出Learning Law:语言模型的最优学习

- 清华新研究:让大模型参与城市规划

- 清华团队RepoAgent:由大模型驱动,主动生成、维护和更新代码文档

- ToMBench:清华团队领衔提出大模型心智理论基准测试

- Google DeepMind:视频是现实世界决策的新语言

- Google DeepMind:大模型能做多跳推理吗?

- Google DeepMind:基础世界模型Genie

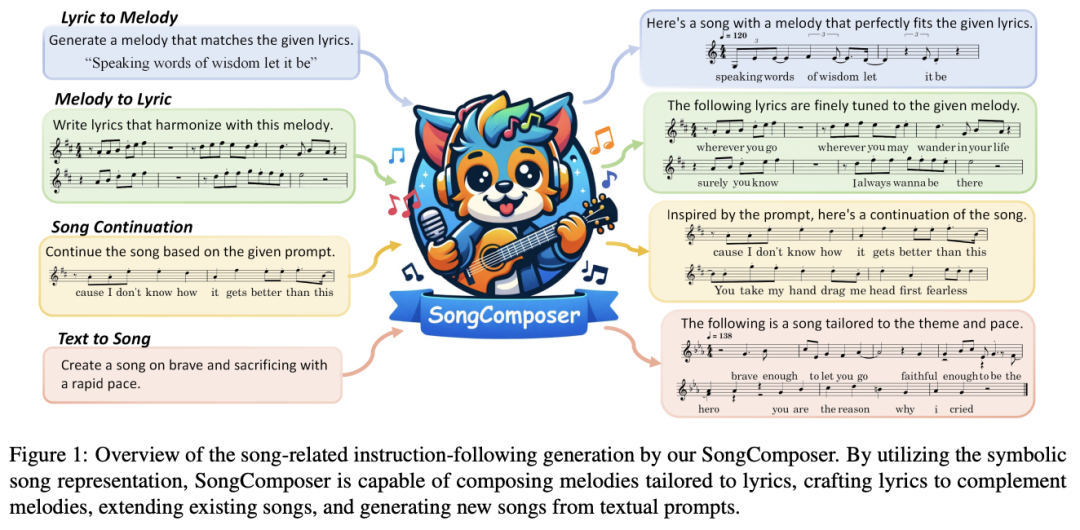

- SongComposer:让大模型像人类一样创作歌曲

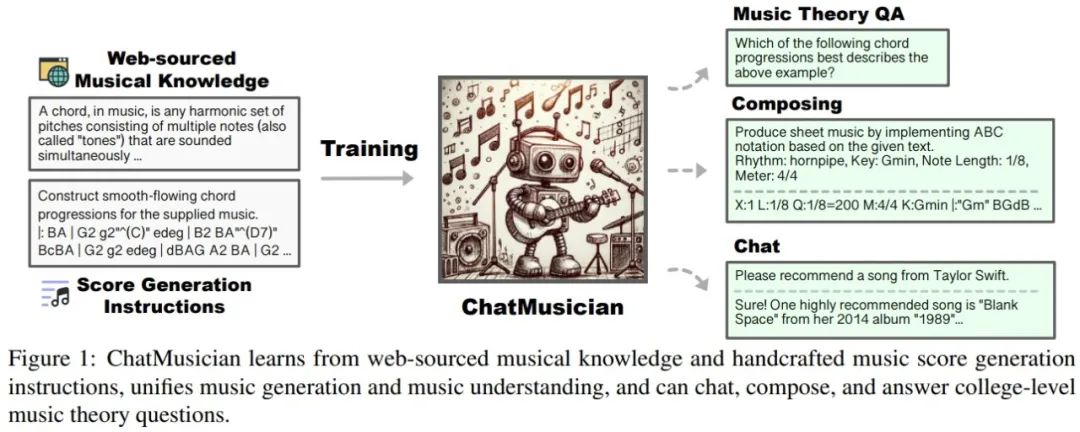

- ChatMusician:使用大模型理解和生成音乐

- 阿里EMO:从音频生成富有表现力的肖像视频

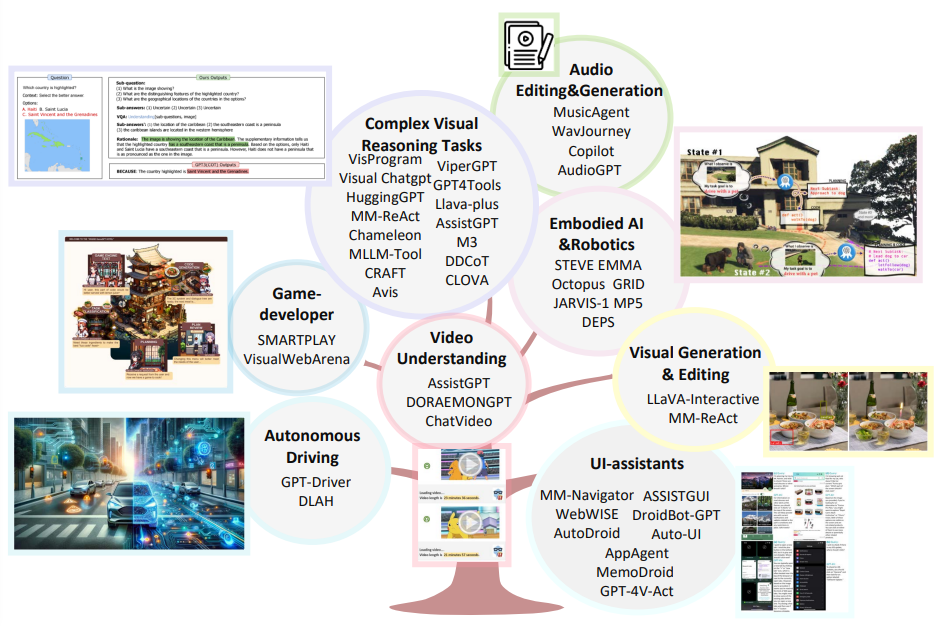

- 最新综述:大型多模态智能体

- 苹果新研究:提高大模型推理效率

- 微软研究院:在小学数学中挖掘小模型潜力

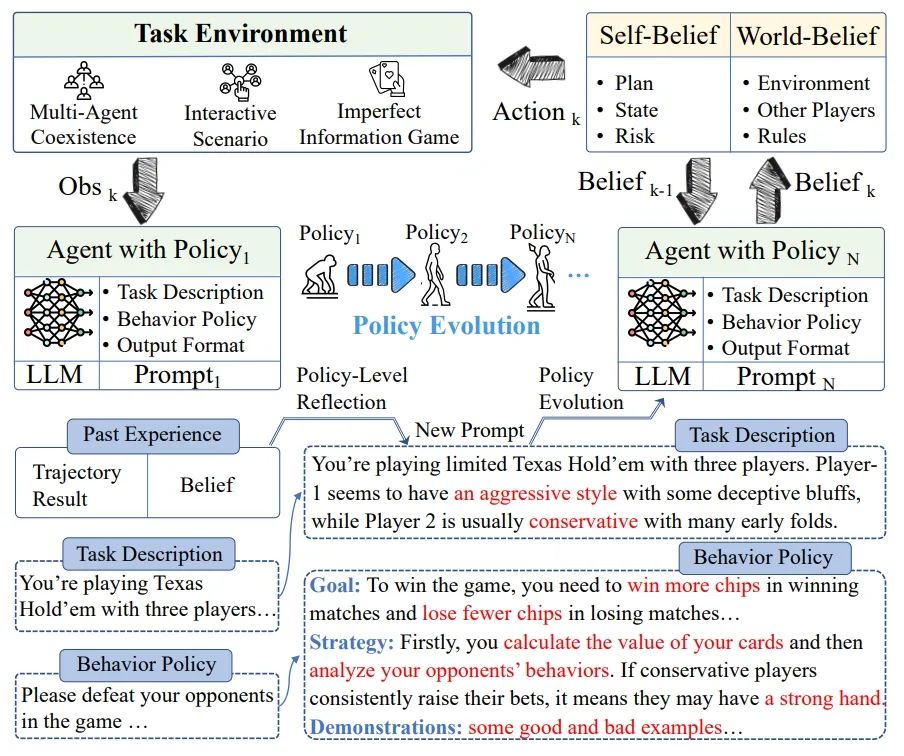

- Agent-Pro:在学习中不断进化的智能体

- FinAgent:首个金融交易多模态基础智能体

- Sum2Act:利用开放世界API增强大模型

- MobiLlama:实现准确、轻量级的全透明 GPT

- MobileLLM:针对端侧使用案例优化次十亿参数语言模型

1.Sora综述:背景、技术、局限性和机遇

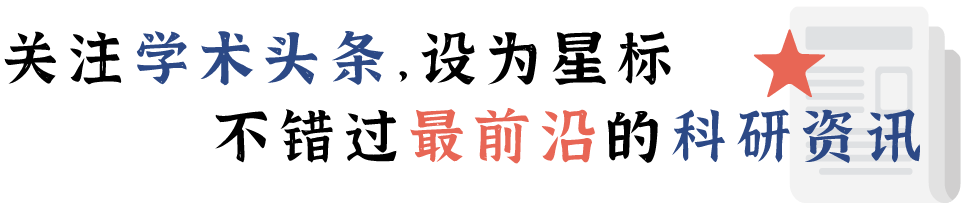

Sora 是 OpenAI 于今年 2 月发布的文生视频人工智能(AI)模型。经过训练,Sora 能根据文字说明生成逼真或富有想象力的场景视频,并显示出了模拟物理世界的潜力。

在这篇论文中,来自理海大学和微软研究院的研究团队以公开技术报告和逆向工程为基础,全面回顾了 Sora 的背景、相关技术、应用、尚存挑战以及文生视频 AI 模型的未来发展方向。

研究团队首先追溯了 Sora 的发展历程,并研究了用于构建这一“世界模拟器”的底层技术。然后,他们详细介绍了 Sora 在从电影制作、教育到市场营销等多个行业中的应用和潜在影响。研究团队讨论了广泛部署 Sora 所面临的主要挑战和限制,如确保安全和无偏见的视频生成。最后,他们讨论了 Sora 和其他视频生成模型的未来发展,以及该领域的进步如何实现新的人机交互方式,提高视频生成的生产力和创造力。

论文链接:

https://arxiv.org/abs/2402.17177

2.清华、央音、微软亚研院:Byte模型是数字世界的模拟器

来自微软亚洲研究院、中央音乐学院和清华大学的研究团队及其合作者提出了一个用于模拟数字世界、具有下一个字节预测功能的模型——bGPT。bGPT 在文本、音频和图像等各种模态下的性能与专业模型不相上下,在模拟 CPU 行为方面也表现出非凡的能力,执行各种操作的准确率超过 99.99%。

论文链接:

https://arxiv.org/abs/2402.19155

3.清华、微软提出Learning Law:语言模型的最优学习

为减少必要的训练步骤、实现卓越的性能,来自清华大学和微软研究院的研究团队探索了改进语言模型(LMs)学习的一般原则。研究团队通过实证验证了 LMs 的最优学习本质上源于 LMs scaling law 中系数的改进,这为设计实用的学习加速方法带来了巨大的希望和意义。

论文链接:

https://arxiv.org/abs/2402.17759

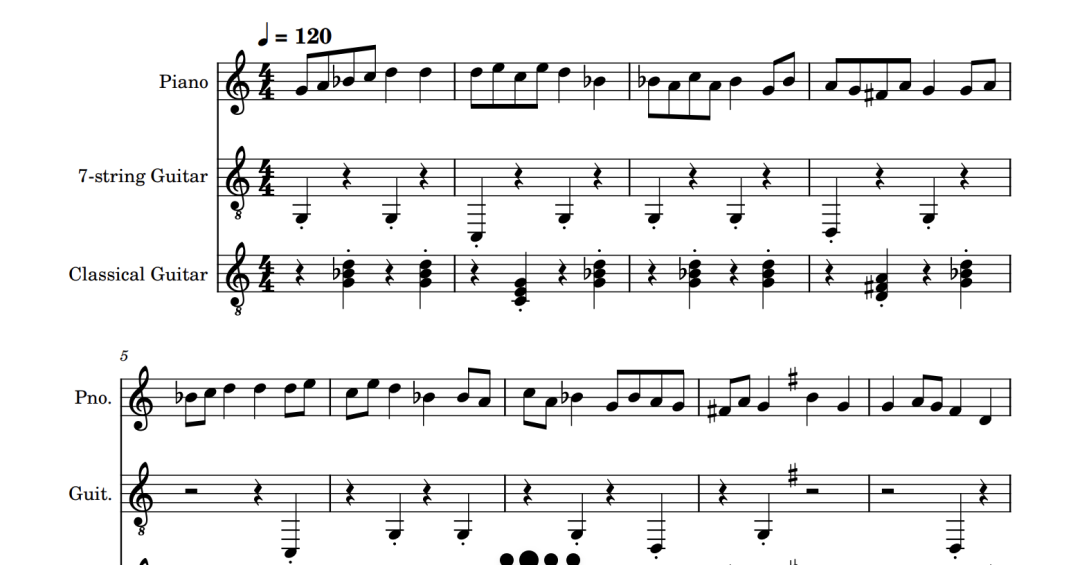

4.清华新研究:让大模型参与城市规划

清华团队为参与式城市规划设计了一个基于大模型的多智能体协作框架,该框架可以考虑居民的不同需求,为城市地区生成土地利用规划。他们在北京的两个实际区域部署了这一方法。实验表明,该方法在居民满意度和包容性指标方面达到了最先进的水平,在服务可达性和生态指标方面也优于人类专家。

图|参与式规划方法框架

论文链接:

https://arxiv.org/abs/2402.17161

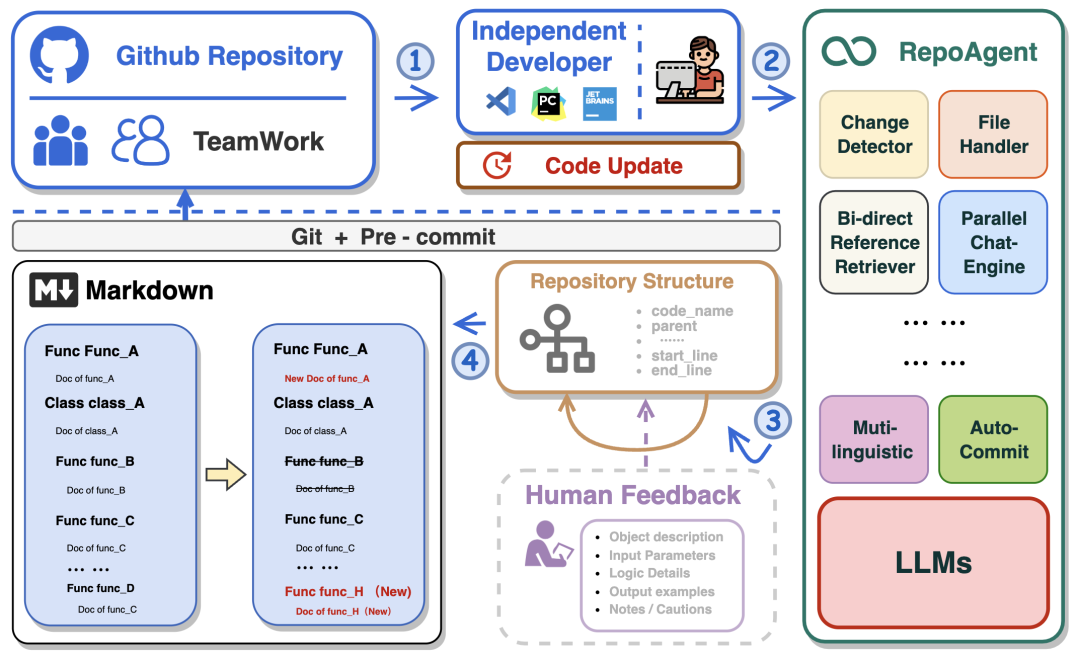

5.清华团队RepoAgent:由大模型驱动,主动生成、维护和更新代码文档

为了主动生成、维护和更新代码文档,来自清华大学、中国人民大学和西门子公司的研究团队提出了一个由大型语言模型驱动的开源框架——RepoAgent。实验表明,RepoAgent 在生成高质量的资源库级文档方面表现出色。

论文链接:

https://arxiv.org/abs/2402.16667

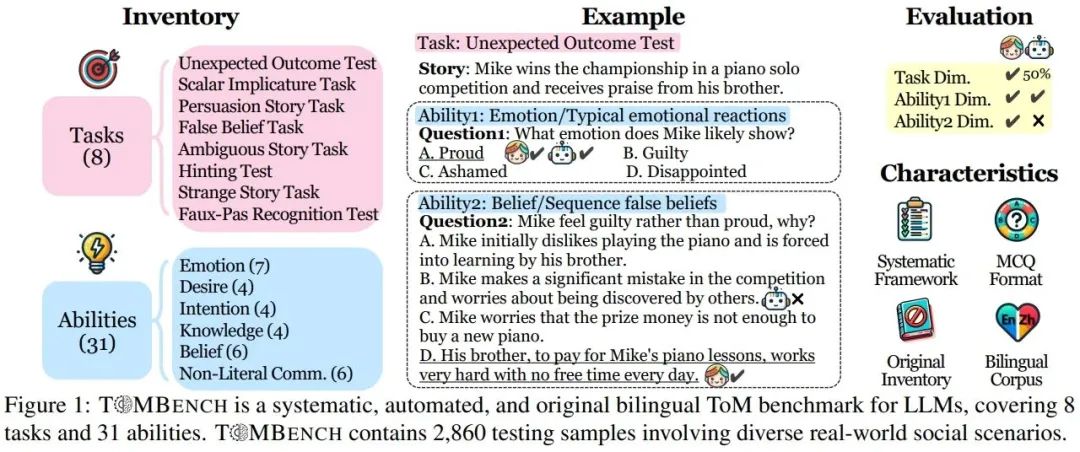

6.ToMBench:清华团队领衔提出大模型心智理论基准测试

Theory of Mind(ToM)是一种能够感知并将心理状态归因于自己和他人的认知能力。最近的研究引发了一场关于大型语言模型(LLMs)是否表现出一种 ToM 形式的争论。来自清华大学的研究团队及其合作者推出了 ToMBench。ToMBench 用于高效评估大型语言模型的 ToM 能力,从而促进具有内在社会智能的 LLM 的开发。

论文链接:

https://arxiv.org/abs/2402.15052

7.Google DeepMind:视频是现实世界决策的新语言

来自 Google DeepMind、加州大学伯克利分校和麻省理工学院的研究团队讨论了扩展视频生成功能来解决现实世界中的任务。他们展示了视频生成如何像语言模型一样,通过上下文学习、规划和强化学习等技术充当规划者、智能体、计算引擎和环境模拟器。(点击查看详情)

论文链接:

https://arxiv.org/abs/2402.17139

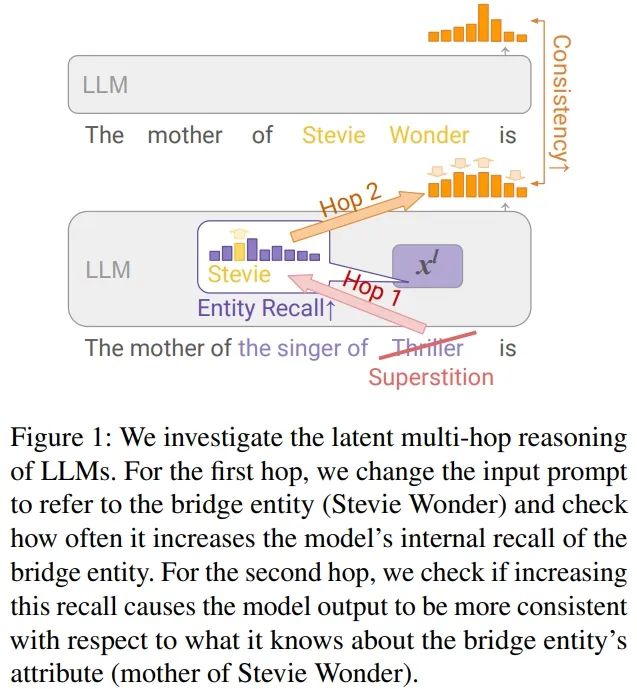

8.Google DeepMind:大模型能做多跳推理吗?

来自 Google DeepMind、伦敦大学学院、Google Research 和特拉维夫大学的研究团队探讨了大型语言模型(LLMs)是否能够对复杂的提示执行多跳推理,如“The mother of the singer of ‘Superstition’ is”。在某些关系类型的提示中,他们发现了潜在多跳推理的有力证据,80% 以上的提示都使用了推理路径。

论文链接:

https://arxiv.org/abs/2402.16837

9.Google DeepMind:基础世界模型Genie

来自 Google DeepMind 的研究团队提出了首个以无监督方式从未经标注的互联网视频中训练出来的生成交互环境模型——Genie。该模型可以通过文本、合成图像、照片甚至草图来生成无穷无尽的动作可控的虚拟世界。(点击查看详情)

论文链接:

https://arxiv.org/abs/2402.15391

10.SongComposer:让大模型像人类一样创作歌曲

来自香港中文大学、北京航空航天大学和上海人工智能实验室的研究团队提出了一款专为歌曲创作而设计的大型语言模型(LLMs)——SongComposer。据介绍,SongComposer 在歌词到旋律的生成、旋律到歌词的生成、歌曲续写和文本到歌曲的创作方面表现出卓越的性能,超过了 GPT-4 等先进的 LLMs。

论文链接:

https://arxiv.org/abs/2402.17645

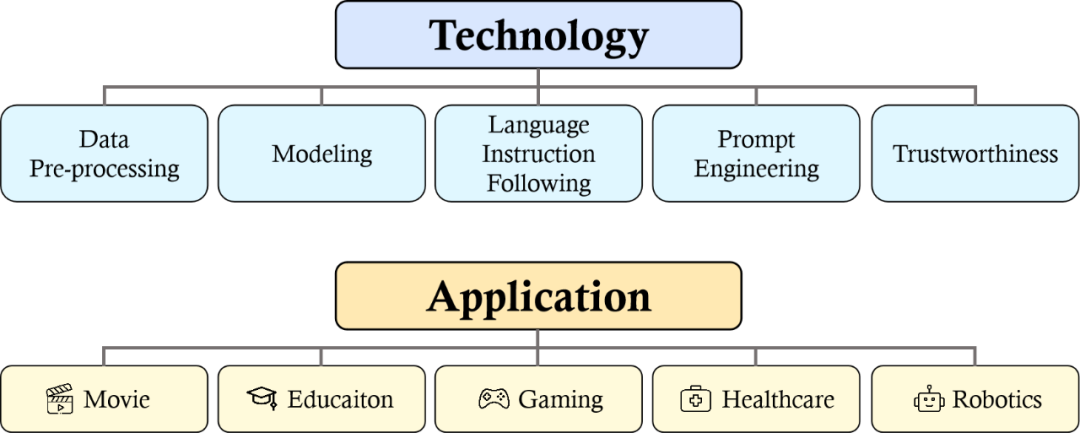

11.ChatMusician:使用大模型理解和生成音乐

来自 Multimodal Art Projection Research Community、Skywork 和香港科技大学的研究团队提出了一个集成了内在音乐能力的开源大型语言模型(LLMs)——ChatMusician。ChatMusician 能够以文本、和弦、旋律、主题、音乐形式等为条件,创作出结构良好的完整音乐,超过了 GPT-4 基线。

论文链接:

https://arxiv.org/abs/2402.16153

12.阿里EMO:从音频生成富有表现力的肖像视频

阿里巴巴团队提出了 EMO 框架,它采用直接从音频到视频的合成方法,能够产生极富表现力且栩栩如生的动画。EMO 不仅能生成令人信服的说话视频,还能生成各种风格的唱歌视频,在表现力和逼真度方面明显优于现有的最先进方法。

论文链接:

https://arxiv.org/abs/2402.17485

13.最新综述:大型多模态智能体

来自香港中文大学(深圳)、深圳市大数据研究院和中山大学的研究团队对 LLM 驱动的多模态智能体,即大型多模态智能体(LMAs)进行了系统回顾。研究团队建立了一个综合的 LAMs 评估框架用于使评估标准化,以便进行更有意义的比较。

论文链接:

https://arxiv.org/abs/2402.15116

14.苹果新研究:提高大模型推理效率

最近的研究表明,如果鼓励大型语言模型(LLMs)先解决主要任务的子任务,它们就能更好地解决推理任务。来自密西根大学和苹果公司的研究团队设计了一种类似的策略,将推理任务分解为问题分解阶段和问题解决阶段,并证明该策略优于单阶段解决方案。

论文链接:

https://arxiv.org/abs/2402.15000

15.微软研究院:在小学数学中挖掘小模型潜力

对于小型语言模型(SLMs)来说,解决数学词语问题一直被认为是一项复杂的任务。最近的一项研究假设,要在 GSM8K 基准上达到 80% 以上的准确率,最小的模型大小需要 340 亿个参数。来自微软公司的研究团队提出了一个基于 Mistral-7B 的 70 亿参数 SLM——Orca-Math,无需多次调用模型,也无需使用验证器、代码执行或任何其他外部工具,在 GSM8k 上实现了 86.81% 的准确率。

论文链接:

https://arxiv.org/abs/2402.14830

16.Agent-Pro:在学习中不断进化的智能体

来自中科院、南京邮电大学、南京信息工程大学、北京工业大学和国科大南京学院的研究团队提出了一个基于大型语言模型(LLMs)的、具有策略级反思和优化功能的智能体——Agent-Pro,它可以从交互体验中学习丰富的专业知识,并逐步提升其行为策略。

论文链接:

https://arxiv.org/abs/2402.17574

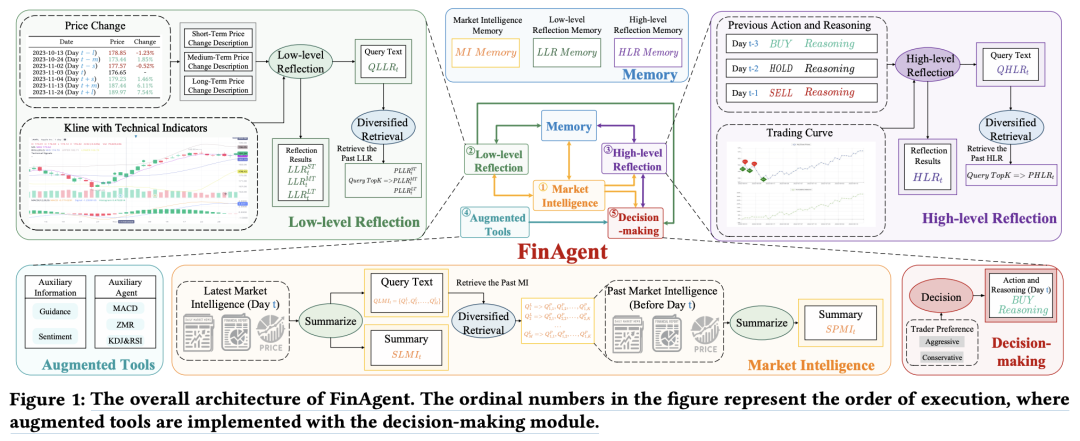

17.FinAgent:首个金融交易多模态基础智能体

来自南洋理工大学和浙江大学的研究团队推出了首个具有金融交易工具增强功能的多模态基础智能体——FinAgent。FinAgent 在 6 个金融指标方面明显优于 9 个最先进的基线,平均收益提高了 36% 以上。特别是在一个数据集上实现了 92.27% 的回报率(相对改进 84.39%)。

图|FinAgent 架构

论文链接:

https://arxiv.org/abs/2402.18485

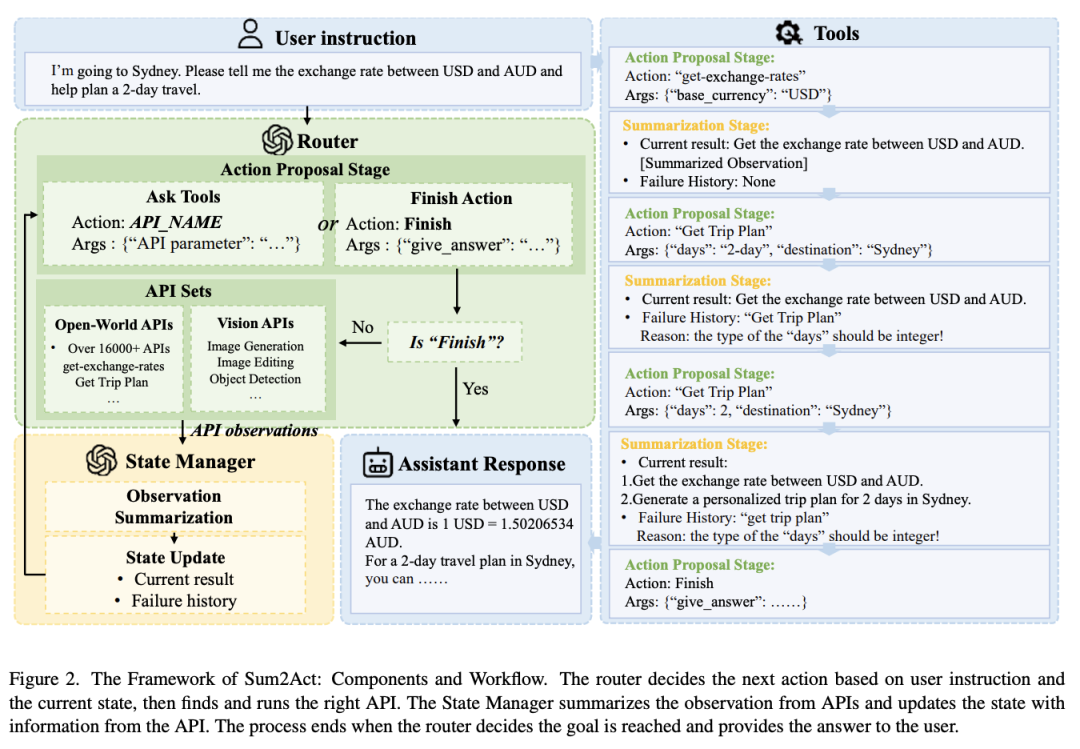

18.Sum2Act:利用开放世界API增强大模型

来自西安交通大学、复旦大学和华为诺亚方舟实验室的研究团队提出了一种新颖的工具调用 pipeline——from Summary to action(Sum2Act),旨在控制大规模的真实世界 API。实验证明了 Sum2Act 在增强 LLMs 以完成复杂的实际任务方面的有效性。

图|Sum2Act架构图

论文链接:

https://arxiv.org/abs/2402.18157

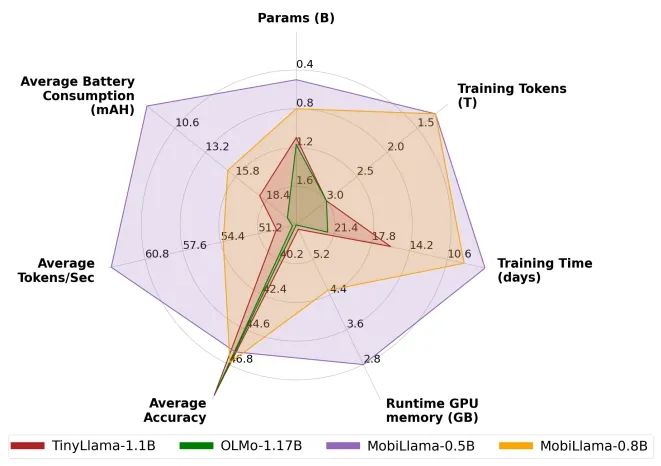

19.MobiLlama:实现准确、轻量级的全透明 GPT

来自阿联酋人工智能大学、澳大利亚国立大学、阿尔托大学、墨尔本大学和林雪平大学的研究团队在其研究中探讨了“less is more”的范式,解决了为资源有限的设备设计精确高效的小型语言模型(SLMs)的难题。

论文链接:

https://arxiv.org/abs/2402.16840

20.MobileLLM:针对端侧使用案例优化次十亿参数语言模型

来自 Meta公司和 PyTorch 的研究团队专注于设计参数少于十亿的高质量 LLMs,这是移动部署的实用选择。MobileLLM 模型系列在聊天基准测试中与之前的十亿以下规模模型相比有了显著提高,在 API 调用任务中与 LLaMA-v2 7B 的正确性接近,凸显了小型模型在常见设备使用案例中的能力。

论文链接:

https://arxiv.org/abs/2402.14905

|点击关注我 👇 记得标星|

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง