新智元报道

编辑:LRS 好困

【新智元导读】研究人员证实了Visual Graph在图推理中的作用,以及其可以和文本模态相互增强。

图神经网络(GNNs)擅长利用图的结构信息进行推理,但它们通常需要特定于领域的调优才能达到峰值性能,这阻碍了它们在不同任务之间的泛化性。

相比之下,基于大型语言模型(LLM)的图推理具有更强的跨任务和泛化能力,但它们在特定任务上的性能往往逊色于专用的图神经网络模型。

无论是以图神经网络为代表的传统图推理还是新兴的基于大型语言模型的图推理,目前图推理相关工作都忽视了视觉模态的图信息。

然而,人类会通过视觉特征高效和准确地完成图任务,例如判断图中是否存在环。

因此,探究视觉形态的图信息在图推理中的作用具有重要意义。

更具体地,将图(Graph)绘制为图片(Image),是否能赋予模型特殊的推理能力呢?这些图片(称为视觉图 Visual Graph)是否能增强现有的基于其他模态的图推理模型呢?

为了回答这些问题,来自香港科技大学和南方科技大学的研究团队构建了首个包含视觉图的推理问答数据集GITQA,并在GPT-4 turbo,GPT-4V等开源模型和Vicuna,LLaVA等闭源模型上进行了广泛的实验,证实了Visual Graph在图推理中的作用,以及其可以和文本模态相互增强。

论文地址:https://arxiv.org/abs/2402.02130

论文地址:https://arxiv.org/abs/2402.02130

项目主页:https://v-graph.github.io/

在GITQA测试基准中,以LLaVA-7B/13B为基础微调出的多模态模型GITA-7B/13B,展示出了超越GPT-4V的图推理性能。

GITQA 多模态图推理问答数据集

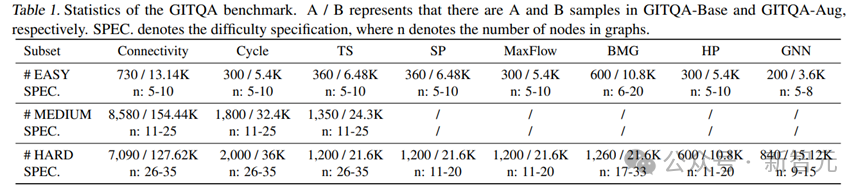

研究团队通过将图结构绘制为不同风格的视觉图像,建立了GITQA数据集及其相应的测试基准,GITQA数据集包含超过423K个问答实例,每个实例包含相互对应的图结构-文本-视觉信息及其相应的问答对。

GITQA数据集包含两个版本:GITQA-Base和GITQA-Aug,其中GITQA-Base只包含单一风格的视觉图。

GITQA-Aug则更加丰富,它对视觉图进行了多种数据增强处理,包括改变布局、点的形状、边的宽度和点的风格等,从而提供了更多样化的视觉图表现。

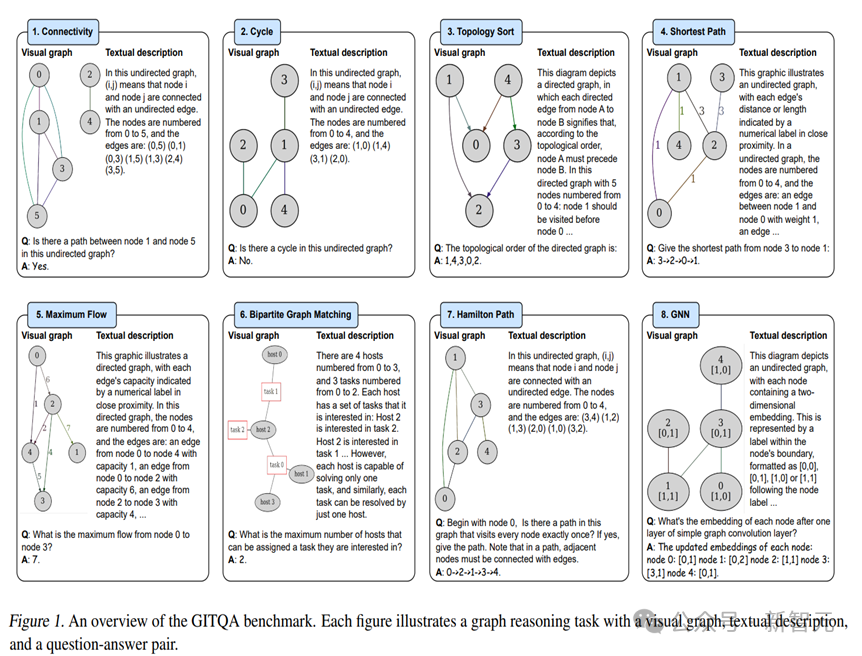

如图1,GITQA测试基准包含8个具有代表性的图推理任务:Connectivity(判断图中两点是否联通)、Cycle(判断图中是否有环)、TS(寻找图的拓扑序)、 SP(寻找图中两点间的最短路径)、 MaxFlow(计算图中两点间的最大流)、 BGM(计算二分图的最大匹配)、 HP(寻找图中的哈密顿路径)和GNN(模拟GNN的消息传递)。

每个任务所对应的数据集都被按照图结构的复杂程度被划分为不同难度等级的子集(相关统计如表1)。

实验及结果

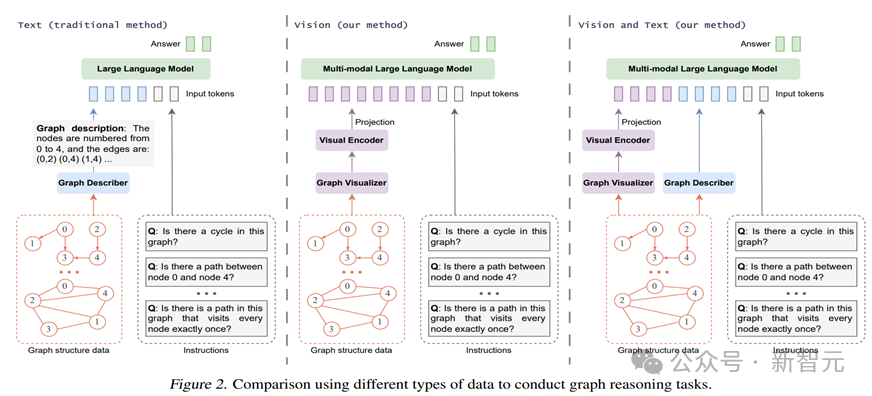

实验一: 基于不同模态图信息的模型的图推理能力对比

研究团队在GITQA-Base数据集上,根据不同的模态图输入类型(包括仅文本(T-Only)、仅视觉(V-Only)、以及文本加视觉(V+T)),评估了流行的闭源和开源大型语言模型(如GPT-4 turbo和Vicuna-7B/13B)以及大型多模态语言模型(如GPT-4V和LLaVA-7B/13B)的表现。如图2所示。

具体来说,闭源模型GPT-4和GPT-4V执行零样本推理,而对于开源模型Vicuna和LLaVA,则通过保持主干模型参数不变,仅训练Projector和LoRA部分进行了微调(特别地,视觉+文本双模态微调后的LLaVA模型被研究者命名为GITA)。

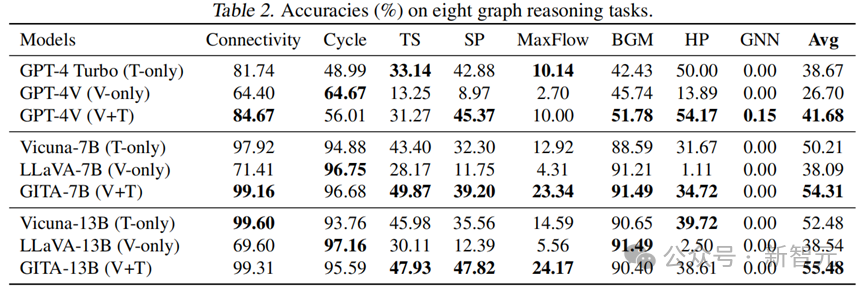

表2总结了所有八项图推理任务的测试结果。

视觉模态 V.S. 文本模态

从表2中可以看到,在Cycle和BGM任务上,视觉模态的表现优于文本模态,而在其他五个任务上则不如文本模态。这揭示了视觉和文本在处理特定类型的图推理任务上各具优势。

视觉和文本模态的相互增强

对于闭源模型,GPT-4V(V+T)在八个任务的平均准确率上远高于GPT-4 Turbo(T-only)和GPT-4V(V-only)。

对于开源模型(7B,13B),同样地,使用双模态数据训练出的GITA模型平均表现最佳。这些观察结果验证了同时使用视觉和文本信息能够增强模型的图推理能力,相比单模态模型可以实现更好的性能。

更具体地说,GITA-7B(V+T)在几乎所有任务中表现优于LLaVA-7B(V-only)和Vicuna-7B(T-only)。而对于闭源模型,使用双模态在八个任务中的五个上达到了最高准确率。

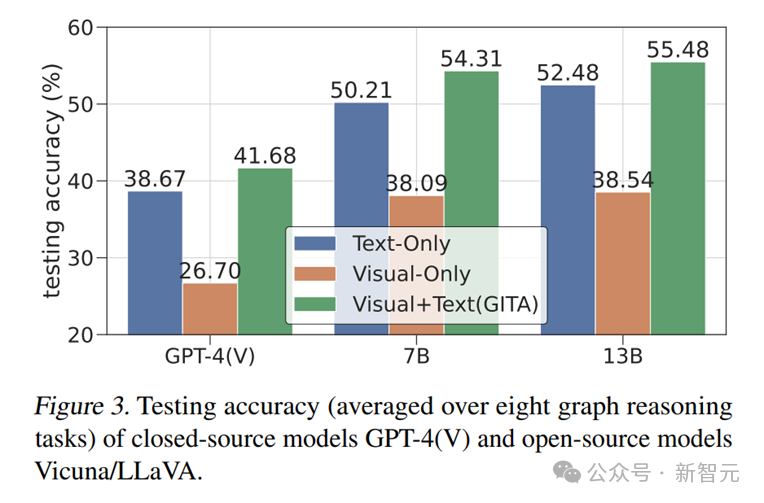

微调后的LLaVA模型可超越GPT-4V

如表2和图3所示,GITA-7B和GITA-13B模型,即经过双模态微调的LLaVA-7B/13B模型,显示出相较于GPT-4V超过13%的显著性能提升。这一巨大的进步幅度表明,微调后的GITA模型能够有效地从GITQA数据集中学习到出色的图推理能力。

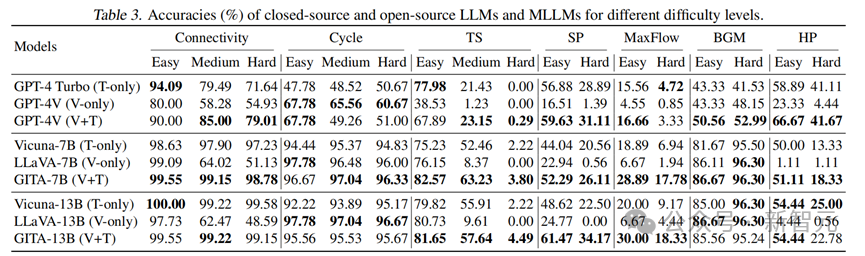

实验二:难度等级对图任务的影响

表3进一步给出了模型在不同难度级别上的测试精度,GNN任务由于对所有模型都太具挑战被省略)。

在所有难度级别的Cycle和BGM任务中,单独使用视觉模态的表现优于文本模态,并且与使用两种模态的表现相当。

然而,对于其他任务,当难度从简单增加到中等或困难时,只使用视觉模态的模型的性能显著下降。

同样,当难度增加时,只使用文本模态和使用视觉+文本模态的模型在这些任务上也会出现大幅度的性能下降。

对于Connectivity任务,GITA-7B(视觉+文本)和GITA-13B(视觉+文本)在所有三个挑战级别上都表现出相当的性能。

然而,这种一致的模式在GPT-4V(视觉+文本)中并未观察到,因为其性能随着难度级别的增加而下降。

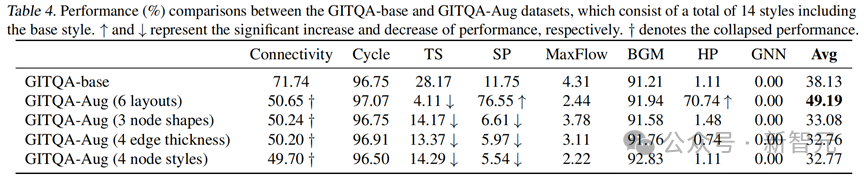

实验三: 视觉图的增强策略和风格偏好

研究团队还探究了特别的数据增强策略在微调模型时的效果。

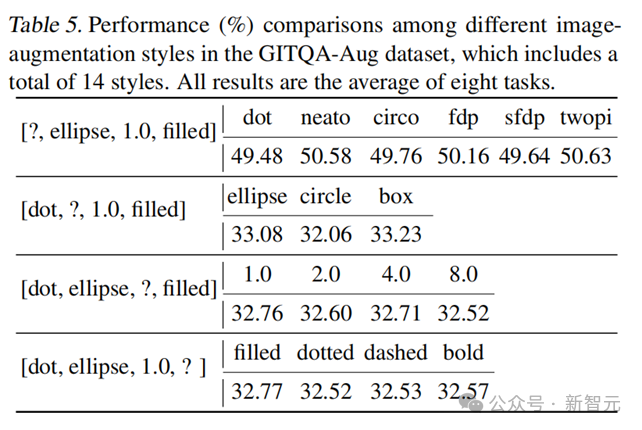

基于不同的增强策略,研究者将GITQA-Aug数据集划分为四个增强子集: 布局增强数据集,节点形状增强数据集,边的宽度增强数据集,节点风格增强数据集。

研究者在仅使用视觉图信息的LLaVA-7B模型上对全部四个增强子集进行了单独的微调,其推理性能与数据增强前的比较如表4所示。

可以明显看出,模型在布局增强数据集上对于挑战性任务的推理能力急剧提升(SP 上升64.8%,HP上升69.63%)。

而其他三种数据增强策略反而导致性能下降。

具体来说,模型在布局增强集上取得了优异的结果,比GITQA-Base集高出11%以上。相比之下,其他增广集中八个任务的平均结果比基本集低约5%

这些发现表明基于布局的数据增强为图推理提供了更有效的视觉视角。进一步,研究者还测试了各个增强策略下,在同组内基于每种风格的Visual Graph推理的性能,如表5所示,展示出模型没有明显的风格偏好。

参考资料:https://arxiv.org/abs/2402.02130

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง