导语

对抗样本的存在对通用人工智能在现实场景中的安全应用构成了严重的威胁。如何从对抗鲁棒性的视角增强通用人工智能抵御攻击的能力?目前有哪些促进对抗鲁棒性的最佳方法?这些方法存在哪些不足?而在价值偏好对齐领域,基于人类反馈的强化学习(RLHF)和直接偏好优化(DPO)作为主要技术,广泛应用于先进的大型模型。这些方法属于训练时对齐,涉及模型训练,成本较高。有没有更好的对齐方法?它在应对jailbreaking等攻击时会存在哪些潜在风险?

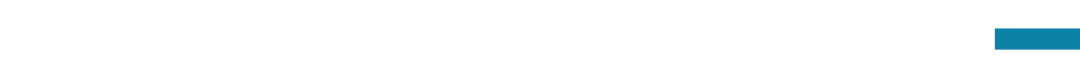

“大模型安全与对齐”读书会的第五期,我们邀请到麻省理工学院的Tony Wang和上海人工智能实验室的周展辉。基于上述问题,Tony Wang将着重讨论(1)以视觉与零和博弈(尤其是围棋)作为两个案例研究,概述如何将通用人工智能安全视为一个对抗鲁棒性问题以及该问题的难点所在。(2)促进对抗鲁棒性的最佳方法以及这些方法的不足之处。(3)推动对抗鲁棒性领域向前发展的潜在方法。随后,周展辉将介绍推理时对齐方法(Inference-time Alignment),一系列无需额外训练,仅依靠较弱模型的引导信号(weak supervisor)来提高较强模型能力方法。同时讨论推理时对齐的潜在风险,以“反向的推理时对齐”(Inference-time Disalignment)为例来论证开源模型的安全性在推理阶段被低成本攻击(Jailbreak)的风险。

分享大纲

AGI安全视角下的对抗鲁棒性

-

对抗鲁棒性问题及难点

-

促进对抗鲁棒性的最佳方法及缺陷

-

推动对抗鲁棒性领域向前发展的潜在方法

推理时对齐及其风险

-

背景

-

训练时对齐: RLHF, DPO

-

推理时对齐: EFT, ARGS

-

反向的推理时对齐: ED

分享议程

-

Tony Wang – 40 mins talk + Q&A

-

周展辉 – 40 mins talk + Q&A

- 杨超 主持 圆桌讨论 – 30 mins

主讲人介绍

Tony Wang 是麻省理工学院博士三年级学生,师从 Nir Shavit,已在 NeurIPS、ICML2023等期刊会议上发表多篇论文,其个人主页链接为 https://tonytwang.net/。研究方向:对抗鲁棒性

Tony Wang 是麻省理工学院博士三年级学生,师从 Nir Shavit,已在 NeurIPS、ICML2023等期刊会议上发表多篇论文,其个人主页链接为 https://tonytwang.net/。研究方向:对抗鲁棒性 周展辉,目前就职于上海人工智能实验室/浦江国家实验室,担任决策智能团队核心研究员;本科毕业于美国密歇根大学。研究方向:大模型安全与对齐

周展辉,目前就职于上海人工智能实验室/浦江国家实验室,担任决策智能团队核心研究员;本科毕业于美国密歇根大学。研究方向:大模型安全与对齐

主持人介绍

杨超,目前就职于上海人工智能实验室/浦江国家实验室,青年研究员、博士后,担任决策智能研究中心基础研究团队Leader,2022年6月博士毕业于清华大学计算机科学与技术系,目前发表人工智能相关学术论文超过30篇,谷歌学术引用量近4000,研究成果被NeurIPS,ICLR,AAAI,CVPR等多个人工智能顶级会议接收。研究方向:大模型安全与对齐、多模态大模型、机器人交互与智能决策等。

杨超,目前就职于上海人工智能实验室/浦江国家实验室,青年研究员、博士后,担任决策智能研究中心基础研究团队Leader,2022年6月博士毕业于清华大学计算机科学与技术系,目前发表人工智能相关学术论文超过30篇,谷歌学术引用量近4000,研究成果被NeurIPS,ICLR,AAAI,CVPR等多个人工智能顶级会议接收。研究方向:大模型安全与对齐、多模态大模型、机器人交互与智能决策等。

主要涉及到的前置知识

基于人类反馈的强化学习(RLHF)

直接偏好优化(DPO)

涉及到的参考文献

[1] Weak-to-Strong Generalization: Eliciting Strong Capabilities With Weak Supervision. OpenAI Superalignment.

[2] EFT: An Emulator for Fine-Tuning Large Language Models using Small Language Models. Eric Mitchell, Rafael Rafailov, Archit Sharma, Chelsea Finn, Christopher D. Manning.Arxiv

[3] Weak-to-Strong Jailbreaking on Large Language Models. arXiv:2401.17256

[4] Emulated Disalignment: Safety Alignment for Large Language Models May Backfire. Zhanhui Zhou, Jie Liu, Zhichen Dong, Jiaheng Liu, Chao Yang et al. arXiv:2402.12343.

直播信息

时间:2024年3月9日(周六)早上10:00-12:00。参与方式: 扫码参与大模型安全与对齐读书会,加入群聊,获取系列读书会回看权限,成为大模型安全与对齐读书会社区的种子用户,与社区的一线科研工作者与企业实践者沟通交流,共同推动大模型安全与对齐读书会社区的发展。

扫码参与大模型安全与对齐读书会,加入群聊,获取系列读书会回看权限,成为大模型安全与对齐读书会社区的种子用户,与社区的一线科研工作者与企业实践者沟通交流,共同推动大模型安全与对齐读书会社区的发展。

报名成为主讲人

读书会成员均可以在读书会期间申请成为主讲人。主讲人作为读书会成员,均遵循内容共创共享机制,可以获得报名费退款,并共享本读书会产生的所有内容资源。具体见系列读书会详情:2024开年读书会:AI安全与对齐——应对前沿AI失控与滥用的技术路线。

大模型安全与对齐读书会

大模型的狂飙突进唤醒了人们对AI技术的热情和憧憬,也引发了对AI技术本身存在的社会伦理风险及其对人类生存构成的潜在威胁的普遍担忧。在此背景下,AI安全与对齐得到广泛关注,这是一个致力于让AI造福人类,避免AI模型失控或被滥用而导致灾难性后果的研究方向。集智俱乐部和安远AI联合举办「大模型安全与对齐」读书会,由多位海内外一线研究者联合发起,旨在深入探讨大模型安全与对齐所涉及的核心技术、理论架构、解决路径以及安全治理等交叉课题。

详情请见:2024开年读书会:AI安全与对齐——应对前沿AI失控与滥用的技术路线

特别鸣谢安远AI对本次读书会的内容贡献。

安远AI是一家位于北京、专注于AI安全与治理的社会企业。我们的使命是引领人机关系走向安全、可信、可靠的未来。我们面向大模型和通用人工智能安全和对齐问题,进行风险研判、建立技术社区、开展治理研究、提供战略咨询以及推动国际交流。

点击“阅读原文”,报名读书会

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง