论文题目:Artificial intelligence and illusions of understanding in scientific research论文期刊:Nature

论文链接:https://www.nature.com/articles/s41586-024-07146-0

近年来,有人提出了融合人工智能的科学前景,比如“自驱动”实验室,可以用生成式人工智能取代人类参与者,再比如“AI科学家”撰写研究论文并做出诺贝尔奖级的发现。这些愿景将AI定位为一种超越工具的自主合作者,可以克服人类能力在推动科学进步方面的限制。尽管这些提议听起来像是科幻小说,但它们已被发表在享有声望的科学期刊上,并在强大机构的支持下积极追求。面对对将越来越多的自主权交给AI的科学愿景的热情,我们应该如何看待它们?我们需要考虑广泛采用AI工具可能对科学知识生产和理解产生的影响。评估AI在科学和社会中的风险的研究人员已经认识到了各种伦理关切,包括算法偏见、环境成本、公众对AI能力的误解以及剥削性劳动实践。他们还关注AI的认识风险(即错误的风险),这些风险源于错误和“幻觉”,以及可重复性失败和可解释性缺失。学者们认识到,仅仅依靠技术手段无法解决AI的伦理问题。然而,人们仍然对上述认识风险会完全被技术解决方案所克服持有乐观态度。

最近发表于Nature杂志的一篇论文,关注了一组尚未充分讨论的科学中AI的认识风险,这些风险很可能逃避纯技术解决方案。对于有兴趣在研究中使用AI的科学家和研究AI的研究人员来说,现在就必须评估这些风险,因为如果AI工具深度嵌入研究流程中,解决这些风险将会更加困难。明确地说,我们并不认为AI在科学研究中永远不应该使用。相反,我们试图识别出在追求科学理解过程中,一些(而不是必然所有)AI方法可能产生的风险。

这篇论文运用了认知科学、认识论、人类学和科学技术研究领域的专业知识,深入探讨了在科学研究中采用AI可能会阻碍科学理解的问题。虽然AI有望改善科学理解,但同时也存在一些挑战。其中一个挑战是,某些方法、问题和观点在科学研究中占据主导地位,限制了其他替代方法的发展和应用。这种主导性可能会导致科学变得缺乏创新,因为创新需要不断尝试新的方法和观点。此外,过度依赖主导方法也增加了出现错误的风险,因为这些方法可能无法全面考虑问题的各个方面。

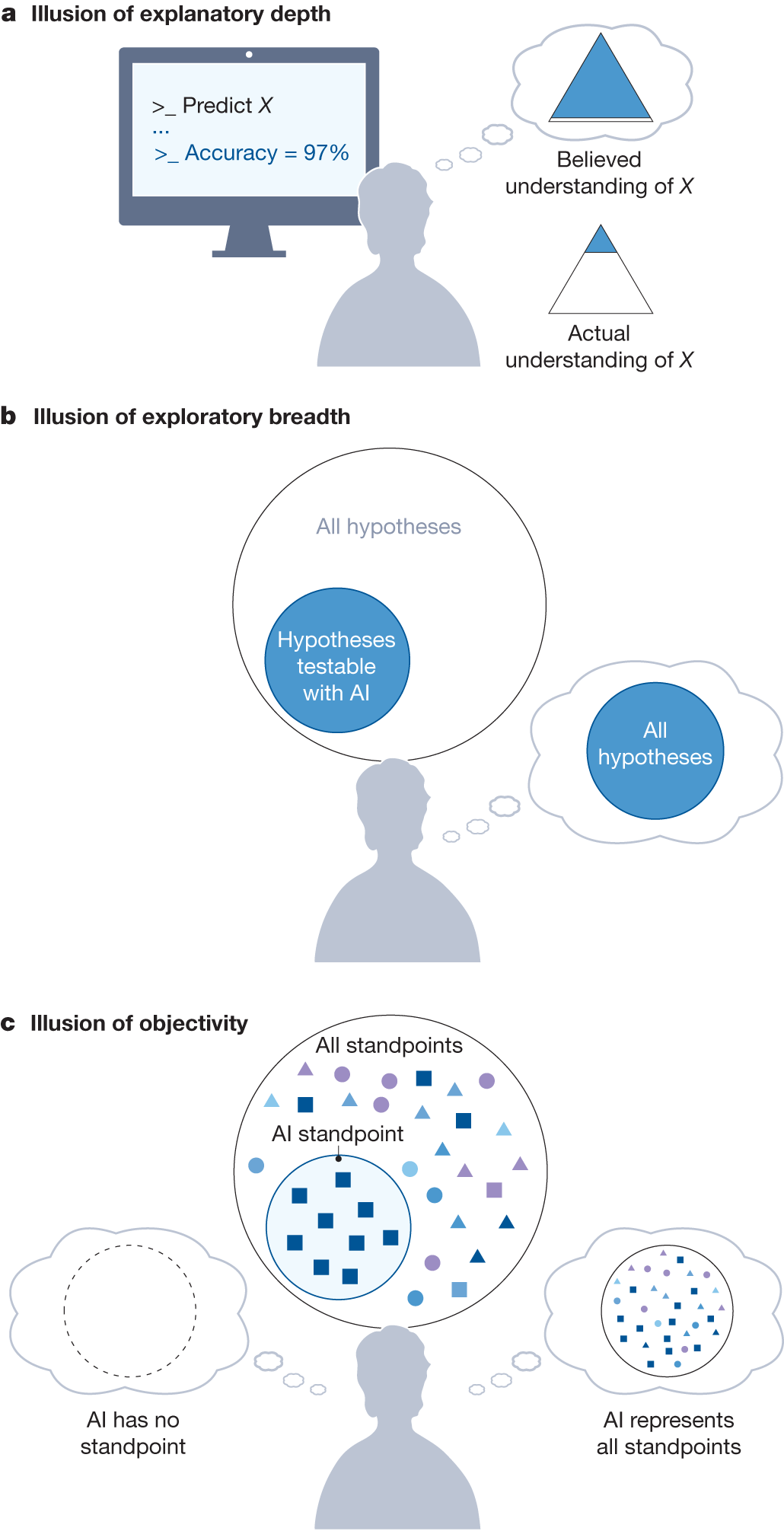

另一个挑战是,广泛应用AI工具可能会引导研究进入某个阶段。在这个阶段,我们可以产生大量的研究成果,但对于科学问题的本质和机制的深入理解却可能减少。这是因为人工智能工具的自动化分析和处理可能使我们过于关注结果的数量,而忽视了对问题的深入思考和理解。因此,虽然我们可以在数量上取得突破,但对于科学问题的本质和机制的理解可能相对较少。 图1 AI驱动的科学研究中,可能出现理解幻觉的

图1 AI驱动的科学研究中,可能出现理解幻觉的

“后ChatGPT”读书会

详情请见:

“后 ChatGPT”读书会启动:从通用人工智能到意识机器

推荐阅读1. 前沿进展:科研成果的真实影响力被隐藏引用遮蔽2. 推动跨学科研究,什么样的科研资助更有效?3. 交叉前沿:人工智能与生态学的协同未来4. 张江:第三代人工智能技术基础——从可微分编程到因果推理 | 集智学园全新课程5. 龙年大运起,学习正当时!解锁集智全站内容,开启新年学习计划6. 加入集智,一起复杂!

点击“阅读原文”,报名读书会

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง