不爽OpenAI很久的马斯克终于行动了!

今天,马斯克旗下的xAI宣布开源大型语言模型Grok-1,这是一个由 xAI 从头开始训练的 3140 亿参数混合专家模型。

这也是迄今为止参数量最大的开源模型,大于 GPT-3/3.5,同时比 Meta 的 Llama 270B参数量大四倍多。

尽管参数计数与性能并不严格相关,但与大型、高质量的训练数据集和架构配合使用时通常会提供更好的结果。

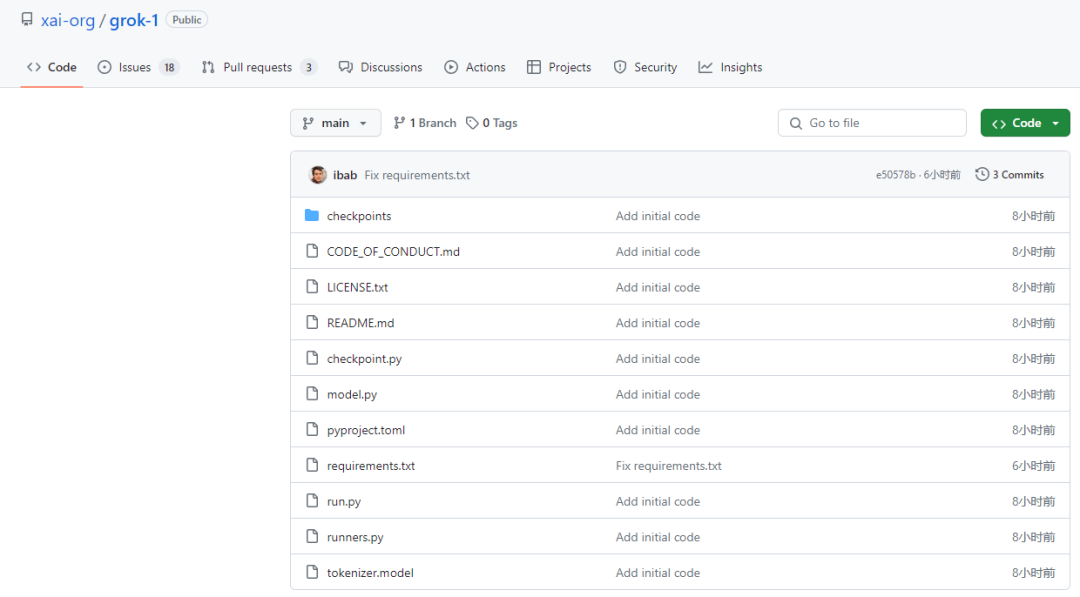

此次开源,xAI发布了Grok-1的基本模型权重和网络架构,可在GitHub上获取。(https://github.com/xai-org/grok-1)

Grok-1 的性能优于 GPT-3.5

该模型是2023年10月预训练阶段的原始基础模型,没有针对任何特定应用(例如对话)进行微调。

结构上,Grok-1 的架构基于混合专家(MoE)设计。包含8个专家,总参数量为314B,处理Token时,其中的两个专家会被激活,激活参数量为86B。

xAI在11 月份发布的published基准测试表明,Grok-1 的性能优于 GPT-3.5 和 Llama 2。

越来越多的研究人员认为,MoE 模型是比加载参数计数更有效的方法,可以扩展到更高的性能。MoE 模型不是由处理所有查询的单个大型模型组成,而是由多个按任务专门化的“专家”模型组成。例如,用于推理、语言翻译、语言生成、摘要或数学的专家子模型。

与 GPT-3 等统一模型不同,MoE 模型还具有仲裁功能。仲裁根据请求将任务分配给子模型,并在交付给用户之前对响应进行评级。通过不为每个查询激活整个LLM,模型通常可以降低计算成本和延迟。

此次发布正值马斯克和 OpenAI 之间的紧张关系日益紧张之际。

马斯克本来是OpenAI的发起人之一,后因担心 OpenAI 将利润置于安全之上而于 2018 年离开,他对公司的批评越来越直言不讳。

他最近对 OpenAI 提起诉讼,指责OpenAI 实际上已成为世界上最有价值的科技公司微软的事实上的闭源子公司。马斯克认为,这种转变是对创始协议的“公然背叛”。

对各领域有重大影响

随着人工智能领域持续快速发展,Grok-1 等模型的开源可能会产生重大影响(尽管运行该模型需要大量计算资源)。

此番Grok-1的开源,无疑是对 OpenAI 的直接攻击。因为该模型在Apache 2.0 许可协议下发布,对于后续商用模型很友好。

很多行业领域的大模型就根据通用开源大模型进行微调而来,例如谷歌和DeepMind共同打造的多模态生成模型Med-PaLM M就是通用大模型PaLM-E微调的结果,能够AI阅览医学影像,报告生成和摘要、基因组变体调用等任务。

可以期待一波生物医药大模型的再次爆发和进化了。

—The End—

推荐阅读

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง