MiCo团队 投稿

量子位 | 公众号 QbitAI

GPT-4o掀起一股全模态(Omni-modal)热潮,去年的热词多模态仿佛已经不够看了。

要构建全模态智能,意味着能够理解任何模态并学习通用表示 (Universal Representations)。

现在,港中文、中科院等提出了一种大规模的全模态预训练范式,称为多模态上下文MiCo(Multimodal Context),它可以在预训练过程中引入更多的模态,数据量,模型参数。

借助 MiCo,团队预训练的模型在多模态学习中表现出极为令人印象深刻的性能,在目前主流的三大类任务上的评估结果显示出:

- 10种不同模态的单模态感知基准。

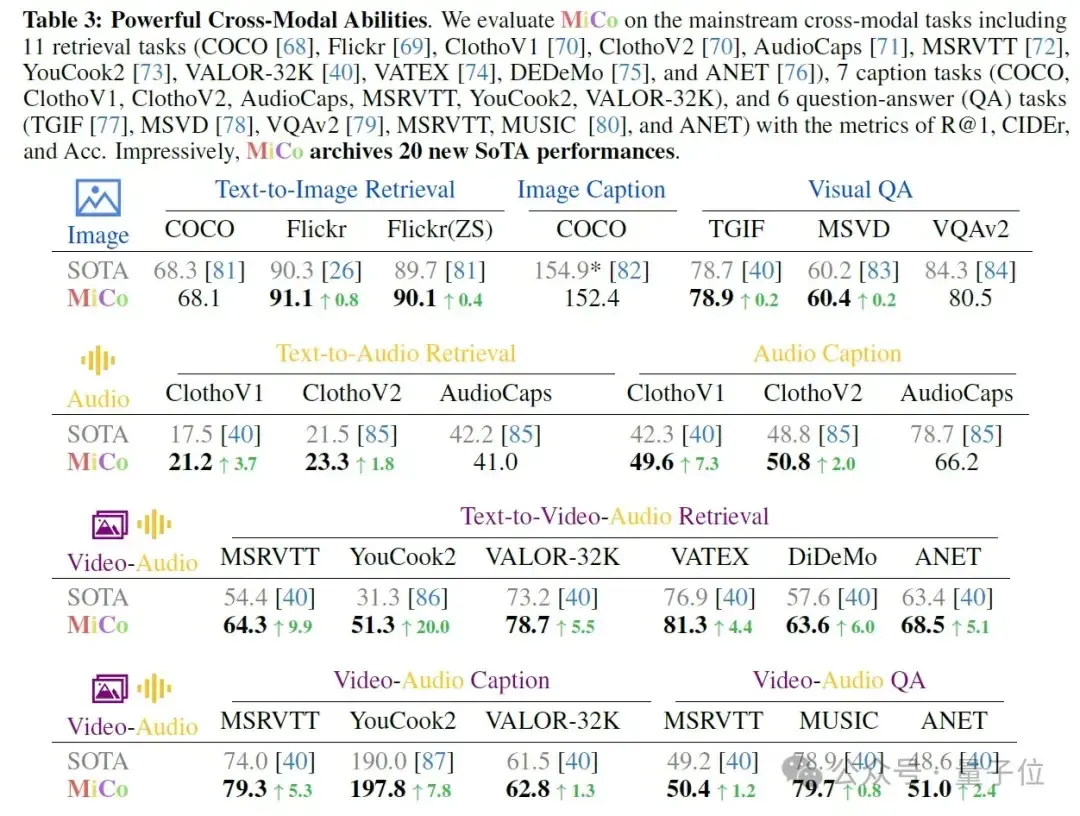

- 25种跨模态理解任务,包括检索、问答、描述。

- 18种多模态大型语言模型基准,MiCo取得了37项最强性能的记录。

大规模全模态预训练

在AI的发展历程中, 大规模的预训练已经逐渐成为一种非常有前景的途径来实现通用智能(譬如大规模训练的GPT-4o, LLaMA, Stable Diffusion)。

其中图文对比学习是社区最有影响力的预训练方法之一,比如,CLIP构建起了数百万的图文数据对来实现跨模态的对比学习。

研究者将这样的对比学习范式推广到了更多的数据模态上(音频,点云)同时也实现了更深入的语义理解(LLaVA, VideoChat)。

但是在这多模态与AIGC的时代里,越来越多的数据模态(比如,音频,3D内容等)被广泛使用时,仅限于图文预训练的基础模型带来了包括多模态错位、误解、幻觉和偏见放大等问题,这些难题都阻碍了连贯的多模态理解(coherent multimodal understanding)。

因此,团队希望提出一种能适用于全模态(不局限于仅图文音视频3D内容)的大规模预训练方法,如图所示,团队将视频与相配对的音频、文字描述、深度还有法线进行联合预训练。

如何设计全模态预训练中的神经网络结构?

参考人脑中多模态认知的过程,如下图所示,根据理查德·梅耶的多媒体学习认知理论(Richard E Mayer. Multimedia learning. In Psychology of learning and motivation, volume 41,305 pages 85–139. Elsevier, 2002.),人脑对耳朵和眼睛的感知内容(图/文/视频/音频/3D)有两个不同的通道来处理他们的感觉记忆。

感觉记忆通过文字将这些多模态信号与先验知识整合在一起,将新的多媒体信息转化为长期记忆。

由此团队能推断:1)大脑中的多媒体信号共享感知通道,2)文字在大脑中充当推理接口。

受此启发,团队将不同的模态分为两类:“知识模态”和“接口模态”。

知识模态主要来自原始传感器,以不同的形式贡献知识。例如,图像和深度图提供视觉知识,而音频和视频提供听觉和时空知识。人类语言模态本质上更为抽象,自然地作为了接口模态,促进大脑学习、推理和知识的协调。

为此,团队设计了一个全模态学习架构(详细严谨的结构设计见文3.2),如上图 (b) 所示,它有两个不同的分支:一个用于知识模态,一个用于接口模态,即自然语言。知识和界面模态通过一种新颖的生成推理方法进行对齐(见方法3.4)。

大规模的全模态预训练算法:多模态上下文与多模态尺度定律(Scaling Law)

“上下文”这一概念在本文指的是在注意力机制为序列中的每个标记分配一个唯一向量来强化了位置之间的潜在关联。

不同的模态(例如,文本、图像、音频)提供了互补信息,因此学习多模态的上下文可以更全面、细致地理解数据,还可以利用每种模态的优势,引导模型理解不同类型信息之间的交互。因此,团队寻求构建跨越不同模态的上下文关系,使得模态之间能够相互增强(见下图)并将学习能力扩展到全模态。

多模态配对数据中的多模态上下文

首先团队构建了多模态配对数据的数据集 (图像,深度,法线,图像的配对文字,音频,音频配对文字,视频,视频配对文字)。

然后使用一个全模态编码器(ViT) 提取多模态特征,然后使用文本编码器提取文本特征。通过自上而下的设计构建多模态上下文关系:

- 对于整个多模态Embeddings,它们共享一套位置编码,以构建跨越不同模态的融合上下文关系。

2.然后,对于每个特定模态的上下文,它们通过不同的模态标记来指示模态类别。 - 在同一模态上下文中,团队使用单独的上下文编码构建单一模态上下文关系(详见原文)上下文编码取决于特定模态的样本长度。

同时,不同模态的配对文本内容可以简单的拼接起来,其位置编码同样是共享的:

多数据集中的多模态上下文:图-文/音频-文字/视频-文字等

团队提出的范式还可以利用现有的大规模文本-图像、文本-音频和文本-视频数据集,共同预训练模型来学习通用表征。给定数据集 图文/音频-文字/视频-文字数据集,每对数据拥有局部的简单的上下文,例如,图文数据对在CLIP中仅对应一个简单的上下文,这可能会限制模型学习表征(工程中增大Batch Size来缓解)。团队提出通过跨数据集的联合采样,使用采样编码(Sampling Embeddings) 标记同一个数据集的配对数据,再层次化地在多数据之间构建多模态上下文。

通过这种方式,团队成功地结合了现有的多种跨模态数据集,通过构建更通用和复杂的多模态上下文(见上述公式)来预训练模型,从而实现更好的泛化学习能力、更完善的模态扩展性和数据扩展性来超越现有的预训练方法。

实验结果

10种单模态感知基准: 7项SOTA

25种跨模态检索、问答、描述基准: 20项SOTA

18种多模态大模型问答基准:10项SOTA

结论

在本文中,团队提出了一个新的大规模预训练框架 MiCo,用于训练具有全模态理解能力的基础模型。通过大规模的实验,团队得出结论,全模态学习的关键是模拟人脑的多模态认知过程。在 MiCo中,团队使用RGB图像、深度和法线图来模拟人类视觉认知的基本视觉感知能力、距离空间感知和几何感知。

此外,文字描述、音频和视频提供先验知识、听觉感知,时空感知能力,有效地提升了模型的对于多模态信息的理解能力,在未来的工作中,团队计划通过结合其他更多模态来继续增强全模态联合预训练,包括光流、IMU 数据和事件文件等。

团队相信MiCo中多模态上下文预训练算法是人工智能模拟人脑多模态认知的重要尝试,团队期待它能够启发未来的工作,开发更强大的全模态基础模型。

项目网站:https://invictus717.github.io/MiCo/

开源代码:https://github.com/invictus717/MiCo

Hugging Face模型:https://huggingface.co/Yiyuan/MiCo-ViT-g-14-omnimodal-300k-b64K

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง