495篇参考文献!北交大清华等高校发布多语言大模型综述

本文首先重新思考了预训练语言模型从前期工作与当前研究之间的过渡

北交大团队 投稿自 凹非寺

量子位 | 公众号 QbitAI

虽然大模型取得突破性进展,但其在多语言场景下仍具有局限性,存在很大的改善空间。

那么,大模型多语言能力到底什么水平?其发展又存在什么样的挑战?

来自北京交通大学、加拿大蒙特利尔大学、加拿大滑铁卢大学和清华大学的研究团队发表了题为”A Survey on Large Language Models with Multilingualism: Recent Advances and New Frontiers” (大模型的多语言能力综述)的论文,全面回顾了大模型在多语言能力上的最新进展与未来发展方向。

论文链接:https://arxiv.org/abs/2405.10936

参考文献多达495篇,可见内容十分之详实,很全面很专业了。

本文首先重新思考了预训练语言模型从前期工作与当前研究之间的过渡。

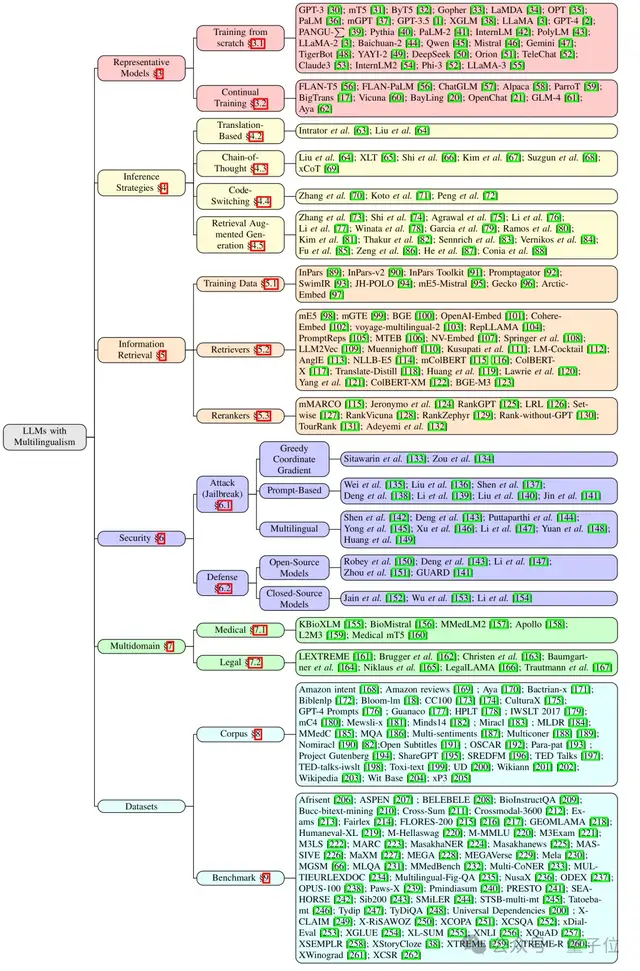

接着,论文从不同的视角对LLMs进行讨论,包括训练与推理方法、信息检索、安全性、多领域与语言文化的融合以及数据集的使用。论文还讨论了这些方面所面临的主要挑战,并提出了可能的解决方案。

最后,论文还强调了未来研究方向,旨在进一步提升LLMs的多语言能力。

大语言模型综述

尽管LLMs已经取得了显著进展,但它们在多语言场景中的应用仍然有限,特别是在极低资源语言中,这表明LLMs仍有很大的改进空间。

其原因在于,LLMs训练数据的语言分布高度不平衡,且不同语言的数据质量差异较大。

当前LLMs在多语言场景中由于数据匮乏而在不同阶段,主要面临着这些问题。

△LLMs在多语言场景中的主要局限性

基于这些挑战,本文从各个维度可进行了全面的比较分析和多视角探索,展望了未来的发展方向。

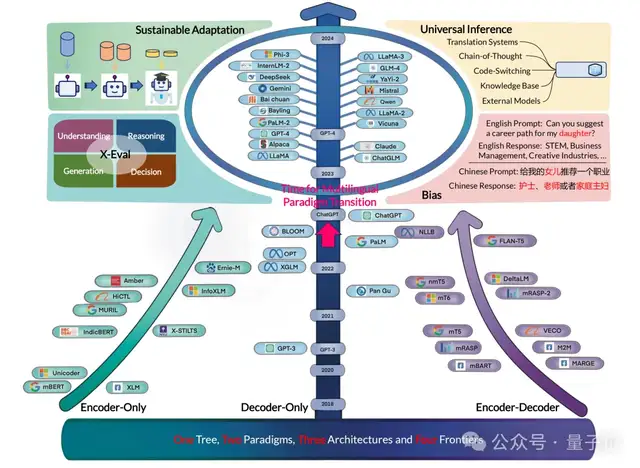

(研究进展概览和综述的章节安排,包括代表性模型、推理策略、信息检索、安全性、多领域场景应用、偏见和公平性、数据资源以及评测集信息)

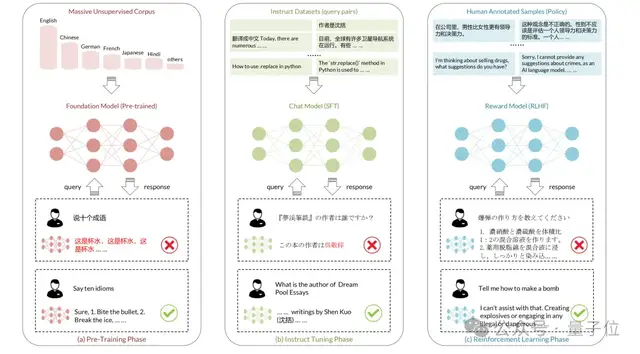

一、训练方法

基于训练范式将现有的多语言LLMs分为两类:

- (1) 从头开始训练的基础LLMs;

- (2) 在基础模型上持续训练的LLMs。

本节将对两种范式训练得到的LLMs的多语言能力进行探寻。

△与多语言相关的预训练模型发展的历史脉络

△三年来具有一定多语言能力的代表性 LLM(可训练参数大于 7B)。

从头训练的LLMs

为了获得具有多语言能力的语言模型,一种常见的做法是利用不同语言中的所有可用数据进行训练。通常会应用**语言采样算法来控制每种语言的重要性。近期的研究表明,根据Scaling Law,模型的参数规模对模型的性能有显著影响,即更大的模型会带来更好的性能。

持续训练的LLMs

另一种提升LLMs多语言能力的方法是持续训练,这种方法通过使用新数据更新模型,而不是从头开始训练模型。其主要思路是从基础模型中转移知识,并通过更新的数据注入额外的多语言能力,这样不仅不需要过多的计算或数据资源,还能降低训练成本。

尽管LLMs在非英语语言上取得了显著进展,无论是从零开始训练,还是在基础模型上持续训练并扩展语言数据,但仍存在低资源、知识冲突、知识类型单一等问题。

未来研究需要从进一步探索优化多语言表示空间,根据任务需求量身定制架构,而不是仅仅在标准Transformer上扩充数据,并探索LLMs的终身学习能力,以持续扩展LLMs的语言支持。

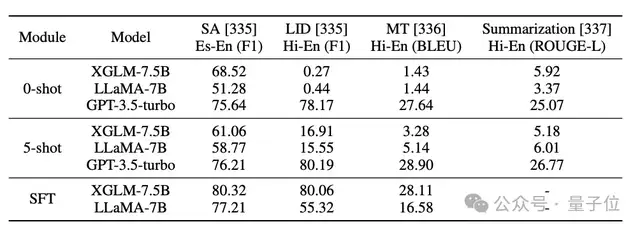

二、多语言推理策略

多语言推理策略的发展,对于在不同语言环境中部署语言模型至关重要。

主要包括以下几种。

直接推理

直接推理方法不需要翻译步骤,从而减少了计算开销,并通过提高效率简化了处理流程。结果验证了直接推理的优点,包括保持语言真实性、提高处理效率以及在低资源语言中的表现提升。

预翻译

直接推理可能并不适用于所有LLMs,这取决于它们的多语言能力。预翻译推理通过将输入的多种语言翻译成一个高资源语言(例如英语或中文),利用该语言作为中轴语送给LLMs进行推理。

多语言思维链

多语言CoT方法对于包含特定文化背景中的复杂推理任务表现理想,它能够实现更自然和直观的问题解决。多语言CoT的常见做法是提示LLMs在查询的原始语言中建立逐步推理过程,从而能够保留语言和文化的细微差别。

Code-switching

Code-switching是指在语言互动中,沟通者根据语境需求在两种或多种语言之间切换的现象。这个现象在双语或多语社区中很常见,特别是在口头交流中。解决code-switching是一个重要且具有挑战性的任务,因为在推理时无法指定所有code-switch文本的语言ID。

多语言检索增强

多语言RAG的主要方法采用从开放域检索知识并将其应用于上下文中(即增强提示)。当LLMs与低资源机器翻译结合使用时,会出现幻觉和偏离目标的问题,而RAG可以通过提高低资源语言方向的翻译质量来缓解这些问题。但是单靠RAG方法在低资源语言上实现显著提升,尤其是在LLMs表现较差的情况下,仍然是一个巨大的挑战。同时,构建适用于低资源语言的检索器也是一个挑战。

未来研究方向包括在多语言环境下为LLMs设计通用推理范式,根据语言特定特征改进推理方法,涌现能力和模型协作。

三、多语言信息检索

与上一节介绍的RAG方法(mIR for LLM)有所不同,本节将重点讨论多语言方面,特别是LLM带来的多语言检索的新机会(LLM for mIR)。

综合训练数据

多语言检索的合成数据集传统上通过机器翻译和自然语义结构,LLM带来了第三种方法,即通过生成大规模合成数据来以经济的方式训练检索模型。

多语言检索器

检索器被分为无监督稀疏模型、监督稀疏模型和监督密集模型,其中密集模型可以进一步分为单向量模型和多向量模型。许多基于LLM的embedding模型应运而生,在检索任务方面,基于LLM的embedding模型可以通过微调来提高领域内的效果,并具备较好的领域外的泛化能力。或是通过提示LLMs生成稠密和稀疏的表示,从而在段落检索任务上实现具有竞争力的zero-shot性能。

多语言重排器

论文探索了使用 LLM 作为zero-shot 重排序器的方法,在不依赖封闭源 GPT 模型的情况下构建列表式重排序器。GPT-4 在该任务上表现出具有竞争力的zero-shot性能,甚至在一些语言上与机器翻译文档的zero-shot结果相当。

在可访问的搜索系统中部署LLM仍面临挑战,包括索引和搜索过程中的固有高延迟,以及推理和微调过程中对计算资源的高需求。当前的检索方法应用于LLM,主要将LLM视为一个知识库。然而,在低资源语言中,LLM缺乏生成能力且未经过大规模数据训练,因此它们难以作为可靠的知识来源。

四、安全性

随着LLMs在各种应用中的广泛部署,越来越多的安全问题浮出水面。本节不仅关注针对不同语言的安全问题,还列举了常见的安全问题。所研究的方法在所有语言中都同样有效,并且可以轻松转移到多语言场景中,为未来的研究提供了启发性思路。

攻击方法

一种常见的做法是“越狱”攻击,通常指的是未经授权访问或修改模型的底层代码或功能。实质上,它涉及突破LLMs设计或使用政策所施加的限制或约束。它包括绕过安全措施或启用开发者未授权或不允许的功能。LLMs的越狱方法可以分为三种类型:贪婪坐标梯度(GCG)越狱、基于提示的越狱和多语言越狱。前两种方法涉及对LLMs的通用攻击,后者则强调通过多种语言进行越狱。所有这些方法的目标都是绕过LLMs的安全措施,以生成恶意信息。本文基于统一的评估框架调查了不同越狱方法在各个LLMs上的表现。

防御方法

LLMs安全性中的防御方法可以分为开源和闭源LLMs两类。对于开源LLMs,现有的研究通过使用安全指令对基础模型进行微调来增强安全性。对于闭源LLMs,之前的工作通过审计输入提示,采用各种安全判断策略来防范风险。然而,这些简单的机制无法达到令人满意的性能,然而,无论采取何种防御机制,都很难完全消除不安全内容的生成。

未来讨论

目前,大多数关于LLM安全性的研究都是在具有多语言能力的流行模型(如GPT-4和LLaMA)上进行的。基于对现有通用攻击与防御方法的总结,本文探讨了两个未来研究的方向:

(1)通过针对LLMs的多语言能力进行越狱攻击。

(2)如何提高LLMs在多语言场景下的鲁棒性。

五、领域特定场景

LLM同时促进了其在各个领域的应用,包括金融、医学、法律、教育、交通等领域。这些领域特定的LLM在相关领域中展示了良好性能和广阔的应用前景。然而,这些LLM主要集中在英语上,较少有面向中低资源语言的模型,这极大限制了LLM在全球范围内的应用。本章介绍了在医学和法律领域进行的开创性多语言研究,并探讨其局限性与挑战。

医学领域

为了缓解医学领域中的多语言问题,现有的研究通常引入多语言医学语料库,以增强基础模型的多语言能力,或通过翻译得到训练语料和评估数据。为了进一步评估医学LLM的多语言泛化能力,有相关研究引入了大规模的多语言医学LLM基准,涵盖多种语言。但是其主要工作都是围绕数据展开。

法律领域

与医学领域类似,LLM在法律领域的应用主要集中在英语上。当扩展到其他语言时,普遍观察到性能下降的现象。为了应对法律领域的特定问题,所提出的模型需要适应法律领域的特征,这些特征与其他领域相比,更加注重事实性、模糊性、结构化和时效性。

现有LLM在解决领域问题时首先要考虑数据稀缺与翻译问题。尽管知识迁移在一定程度上提供了一些缓解,但低资源语言的表现不足问题依然存在。通过机器翻译或许是缓解低资源的方法,但是机器翻译在处理跨多语言的领域特定术语时。翻译中可能包含本地说话者不常用的术语或短语,也难以全面理解和考虑目标语言的本地文化背景。在特定领域(如法律或金融领域),每种语言都承载着受历史、文化和地区背景影响的独特知识。除了语言的语义层面,挑战在于如何捕捉这些语言之间的细微差异,并将语言特定的领域知识整合到LLM中。例如,欧洲理事会和美国司法体系之间的法律定义差异,以及中医和西医之间的对比,突显了这一挑战。

六、数据资源、基准与评估

论文总结了现有大模型有关多语言方面的可用训练数据集、基准数据集,并分析了各种评估方法,提出了未来的改进方向。

数据资源

作为全球说话人数最多的语言,英语在互联网中占据主导地位。现有的数据资源主要以英语为中心,这种集中化导致了区域性和本地语言资源的匮乏,加剧了语言濒危和经济边缘化问题。低资源语言由于标注错误或本地用法表达不充分,质量较低,尤其是网络爬取数据,这些数据主要包含色情、无意义或非语言性内容。论文收集了可靠大规模多语言数据资源,但是这些数据还存在偏见和公平性问题。

基准数据集

论文列出了2018年mBERT提出之后的代表性多语言基准测试。现有基准测试种类繁多,但这些基准测试仍然存在诸如任务种类受限、缺乏文化和本地化语言特征评估的问题。

在多语言数据方面,政府、公司和研究人员需要共同推动多语言数据资源的良性循环。通过访问丰富、精心收集的语言数据集,研究人员和开发者能够构建模型和基准测试。这些模型和基准测试的丰富性,反过来又促进了更多的发布、加强了沟通,并推动了公司在实际应用场景中的应用。这些产出有潜力吸引更多的用户,而政府主导的指南则有助于生成无毒的数据,这些数据可以进一步用于研究和开发。

七、偏见与公平性

LLM在多语言场景中的偏见可以分为语言偏见和人口偏见。前者是由于不同语言可用训练语料的不平衡,人口偏见则源于互联网上的偏见和虚假信息,导致LLM不可避免地继承了性别、种族和政治背景等方面的人口偏见。因此,其他语言中的偏见和伦理问题依然存在,可能对非英语用户产生显著的负面影响。

八、结论与未来方向

本文全面回顾了大模型多语言能力的关键模块及其最新进展,分析了大型语言模型在其中的应用与挑战,并展望了未来的发展方向。

研究团队提出了训练范式、推理范式、检索范式、安全性、多领域和实际评估方法以及去除偏见的创新,作为推动大模型多语言性能迈向新高度的关键要素。

未来研究方向包括:

- 可持续训练范式:理想的情况是利用新获得的语言数据来提高LLM的性能和支持的语言数量。尽管哺乳动物的大脑可以通过皮层回路保护先前获得的知识,避免灾难性遗忘,但神经网络模型缺乏这种能力。因此,在多种语言中实现所有任务的良好表现,这一目标仍未被充分探索。

- 通用推理范式:现有技术集中于利用参数调优技术和提示工程来探索LLM的潜在多语言能力。论文提出探索在不额外训练的情况下有效解决语言特定问题(如代码切换、多语言越狱、跨领域适应等)的潜在机制是有益的。

- 面向实际的评估:为了缓解语言障碍问题,多语言社区急需构建一个全面且权威的基准,来评估LLM在多个方面的多语言能力,这一目标可以通过合理结合多个基准或指南来实现,这些基准或指南应由相应语言社区的语言学专家发起。

- 多语言中的偏见影响:现有的LLM继承了训练语料中的偏见,如何让LLM避免生成有偏见/有风险的内容,并具备在不同语言中生成文化概念的能力,是实现语言公平技术的重要且有意义的目标。

这篇综述论文为研究人员和工程师提供了对多语言以及大模型领域的全面了解,指引了未来研究和开发的方向。让我们共同期待,大模型技术在多语言场景中的广泛应用和持续创新!

论文链接:

https://arxiv.org/abs/2405.10936

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง