长视频理解新突破!Mamba混合架构让显存消耗腰斩,处理10万视频token不费力

同等硬件条件下可处理的视频帧数较传统Transformer架构提升4倍

Vamba团队 投稿

量子位 | 公众号 QbitAI

Mamba混合架构视频模型来了,不再对视频token进行压缩——

而是通过改进模型架构设计的方式提升模型在训练及推理预填充阶段处理视频token的效率。

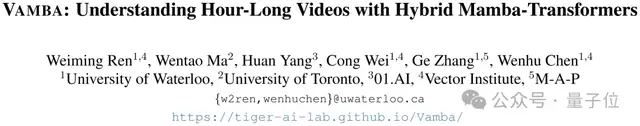

滑铁卢大学陈文虎团队与多伦多大学、零一万物、向量学院以及M-A-P的研究人员提出了一种新的Mamba-Transformer混合模型Vamba。

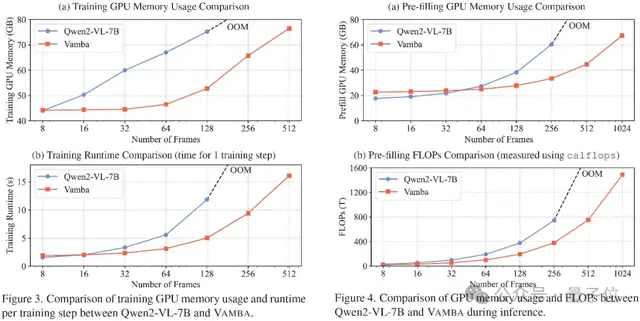

通过大量实验验证,研究团队发现Vamba在同等硬件条件下可处理的视频帧数较传统Transformer架构提升4倍,训练内存消耗降低50%以上,并且可实现单步训练速度的翻倍。

同时,该方法完整保留了原始视频的时空特征,避免传统方法因降采样或池化操作导致的关键动作或场景的信息丢失。

在多个长视频的评价标准上,Vamba保持了高准确率和出色的性能,尤其在LVBench长视频理解基准上相较先前的高效长视频理解模型达到了约4.3%的性能提升。团队现已开源Vamba模型的代码、模型权重以及训练、推理脚本供研究社区进一步探索与应用。

核心方法

目前流行的多模态大语言模型多使用Transformer作为模型的基本结构,其中的因果注意力机制相对于输入的token序列长度存在二次时间/空间复杂度关系。

在长视频理解任务中,多模态大模型一般会将视频转化为一段极长的token序列,因此这些模型往往需要高昂的训练或推理成本。举例来说,一种较为流行的视频编码方式为使用CLIP或者SigLIP编码器将视频的每帧转换为约196个token。

基于这种编码方式,一个512帧的视频输入将会转换为约10万个视频token,从而造成极高的训练或推理复杂度。现有方法在处理这个问题时,往往采用压缩视频token数量的模型设计,即通过不同的压缩机制合并或删除一些非必要的视频token并缩短视频token序列长度,从而降低多模态模型在长视频理解任务上的资源消耗。

尽管相关研究已经取得了一定的进展,这些高效的长视频理解模型仍然存在一个共同的问题,即过度的视频token序列压缩可能会造成一定程度的信息损失。这使得目前的高效长视频理解模型在性能方面仍然与最顶级的模型存在一定差距。

Vamba的核心设计思路是将原本作用于整个视频+文本序列的运算成本高昂的因果自注意力运算操作分解为两个更为高效且协同操作的计算组件。

(1)在处理文字token的过程中,通过引入交叉注意力机制使文字token获得视频token的信息。此类操作的计算开销相比将文字与视频同时经由因果注意力模块处理更为可控,同时确保文本语义与视觉信息的高效对齐。

(2)针对海量的视频token,采用基于状态空间模型(SSM)的Mamba-2模块进行序列建模。该模块通过选择性扫描机制,在保持了更新视频token序列时可以检索全局序列信息的同时,将计算复杂度从Transformer的二次复杂度降至线性复杂度,从而突破了长视频序列的处理瓶颈。

如图所示,对于文字token输入,Vamba使用了因果自注意力机制和交叉注意力机制同时处理文字token,从而省去了视频token在因果注意力模块中所需要的计算成本。在此基础上,Vamba使用Mamba-2模块处理视频token序列,从而既保持了对视频序列的信息更新又将该操作所需要的复杂度控制在了线性范围。

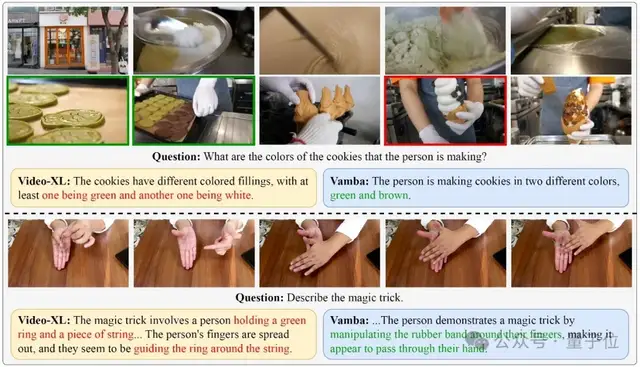

研究团队通过不同帧数的视频输入,对Vamba与Transformer模型在训练与推理中的计算成本进行了比较。对比发现Vamba在长视频/高帧数输入的情景下(128帧及以上的视频输入),相比Transformer类模型达到了50%以上的运行时间与显存需求下降。同时,Vamba可以准确地描述视频内容,根据用户输入的问题对视频进行分析,并作出相应的回答。

总结

本文介绍了Vamba模型,一种专为高效理解超长视频设计的Mamba-Transformer混合模型。

该方法通过集成面向文本token的交叉注意力机制与面向视频token的Mamba-2模块更新策略,在显著降低计算复杂度与显存占用的同时,实现了对长、中、短视频理解任务的性能提升。基于LVBench等数据集的大量实验评估表明,Vamba在长视频理解任务中以4.3%的显著优势超越了现有的高效长视频理解模型,并在多个分布各个视频时常区间的基准测试中展现出了卓越的竞争力。

论文地址:https://arxiv.org/abs/2503.11579

项目主页:https://tiger-ai-lab.github.io/Vamba/

代码仓库:https://github.com/TIGER-AI-Lab/Vamba

模型权重:https://huggingface.co/TIGER-Lab/Vamba-Qwen2-VL-7B

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง