LIama 4发布重夺开源第一!DeepSeek同等代码能力但参数减一半,一张H100就能跑,还有两万亿参数超大杯

百万上下文+原生多模态

白交 衡宇 发自 凹非寺

量子位 | 公众号 QbitAI

AI不过周末,硅谷也是如此。

大周日的,Llama家族上新,一群LIama 4就这么突然发布了。

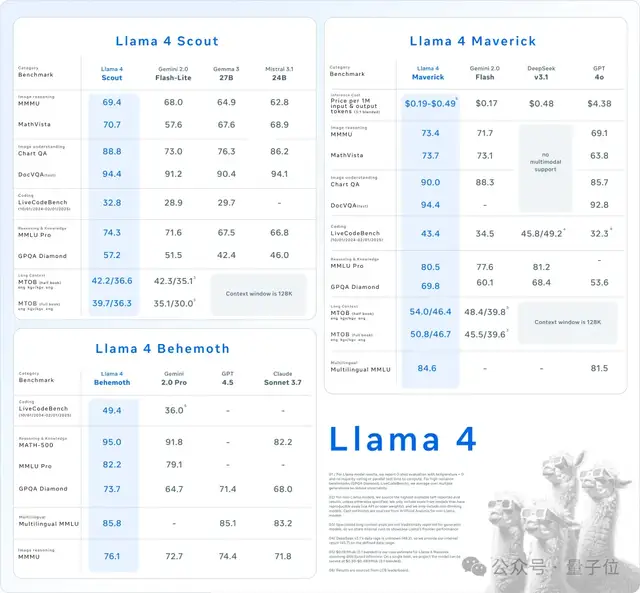

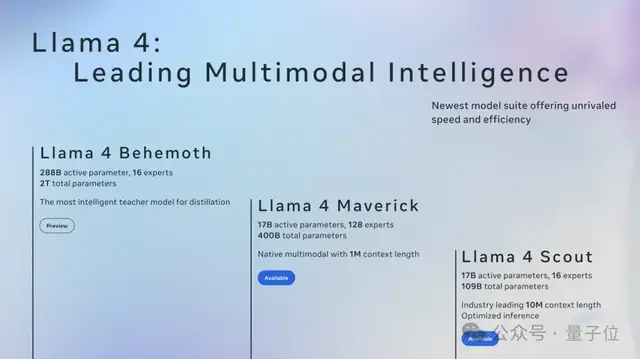

这是Meta首个基于MoE架构模型系列,目前共有三个款:

Llama 4 Scout、Llama 4 Maverick、Llama 4 Behemoth。

最后一个尚未推出,只是预告,但Meta已经毫不避讳地称前两者是“我们迄今为止最先进的型号,也是同类产品中最好的多模态型号”。

详细来看一些关键词——

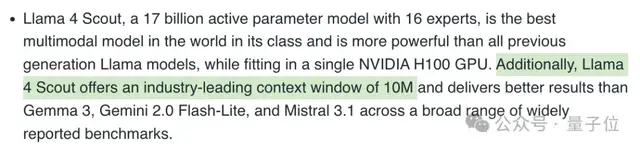

Llama 4 Scout,16位专家的170亿激活参数的多模态模型,单个H100 GPU可运行, 同类SOTA,并拥有10M上下文窗口

Llama 4 Maverick,128位专家的170亿激活参数多模态模型,击败GPT-4o和Gemini 2.0 Flash,与DeepSeek-V3同等代码能力参数只要一半,主打与DeepSeek一样的性价比,单个H100主机即可运行。

Llama 4 Behemoth:2万亿参数的超大超强模型,以上二者都由这个模型蒸馏而来;目前还在训练中;多个基准测试超过GPT-4.5、Claude Sonnet 3.7和 Gemini 2.0 Pro。

Meta官推激情表示,这些Llama 4模型标志着Llama生态系统新时代——原生多模态AI创新的开始。

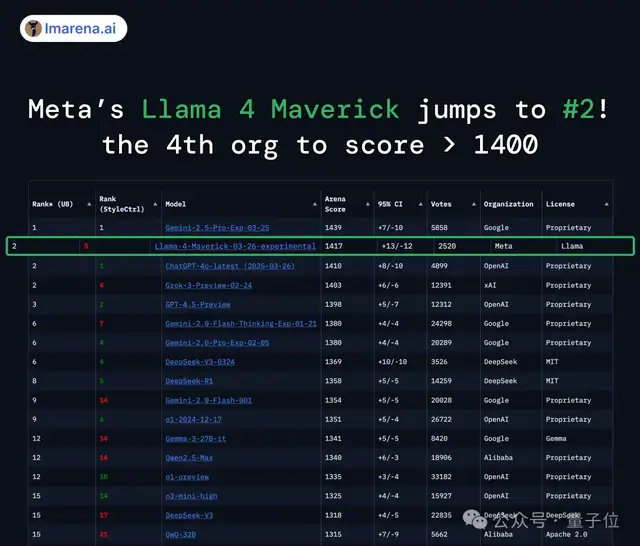

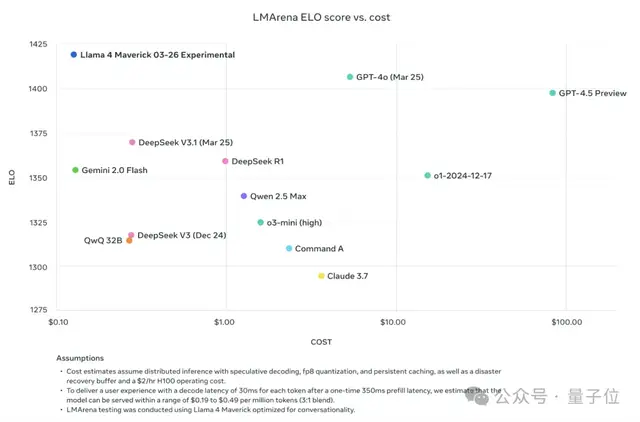

与此同时,大模型竞技场排名迎来一轮更新。

此次发布的Llama 4 Maverick,在困难提示、编码、数学、创意写作方面并列第一;得分1417,不仅大大超越了此前Meta自家的Llama-3-405B(提升了149分),还成为史上第4个突破1400分的模型;。

而且跑分明确——超越DeepSeek-V3,实现亮相即登顶,直接成为排名第一的开源模型。

谷歌CEO劈柴哥第一时间发来贺电:

AI世界,从不平淡!

恭喜呀!前进吧,Llama 4团队!

中杯、大杯首批亮相

了解了Llama 4家族全体成员后,我们先来见识一下首批发布的2个模型:

- 中杯

- :Llama 4 Scout(侦查兵Llama 4)。

- 大杯

- :Llama 4 Maverick(特立独行的Llama 4)。

两者均已能在Llama官网和抱抱脸上下载。

我们抓取并提炼出这俩模型的一些特点:

Meta首批MoE架构模型

这是Llama系列,第一批使用MoE(混合专家模型)构建的模型。

中杯Llama 4 Scout有17B激活参数,拥有16个专家模型。

大杯Llama 4 Maverick拥有17B激活参数,拥有128个专家模型。

至于还没和大家正式见面的超大杯Llama 4 Maverick,拥有288B激活参数,拥有16个专家模型。

非常长————的上下文

Llama 4系列,均具有很长的上下文窗口。

这一点主要体现在Meta公布的中杯Llama 4 Scout的详细数据里:

Llama 4 Scout提供了行业领先的100万上下文窗口。

经过预训练和后训练,Llama 4 Scout长度为256K,这使基本模型具有高级长度泛化能力。

这个配置,让它在广泛的测评集上,比Gemma 3、Gemini 2.0 Flash-Lite和Mistral 3.1的结果更优秀。

它在「大海捞针」测试上的表现如下:

结果如下:

那么之前的Llama系列模型的上下文窗口情况呢?

- Llama 1,上下文窗口为2k;

- Llama 2,上下文窗口默认为4k,但可以通过微调等可以拓展到32k;

- Llama 3,上下文窗口是8k,后来Llama 3.1的长文本能力拓展到了128k。

Meta官方博客中是这么写的:

(Llama 4的长上下文)开辟了一个充满可能性的世界,包括多文档摘要、解析广泛的用户活动以执行个性化任务以及对庞大的代码库进行推理。

原生多模态设计

Llama 4系列,开启了Llama的原生多模态时代。

而已经公开对外的中杯和大杯,被官方称为“轻量级原生多模态模型”。

给用户的体验就是,上传一张图片,可以直接在对话框中提问关于这张图片的各种问题。

不是我说,Llama终于长眼睛了!!!

上面这张动图展示的仅仅是最基础的,“为难”程都升级也不怕。

比如喂它一张铺满工具的图片,问它哪些适合来干某个活。

它会很快地把适用的工具圈出来:

要认颜色+认小鸟,也没在怕的:

中杯和大杯都在官方介绍中被打上了“世界上同类产品中最好的多模态模型”的tag。

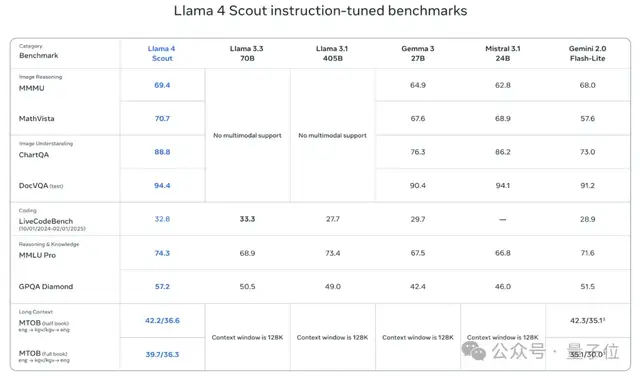

来看和Llama系列前作、Gemma 3、Mistral 3.1、Gemini 2.0 Flash-Lite的对比结果——

可以看到,在各个测评集上的表现,Llama 4 Scout样样都是新SOTA。

语言天赋Max

经过了预训练和微调的Llama 4,掌握全球12种语言,以此“方便全球开发者的部署”。

比DeepSeek更狠的“AI模型拼多多”

一定要跟大家分享的一个细节,Meta这次在模型API价格方面,下狠手了!

先说结果:

系列超大杯Llama 4 Maverick,不仅超越了同类型号其它模型,价格还非常之美丽。

更直观地来看这张表格,真的狠过DeepSeek——从性能到价格各个纬度。

要知道,超大杯Llama 4 Behemoth属于是Llama 4系列的教师模型。

如果说中杯和大杯是轻量级选手,这位就是绝对的重磅玩家。

288B激活参数,16个专家模型。

最重要的是,它的总参数量高达2000B!

在数学、多语言和图像基准测试中,它提供了非推理模型的最先进性能。

当“最牛”和“最便宜”摆在一起的时候,试问哪位开发者会不心动?(doge)

训练细节

用他们自己的话来说,Llama系列是进行了彻底的重新设计。目前第一组LIama 4系列模型,他们也公布了具体的训练细节。

预训练

他们首次使用混合专家MoE架构,在MoE架构中,单个token仅激活总参数的一小部分。MoE架构在训练和推理方面具有更高的计算效率,固定训练FLOP成本情况下质量更高。

比如,Llama 4Maverick模型有17B个激活参数和400B个总参数。他们使用交替的密集层和混合专家(MoE)层来提高推理效率。

MoE层使用128位路由(Routed)专家和一位共享专家。每个令牌都会发送给共享专家以及128位路由(Routed)专家之一。

因此,虽然所有参数都存储在内存中,但在为这些模型提供服务时,只有总参数的子集被激活。

这通过降低模型服务成本和延迟来提高推理效率——Llama 4 Maverick 可以在单个H100 DGX主机上运行,以便于部署,也可以通过分布式推理实现最高效率。

他们早期融合,将文本和视觉token无缝集成到统一模型中。

他们开发了一种新的训练技术:MetaP,可以设置关键模型超参数,比如每层的学习率和初始化尺度。

结果发现,所选的超参数能在批量大小、模型宽度、深度和训练token的不同值之间很好地扩展和泛化——

Llama 4通过在200种语言(包括100多种语言,每种语言有超过10亿个词库)上进行预训练,实现了开源微调工作,多语言词库总量是Llama 3的10倍。

此外,他们使用FP8精度进行高效模型训练,同时不牺牲质量并确保模型 FLOPs的高利用率—在使用FP8和32K GPU 预训练 Llama 4 Behemoth模型时,结果他们实现了390TFLOPs/GPU。

用于训练的整体混合数据包括30多万亿个token,是Llama 3预训练混合物的两倍多,其中包括各种文本、图像和视频数据集。

在所谓的“中期训练”中继续训练模型,通过新的训练方法(包括使用专业数据集进行长上下文扩展)来提高模型的核心功能。

后训练

后训练阶段,他们提出一个课程策略,与单个模式专家模型相比,该策略不会牺牲性能。

在Llama 4中,采用了一种不同的方法来改造我们的后期训练管道:

轻量级监督微调(SFT)>在线强化学习(RL)>轻量级直接偏好优化 (DPO)。

一个关键的教训是,SFT和DPO可能会过度约束模型,限制在线强化学习阶段的探索,并导致精度降低,尤其是在推理、编码和数学领域。

为了解决这个问题,他们使用Llama模型作为评判标准,删除了50%以上被标记为简单的数据,并对剩余的较难数据集进行了轻量级SFT处理。

在随后的在线强化学习阶段,通过仔细选择较难的提示,我们实现了性能上的飞跃。

此外,他们还实施了一种连续的在线强化学习策略,即交替训练模型,然后利用模型不断过滤并只保留中等难度到较高难度的提示。事实证明,这种策略在计算量和准确性的权衡方面非常有利。

然后,他们采用轻量级DPO来处理与模型响应质量相关的拐角情况,从而有效地在模型的智能性和对话能力之间实现了良好的平衡。流水线架构和带有自适应数据过滤功能的连续在线RL策略,最后造就了现在的LIama 4。

总结来看,Llama 4架构的一项关键创新是使用交错注意力层,而无需位置嵌入。此外,他们还采用了注意力推理时间温度缩放来增强长度泛化。

这些他们称之为iRoPE架构,其中“i”代表 “交错 ”注意力层,突出了支持 “无限”上下文长度的长期目标,而 “RoPE ”指的是大多数层中采用的旋转位置嵌入。

Llama 4 Behemoth

最后,他们还透露了超大模型Llama 4 Behemoth一些蒸馏和训练细节。

我们开发了一种新颖的蒸馏损失函数,可通过训练动态加权软目标和硬目标。

预训练阶段,Llama 4 Behemoth的代码蒸馏功能可以摊销学生训练中使用的大部分训练数据计算蒸馏目标所需的资源密集型前向传递的计算成本。对于纳入学生训练的其他新数据,他们在Behemoth模型上运行前向传递,以创建蒸馏目标。

后训练阶段,为了最大限度地提高性能,他们删减了95%的SFT数据,而小型模型只需删减50%的数据,以实现对质量和效率的必要关注。

他们在进行轻量级SFT后,再进行大规模强化学习(RL),模型的推理和编码能力会有更显著的提高。

强化学习方法侧重于通过对策略模型进行pass@k分析来抽取高难度提示,并根据提示难度的增加精心设计训练课程。

此外还发现,在训练过程中动态过滤掉优势为零的提示语,并构建包含多种能力的混合提示语的训练批次,有助于提高数学、推理和编码的性能。最后,从各种系统指令中取样对于确保模型在推理和编码方面保持指令跟随能力并在各种任务中表现出色至关重要。

由于其规模空前,要为两万亿个参数模型扩展RL,还需要改造底层RL基础设施。

他们优化了MoE并行化的设计,从而加快了迭代速度;并开发了一个完全异步的在线RL训练框架,提高了灵活性。

现有的分布式训练框架会牺牲计算内存以将所有模型堆叠在内存中,相比之下,他们新基础架构能够将不同模型灵活分配到不同GPU上,并根据计算速度在多个模型之间平衡资源。

与前几代产品相比,这一创新使训练效率提高了约10倍。

One More Thing

要知道,由于昨天DeepSeek发了新论文,搞得奥特曼都坐不住了,赶紧出来发声:

计划改变:我们可能在几周之后先发布o3和o4-mini。

GPT-5就在几个月后啊~

但,谁知道半路又杀出个Llama 4?!

前有猛虎,后有豺狼,OpenAI你真的得加油了……

网友调侃道,当奥特曼一睁眼,看到Llama 4来了,而且Llama 4的成本比GPT-4.5降低了3个数量级后——

他的状态一定是酱婶儿的:

以及相比Llama,现在可能神秘低调的DeepSeek,可能不知道什么时候突然就会推出DeepSeek R2和V4…同在杭州的通义千问也干劲十足,Llama也好GPT也好,基本成为平行参考了。

太平洋这头,已经开始落地应用和智能体了。

参考链接:

[1]https://www.llama.com/

[2]https://ai.meta.com/blog/llama-4-multimodal-intelligence/

[3]https://x.com/AIatMeta/status/1908598456144531660

[4]https://x.com/lmarena_ai/status/1908601011989782976

[5]https://x.com/IOHK_Charles/status/1908635624036590070

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง