腾讯混元挖走微软明星大模型团队!一作全员出走,新成果已跻身大模型竞技场TOP 10

核心成员来自北大

鱼羊 发自 凹非寺

量子位 | 公众号 QbitAI

微软明星大模型团队,被腾讯整个挖走了。

WizardLM一作Can Xu和Kai Zheng刚刚在上官宣了此事:

WizardLM,微软明星开源模型。在GitHub上,该项目已累计9.4k标⭐️。

阶跃星辰创始人、前微软副总裁姜大昕,是相关论文的通讯作者。

加入腾讯,WizardLM团队的最新力作,正是腾讯混元的新一代快思考模型Hunyuan-Turbos——

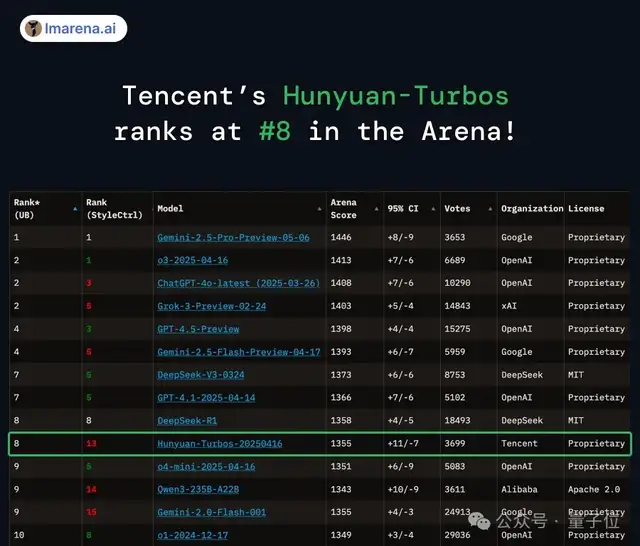

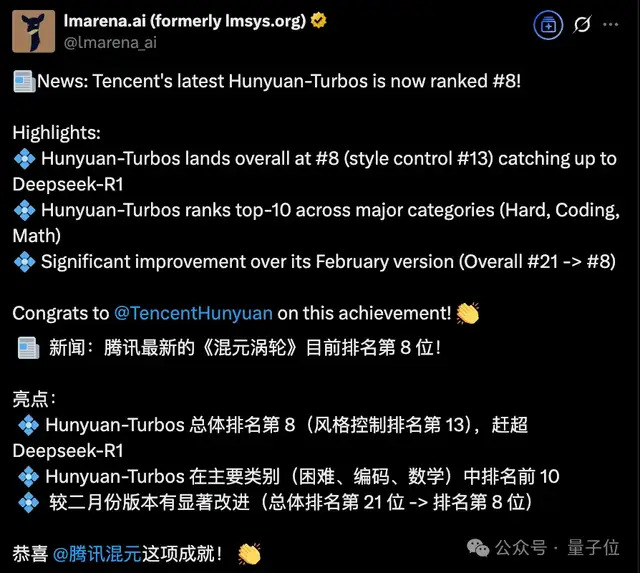

该模型刚刚在大模型竞技场榜单中跻身前10,和DeepSeek R1同列总榜第8。

核心成员来自北大

目前,WizardLM的三位一作,均已加入腾讯混元。

从领英信息上来看,Qingfeng Sun是最早投奔腾讯的一位,在去年12月就已加入。

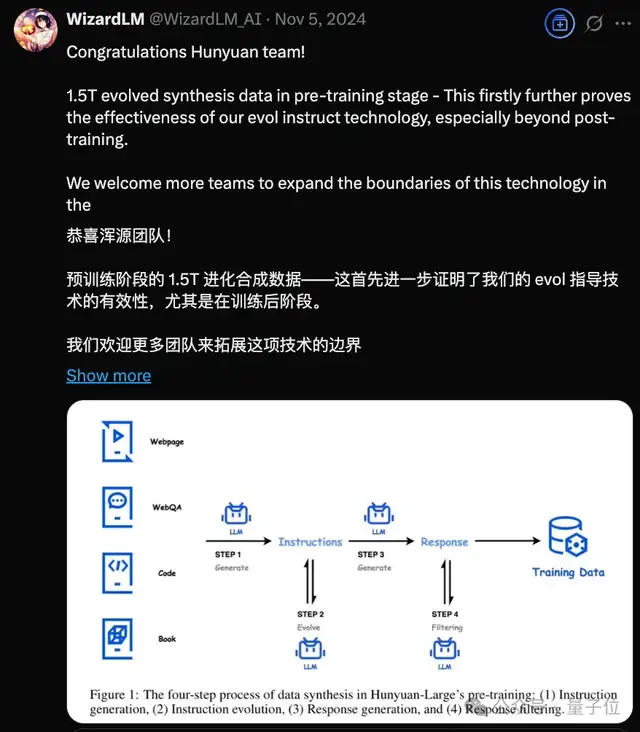

而在去年11月,WizardLM官方账号已经和腾讯混元有所互动。一条恭喜混元开源进展的推文提到,WizardLM的核心技术之一——Evol Instruct已经被用到混元的post-training中。

具体来看这几位的履历。

Can Xu,WizardLM的项目Leader。

他2017年加入微软,一直从事NLP相关研究。在开启WizardLM项目之前,也是微软小冰、Phi-3等项目的核心贡献者。2024年6月,升任微软高级研究科学家。

他毕业于四川大学计算机专业,后于北京大学获得计算机硕士学位。

Qingfeng Sun,在微软期间任NLP科学家,专注于大语言模型方向,曾为必应和Office 365贡献了核心深度模型。

他本科毕业于合肥工业大学,硕士同样毕业于北京大学。Can Xu是他在微软的mentor。

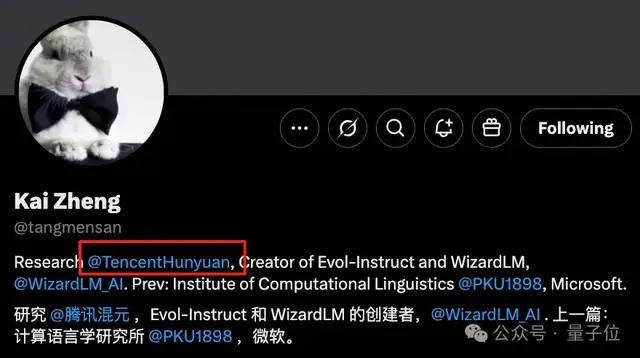

Kai Zheng,又一位PKUer。跟Can Xu都是Evol-Instruct和WizardLM的创始人。

官宣职业生涯开启新的一程的同时,WizardLM团队也公布了他们在混元的最新工作——Hunyuan-Turbos。

这是首个超大型混合Transformer-Mamba架构的MoE模型,既有Mamba高效处理长序列的优点,又集成了Transformer强大的上下文理解能力。

基准评测结果显示,Hunyuan-Turbos在数学、推理和对齐方面,有优于GPT-4o-0806和DeepSeek V3的表现。

该模型首发于今年2月,2月版本在大模型竞技场排名第21。而现在,Hunyuan-Turbos再次进化,在最新榜单中前进13名,排名第8。

值得关注的一点是,WizardLM虽然火爆一时,为微软在开源社区赚足了讨论度,但之后WizardLM-2的发布并不顺利:

开源不久又被撤回了。

官方解释是WizardLM-2在发布时遗漏了毒性测试。

但当时404的网站此后也并没有恢复。

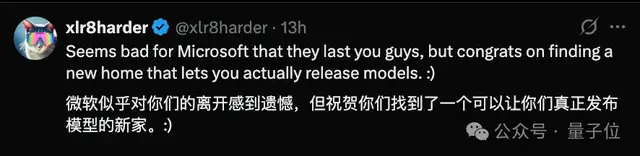

在Can Xu官宣新东家的推文下,还有网友如此祝贺:

恭喜你们找到了一个可以让你们真正发布模型的地方。

另外,微软又一波大裁员要来了:周二宣布计划裁员超过6000人。此次裁员预计将影响微软所有业务部门的员工。

国内大厂人才争夺进行时

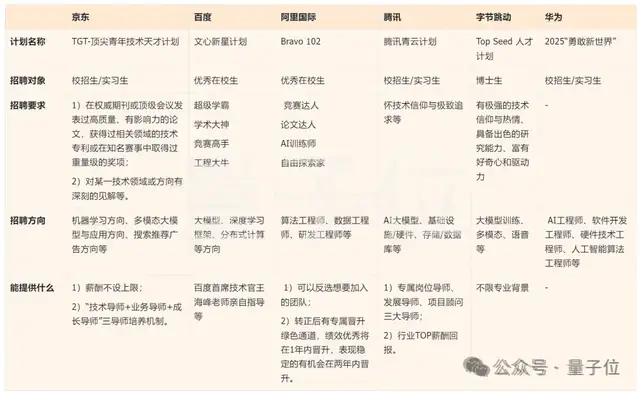

不管怎么说,可以确定的是,进入2025年,伴随着推理模型激发的新一轮基础模型之争,国内大厂抢人是越来越眼疾手快了。

不仅到处挖顶级大牛——

字节挖来谷歌DeepMind研究副总裁吴永辉、阿里招揽全球顶尖AI科学家许主洪。前几天,阿里薄列峰离职被曝加盟某大厂……

各种人才计划、AI扩招计划也是看得人眼花缭乱。

大模型的技术之争,归根到底亦是人才之争。

风云人物、时代新星们的更多动向,还看今朝。

参考链接:

[1]https://x.com/CanXu20/status/1922303283890397264

[2]https://x.com/lmarena_ai/status/1921966648795533459

— 完 —

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง