大模型参与推理崩溃论战!从「思维错觉」到「错觉的错觉」再到「错觉的错觉的错觉」

闻乐 发自 凹非寺

量子位 | 公众号 QbitAI

苹果团队一篇论文,现已升级成AI圈“论文连续剧”。

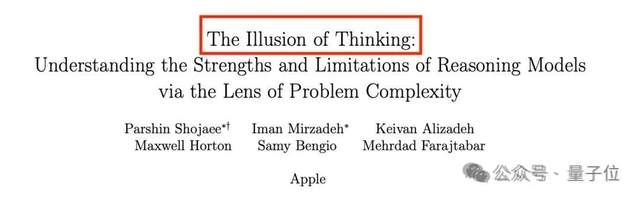

《思维的错觉》:大模型推理会崩溃。

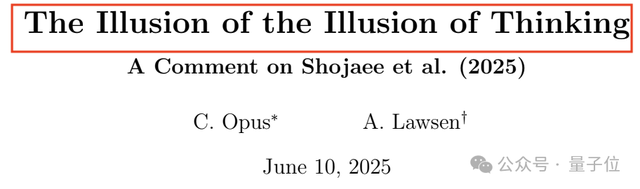

《思维的错觉的错觉》:大模型崩溃是错觉。

《思维的错觉的错觉的错觉》:大模型还是会崩溃。

起初,苹果团队发了一篇论文炮轰所有大模型推理都是假象,遇到高复杂度长推理问题时都会崩溃,即使给他们足够的时间和计算资源。

这篇文章引起了广泛关注,有人支持也有人质疑。

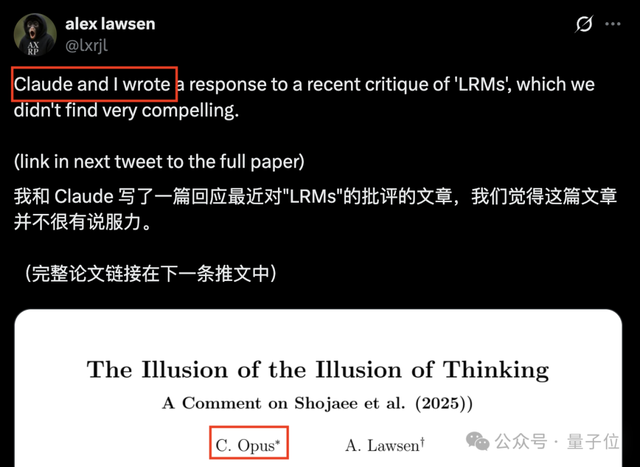

在质疑的人中,有一位网友与Claude Opus“合作”写了一篇长达5页的文章,来说明大模型这种明显的崩溃是人为因素造成的。

没多久,第三篇文章也来了,这篇综合了前两篇的观点,赞同大模型崩溃是实验设计不合理这一人为因素造成的,但也强调模型在非常长的逐步执行中仍然会出错,尽管方法有所改进,但脆弱性依然存在。

也就是说,大模型在推理过程中还是会崩溃。

基于上次的经验,网友猜测第三篇文章的第一作者或许是Gemini Pro~

让我们来看看这部“连续剧”到底在“演”什么。

大模型推理到底会不会崩溃

最新的这篇文章对前两篇内容进行了双重审视,得出的结论是:你俩说的都有道理。

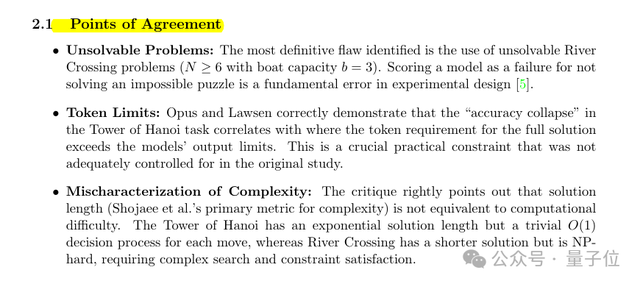

认同第二篇的三个关键修正

原研究的观点是:当题目难度超过临界点时,大模型推理会崩溃。

苹果的原研究是通过设计4类谜题环境(汉诺塔、跳棋交换、过河问题、积木世界),系统观察模型在不同复杂度下的行为变化。

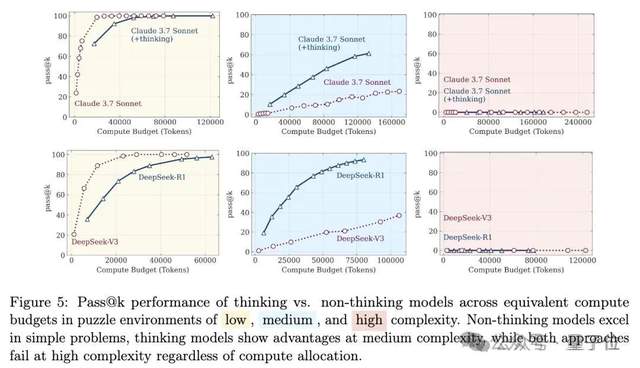

他们进行了大量实验,对比“会思考”和“不思考”的模型组合。

发现在低复杂度任务中,那些“不思考”标准语言模型实际上表现得更好。

随着任务难度进入中等水平,“会思考”的推理模型开始显现优势。

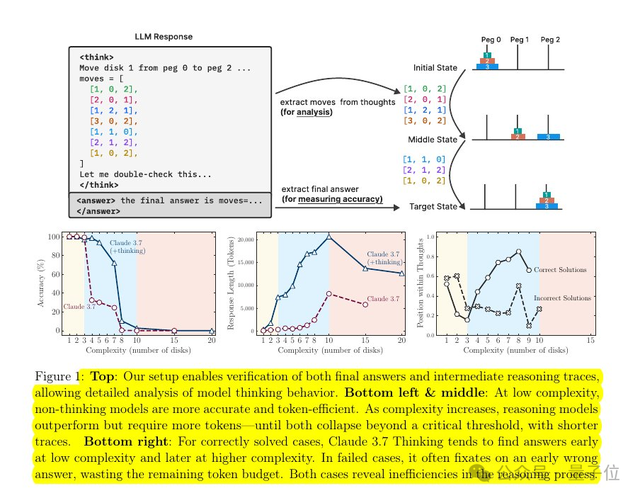

当问题复杂度继续增加并超过某个临界点时,无论是推理模型还是标准模型都会经历完全的性能崩溃,准确率直线下降至零,甚至会减少思考token。

比如汉诺塔问题,在超过大约8个盘后,标准模型和推理模型都崩溃到0%,推理模型的输出token甚至更少,这表明当前的思维链扩展在较小深度之外就失效了。

第二篇认为这里面有三个测试瑕疵,token预算限制、评估误判、以及谜题设计的数学不可解性。

于是,作者进行了模型重新验证。

- 替代表示法的有效性:当要求模型以Lua函数等紧凑形式输出汉诺塔解法时(而非枚举所有步骤),测试模型(如Claude-3.7-Sonnet、Gemini 2.5)在N=15时仍能保持高准确率,且token消耗远低于上下文限制(<5000token),证明模型具备递归算法理解能力,失败源于格式约束而非推理缺陷。

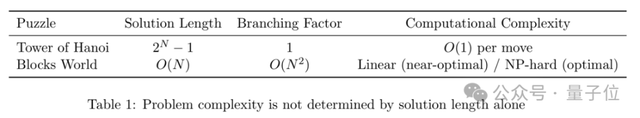

- 复杂度指标的误用:原研究以 “组合深度”(最小移动步数)衡量复杂度,但汉诺塔虽需指数级步数,每步决策复杂度仅为O(1),而积木世界因涉及最优解搜索(NP难问题),实际难度更高。模型在长序列汉诺塔问题中的表现优于短序列积木问题,印证了 “解长度≠计算复杂度” 的观点。

结论就是,原研究的 “崩溃” 本质上是实验设计对模型输出限制、谜题不可解性和复杂度误判的综合结果,而非LRMs(推理模型)的根本性推理局限。

最新的第三篇认同了第二篇的三个关键修正。

大模型在面对高复杂度长推理时还是避免不了“崩溃”

虽然认为第二篇的反驳有道理,但该作者又指出:

第二篇的实验测试的是算法知识检索与代码生成,而非原实验的 “连续执行与状态追踪”。

模型可能因训练数据包含汉诺塔算法而成功生成函数,但无法证明其能无错执行3万余步(如N=15的32767步)。

也就是说,虽然汉诺塔每步规则很简单,但模型仍可能因中间步骤误差累积导致失败。

原研究中,即使向模型提供算法提示,它仍表现为崩溃,暗示瓶颈在于执行保真度而非解法发现。

简单来说就是,虽然token限制是直接原因,但模型在长序列任务中的失败反映了 “持续高保真执行” 的内在缺陷。

并且,模型在接近 “崩溃点” 时会提前减少推理投入(如推理token数下降),这一现象无法仅用token限制解释。

也就是说,即使修正了测试设计并提供了足够的输出空间,模型一旦将逐步计划扩展到数千步,仍然会开始失去对计划的追踪。

因此,这位作者认为大模型在维持非常长的推理链方面仍然存在真正的弱点。

这或许需要后续的研究跟进。

One More Thing

目前,这部“连续剧”已经发展到了第三集,有些网友看热闹不嫌事儿大,表示想快进到第四集!

你认为第四集会是什么剧情呢?

参考链接:

[1]https://x.com/rohanpaul_ai/status/1930968053027578199

[2]https://x.com/rohanpaul_ai/status/1933296859730301353

[3]https://x.com/rohanpaul_ai/status/1935746720144544157

— 完 —

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง