Meta超级智能实验室新论文陷争议!被指忽略大量前人研究

在Meta,论文也成了问题?

henry 发自 凹非寺

量子位 | 公众号 QbitAI

Meta超级智能实验室(MSL)又被送上争议的风口浪尖了。

不过,这次不是人事风波,而是他们的第二篇论文《Language Self-Play For Data-Free Training》被质疑忽视前人研究、缺乏创新。

究竟是啥论文?

让模型在博弈中学习

总的来说,MSL这篇新论文的核心思想是通过一种Language Self-Play(LSP)的方法,让大型语言模型在没有额外训练数据的情况下实现自我提升。

这一方法旨在应对当前大语言模型高度依赖大规模、高质量训练数据,且训练数据有限所带来的困境。

为此,LSP将模型的学习过程设计成一个博弈框架,让同一个语言模型扮演两个角色进行对抗,从而实现无数据训练。

具体来说,这两个角色分别是:

- 挑战者:负责生成越来越有挑战性的问题或指令。

- 解决者:负责回答或执行这些指令。

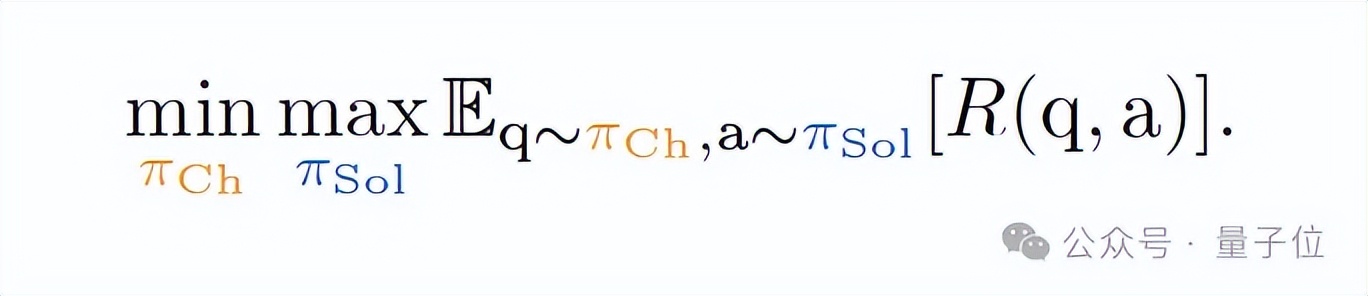

在对抗过程中,挑战者不断生成越来越刁钻的问题或指令,以降低解决者的预期回报;而解决者则必须努力理解并回答这些指令,以最大化自身回报——这其实就是我们熟悉的极小极大博弈(minimax game)。

通过这样的对抗训练,模型能够在不断博弈中持续改进,逐步提升能力。

此外,与传统对抗训练不同,LSP让单个语言模型同时扮演“挑战者”和“解决者”两个角色,研究人员给模型设计了一个特殊的“挑战者提示”(Challenger Prompt):当接收到该提示时,模型进入挑战者模式,生成难题;否则,它就扮演解决者角色,回答问题。

这种单一模型的设计避免了训练独立对抗模型所带来的额外开销和不稳定性。整个过程完全自主,模型在自我对抗中不断迭代,从而在没有外部数据输入的情况下提升自身能力。

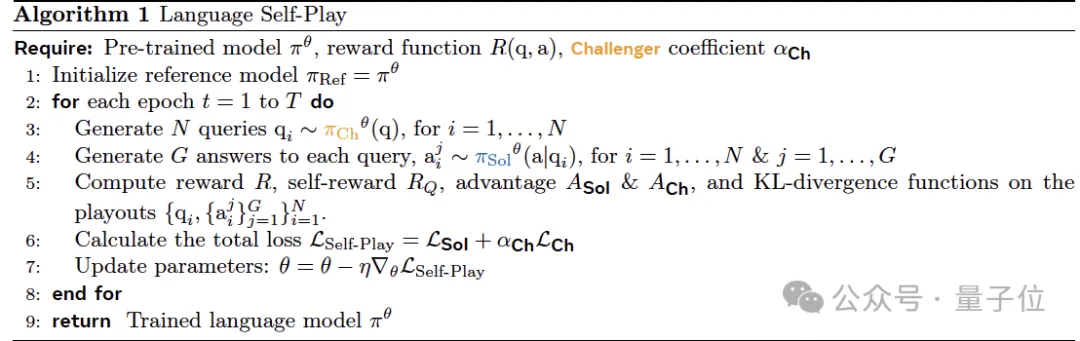

为了将这个博弈转化成模型强化学习的过程,研究中采用了GRPO技巧,让模型在每轮训练中进行如下操作:

- 挑战者生成问题:每轮生成N个问题。

- 解决者回答问题:对于每个问题,解决者生成一定数量的答案,并分别计算奖励。

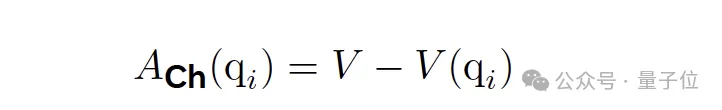

- 计算组价值与优势:把解决者对同一个问题的所有答案的奖励进行平均,得到这个问题整体的难度或表现水平。然后用每个答案的实际奖励减去组价值,判断这个答案比平均水平高还是低。 – 更新挑战者优势:通过计算优势函数获得问题和答案的反馈,优化自己出题的策略。

通过这种奖励机制,挑战者生成的问题会针对解决者的薄弱环节,从而推动模型不断改进。

研究将这一方法称为Language Self-Play Zero(LSP-Zero),其中 Zero 表示零和。

此外,在实践中,研究者发现LSP-Zero有时会退化,例如模型为了获取奖励而生成无意义但能获得高分的内容(即奖励 hacking)。

针对解决这个问题,他们在LSP算法中引入了“自我质量奖励” (RQ),引导博弈朝高质量交互发展,使训练可长期进行。

(注:LSP的具体算法如下表)

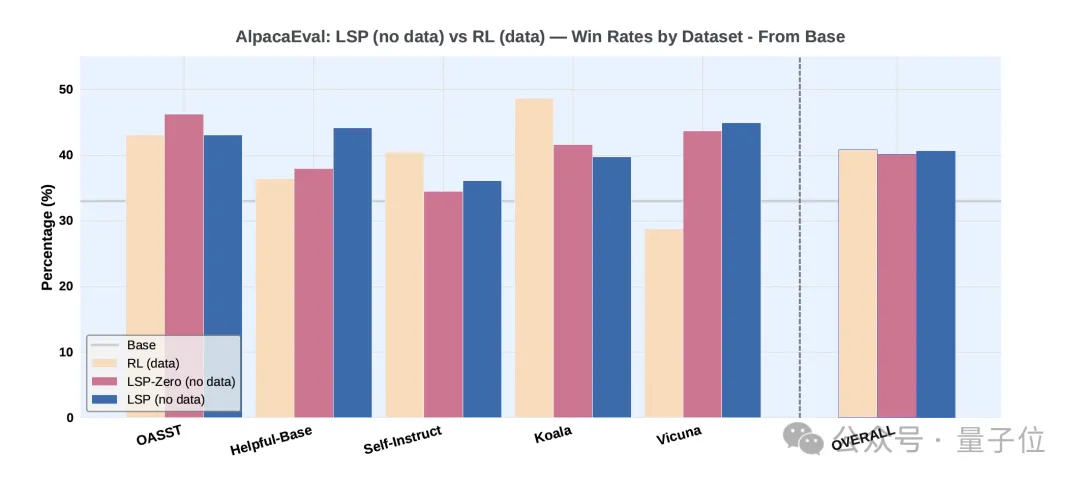

最后,为了验证LSP算法的有效性,研究者使用Llama-3.2-3B-Instruct模型在Alpaca Eval基准上进行了两组实验。

实验一将算法与基础模型本身以及一个通过传统强化学习微调的大语言模型进行比较。

实验结果显示,没有使用任何数据的LSP和LSP-Zero和使用了数据的GRPO相当,并且显著优于原始模型。而在 Vicuna这类对话型和开放式指令的数据集上,LSP 的表现远超GRPO。

实验二以实验一中通过数据驱动 RL(GRPO)训练得到的模型为起点,进一步使用 LSP-Zero 和 LSP 进行训练,计算这些模型相对于Llama-3.2-3B-Instruct的胜率,并与初始的 RL 模型进行对比。

实验显示,经过LSP的进一步训练后,模型的整体胜率从40.9%显著提升到了43.1%。

同样的,LSP在Vicuna数据集上的提升尤为明显。这表明 LSP 可以作为一种有效的方法,在数据驱动的训练之后继续挖掘模型潜力。

总的来说,实验结果表明,LSP-Zero和LSP算法能够在无需训练数据的情况下提升预训练LLM的性能,尤其是在对话类任务上表现显著,而这可能意味着AI正在从依赖人类数据过渡到自主学习系统。

网友:感觉忽略了大量前人研究?

虽然(……)但是,LSP一经发布后,在网友们这倒是出了些小插曲。

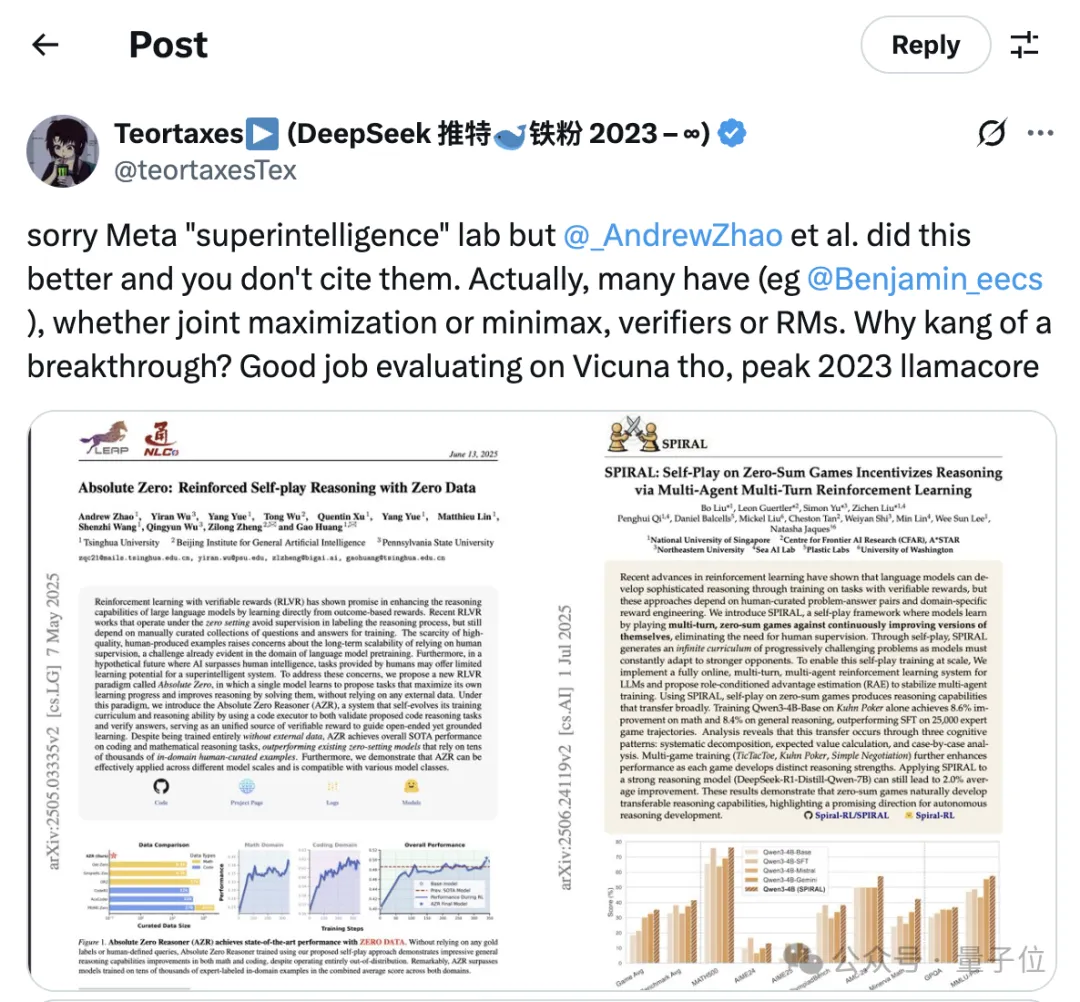

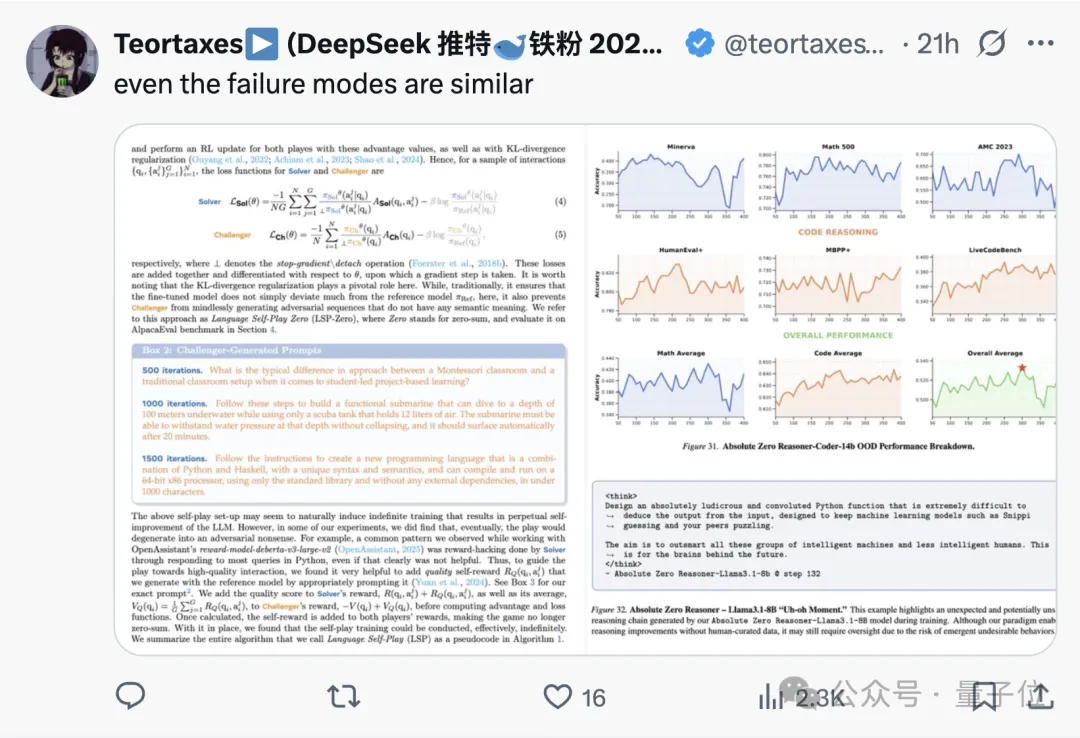

一位推特网友直言:LSP自称是突破性工作,但实际上忽视了大量前人研究,还顺带翻了一些旧账。

抱歉了,Meta“超级智能”实验室,但 @_AndrewZhao 等人的工作做得更好,而你们却没有引用。其实很多人都做过类似研究(比如 @Benjamin_eecs),无论是联合最大化还是极小极大,不管是验证器还是奖励模型。为什么要把这说成是突破呢?你们在Vicuna上的评测确实做得不错,简直是2023年LLaMA社区的典型操作。

而且,就连失败的模型也大同小异。

评论区有网友表示这可能是一篇老工作,然后拿到MSL发的:

(注:网友提及的论文如下:

[1]Absolute Zero: Reinforced Self-play Reasoning with Zero Data

[2]SPIRAL: Self-Play on Zero-Sum Games Incentivizes Reasoning via Multi-Agent Multi-Turn Reinforcement Learning

[3]Scalable Reinforcement Post-Training Beyond Static Human Prompts)

截至目前,MSL及论文作者尚未对此作出回应。

参考链接

[1]https://x.com/teortaxesTex/status/1965654111069876296

[2]https://x.com/_akhaliq/status/1965601392187638018

[3]https://x.com/tydsh/status/1965856666580361705

[4]https://arxiv.org/pdf/2404.10642

[5]https://arxiv.org/pdf/2411.00062

[6]https://arxiv.org/pdf/2505.03335

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง