太疯狂了!Meta裁员裁到田渊栋头上,连组员一锅端

亚历山大王这招太狠了

梦晨 发自 凹非寺

量子位 | 公众号 QbitAI

很疯狂,Meta AI裁员能裁到田渊栋头上,而且是整组整组的裁。

田渊栋在Meta工作已超过十年,现任FAIR研究科学家总监(Research Scientist Director),他领导开发了早于AlphaGo的围棋AI“Dark Forest”,近期在大模型领域也推出了整合快慢思考的Dualformer模型、以及开创性的“连续思维链”(Coconut)范式。

这样一位大佬突然面临找工作了,OpenAI以及各路初创公司反应都很快,直接开始在评论区排队抢人。

看来这次由新任首席AI官亚历山大王主刀的Meta AI大裁员,不只是明面上精简组织那么简单,

田渊栋其人

田渊栋拥有上海交通大学计算机系的本科和硕士学位,随后在卡内基梅隆大学(CMU)机器人研究所获得博士学位。

约在2014年,田渊栋加入Facebook(现Meta)的人工智能研究院(FAIR),至今已近十年。

在DeepMind的AlphaGo震惊世界之前,田渊栋团队已在围棋AI领域取得重要进展。

2015年,田渊栋主导发布了围棋AI“Dark Forest”,达到了顶尖业余棋手的水平。在AlphaGo之后,田渊栋团队基于AlphaGo Zero和AlphaZero的算法,完成了开源复现项目ELF OpenGo,仅靠单GPU就能战胜世界顶级的人类选手。

2017年起,田渊栋的研究重心转向AI的可解释性与基础原理

2019年,OpenAI联合创始人Ilya Sutskever曾邀请田渊栋加入,共同研发语言模型,田渊栋因希望专注于“理解神经网络模型的工作原理”而拒绝了邀请。

语言模型爆发后,Transformer成为AI研究最重要的工具,田渊栋还是坚持他认为更根本的的研究道路,不是简单训练发布模型,而是致力于提高LLM在复杂推理和规划任务上的能力。

下半年开始,他在AIR负责领导一个专注于规划和推理方向的团队,团队规模约为10人,展开了一系列研究。

- 内存高效的训练方法GaLore: 将预训练7B模型所需的内存压缩至24GB以内,使得在单张消费级显卡(如RTX 4090)上进行预训练成为可能

- 快慢思考整合Dualformer:通过在训练中随机移除推理链的部分步骤,使模型能够动态切换“快思考”(对简单问题直接给出答案)和“慢思考”(对复杂问题展开深入推理)

- Coconut连续思维链:不再依赖离散的自然语言思维链,而是将推理轨迹压缩并保留在连续的隐空间中。

- 理论探索CoGO:揭示了由梯度下降获得的神经网络解与代数结构之间存在关联,增加了对神经网络表示能力的理解。

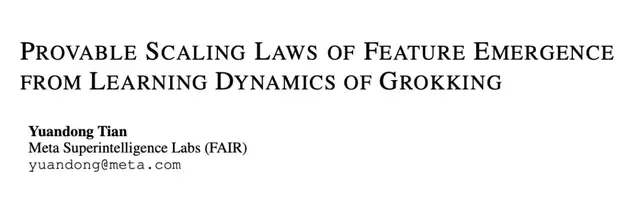

就在刚刚过去的9月,他还发表了一篇独作论文,揭示了揭示了关键超参数对“顿悟”(Grokking)中扮演的角色,从梯度动力学的第一性原理揭示了为什么像 Muon 这样的最新优化器可以有效的根本原因。

……

One More Thing

除了科研,田渊栋也是一位科幻小说家,第一部长篇小说作品《破晓之钟》于2024年出版。

在他的2024年个人年终总结里,还透露接下来的第二部长篇小说会尝试使用AI辅助写作。

他在职场遭遇的疯狂经历,能化作创作的灵感也说不定。

参考链接:

[1]https://x.com/tydsh/status/1981167436859920861

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง