LeCun离职前的吐槽太猛了

“LLM到不了AGI”

好一个一吐为快!

年底就要正式离开Meta的LeCun,这下真是啥都不藏了。

不看好大语言模型能通往AGI,他就言辞犀利地指出:

通往超级智能之路——只需训练大语言模型,用更多合成数据训练,雇佣成千上万的人在后训练中“教育”你的系统,发明强化学习的新花招——我认为这完全是胡说八道。这根本行不通。

看不惯即将成为“前任”的Meta的封闭作风,他也直言不讳:

Meta正在变得更加封闭……FAIR被推动去从事一些比传统上更偏向短期的项目。

而且还顺带剧透,自己将要创办的新公司仍会继续坚持开放。

以上内容来自LeCun最新参与的一档播客节目。在接近两小时的对谈中,他主要回答了:

- 为什么硅谷对扩展语言模型的痴迷是一条死路?

- 为什么AI领域最难的问题是达到狗的智能水平,而非人类的智能水平?

- 为什么新公司选择构建在抽象表示空间中进行预测的世界模型,而非直接生成像素的模型?

- ……

总结起来就是,不管是在Meta接近12年的研究经历,还是接下来要创办的新公司,抑或是未来想要实现的AGI,通通都在这里了。

人生下一程:创办新公司AMI

告别工作十二年的老东家,LeCun的下一步已然明了——创业。

做的还是之前在Meta被打压的世界模型。

LeCun透露,自己的公司名叫Advanced Machine Intelligence(AMI),将优先专注于世界模型的研究,而且开源……

这一招算是把和Meta的矛盾摆在台面上了。

毕竟众所周知,自从亚历山大王走马上任,Meta就开始急转方向盘,从原来的开源先锋变得越来越封闭。

△图片由AI生成

LeCun更是直言不讳:

FAIR曾对AI研究生态产生了巨大影响,核心就在于高度开放的理念。但在过去几年里,包括OpenAI、谷歌、Meta都在变得封闭。

所以与其留在Meta任人宰割,不如自己出来做喜欢的研究。

而且LeCun强调,如果不公开发表研究成果,就算不上真正的研究。故步自封,只会陷入自我欺骗,不让学术界检验,就很可能只是一厢情愿的妄想。

他曾见过很多类似现象:内部对某个项目大肆吹捧,却没意识到其他人正在做的事情其实更优秀。

更何况Meta现在只追求短期项目影响,实则难以做出有价值的贡献,要突破就要公开发表成果,这是唯一的途径。

所以新公司走的是一条和Meta现在截然不同的路。

不止要做研究,还会推出围绕世界模型、规划能力的实际产品,AMI的终极目标是成为未来智能系统的主要供应商之一。

之所以选择世界模型,是因为LeCun认为:

构建智能系统的正确打开方式就是世界模型。

这也是他多年来一直致力于研究的内容,在纽约大学和Meta的多个项目中,已经取得了快速发展,现在也是时候将研究落地了。

至于他离职后,自己一手打造的FAIR会驶向何处?LeCun也透露了一二。

首先他表示,亚历山大王不是他在Meta的继任者。

亚历山大王的内部职责更偏向于整体运营管理,而非专门的科研人员,超级智能实验室也由他领导,下设四个部门:

其中FAIR被交给了Rob Fergus领导,他也是LeCun在纽约大学的同事,目前FAIR内部减少了对论文发表的重视,更倾向于短期项目和为TBD实验室的前沿模型提供支持。

而LeCun自己目前仍然是FAIR的AI科学家,不过任期只剩下最后三周。

LeCun的离开,标志着Meta以FAIR为代表的、长达十年的“学院派”研究黄金时代的彻底结束,也标志着LeCun自己离开LLM转投世界模型的决心。

那么问题来了,为什么LeCun认为世界模型正确、LLM错误呢?

要做的世界模型和LLM“根本不是一回事”

核心原因在于,LeCun认为它们本质上是为了解决不同的问题而生,二者“根本不是一回事”。

前者是为了处理高维、连续且嘈杂的数据模态(如图像或视频),这些构成了与现实世界进行感知和交互的基础;

后者在处理离散、符号化的文本数据上表现出色,但不适合处理上述现实世界数据,LeCun对其评价为“完全糟糕”。

他还断言,处理图像视频类数据“就不能使用生成模型”,尤其不能使用那种将数据tokenize化为离散符号的生成模型(而这正是大多数LLM的基础)。

大量经验证据表明,这根本行不通。

基于此,LeCun坚信仅靠训练文本数据,AI永远不可能达到人类智能水平。

他在对比了LLM训练所需的海量文本数据(约30万亿tokens)与等量字节的视频数据(约15000 小时)后发现:

15000小时的视频信息量相当于一个4岁孩子一生中清醒时接收到的视觉信息总量,但这仅相当于YouTube半小时的上传量,而且后者信息结构更为丰富、冗余度更高。

这表明,视频这样的真实世界数据,其内部结构比文本丰富得多。

△图片由AI生成

正是因为深刻认识到“文本无法承载世界的全部结构与动态” ,LeCun将目光重新投向了一条更接近人类学习本质的路径——让机器像婴儿一样,通过观察世界的连续变化,主动构建一个内在的、可预测的模型。

而这,就是LeCun眼中世界模型的画像。

在他看来,世界模型的关键作用就是预测特定动作或一系列动作所导致的后果,其核心基石为预测和规划。

- 预测:能够基于当前状态和潜在行动,推演出未来可能的状态(或状态的抽象表示);

- 规划:以预测为基础,通过搜索和优化,来确定实现预设目标的最佳行动序列。

至于怎样才能算一个“好的”世界模型,LeCun反驳了需要完美模拟现实的观点,强调了抽象的重要性*。

以前很多人认为世界模型必须是“重现世界所有细节的模拟器”,就像《星际迷航》中的全息甲板那样。

(全息甲板是一个特制的封闭房间,内部由计算机控制,能够通过全息投影技术生成三维的、逼真的环境和物体。)

但LeCun认为,这一想法是“错误且有害的”,实践证明抽象有时候往往更有效。

所有科学和模拟都通过“发明抽象”来工作,例如计算流体力学忽略了分子等底层细节,只关注宏观变量(如速度、密度、温度),而这种抽象能够带来“更长期、更可靠的预测”。

因此,有效的方法是学习一个抽象的表示空间,它会“消除输入中所有不可预测的细节,包括噪声”。

由此他也总结道,世界模型不必是完全的模拟器,“它们是模拟器,但在抽象表示空间中”。

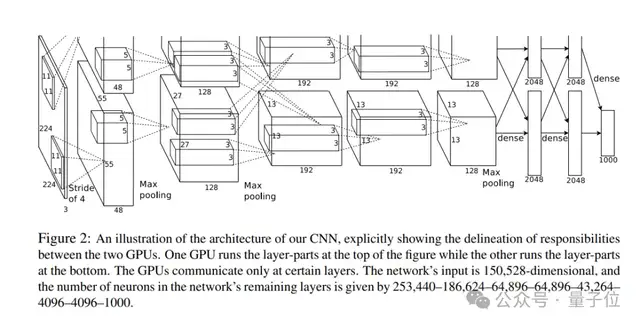

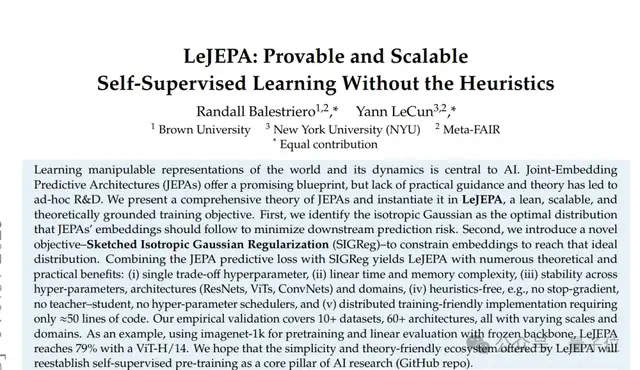

至于具体实现方式,他目前想到了通过联合嵌入预测架构(JEPA)在这一抽象表示空间中进行预测。

而关于JEPA想法是如何诞生的?LeCun带我们回顾了20年来“AI如何学习”的曲折发展史。

从无监督到JEPA

LeCun坦言,在长达近二十年的时间里,他一直坚信构建智能系统的正确路径是某种形式的无监督学习。

这就和婴儿看世界一样,他们不是被“标注”后才认识世界的。同理,真正的智能也不可能依靠海量人工标注数据来构建。

因此,他一开始就将重点放在了无监督学习上,这种“让机器自己从原始数据中发现规律”的设计完美契合了他的理念。

说干就干,他开始尝试训练自编码器(Autoencoders)来学习表示。

其核心逻辑是:先压缩,再还原。

比如将一张图片(输入数据)经由编码器压缩成一个紧凑的、低维的“摘要”(即表示或特征);然后将这个“摘要”经由解码器重构,还原为一张与原始输入尽可能相似的图片。

一旦这个“摘要”能够近乎完美地还原出原始输入,那么合理推测它必然抓住了数据中最关键、最本质的信息。

因此,如果后续有其他任务用到这个“摘要”,其表现大概率也不错。

然而,后来的研究让LeCun意识到,“坚持表示必须包含所有输入信息的直觉是错误的”。

因为他发现,AI在上述学习过程中存在“作弊”现象。

就像数学上的“恒等函数”所代表的含义——输出只是输入的另一种形式,AI根本不理解自己所学的内容,它们只是在“抄答案”。

而连理解都没有,又何谈真正的智能呢?

于是,LeCun接着引入了“信息瓶颈”(Information Bottleneck)这个核心思想来纠正方向。

其目的是限制表示的信息内容,从而迫使系统学习更精简、更有用的表示,也即所谓的抽象能力。

后来他与多位学生在这一方向上做了大量工作,希望以此预训练非常深的神经网络。

然而,随着深度学习迎来历史转折点——全监督学习开始崛起,有关无监督或自监督学习的研究一度被搁置。

当时的情况是这样的。

在2010年代初期,研究者们面临一个核心难题:理论上有强大表达能力的深度神经网络,在实践中却极其难以训练。 梯度不是消失就是爆炸,网络深层的参数几乎学不到东西。

而几项简洁却革命性的工程改进,彻底改变了局面。

一个是ReLU(线性整流函数)的胜利。之前大家普遍使用Sigmoid或Tanh作为激活函数,它们的梯度在两端会变得非常平缓(饱和区),导致反向传播时梯度信号迅速衰减,无法有效更新深层权重。这就是“梯度消失”问题。

而ReLU的梯度在正区间恒为1,完美解决了梯度消失问题,计算速度也极快,几乎凭一己之力让训练可以深入到数十甚至上百层。

另一个是归一化(Normalization)开始发威。随着网络层数加深,每一层输入的分布都会发生剧烈偏移,这迫使后续层需要不断适应新的数据分布,大大拖慢了训练速度,也使得学习率等超参数设置变得极其敏感。

而归一化技术使得每一层的输入进入激活函数前,强行将其归一化到均值为0、方差为1的标准分布。这就像给每一层安装了一个“自动稳压器” ,确保了训练流程的平稳。

正是这些改进的结合,使得研究者第一次能够可靠、高效地训练出非常深的神经网络。

换言之,深度网络的威力终于从理论照进了现实。

而且更幸运的是,技术的突破还遇上了数据的爆炸——包括李飞飞带头创建的ImageNet和一些大型文本语料库等大规模高质量标注数据集,越来越多地被创建和公开。

在技术和数据的双重红利下, 监督学习在当时表现良好(比如大名鼎鼎的AlexNet引爆“深度学习革命”)。

直到2015年,LeCun开始再次思考如何推动人工智能达到人类水平。他观察到,当时主流的强化学习方法在样本效率方面极其低效,“无法实现目标”。

因此,他重新将研究重心转向了世界模型和规划,即一个能够预测其行动后果并能进行规划的系统。

他最初的设想很直接:要建立一个世界模型,那就让它像物理模拟器一样,预测下一帧画面的每一个像素。

这一想法和当时主流的观点不谋而合,但事实证明它错了。

我起初和当时所有人的做法一样,犯了试图在像素级别预测视频的错误,这实际上是不可能的,因为预测是非决定性的。

因为现实世界往往充满随机性。比如预测一杯水被打翻后,每一颗水珠的确切轨迹和形状,是不可能的。未来有无限多种可能的像素级状态。

如果强行训练一个确定性模型来预测像素,它为了最小化误差,通常会学会输出一个所有可能未来的模糊平均。这就是为什么早期视频预测模型生成的画面总是模糊不清的原因——它不是预测,而是“和稀泥”。

而为了解决不确定性,LeCun最初尝试了潜变量模型。这就像给模型一个“随机数骰子”(潜变量),允许它根据骰子的不同结果,生成不同的未来画面。

不过LeCun最终意识到,这本质上仍是在像素空间中工作,没有触及核心。

直到这时,主打“在抽象表示空间中进行预测”的JEPA架构终于应运而生。

其灵感源自LeCun在90年代研究的Siamese Networks,只不过一直面临一个巨大的难题——防止系统崩溃(Collapse)。

在训练过程中,模型可能将所有输入映射到单一的点或低维空间,导致嵌入空间中的样本不可区分,从而无法有效捕捉样本间的语义差异。

为了解决这个问题,LeCun依次尝试了对比学习、非对比学习的方法,最新进展就是LeJEPA技术。

LeJEPA核心提出了一种基于各向同性高斯嵌入的自监督学习方法,通过引入SIGReg正则化,有效解决了表示崩溃问题,并显著提升了模型的泛化能力。

LeCun认为,“LeJEPA+SIGReg”是训练模型学习抽象表示的“非常有前途的技术集合”,并预计未来一两年内在这个领域将会有更多进展。

“LLM无法通往AGI,最难的是达到狗的智能水平”

基于上述,LeCun判断,那些号称一两年就能实现AGI的人完全是痴心妄想。

因为现实世界远比token化的文本复杂,仅靠现在的LLM路线不可能直接实现AGI。

更何况对于AGI这个概念,LeCun本身就觉得毫无意义。

AGI通用智能指的是人类水平的智能,但事实上人类智能是高度专业的,比如人类擅长处理现实世界的问题(导航、互动),但在棋类任务上表现差劲。

甚至在很多任务上,其实动物比人类更擅长,而人类之所以自诩为“通用”,只是因为人类自认为能处理所有可以想象到的问题,但很多想象之外的问题,人类其实无法做到。

所以与其讨论人类水平的智能,不如讨论机器是否可以在人类擅长的领域达到或超越人类。

毫无疑问,答案是肯定的。已经有机器在部分领域超越人类,但要说全部领域,则需要一个渐进的过程,而非突发事件。

可预见的是,在未来几年,世界模型、规划能力这方面或许能取得概念性突破,这将为实现人类水平的AI铺平道路。

但这还远远不够,还需要很多的基础概念铺垫,需要新的理论创新才能突破当前人类智能的瓶颈。

总的来说,人类智能距离人类还很遥远。

而且并非大家所普遍认知的那样:“人类智能难以实现,那么低一档的狗级智能或许更容易实现”。

LeCun认为恰恰相反,实现人类智能的过程中,最难的反而是达到狗的智能水平。

能够达到狗级智能,说明在研究人类智能上已经具备了大量的基础理论,再从狗级智能到人类智能就容易得多。

因为灵长类动物和人类的差异,除了大脑尺寸的增长,关键在语言。语言其实是由大脑中很小的一块区域(Wernicke区和Broca区)负责,而这些区域在不到100万年(甚至200万年)前才进化出,复杂性并没有想象中那么高。

现在的LLM就可以很好地扮演这一区域的角色,将语言编码为抽象表征,并将思想解码为文本,而世界模型则相当于大脑的前额叶皮层,负责规划和决策。

所以LeCun的观点是,单靠LLM或者单靠世界模型是无法实现真正的人类智能的,这需要很多的相关研究支撑,也需要很多时间完成。

也正因为如此,老爷子LeCun说他还不能退休。

拒绝退休,人生目标是提升人类智能

事实上,今年LeCun就已经65岁了。

花甲之年、荣誉等身,LeCun的妻子也希望他退休回归家庭,但LeCun如今还要大龄创业,据他所说,原因只有两个字——“使命”。

大道至简,LeCun的一生都在追求的,无非是提升人类的智能。

他说,智能是世界上最稀缺的资源,人类和地球的发展总是受到智能总量的限制,这也是为什么人类会前仆后继地投入大量资源进行教育、发展机器。

所以回顾LeCun整个职业生涯的全部研究项目,都紧紧围绕着“让人类更聪明”这一核心目标:

作为教授,LeCun教书育人;作为机器智能的研究者,LeCun希望通过机器辅助人类提升智能;通过社交媒体发声,公开传播AI和科学知识,让更多人了解相关领域……

LeCun表示:

为了这一目标,我愿意继续做出贡献。

不过他也坦然表示,这么多年的职业生涯里,他也有遗憾。

很多想要做的想法,都没有足够的时间去做,结果同行们比他抢先一步发表,典型的比如反向传播算法 (backpropagation)。

他曾发表过一篇关于训练多层网络的目标传播算法论文,那时他就衍生想到了反向传播的核心思路,但受时间和精力限制没能做成,后来David Rumelhart和Hinton发表了相关论文,并引用了LeCun的论文。

类似的事情还有很多,但LeCun并不后悔。

在他的视角里,一个好的想法的涌现往往是复杂的,很少有人能在完全孤立的情况下提出全新的想法。

这在科学界里再正常不过,所以不能只把功劳归结于第一个产生想法的人,那些将想法落地的人同样需要巨大的努力。

或许正因如此,他才始终坚持开源的技术路径——在他看来,科学的进步从来都不是少数天才的灵光乍现,而是无数人思想在开放交流中的不断叠加延伸。

因此再回头看LeCun的离职,其实并不突兀。

当Meta已经不再是那个鼓励长期开放研究的“科学乌托邦”,LeCun的离开,几乎成为一种必然。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง