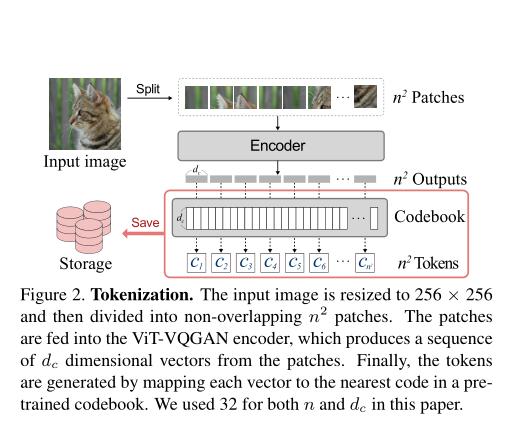

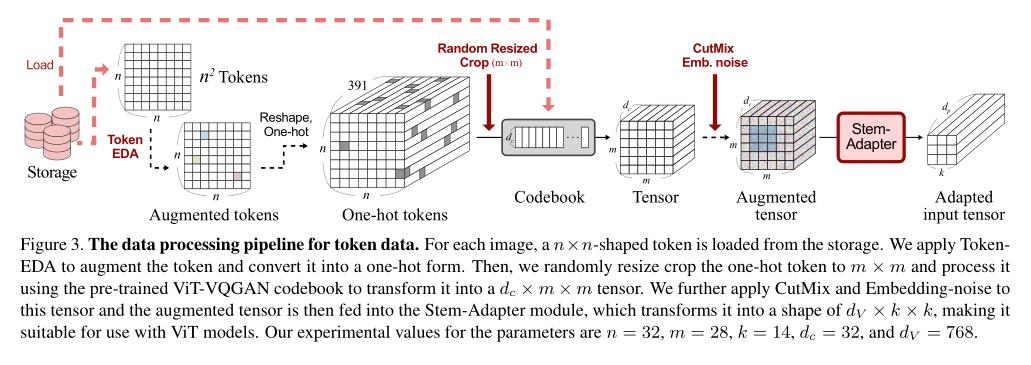

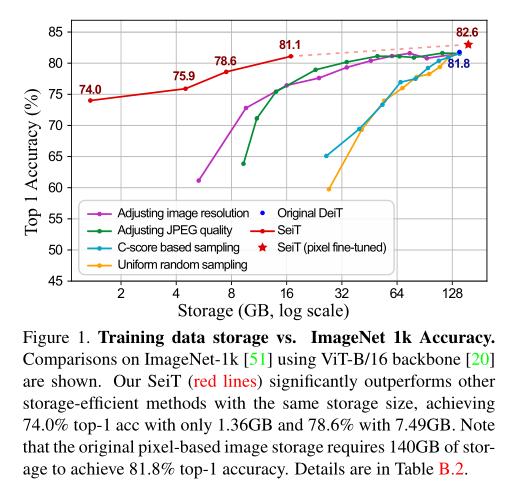

为了得到通用和精确的视觉大模型,训练图像数据的规模已经发展到了十亿级别,促使研究研究人员必须在训练过程中配置大量的存储资源。然而,这一条件并不实际,因此一系列存储优化训练方法(storage-efficient training methods)被研究人员提出,但它们大多会造成模型性能的退化。在本文中,作者提出一个新的策略,可以将视觉大模型的训练存储压缩到每个实例仅需1024个Token,且相较于原始像素,仅需要1%的存储资源。作者进一步提出了Stem-adaptor模块和Token增强策略提升训练效率。实验证明,本文提出的方法在预训练、持续学习多个设定下都能以低存储损耗的条件训练得到更好的视觉大模型。

论文地址:https://arxiv.org/pdf/2303.11114.pdf

开源代码:https://arxiv.org/pdf/2303.11114.pdf

作者:Song Park Sanghyuk Chun Byeongho Heo Wonjae Kim Sangdoo Yun

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ดูบอลสด

Very well presented. Every quote was awesome and thanks for sharing the content. Keep sharing and keep motivating others.

ดูบอลสด

Very well presented. Every quote was awesome and thanks for sharing the content. Keep sharing and keep motivating others.