GTC 2024 来了。

在今天凌晨的发布会上,英伟达 CEO 黄仁勋发布了新的 AI 芯片,继 Ampere A100、Hopper H100 芯片之后新产品——Blackwell B200,专为超大参数大模型打造的目前最强 AI 芯片。

除此之外,英伟达还发布了诸多新产品:可以云上进行 AI 推理和部署的 NIM、人形机器人的新平台 Project GR00T、以及 Ominiverse 的诸多更新。

01

Blackwell B200

目前性能最强大的 AI 芯片

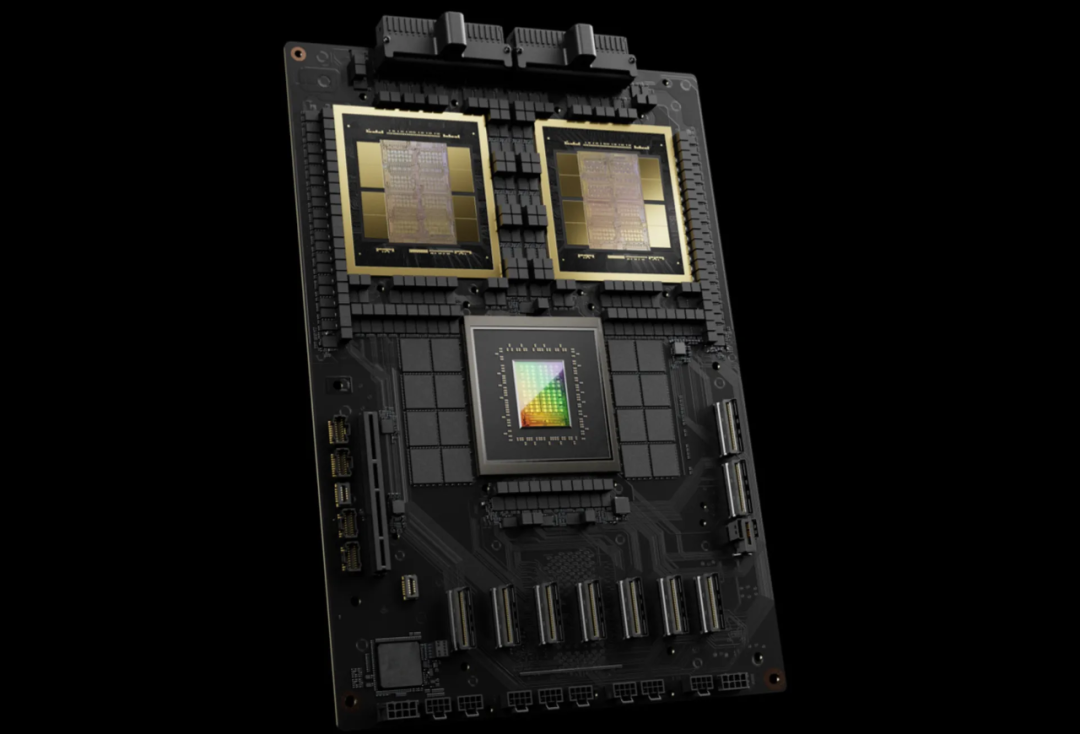

这是 GB200,包含两个 B200 GPU 和一个基于 Arm 架构的 CPU。

新一代 AI GPU 被命名为 Blackwell。该 GPU 平台以数学家 David Harold Blackwell 的名字命名,继承了英伟达两年前推出的 Hopper 架构,第一款 Blackwell 芯片称为 GB200,将于今年晚些时候出货,目前尚未透露价格。

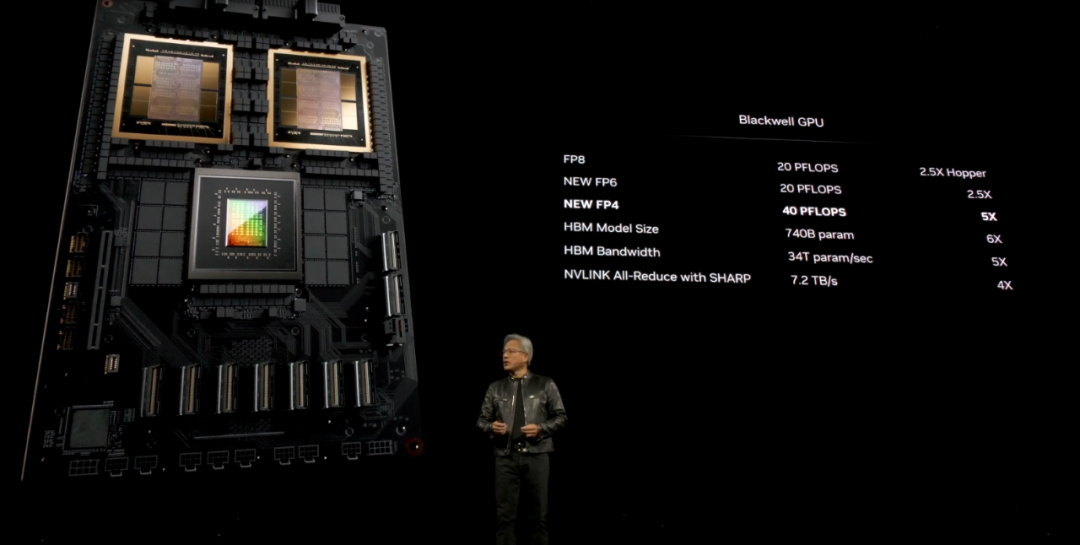

据老黄介绍,B200 拥有 2080 亿个晶体管(而 H100/H200 上有 800 亿个晶体管),采用台积电 4NP 工艺制程,可以支持多达 10 万亿个参数的 AI 模型,而 OpenAI 的 GPT-3 由 1750 亿个参数组成。它还通过单个 GPU 提供 20 petaflops 的 AI 性能——单个 H100 最多可提供 4 petaflops 的 AI 计算。

与 H100 相比,它「将成本和能耗降低高达 25 倍」。

训练一个 1.8 万亿参数的模型以前需要 8000 个 GPU 和 15 兆瓦的电力。如今,黄仁勋表示,2000 个 Blackwell GPU 在仅消耗 4 兆瓦电力的情况下就能完成这一任务。在一个拥有 1750 亿参数的 GPT-3 基准测试中,英伟达表示,GB200 的性能大约是 H100 的七倍,而且英伟达声称它提供了 4 倍的训练速度。

还有专门为 AI 训练推出的 GB200 NVL72 机群,它将 36 个 CPU 和 72 个 GPU 插入一个单一的液冷机架中,总共有 720 petaflops 的 AI 训练性能或 1440 petaflops(也称为 1.4 exaflops)的推理能力。内部有近两英里长的电缆,有 5000 根独立电缆,包含 72 个 Blackwell GPU 和 36 个 Grace CPU,通过第五代 NVLink 互连。

英伟达表示,该系统可以部署一个拥有 27 万亿参数的模型,而 GPT-4 大约是一个拥有 1.7 万亿参数的模型。据称,亚马逊、谷歌、微软和甲骨文都已计划在其云服务产品中提供 NVL72 机架。

02

NIM

新一代部署 AI 的方式

在今天的 GTC 上,英伟达宣布推出 NIM(Nvidia Inference Manager)软件技术,该技术将优化的推理引擎、行业标准 API 和对 AI 模型的支持打包到容器中,以便轻松部署。虽然 NIM 提供了预建模型,但它还允许组织带来自己的专有数据,并将支持和帮助加速检索增强生成(RAG)部署。

简单来说,NIM 是一个装满各种微服务(microservice)的容器。容器可以包含任何类型的模型,从开放到专有模型,只要在有 Nvidia GPU 的地方就能运行——无论是在云端还是在笔记本电脑上。反过来,这个容器可以部署在任何能运行容器的地方,可能是云端的 Kubernetes 部署、Linux 服务器,甚至是无服务器的函数即服务模型。Nvidia 将在其新的 ai.nvidia.com 网站上提供无服务器部署方法,开发者可以在部署前前往该网站开始使用 NIM。

严格说来,NIM 并不是 Nvidia 之前任何模型交付方式的替代品。它是一个容器,包含了一个针对 Nvidia GPU 高度优化的模型以及提高推理性能所需的必要技术。

NIM 使得使用旧的 Nvidia GPU 进行 AI 推理变得更加容易,并且将允许公司继续使用他们已经拥有的数亿个 Nvidia GPU。NIM 使那些想要运行自己的 AI 模型的公司受益,而不需要向 OpenAI 这样的公司以服务的形式购买 AI 使用能力。

NIM 技术作为英伟达下一代推理战略的基础,标志着通用人工智能部署的重要里程碑,将对该领域的几乎每个模型开发者和数据平台产生影响。英伟达已与包括 SAP、Adobe、Cadence、CrowdStrike、Getty Images、ServiceNow 和 Shutterstock 在内的大型软件供应商合作,以及与 BOX、Cohesity、Cloudera、Databricks、Datastax、Dropbox、NetApp 和 Snowflake 等一长串数据平台供应商合作,以支持 NIM。

03

Project GR00T

为具身智能而来

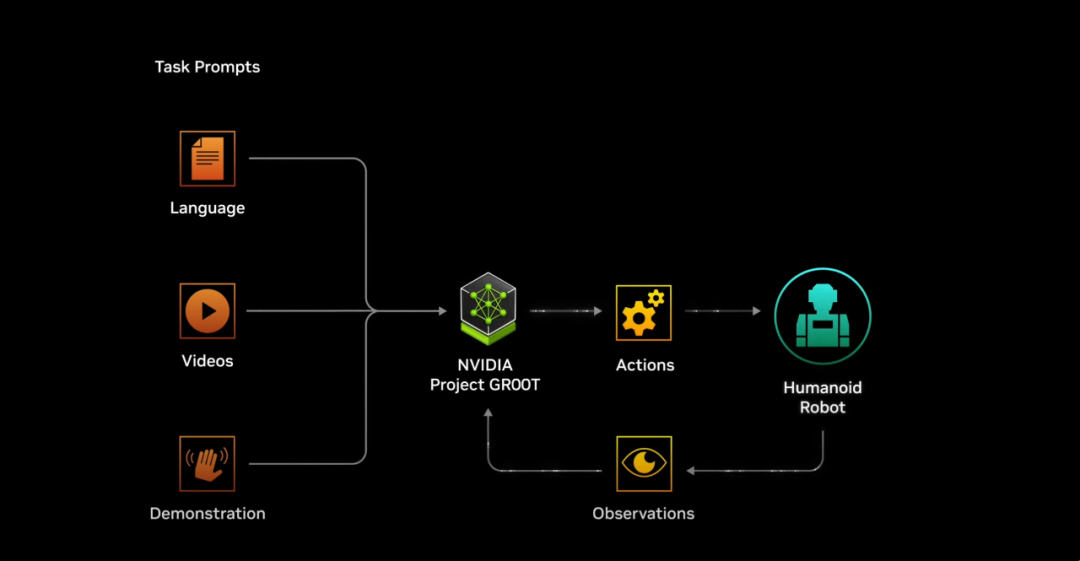

Nvidia Project GR00T,利用了通用基础模型,使类人机器人能够将文本、语音、视频甚至现场演示作为输入,并处理这些信息以采取特定的一般行动。该项目是在使用 Nvidia 的新的 Isaac 机器人平台工具(Jetson Thor)的帮助下开发的,Jetson Thor 运行基于 Blackwell 的 GPU,可在 8 位数据处理中提供 800 teraflops 的 AI 性能。

「为通用仿人机器人构建基础模型是当今人工智能领域最令人兴奋的待解决问题之一,」Nvidia CEO 黄仁勋说。「GR00T 能让技术汇聚在一起,让全球领先的机器人学家能够向人工通用机器人领域迈出巨大的飞跃。」

尽管 GR00T 这个名字看起来与漫威的格鲁特相似,但它实际上代表的是通用机器人技术(Generalist Robot 00 Technology)。英伟达表示,它被设计为能够理解自然语言文本、语音、视频和现场演示,以模仿人类动作——协调、灵巧和其他技能——并产生一般动作来导航、适应和与现实世界互动。

英伟达将新平台称为「类人机器人的通用基础模型」。本质上,该公司正在为最近进入该领域的一系列公司构建一个 AI 平台,包括像 1X Technologies、Agility Robotics、Apptronik、Boston Dynamics、Figure AI、Fourier Intelligence、Sanctuary AI、Unitree Robotics 和 XPENG Robotics 这样的公司。这几乎涵盖了目前活跃的类人机器人制造商,除了特斯拉。

04

Earth-2 云平台

地球孪生,预测气候变化

Earth-2 平台,作为 Nvidia CUDA-X 微服务软件的一部分,利用先进的 AI 模型和 CorrDiff GenAI 模型,生成高分辨率模拟的速度比当前数值模型快 1000 倍,能效高出 3000 倍。

Earth-2 API 可以让用户创建从全球大气条件到局部天气现象(如台风和湍流)的交互式实时模拟,使他们能够在几秒钟内提供实时预报和警告。

台湾的中央气象局是最早采用 Earth-2 来提高台风预报的机构之一,目的是通过提前疏散来尽量减少人员伤亡。通过利用 Nvidia 的 AI 技术,Earth-2 试图彻底改变灾害准备和应对策略,在有可能在易受极端天气事件影响的地区拯救生命。

此外,Earth-2 与 Nvidia Omniverse 集成,使像 The Weather Company 这样的组织能够开发包含真实天气数据的 3D 工作流程,以增强他们的数字孪生环境,从而更好地分析和模拟天气影响。

05

Omniverse Cloud API 上线,

支持 Vision Pro

在推出 Ominiverse 五年后,英伟达推出 Ominicerse Cloud API,通过将 Omniverse 核心能力直接集成到现有软件应用中,开发者现在可以简化工作流程,并加速创建用于广泛工业应用的数字孪生。

「我们相信每一样制造出来的东西都会有数字孪生,」黄仁勋在今天 Nvidia GTC 2024 的主题演讲中说。「Omniverse 是用来构建和操作物理上逼真的数字孪生的操作系统。通过生成性 AI 和 Omniverse,我们正在数字化重工业市场,为创作者开辟无限的机会。」

五个新的 Omniverse Cloud API 为开发者提供了一套全面的开发工具。它们包括 USD Render,它可以生成 OpenUSD 数据的完全光线追踪渲染图;USD Write,允许用户修改和与 OpenUSD 数据交互;USD Query,可以进行场景查询和交互式场景;USD Notify,跟踪 USD 更改并提供更新;以及 Omniverse Channel,它促进跨场景的协作,连接用户、工具和世界。

西门子和 Ansys 这样的公司已经将 Omniverse Cloud API 集成到他们的平台中。例如,西门子正在将 API 集成到其 Xcelerator 平台中,增强其基于云的产品生命周期管理软件 Teamcenter X 的功能。

Omniverse Cloud 现已支持 Vision Pro,演示中可以看到,基于云的图像以远高于 Vision Pro 上应用程序所支持的分辨率进行流式传输。对于不少工业和企业公司来说,可能因此可以节省不少费用。

参考资料:https://www.theverge.com/2024/3/18/24105157/nvidia-blackwell-gpu-b200-aihttps://venturebeat.com/games/nvidia-announces-earth-2-digital-twin-to-forecast-planets-climate-change/https://venturebeat.com/ai/nvidia-omniverse-cloud-apis-will-elevate-digital-twins-for-a-new-industrial-revolution/

https://techcrunch.com/2024/03/18/nvidia-enlists-humanoid-robotics-biggest-names-for-new-ai-platform-gr00t/

如果你关注大模型领域,欢迎扫码加入我们的大模型交流群,来一起探讨大模型时代的共识和认知,跟上大模型时代的这股浪潮。

更多阅读

国内创业者和投资人如何看待 Figure 01 机器人:距离具身智能还有多远?

OpenAI Sora 团队专访:技术细节、后续功能开发排期全解密!

转载原创文章请添加微信:geekparker

ดูบอลสด

Very well presented. Every quote was awesome and thanks for sharing the content. Keep sharing and keep motivating others.

ดูบอลสด

Very well presented. Every quote was awesome and thanks for sharing the content. Keep sharing and keep motivating others.