今天为大家介绍的是来自Yanshan Wang团队的一篇论文。药物分子够改变生物体精神或身体状态。每种被批准的药物都有一个适应症,这指的是该药物用于治疗特定医疗条件的治疗用途。尽管大型语言模型(LLM)最近在将分子及其文本描述之间进行翻译方面显示出了有效性,但在利用这些模型帮助实现药物分子与适应症之间,或反之亦然的翻译方面,研究仍存在空白。这种能力对药物发现过程大有裨益,能够根据给定的适应症生成药物,这将允许发现针对特定疾病或靶点的药物,并最终为患者提供更好的治疗方案。

药物发现是一个成本高昂的过程,旨在识别具有成为治疗剂潜力的化学实体。因为它对健康的明显益处和重要性,药物发现已经成为一个活跃的研究领域,研究人员试图自动化和简化药物发现过程。被批准的药物有其适应症,这指的是使用该药物治疗特定疾病。从适应症创建分子,或反之亦然,将能更有效地针对疾病,并显著降低药物发现成本,有潜力革命化药物发现领域。大型语言模型(LLMs)已经成为生成式人工智能(AI)研究的主要方向之一,近年来开发了如GPT-3、GPT-4、LLaMA和Mixtral等高性能模型,以及像ChatGPT这样的服务已经吸引了超过一亿用户。LLMs利用深度学习方法执行各种自然语言处理(NLP)任务,比如文本生成和神经机器翻译。LLMs之所以能够执行这些任务,部分原因是它们在大规模文本数据上进行训练,使模型熟悉广泛的话题。LLMs还在不同科学领域的多种任务中展示了有希望的性能。因为LLMs处理的是文本数据,通常第一步是找到一种方式以文本或语言的形式表达一个问题。

分子的文本表示方法的其中一种是简化分子输入线条式系统(SMILES)。由于SMILES字符串以文本形式表示药物,我们可以评估LLMs在药物分子及其适应症之间进行翻译的可行性。在这篇文章中,作者考虑两个任务:药物到适应症和适应症到药物,作者试图从现有药物的SMILES字符串生成适应症,反之亦然。药物与相应适应症之间的翻译将允许找到治疗当前无法治疗的疾病的方法,并为临床医生提供更多的患者护理途径。

在文中,作者评估了MolT5(一种基于T5的模型)在通过两项任务(药物到适应症和适应症到药物)将药物及其适应症之间进行翻译的能力,使用的药物数据来自DrugBank和ChEMBL。药物到适应症任务使用现有药物的SMILES字符串作为输入,以药物的匹配适应症作为目标输出。适应症到药物任务以药物的一组适应症作为输入,并寻求生成治疗所列条件的药物的相应SMILES字符串。作者使用了所有可用的MolT5模型大小,并在两个数据集上分别对它们进行了评估。此外,作者在三种不同的配置下进行了实验:1.在整个可用数据集上评估基线模型;2.在数据集的20%上评估基线模型;3.在数据集的80%上对模型进行微调,然后在20%的子集上进行评估。较大的MolT5模型在所有配置和任务中都优于较小的模型。

实验部分

作者使用HuggingFace上的MolT5模型进行了初步实验。MolT5提供了三种模型大小,并为每种大小的模型提供了经过微调的版本。对于从药物适应症生成SMILES字符串(药物到适应症)的实验,作者使用了经过微调的模型MolT5-smiles-to-caption;而对于从药物适应症生成SMILES字符串(适应症到药物)的实验,作者使用了模型MolT5-caption-to-smiles。对于每个表格,作者使用以下标志:FT(表示在数据集的80%上微调模型并在剩余的20%测试子集上进行评估的实验),SUB(表示仅在20%测试子集上评估模型的实验),以及FULL(表示在每个数据集的全部评估模型的实验)。

对于评估药物到适应症使用自然语言生成指标BLEU、ROGUE和METEOR,以及Text2Mol指标,后者生成SMILES-适应症对的相似度。至于评估适应症到药物,作者测量精确的SMILES字符串匹配、Levenshtein距离、SMILES BLEU分数、Text2Mol相似度指标,以及三种不同的分子指纹度量:MACCS、RDK和Morgan FTS(FTS代表指纹Tanimoto相似度),以及返回的SMILES字符串中有效分子的比例。评估SMILES生成的最终指标是FCD,或Fréchet ChemNet Distance,它测量两个分子分布之间的距离,这些分子是从它们的SMILES字符串得出的。

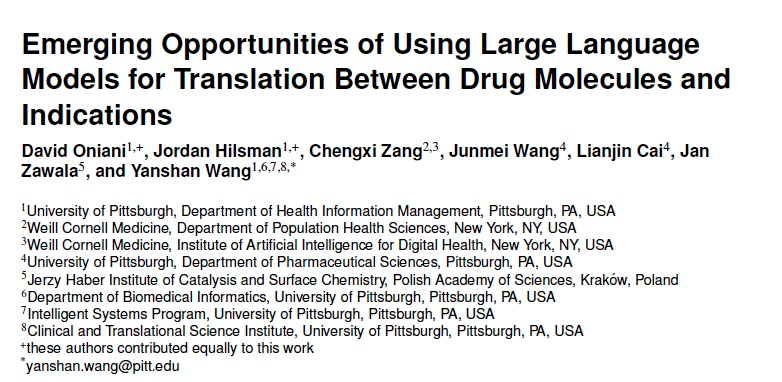

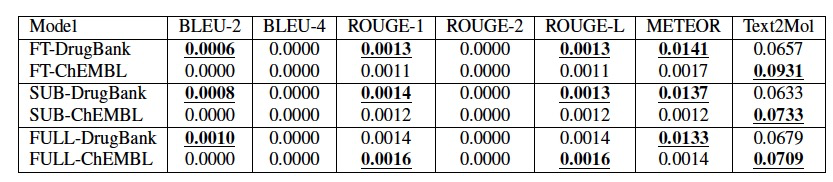

表 1

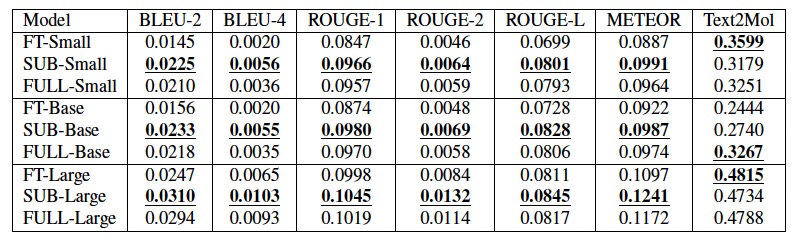

表 2

表1和表2分别展示了在DrugBank和ChEMBL数据上对于药物到适应症任务的MolT5实验结果。在每次实验的所有指标上,较大的模型往往表现更好。在DrugBank和ChEMBL数据集上,几乎所有指标对于药物到适应症任务而言,模型在20%子集数据上表现最佳。同时,子集和完整数据集的评估都比微调实验的结果更好。由于MolT5模型是在分子标题上训练的,使用适应症进行微调可能会引入噪声,削弱输入与目标文本之间的信号。模型在DrugBank数据上的表现优于ChEMBL数据,这可能是由于DrugBank提供的药物适应症的详细程度造成的。

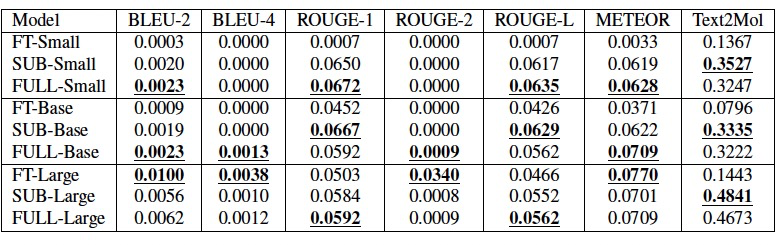

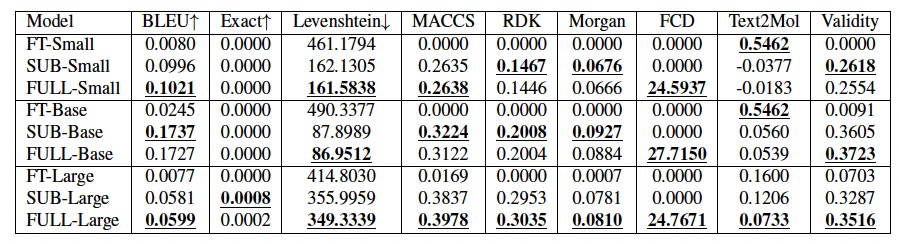

表 3

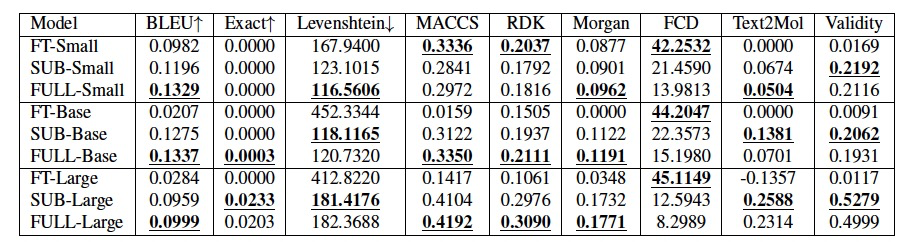

表 4

表3和表4分别展示了在DrugBank和ChEMBL数据上对于适应症到药物任务的MolT5实验结果。表格显示,在新数据上微调模型会恶化性能。同样,较大的模型在每次实验的所有指标上往往表现更好。在药物到适应症和适应症到药物实验中,作者发现微调模型会导致模型在所有指标上的表现变差。此外,较大的模型在任务上表现更好。随后作者为了尝试解决微调不能提高模型能力的问题做了自定义分词器实验,作者预训练了MolT5-Small,并且没有加入Smiles-to-Caption和Caption-to-Smiles的额外层。

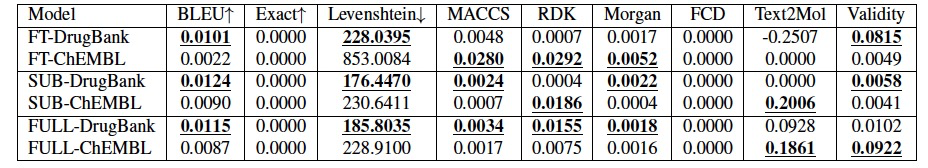

表 5

表 6

表5和表6分别展示了使用自定义分词器预训练的MolT5在药物到适应症和适应症到药物任务上的评估结果。对于药物到适应症任务,模型在DrugBank数据集上的表现更佳,这一点在所有指标上都有所反映。在任一数据集的80%上微调模型并没有像基线结果中那样恶化药物到适应症的性能,而且一些指标显示出改进的结果。对于适应症到药物的结果则更加混杂。模型在两个数据集上的表现并不一致地更好,微调模型对评估指标的影响也不一致。这表明,在使用自定义分词器预训练的MolT5模型进行特定任务时,对于不同的数据集和微调策略,模型的性能可能会有所不同。在药物到适应症任务中,特别是在DrugBank数据集上,模型表现出了较好的适应性和性能提升的可能性。然而,在适应症到药物的任务上,模型的表现似乎更加依赖于具体的实验设置和数据特性,指出了对模型微调和评估方法的选择需要更加谨慎的事实。

编译 | 曾全晨

审稿 | 王建民

参考资料

Oniani, D., Hilsman, J., Zang, C., Wang, J., Cai, L., Zawala, J., & Wang, Y. (2024). Emerging Opportunities of Using Large Language Language Models for Translation Between Drug Molecules and Indications. arXiv preprint arXiv:2402.09588.

ดูบอลสด

Very well presented. Every quote was awesome and thanks for sharing the content. Keep sharing and keep motivating others.

ดูบอลสด

Very well presented. Every quote was awesome and thanks for sharing the content. Keep sharing and keep motivating others.