导语

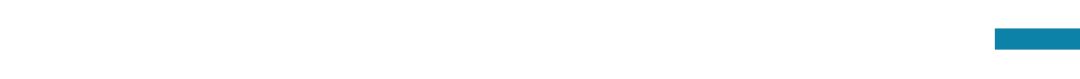

智能体研究已成为科研领域的绝对热点。“大模型安全与对齐”读书会的第七期,我们邀请到清华大学的杨宗瀚,他将介绍大模型智能体系统的统一对齐原则,要求智能体系统通盘考虑人类意图、环境规律与自身限制三方面的因素,并达成统一对齐。通过分析当前智能体系统的测试基准和方法框架,不仅证明了统一对齐原则的重要性;并进一步通过构建更为现实的测试基准,提出更加关注统一对齐的智能体系统来实践并验证这一原则。此外,进一步分析了智能体系统与对齐之间本质的联系,为下一代更加自主的通用智能体系统作出展望。本次分享将从安全可靠性的角度着重讨论,并同时覆盖智能体的自主性与可靠性之间的辩证关系。

分享议程

-

主题分享:杨宗瀚《智能体系统的统一对齐原则》

-

圆桌讨论 :

-

统一对齐原则可以怎样被泛化到多智能体领域?

-

怎么看待智能体与工具之间的关系,这是否是统一对齐原则里的一个安全挑战?

- 出席嘉宾:段雅文(安远AI),唐相儒(耶鲁大学)、周凡(上海交通大学)等

分享内容大纲

- 智能体系统的构成与统一对齐原则

- 统一对齐原则下现有交互环境、方法框架的综述评价

- 基于统一对齐原则的交互环境设计、方法框架设计、评价指标设计

- 统一对齐原则带来的启发与展望

- 关于智能体自主性与可靠性之间的辩证关系讨论

主要涉及到的前置知识

-

智能体

- 对齐

主讲人介绍

清华大学计算机系2020级博士生,导师是刘洋教授。研究兴趣是基础模型的对齐技术和智能体,特别是两者之间的交叉。个人主页:https://minicheshire.github.io/

清华大学计算机系2020级博士生,导师是刘洋教授。研究兴趣是基础模型的对齐技术和智能体,特别是两者之间的交叉。个人主页:https://minicheshire.github.io/

圆桌嘉宾介绍

唐相儒:耶鲁大学计算机科学专业博士生。他的研究兴趣是大型语言模型,智能体和代码生成。他也是ICLR 2024 LLM Agents Workshop的核心组织者,个人主页为https://xiangrutang.github.io/。

研究方向:大语言模型和生物医疗数据科学应用的交叉领域。

周凡:上海交通大学计算机科学与技术硕士三年级学生,在GAIR实验室从事NLP方面的研究,指导老师为刘鹏飞副教授。硕士期间,他曾在微软亚洲研究院、香港大学XLang实验室进行研究和学习,并发表了和智能体相关的多篇论文。研究兴趣:语言模型智能体构建、代码生成模型。

周凡:上海交通大学计算机科学与技术硕士三年级学生,在GAIR实验室从事NLP方面的研究,指导老师为刘鹏飞副教授。硕士期间,他曾在微软亚洲研究院、香港大学XLang实验室进行研究和学习,并发表了和智能体相关的多篇论文。研究兴趣:语言模型智能体构建、代码生成模型。

主持人介绍

段雅文,安远AI技术项目经理,致力于AI安全技术社区建设。他是未来生命研究所AI Existential Safety PhD学者,关注大模型安全和对齐研究。他曾在UC Berkeley的Stuart Russell组和剑桥大学David Krueger实验室进行AI安全和对齐研究。他曾在NeurIPS组织Socially Responsible Language Model Research工作坊,参与的研究项目曾在CVPR、ECCV、ICML、ACM FAccT、NeurIPS MLSafety Workshop等ML/CS会议和工作坊上发表。他拥有剑桥大学机器学习硕士学位和香港大学理学士学位。研究方向:人工智能安全与对齐等。

段雅文,安远AI技术项目经理,致力于AI安全技术社区建设。他是未来生命研究所AI Existential Safety PhD学者,关注大模型安全和对齐研究。他曾在UC Berkeley的Stuart Russell组和剑桥大学David Krueger实验室进行AI安全和对齐研究。他曾在NeurIPS组织Socially Responsible Language Model Research工作坊,参与的研究项目曾在CVPR、ECCV、ICML、ACM FAccT、NeurIPS MLSafety Workshop等ML/CS会议和工作坊上发表。他拥有剑桥大学机器学习硕士学位和香港大学理学士学位。研究方向:人工智能安全与对齐等。

涉及到的参考文献

-

Yang et al. Towards Unified Alignment Between Agents, Humans, and Environment. arXiv:2402.07744, 2024.

-

Yao et al. WebShop: Towards Scalable Real-World Web Interaction with Grounded Language Agents. NeurIPS 2022.

- Tang et al. Prioritizing Safeguarding Over Autonomy: Risks of LLM Agents for Science. arXiv:2402.04247, 2024.

直播信息

时间:2024年3月23日(周六)早上10:00-12:00参与方式: 扫码参与大模型安全与对齐读书会,加入群聊,获取系列读书会回看权限,成为大模型安全与对齐读书会社区的种子用户,与社区的一线科研工作者与企业实践者沟通交流,共同推动大模型安全与对齐读书会社区的发展。

扫码参与大模型安全与对齐读书会,加入群聊,获取系列读书会回看权限,成为大模型安全与对齐读书会社区的种子用户,与社区的一线科研工作者与企业实践者沟通交流,共同推动大模型安全与对齐读书会社区的发展。

报名成为主讲人

读书会成员均可以在读书会期间申请成为主讲人。主讲人作为读书会成员,均遵循内容共创共享机制,可以获得报名费退款,并共享本读书会产生的所有内容资源。具体见系列读书会详情:2024开年读书会:AI安全与对齐——应对前沿AI失控与滥用的技术路线。

大模型安全与对齐读书会

大模型的狂飙突进唤醒了人们对AI技术的热情和憧憬,也引发了对AI技术本身存在的社会伦理风险及其对人类生存构成的潜在威胁的普遍担忧。在此背景下,AI安全与对齐得到广泛关注,这是一个致力于让AI造福人类,避免AI模型失控或被滥用而导致灾难性后果的研究方向。集智俱乐部和安远AI联合举办「大模型安全与对齐」读书会,由多位海内外一线研究者联合发起,旨在深入探讨大模型安全与对齐所涉及的核心技术、理论架构、解决路径以及安全治理等交叉课题。

详情请见:2024开年读书会:AI安全与对齐——应对前沿AI失控与滥用的技术路线

特别鸣谢安远AI对本次读书会的内容贡献。

安远AI是一家位于北京、专注于AI安全与治理的社会企业。我们的使命是引领人机关系走向安全、可信、可靠的未来。我们面向大模型和通用人工智能安全和对齐问题,进行风险研判、建立技术社区、开展治理研究、提供战略咨询以及推动国际交流。

点击“阅读原文”,报名读书会

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง