关键词:机器学习,神经网络,特征学习,反向传播

论文题目:Mechanism for feature learning in neural networks and backpropagation-free machine learning models论文期刊:Science

论文链接:https://www.science.org/doi/10.1126/science.adi5639

神经网络一直在推动人工智能的突破,包括现在在金融、人力资源和医疗保健等各个领域中广泛使用的大语言模型。神经网络通过反向传播和梯度下降等方法,在输入数据上自动地“发现”有意义的模式或特征。揭秘特征学习的机制一直是悬而未决的问题,但这是提高神经网络性能和可解释性的关键。

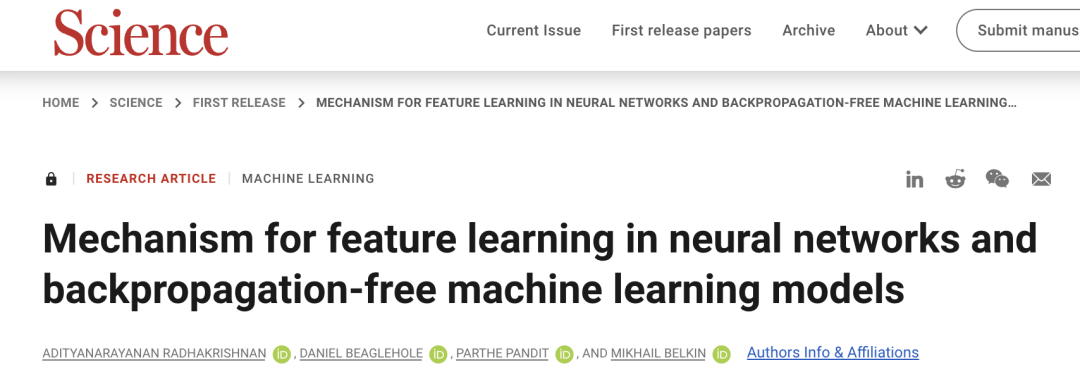

加利福尼亚大学圣地亚哥分校的数据和计算机科学家领导的团队近期在Science发表研究,提出了一个统一的数学机制,用于描述神经网络的学习方式。该框架可以捕捉神经网络架构中学习到的特征,并提升通用机器学习模型的特征学习。研究团队提出了“神经特征假设”(Neural Feature Ansatz),即某个给定神经网络层抽取的特征与该层输入相关的平均梯度外积(AGOP)成正比。其中,神经特征是指由模型从输入数据中学习并用于执行任务(例如分类或回归)的内部表示形式或模式。平均梯度外积是一个数学运算符,计算某个函数相对于其输入参数改变量所产生影响范围之间的协方差,研究人员使用平均梯度外积来捕获和描述神经网络如何从原始输入数据中提取出有意义信息。神经特征假设量化描述了深度学习模型在各层级上如何捕获和提取输入数据的特征。也就是说,如果一个网络层能够抽取出有价值的特征(即对任务有帮助),那么自该层之前的输入到输出所形成的平均梯度外积,应该会相应地增大。因此,通过测量平均梯度外积, 就可以理解并可视化神经网络每一层中发生的学习过程。

通过大量实证数据,该研究证明了神经特征假设适用于最先进的模型,如Transformer、深度卷积网路(例如ResNet, VGG, AlexNet),以及GPT2语言模型。这项研究成果可以用来描述和可视化各种神经架构在处理表格、图像和文本数据时提取的特征,从而增强神经网络的透明度。

图1 平均梯度外积(AGOP)在神经网络架构中捕获特征,并在通用机器学习模型中实现特征学习

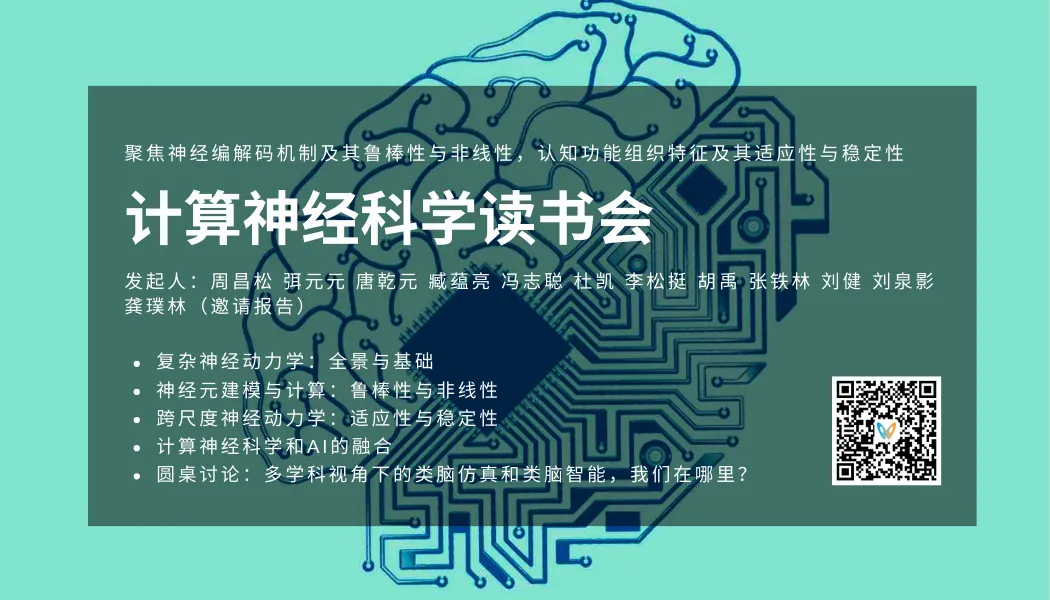

计算神经科学读书会

详情请见:计算神经科学读书会启动:从复杂神经动力学到类脑人工智能

推荐阅读1. PNAS速递|第四代神经网络:树突计算模型2. 前沿探讨:图神经网络、组合优化、大模型与AI4Science如何相互促进?3. 前沿进展:利用神经网络提取系统中未被观测到变量的信息4. 张江:第三代人工智能技术基础——从可微分编程到因果推理 | 集智学园全新课程5. 龙年大运起,学习正当时!解锁集智全站内容,开启新年学习计划6. 加入集智,一起复杂!

点击“阅读原文”,报名读书会

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง